(一)技术与产业发展态势

人工智能已成为第四次科技革命核心驱动力,技术迭代呈现三大特征:一是生成式人工智能实现突破,大模型参数规模迈入万亿级,混合专家架构、多模态融合(文本 / 图像 / 音频 / 视频)及逻辑推理能力显著提升,智能体(AI Agents)从内容生成向主动执行演进;二是产业应用加速渗透,2024 年全球市场规模达 6382 亿美元,预计 2030 年将达 3.6 万亿美元,覆盖科研、制造、金融、医疗、交通等关键领域,形成 “人工智能 +” 产业生态;三是基础设施竞争加剧,全球算力设施建设提速,英伟达 CUDA 生态占据主导,国产芯片通过架构创新逐步缩小差距。

(二)核心发展与治理目标

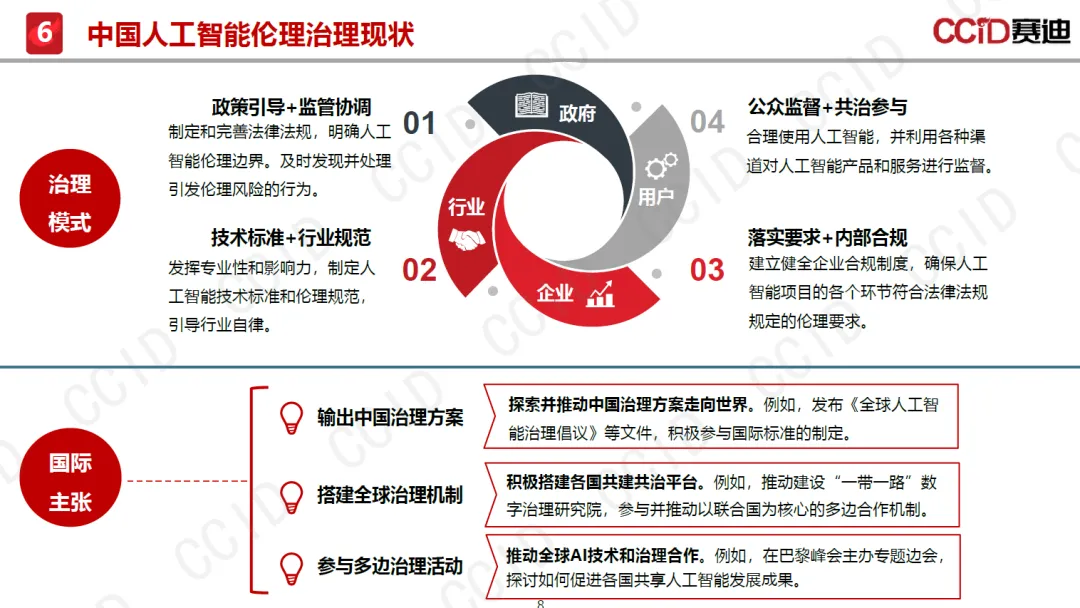

全球普遍遵循 “发展与安全并重” 原则,核心目标聚焦三方面:一是技术创新与安全可控动态平衡,确保人工智能始终处于人类控制之下,防范灾难性风险;二是伦理合规与价值对齐,将和平、发展、公平、正义等全人类共同价值融入技术全生命周期;三是普惠共享与全球协同,缩小智能鸿沟,推动不同发展水平经济体公平参与治理,实现技术造福人类的终极目标。中国明确提出 “以人为本、智能向善”,通过《全球人工智能治理倡议》《人工智能安全治理框架》等文件,构建开放公正的治理机制。

二、安全风险与伦理挑战

(一)多维安全风险体系

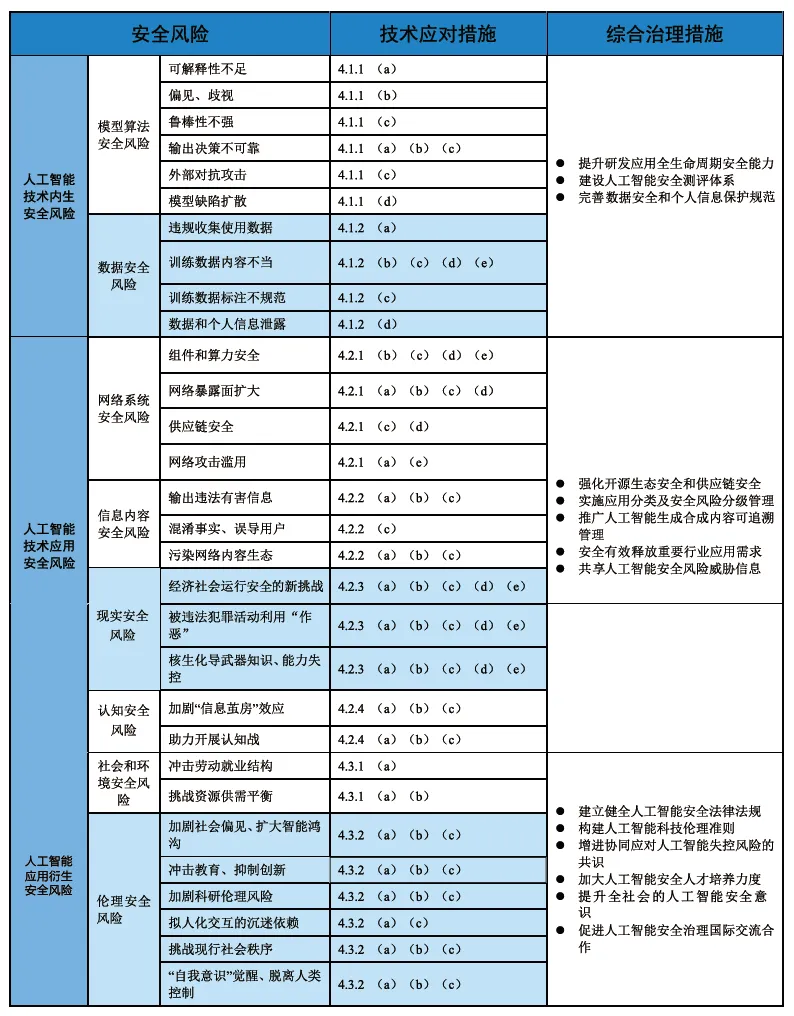

技术内生安全风险:模型算法存在可解释性不足、偏见歧视、鲁棒性不强、输出不可靠等问题,易受对抗攻击与模型缺陷传播影响;数据安全面临违规收集、内容不当、标注不规范及敏感信息泄露风险,训练数据 “投毒” 可能污染模型概率分布。

技术应用安全风险:网络系统存在组件算力缺陷、网络暴露面扩大、供应链断供(芯片 / 软件 / 工具)及网络攻击滥用风险,AI 生成的高仿真内容可绕过身份认证;信息内容存在违法有害输出、事实混淆、网络内容生态污染等问题;现实安全风险涉及关键信息基础设施运行安全、被违法犯罪利用,甚至核生化导武器知识失控;认知安全风险加剧 “信息茧房”,可能被用于认知战与价值观干预。

衍生安全风险:社会层面冲击劳动就业结构,传统劳动力需求下降,加剧资源供需矛盾;伦理层面扩大智能鸿沟与社会偏见,抑制创新潜力,引发科研伦理争议,挑战传统社会秩序,存在技术失控风险。

来源:中国信息安全测评中心,人工智能安全风险测评白皮书(2025)

来源:中国信息安全测评中心,人工智能安全风险测评白皮书(2025)

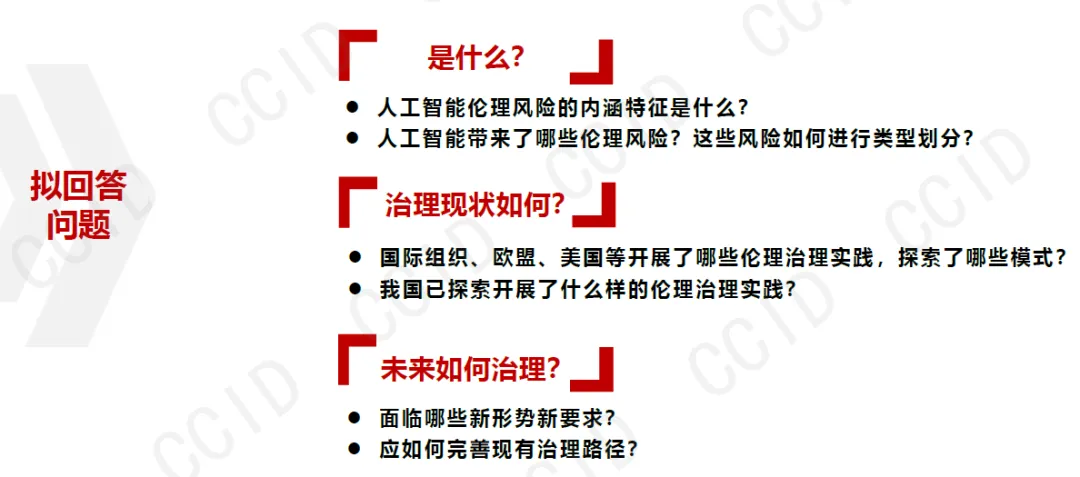

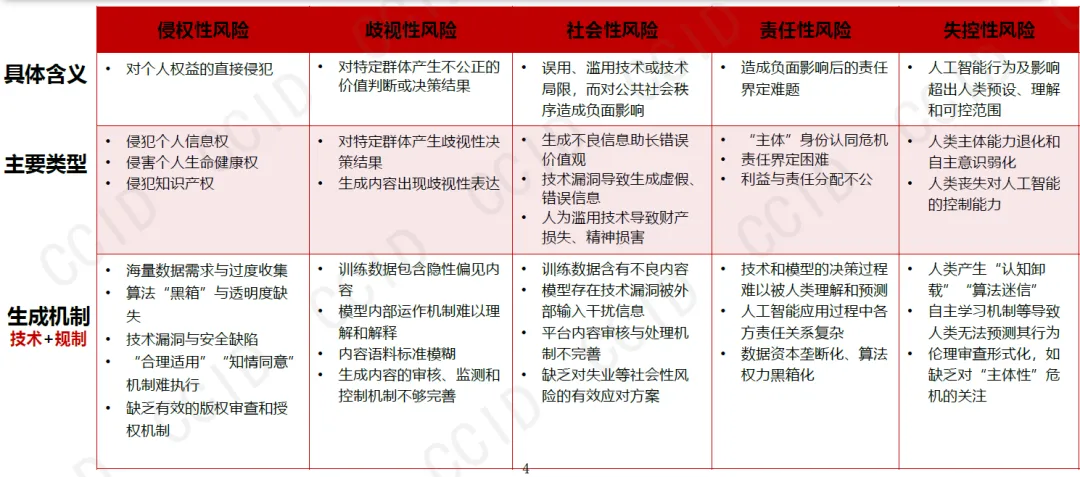

(二)核心伦理挑战

人工智能伦理风险主要表现为五类:一是侵权性风险,包括个人信息泄露、生命健康侵害、知识产权侵犯及不良信息传播;二是歧视性风险,因训练数据偏见或算法缺陷,对特定群体产生不公正决策与表达;三是社会性风险,技术误用滥用冲击公共秩序,引发失业、认知退化等问题;四是责任性风险,多方参与主体导致责任界定困难,利益与责任分配不公;五是失控性风险,技术自主学习能力提升可能超出人类预设与可控范围,引发 “主体性” 认同危机。

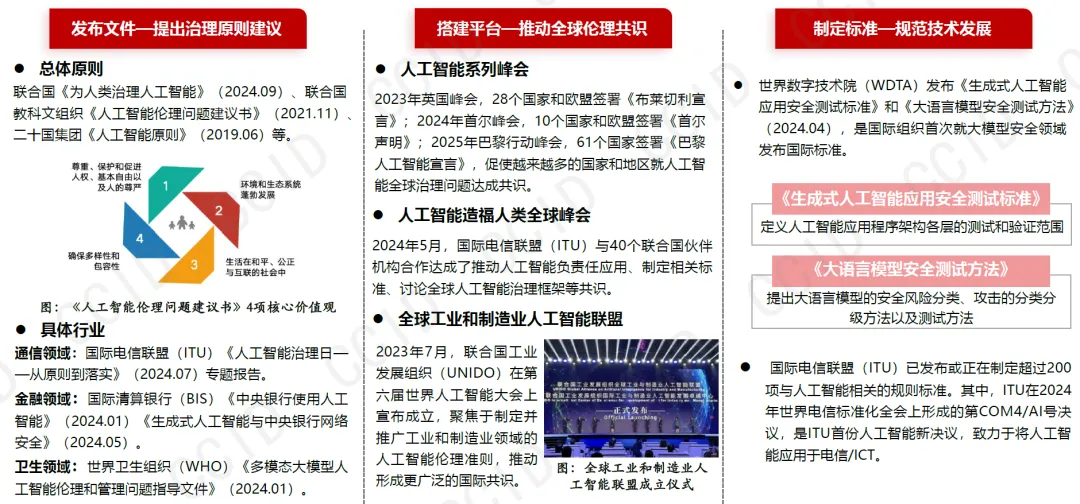

三、全球治理与标准发展进展

(一)国际组织治理行动

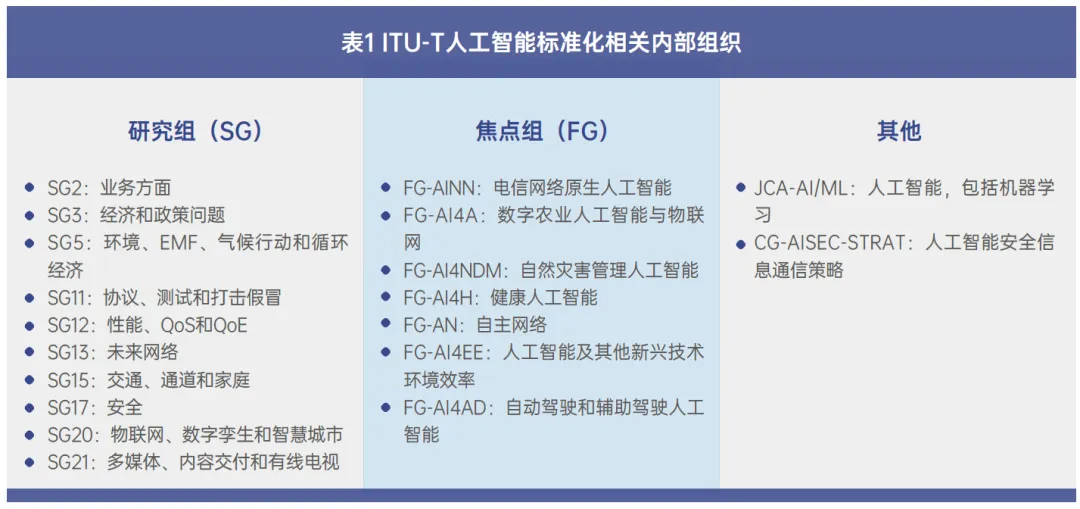

ITU:依托信息通信领域优势,构建技术 - 应用 - 治理多层次标准体系,已发布 120 多项相关标准,聚焦安全可信与全球协同,建立人工智能标准交流数据库,推动跨区域标准对齐。

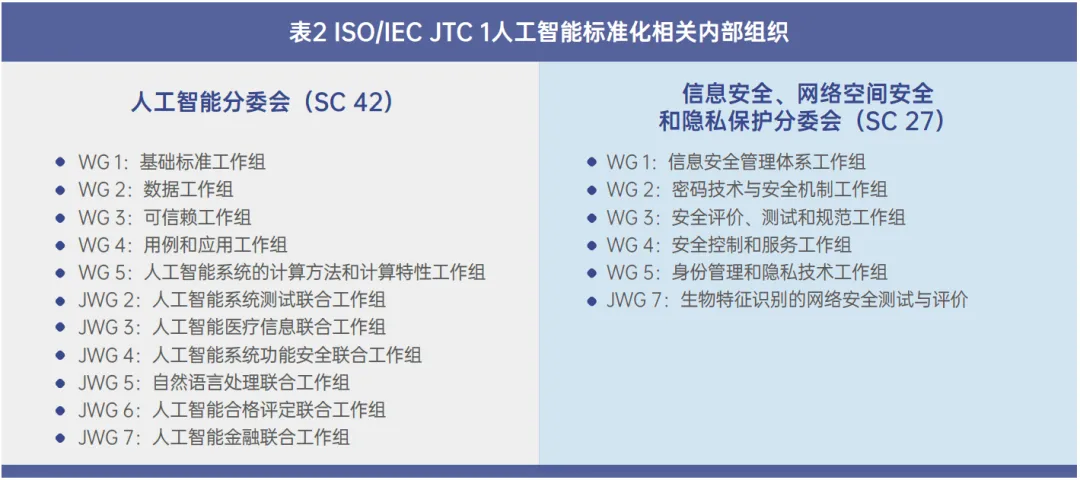

ISO/IEC:以 JTC1 SC42 为核心,形成基础 - 技术 - 管理协同的标准体系,发布 37 项标准,涵盖术语定义、风险管理、管理体系等,探索模块化、智能标准形式,适配技术快速迭代。

IEEE:以伦理治理为导向,推动 P7000 系列标准,覆盖系统设计、算法偏见处理、福祉度量等,构建跨领域全栈式标准生态,开放部分标准促进伦理共识普及。

(二)主要经济体治理模式

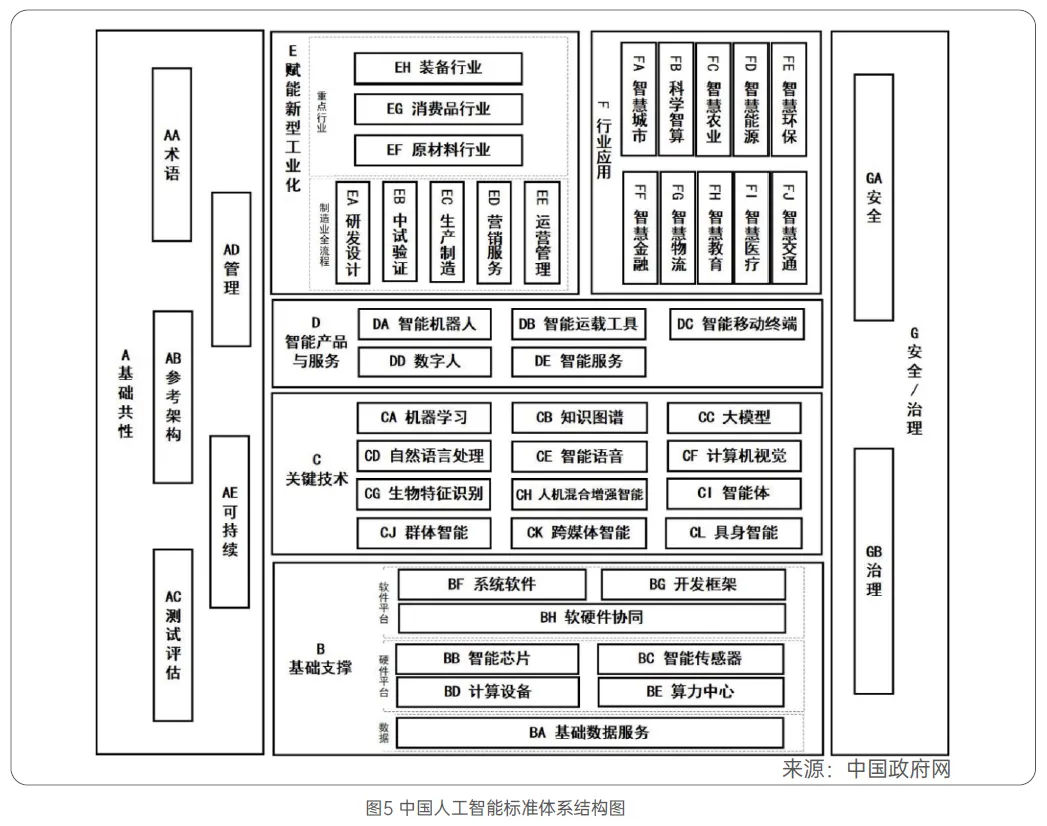

中国:形成 “治理倡议 + 框架文件 + 标准体系” 三位一体格局,发布《人工智能安全治理框架》1.0/2.0 版,构建涵盖基础共性、技术应用、安全治理的标准体系,2024 年提出到 2026 年新制定 50 项以上国家 / 行业标准,参与 20 项以上国际标准,推进生成式 AI 服务安全、数据标注安全等重点标准落地。

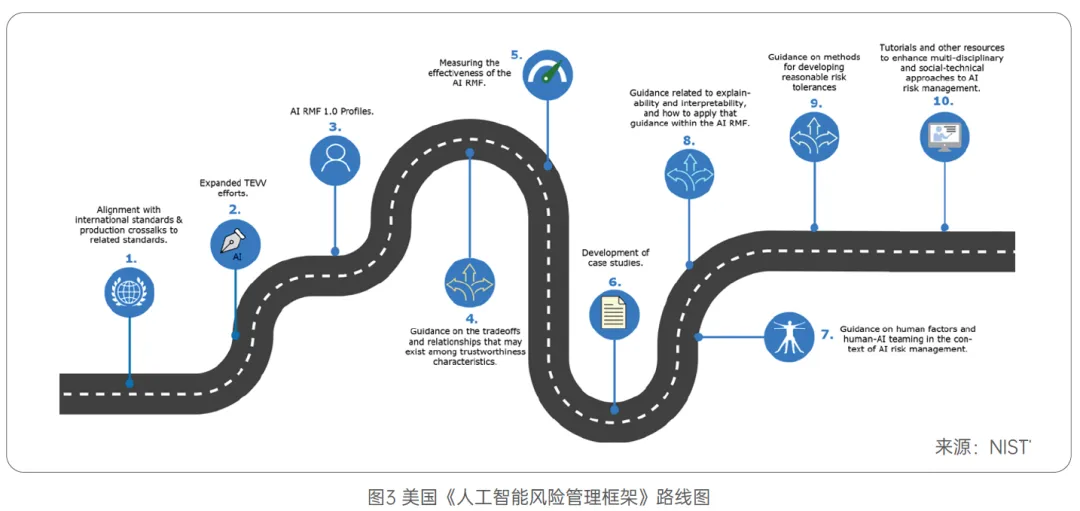

美国:推行 “自愿共识 + 行业自律” 模式,NIST 主导《人工智能风险管理框架》,2025 年成立人工智能标准与创新中心,通过零草案试点加速标准制定,强调技术创新与风险管理融合。

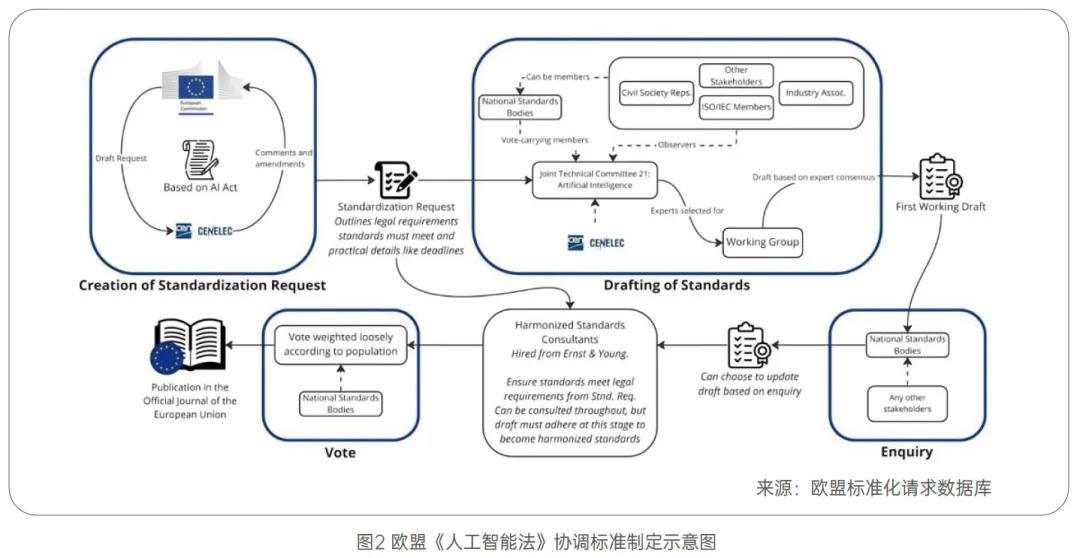

欧盟:采取 “法律规制 + 分级监管” 路径,《人工智能法》作为全球首个全面监管 AI 的法律体系,将 AI 系统分为不可接受风险、高风险、有限风险、最小风险四类,通过 CEN/CENELEC 制定协调标准,确保合规可执行。

英国与南方国家:英国依托 BSI 推动国际标准转化,设立 AI Standards Hub 促进全球合作;金砖国家、东盟、非盟等通过区域合作机制,强调发展权与技术公平,推动包容性治理框架。

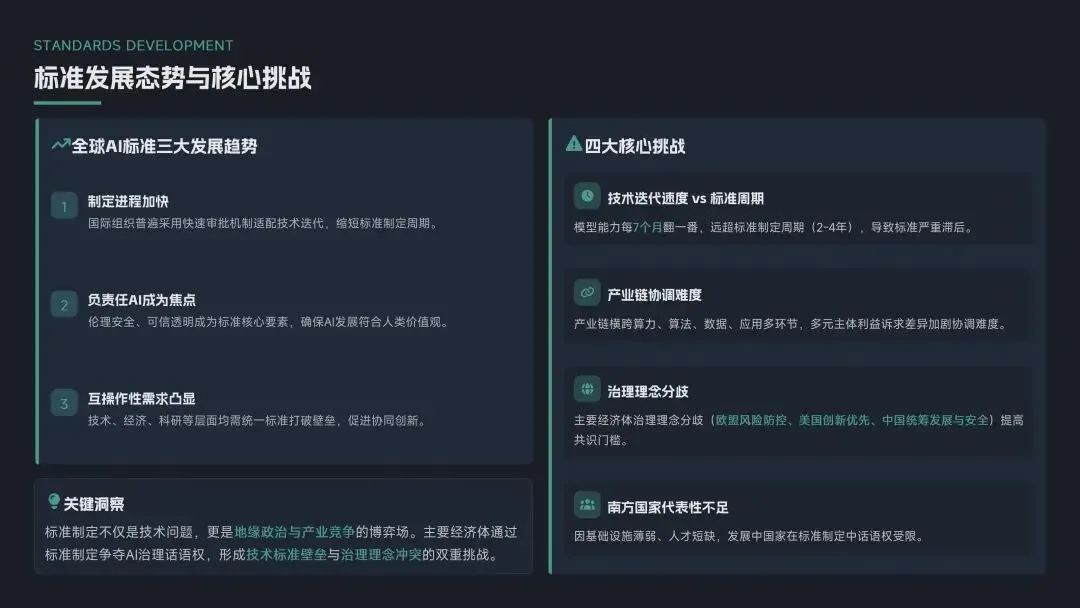

(三)标准发展态势与挑战

发展态势:全球 AI 标准呈现三大趋势,一是制定进程加快,国际组织普遍采用快速审批机制适配技术迭代;二是负责任 AI 成为焦点,伦理安全、可信透明成为标准核心要素;三是互操作性需求凸显,技术、经济、科研等层面均需统一标准打破壁垒。

核心挑战:技术迭代速度(模型能力每 7 个月翻一番)远超标准制定周期(2-4 年),导致标准滞后;产业链横跨算力、算法、数据、应用多环节,多元主体利益诉求差异加剧协调难度;主要经济体治理理念分歧(欧盟风险防控、美国创新优先、中国统筹发展与安全)提高共识门槛;南方国家因基础设施薄弱、人才短缺,在标准制定中代表性不足。

四、安全测评体系与关键技术

(一)测评体系框架

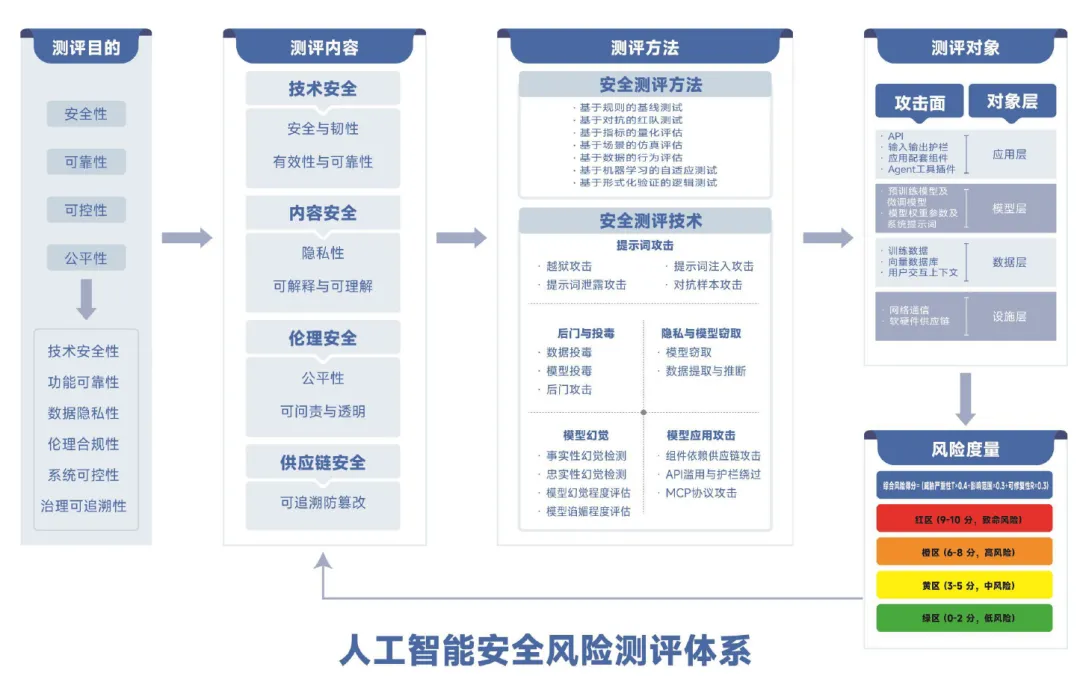

人工智能安全风险测评遵循 “全生命周期 + 多维度覆盖” 逻辑,构建 “目标设定 - 内容实施 - 方法技术 - 对象覆盖 - 风险度量 - 持续优化” 闭环体系。核心测评目标包括安全性、可靠性、可控性、公平性四大维度,细化为技术安全性、功能可靠性、数据隐私性、伦理合规性、系统可控性、治理可追溯性六大具体指标,风险等级划分为红(致命风险)、橙(高风险)、黄(中风险)、绿(低风险)四级。

(二)核心测评内容

供应链安全测评:覆盖硬件基础设施、软件开发框架、模型组件及第三方服务,聚焦供应韧性、完整性与计算安全性,防范供应链攻击与组件漏洞。

数据安全测评:贯穿数据采集、存储、传输、使用、销毁全流程,重点评估训练数据来源合规性、内容安全性、隐私保护措施及抗投毒能力。

模型安全测评:针对模型架构、参数与推理机制,测评对抗鲁棒性(抵御提示词攻击、对抗样本等)、输出可靠性(抑制幻觉)、完整性与后门风险。

伦理与运行态系统测评:伦理对齐测评涵盖内容合规、偏见公平性、伦理遵从等;运行态系统测评覆盖基础设施、网络、智能体全栈安全,验证工具调用、任务规划及外部信息源可靠性。

(三)测评方法与关键技术

主要测评方法:包括基于规则的基线测试(合规底线筛查)、基于对抗的红队测试(主动挖掘漏洞)、基于指标的量化评估(客观对比安全水平)、基于场景的仿真评估(贴近业务风险)等多元化路径。

关键测试技术:输入层测试涵盖越狱、提示词注入、对抗样本等攻击模拟;训练层测试聚焦数据投毒与后门植入;模型层测试包括模型窃取、权重篡改;输出层测试关注幻觉检测、数据提取与推理;部署层测试覆盖供应链污染、API 滥用与护栏绕过。

五、信任现状与影响因素

(一)信任分布差异

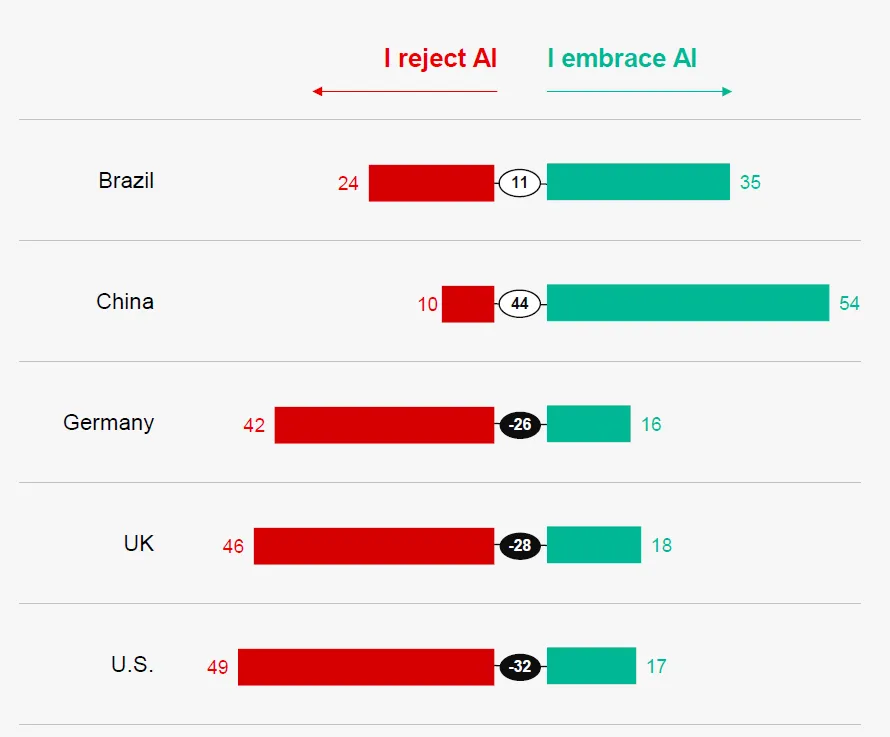

区域差异:中国(87%)、巴西(67%)对 AI 接受度较高,德国(39%)、英国(36%)、美国(32%)呈现抗拒态度,发达国家普遍担忧技术风险。

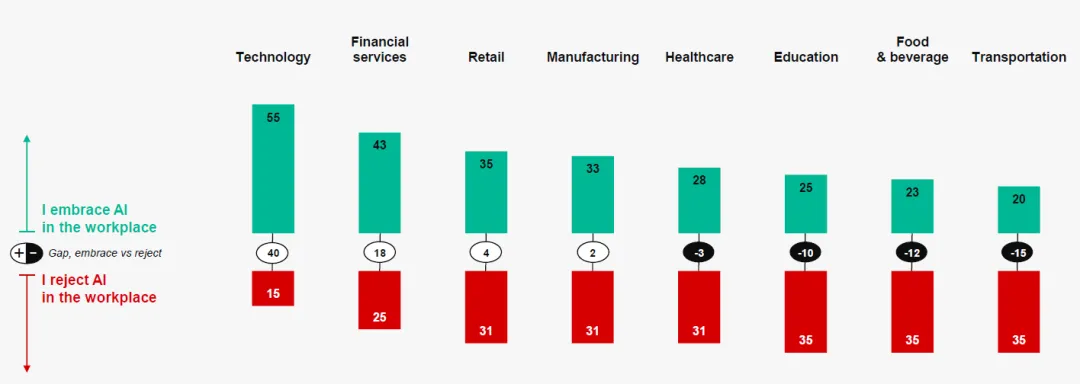

群体差异:行业层面,科技(55%)、金融(43%)行业员工对职场 AI 接受度最高,食品(23%)、交通(20%)行业接受度最低;

来源:Edelman, Flash Poll: Trust and Artificial Intelligence at a Crossroads(2025)

来源:Edelman, Flash Poll: Trust and Artificial Intelligence at a Crossroads(2025)

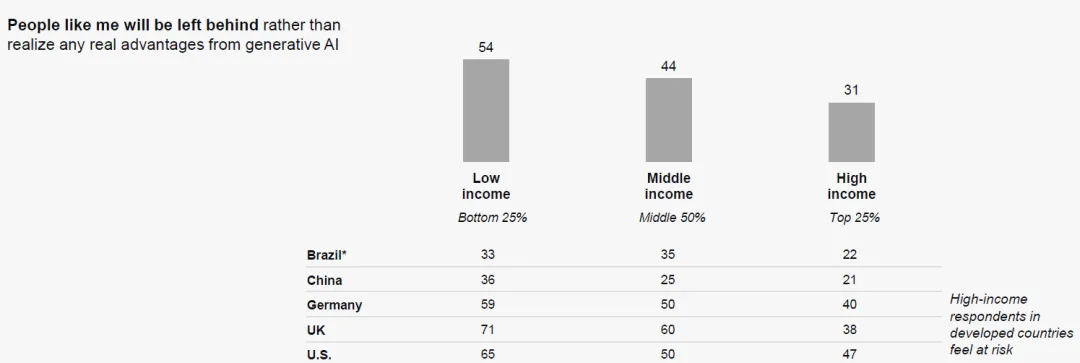

收入层面,低收入群体(54%)更担心被技术抛弃,高收入群体顾虑相对较低;

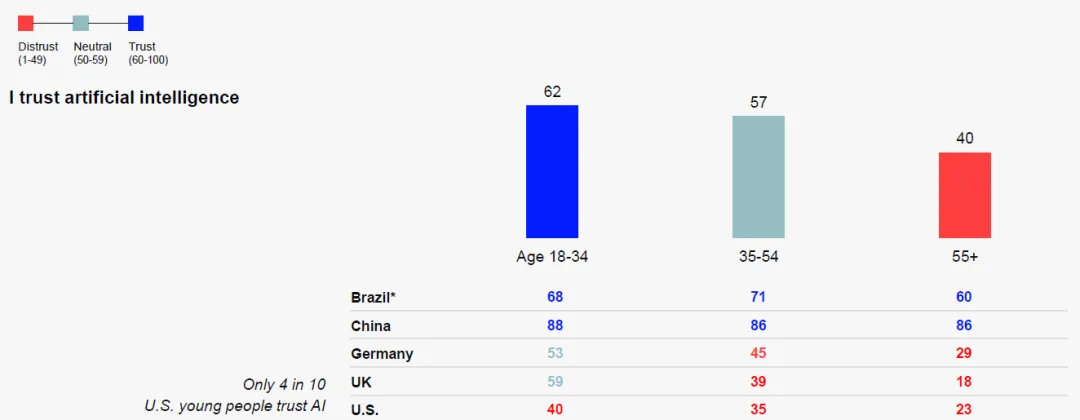

年龄层面,18-34 岁群体信任率(62%)高于 35-54 岁(57%)与 55 岁以上(40%)群体。

(二)信任驱动与阻碍因素

核心驱动因素:认知水平与信任直接相关,了解 AI 的群体接受度提升 17.45%;个人体验是关键变量,AI 对复杂问题的解释能力可使信任率提升 36-46 个百分点;透明度与可追溯性增强信任,明确的数据使用规则、决策逻辑披露能显著提升接受度。

主要阻碍因素:信任问题是首要障碍,70% 的美国用户、57% 的德国用户因数据安全与技术可信度放弃频繁使用 AI;就业担忧加剧抗拒情绪,69% 的巴西用户、62% 的中国用户认为企业领导人未如实披露 AI 对岗位的影响;技术滥用风险(深度伪造、虚假信息)降低社会信任基础。

六、未来展望与发展建议

(一)技术与测评发展趋势

测评技术迭代方向:自动化测评成为核心,依托强化学习与生成式 AI 实现测试用例动态生成与风险智能定位;全生命周期融合测评普及,将安全测试嵌入设计、训练、部署、退役全流程;跨模态测评技术突破,应对多模态协同攻击与风险传导。

标准协同发展:推动国际核心指标统一,提炼各国共识性要求形成通用测评基准;预留区域适配接口,兼容不同法律与文化背景;构建产学研协同生态,整合技术研发、实践验证与标准落地全链条资源。

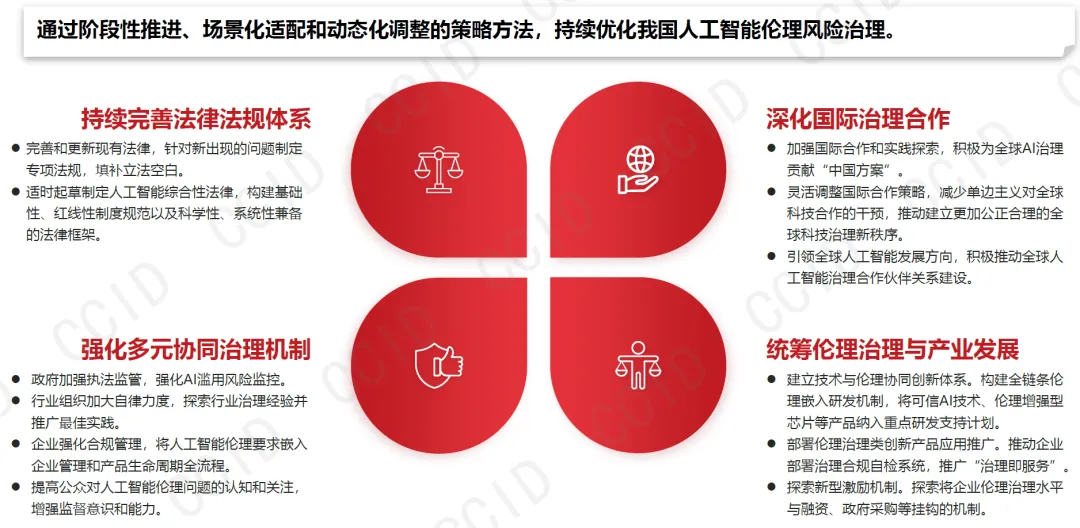

(二)核心发展建议

完善治理体系:加快人工智能综合性立法,细化分类分级监管规则,强化法律法规与标准的衔接配套;建立 “政府监管 - 行业自律 - 企业合规 - 公众监督” 多元协同机制,压实各方安全责任。

强化技术支撑:加大可信 AI 技术研发投入,推动伦理增强型芯片、安全护栏等产品落地;推广 “治理即服务” 模式,部署合规自检系统,实现风险动态监测与应急响应。

深化国际合作:依托联合国、APEC、G20 等多边机制,加强治理理念与标准互鉴;支持发展中国家能力建设,通过技术转让、人才培训缩小智能鸿沟;共同应对跨境 AI 风险,建立威胁信息共享与联合处置机制。

促进产业协同:企业应将安全伦理要求嵌入产品全生命周期,主动参与标准制定与测试验证;行业组织牵头制定自律规范,推广最佳实践;科研机构加强基础理论研究,培养既懂技术又懂规则的复合型人才。