欢迎关注下方公众号阿宝1990,本公众号专注于自动驾驶和智能座舱,每天给你一篇汽车干货,我们始于车,但不止于车。

摘 要:智能网联与自动驾驶技术的突破推动汽车座舱由传统功能集成向高阶智能认知演进。高阶认知座舱通过感知-认知-决策-优化的闭环技术架构,构建以人为中心的智能交互新范式。梳理了高阶认知座舱技术架构,聚焦人车交互关键技术,重点分析大语言模型在优化情境理解适应性及意图识别准确性方面的赋能机制,并探讨舱驾一体化框架下多模态状态感知与协同决策技术对实现人-车-环境三域协同与控制权安全接管的支撑作用,总结了当前面临的技术瓶颈与未来研究趋势。

随着技术革新与产业转型,人、车、路、云高度一体化的智能交通系统是互联时代的重要发展方向,智能网联汽车作为多行业、多领域技术融合的载体,是交通系统的核心单元[1]。智能网联汽车能通过传感器、控制器、执行器等硬件设备,结合大数据、云计算及人工智能(AI)技术,实现实时的环境感知、智能决策和协同控制,进而实现高安全、高效率、高舒适的自动驾驶。国际汽车工程师学会(SAE)根据自动化程度将智能汽车由人工手动到系统自动的过渡过程划分为6 个离散等级[2],预期实现全天候、全场景、全状态下的完全自动驾驶。自动驾驶系统能逐步释放驾驶员在动态驾驶任务中受到的约束,激发了驾乘人员对座舱高娱乐性、高宜人性的新需求。座舱由传统机械传动的驾驶控制空间,到电控单元集成的数字化座舱,进而向具备V2X 通信与AI 决策能力的智能终端,可感知驾乘人员状态并建立情感联结的“第三生活空间”演进,使汽车超越交通工具的定义,成为工作、休憩、娱乐一体化的移动智能空间。

智能座舱是智能网联和人机交互技术的综合应用空间,能促进汽车行业技术创新、带动相关产业链协同发展,并推动智能技术与产品市场的深度融合,在汽车领域发展中兼具实践与战略意义。高阶认知座舱指高度智能化、网联化的智能座舱,其标志着由信息呈现和功能集成向认知建模和主动交互的跃迁,已成为当前汽车技术创新的核心驱动力。传统座舱在驾驶操纵性能方面关注动力性、安全性及平顺性;在乘坐舒适性能方面关注空间布局合理性、座椅的支撑性,高阶认知座舱突破了基础功能限制,发展为融合人工智能、材料科学、信息通信、传感技术、物联网、虚拟现实和增强现实等跨领域技术的集成平台。其技术架构包括座舱硬件的架构重构、域控制系统的高度集成、座舱环境的智能优化3 个维度。高阶认知座舱作为面向终端用户的技术展示窗口,直观体现了高度集成化技术的应用水平,承担着技术市场化验证的重要功能[3],由此可见,高阶认知座舱构成了传统汽车产品智能化演进中的核心技术锚点。高阶认知座舱是汽车产品差异化的核心竞争力,具有用户直接可见、高感知度、高接受度的特性[4]。相较于自动驾驶系统依赖于感知决策算法准确性、法律法规完备性以及整车系统冗余性,其技术实现途径可控性高、产品商业化周期短[5]。相较于传统座舱,高阶认知座舱从统一配置转向持续进化、从封闭系统转向开放生态、从辅助功能载体转向主导体验平台,重塑整车价值体系,成为智能汽车差异化的突破点。

作为人车交互的枢纽,高阶认知座舱受到产学研各界广泛关注,其设计仍面临机遇和挑战。未来座舱的关键研究领域和难点如下。

智能主动交互的宜人性优化,随着用户需求层次的提升,高阶认知座舱需提供具备高认同感、高个性化的主动交互服务。其核心难点在于座舱环境与人员情绪的不确定性导致行为状态难以精准识别;行为序列与交互意图的时空因果关系隐匿,使心理动因难以推断;情感反馈的复杂性导致交互效果难以量化并用以优化模型。

主次任务协调的安全性保障,人机共驾模式下驾驶员的任务分离状态导致驾驶员态势感知下降,使其在突发接管时面临高风险。其核心难点在于精准预测控制权转换时刻,并通过清晰、准确的情境信息传递,增强驾驶员的情境理解与控制能力,降低其认知负荷,从而确保接管过程的安全性与平滑性。

本文首先概述了汽车智能座舱定义、智能层级与技术支撑。在此基础上,聚焦高阶认知座舱的核心人机交互技术,提出感知-认知-交互-评价的逻辑框架,重点总结了大语言模型赋能与舱驾一体化技术,大模型赋能高阶认知座舱实现精准用户意图识别、情境理解及个性化服务生成;舱驾一体化推动车辆控制与交互系统深度融合,为应对交互宜人性与接管安全性等核心挑战提供了关键技术支撑。最后,分析了实现高阶认知座舱所面临的挑战,展望未来研究的发展趋势。

1 高阶认知座舱概述

1.1 智能座舱的定义与分级

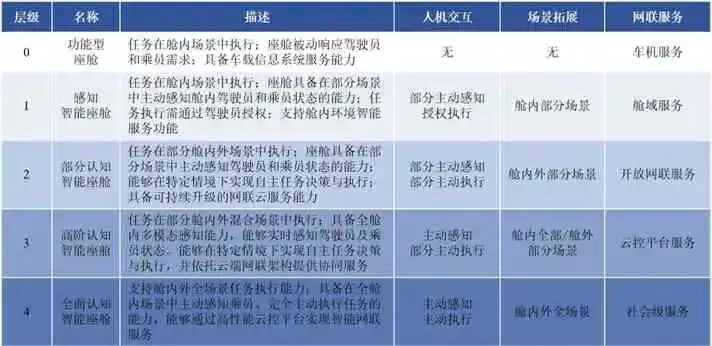

汽车智能座舱是指集成了先进系统及前沿技术的移动空间,具备人机交互、场景扩展和网联服务的能力,能为乘员提供高宜人性、高安全性、高愉悦度的综合体验。智能座舱的演进如图1所示。

图1 智能座舱演进蓝图

该标准通过界定人机交互、场景扩展和网联服务3 个技术维度的能力水平,将智能座舱从传统功能到全面智能的演进过程进行明确划分与详细阐述。其中人机交互能力指智能座舱感知、理解乘员需求并生成决策以服务乘员的能力;场景扩展能力指服务人员拓展及应用区域拓展的能力;网联服务能力指智能座舱为乘员提供多元化服务的能力。多维度能力的优化与融合促使智能座舱从单一功能模块进化为具有综合服务及自主进化能力的数字生命体。多维能力的不断优化与深度融合促使智能座舱逐渐从单一功能模块演进为具备综合服务与自主进化能力的数字生命体。各个级别的具体特征如图2所示。

图2 智能座舱分级描述

随着智能座舱技术层级的演进,其人机交互范式由初期被动响应驾乘人员操作指令的基础交互,逐步发展为具备主动环境感知、人车自然交互与车云服务能力的智能交互。这一演进过程表现为3 个维度的协同发展。

(1)交互智能深化:任务执行动因由指令执行跃迁至主动认知交互,实现宜人化、个性化的服务。

(2)交互场景扩展:任务执行场域由舱内局部空间延伸至车外全域环境,实现全场景化服务生态。

(3)网联服务融合:服务架构从封闭的车机系统逐步演进为开放式的车路云协同平台,最终嵌入智慧城市基础设施网络。

高阶认知座舱旨在重塑人车交互范式及智能情感关系,以人为核心,发展全场景、多维度感知人、理解人、服务人的能力,促使驾乘人员接纳和信任座舱系统,并提升功能和情感依赖度。现有研究与产业实践处于智能感知座舱及部分认知座舱阶段,高阶认知座舱的实现面临极端环境下的感知性能不佳、交互意图预测精准度不足、高价值人车交互数据匮乏等挑战。大语言模型凭借其强大的情境推理与知识泛化能力,能为上述挑战提供新的技术路径,通过增强语义理解、生成仿真数据与优化交互逻辑,实现语境泛化与隐式意图推断,促使座舱系统具备少样本自适应与多轮任务推理能力,已成为高阶认知座舱的重要研究方向。

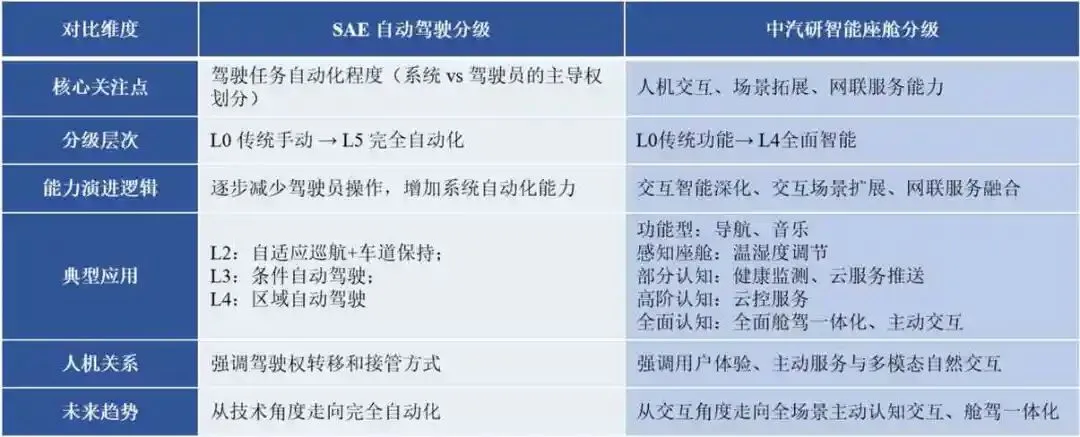

在智能汽车的演进过程中,智能座舱分级体系与智能驾驶分级体系分别从不同维度描述技术发展路径。智能座舱分级聚焦交互与智能维度,以人机交互与用户体验的智能化程度为衡量标准,强调座舱人机交互能力的演进和人-车-云-环境的协同。智能驾驶分级体系聚焦驾驶任务维度,以驾驶任务的功能划分与人车职责边界为核心指标,强调系统在环境感知、行为决策与执行控制三大核心环节中自主能力的阶跃。虽然两者在初始定位上存在差异,但其在系统演进过程中存在高度的互补与耦合。驾驶自动化等级的提高,对驾驶员状态感知、多模态自然人机交互及动态接管辅助等功能提出了高精度、高可靠性与高实时性的技术要求;座舱智能化技术的完备性,直接决定驾乘人员对高阶自动驾驶功能的接受性与系统运行的安全性。例如,L2、L3 级别自动驾驶汽车依赖于驾驶员不定期接管,座舱需具备疲劳、分心识别与多模态交互能力,以保障控制权切换的灵活性与安全性;L4、L5级别自动驾驶支持驾驶员角色转变为乘员,座舱需提供情境感知与个性化服务,以优化用户的信任感与体验感。如图3 所示,分析智舱与智驾在技术导向与阶段目标等方面的差异性,有助于阐释复杂系统中舱、驾的协同机理。智驾与智舱系统通过功能协同与数据融合,形成深度依赖与共生的技术体系,二者共同构成新一代智能汽车的核心架构基础。这一演进逻辑揭示了舱驾一体化的必然性。

图3 智能驾驶与智能座舱分级对比

1.2 高阶认知座舱技术架构

高阶认知座舱作为一个跨学科、跨系统的复杂技术体系,其总体架构可概括为三层支撑、一维核心、两环驱动、三域协同。

三层支撑是高阶认知座舱提供服务的基础保障与技术支持,包括硬件支撑层、软件支撑层和服务支撑层。硬件支撑层提供座舱运行的物理载体和算力基础,涵盖传感器[7-10]、执行器及域控制器。传感器和执行器负责感知和执行座舱内外的各种操作和环境信息。域控制器负责管理和协调各种传感器和执行器的操作,同时处理座舱内的数据和任务。系统级芯片(SOC)是座舱硬件支撑的核心。目前国外企业在座舱SOC 技术方面相对领先,高通SA8155P 集成人工智能引擎、中央计算单元、视觉子系统等多个处理器,能将液晶仪表、中控大屏、抬头显示器[11](HUD)、流媒体后视镜、后座显示屏等多个屏幕功能集中整合到一块芯片上,通过一个座舱域控制器实现“一芯多屏”,成为国外最主流的座舱SOC芯片。软件支撑层是座舱硬件与交互服务间的连接桥梁。操作系统(OS)为上层软件提供运行环境、运行机制、通信机制和安全机制等,该系统需同时确保座舱功能运行的稳定性、可靠性及用户数据的安全性与隐私性。对座舱交互性能与互联生态起决定性作用。座舱OS 可以划分为基础型OS、定制型OS、ROM 型OS。基础OS包括系统内核、底层驱动等,赋予操作系统最基本的功能。定制型OS通过对基础型OS的定制化开发,包括修改内核、程序框架、硬件驱动。ROM 型OS 则是对基础型OS 进行有限度的定制开发,通常仅优化原基础型OS 配备的应用程序,是当前车企研发的主流选择。服务支撑层保障座舱的功能扩展与迭代进化。通过增强现实抬头显示(AR-HUD)、智能座椅来优化用户的驾乘体验。AR-HUD 结合AR全息技术,通过光学投影技术于驾驶员视线中呈现虚拟信息增强效果,避免驾驶员视线在现实世界与仪表、屏幕间频繁调整[12]。作为传统仪表盘显示的补充,能实现更加精确、实时、全面的驾驶信息感知,进而提升驾驶安全性。座椅作为驾乘人员与座舱接触的主要界面,其舒适性直接影响驾驶和乘坐体验。吴冠琦等[13]提出记忆预设方案,设计了一款能自动调节靠背、坐垫及扶手高度的主动升降式座椅,优化了乘坐舒适性。车企通过搭载车内语音助手实现用户与座舱间的自然语言交互。语音助手具备高交互精准度,通过声源定位、语义理解识别用户语音指令,执行交互服务。

一维核心聚焦于人机交互技术,其作为高阶认知座舱的价值中枢,承担着融合硬件层的多模态感知信息、上下文语义理解与智能决策反馈的关键职能,旨在为用户构建自然、高效且安全的交互体验。该核心通过融合计算机视觉、语音信号处理及自然语言理解等技术,实现对用户意图的精准感知与解析。近年来,以大语言模型为代表的新兴人工智能技术,显著增强了交互核心在复杂语境下的对话管理、情感计算与多轮任务规划能力,推动了其从被动响应向主动智能的服务范式转变。

两环驱动是高阶认知座舱实现功能执行与性能优化的核心机制,包括运行闭环与进化闭环。运行闭环实现座舱功能的宜人性与实时性,遵循感知-决策-执行的逻辑回路。该闭环通过传感器阵列实时采集环境与用户状态信息;由域控制器及操作系统对多源数据进行数据融合、情境建模与决策推理;最终通过屏幕、音响、执行器等终端设备完成服务渲染与物理交互,确保功能响应的低延迟与高可靠性。进化闭环是驱动系统持续学习与迭代优化,遵循数据采集-评估分析-优化迭代-车端部署的性能演进路径。通过收集脱敏后的系统运行日志与用户交互数据;基于云端评估框架对模型效能与服务满意度进行量化洞察与根因分析;据此生成参数优化策略或新功能模块;最终将增强算法部署至车端,实现座舱系统全生命周期的自适应优化。

三域协同推动高阶认知座舱实现功能融合与全域智能,涵盖座舱域、驾驶域与云域。三域通过高速车载网络与通信协议实现数据共享与功能协同,共同构建人-车-路-云一体化的智能服务生态。座舱域聚焦于驾乘人员的舒适性与娱乐性需求,是人机交互的核心载体。该域以座舱域控制器为核心,集成仪表盘、中控屏、抬头显示(HUD)、音响系统、座椅控制器等终端设备,实现多模态交互响应、座舱环境智能调节以及信息娱乐服务推送,通过多感官的交互服务营造更健康、愉悦的车内环境,以实现驾乘人员的高舒适性和高愉悦感。此外,研究人员采用噪声抑制技术改善座舱的声学环境,减轻了音响音质和语音交互的负面影响[14]。通过个性化的氛围灯照明系统和阅读灯照明系统优化光线环境,增强了定制化的氛围体验[15]。座舱域以用户体验为中心,其核心目标为优化驾乘人员在行车过程中的体验多元化与情感满意度。驾驶域侧重于车辆行驶过程中的安全保障与辅助决策,负责实现驾驶任务中的人机共驾与接管交互功能。该域通过融合多模感知、高精定位与规划控制算法,实现对车辆状态与外部环境的实时监控。在高级别自动驾驶场景中,认知座舱需与驾驶域紧密协同,执行驾驶员状态监测、安全预警、人机接管请求及自动驾驶状态可视化等关键任务,确保行车过程的安全性。脑控车辆技术[16]通过头戴设备收集脑电波,监测用户状态并预测下一时刻的驾驶意图,授权智能汽车主动干预驾驶任务,执行用户预期驾驶操作。丰田[17]通过舱内摄像头监测驾驶员的眼部和头部运动,评估驾驶员的疲劳状况并触发自动驾驶系统接管驾驶任务以保障行车安全。云域作为高阶认知座舱的远端能力扩展与数据智能中心,通过云计算平台与人工智能技术,为车端提供弹性算力与知识服务支撑。该域通过V2X通信实现车辆与云端基础设施的互联,承担海量行车数据存储、场景模型训练、用户行为分析及个性化服务生成等任务,并借助OTA技术实现系统功能的持续迭代与服务的广泛覆盖,推动智能座舱从功能固化向体验进化的范式演进,实现高智能化、高主动化的人车交互。

2 高阶认知座舱核心技术

人机交互能力是推动驾驶舱智能化的关键。其核心机理是通过感知驾驶舱内人员及驾驶舱外环境信息,获取多模态信息,深入了解驾乘人员当前的动作行为和情感状态,结合历史数据预测用户在当前场景可能需要的功能,确定这些功能的组成和重要性,然后通过适当方式与用户交互以提供服务[18]。

2.1 高阶认知座舱交互流程框架

人机交互的功能机理包括以下4个步骤:

(1)通过座舱内外安装的传感器采集车辆信息与用户信息[19];

(2)对多源异构数据进行处理及分析并预测用户在当前情境下可能需要的功能;

(3)通过适当的形式与用户交互,为用户提供服务[20];

(4)建立用户反馈的闭环优化机制,实现感知-决策-交互全周期的迭代优化。

交互流程框架如图4所示。

图4 高阶认知座舱交互流程框架

从系统功能角度,引入以人为核心的高阶认知座舱人车交互流程框架,包含多模感知、认知决策、主动交互与评估进化4 个模块。该框架通过多源信息融合与意图建模,构建了从环境感知到服务优化的闭环反馈系统,显著提升了座舱系统的情境理解与个性化服务能力。

多模态感知模块作为认知座舱的信息输入中枢,其核心功能包括数据采集与特征提取两个维度。该模块通过异构传感器实时获取车辆状态[21]、乘员生理特征[22]及外部交通状态等多源数据,从原始信号中提取高阶特征为认知决策模块提供数据基础。在认知座舱的应用场景中,感知模块的性能直接决定系统对驾驶员状态及动态环境的分辨与解析能力,进而影响决策算法的准确性与交互策略的适配性。

认知决策模块作为认知座舱的运算中枢,其任务为了解用户状态,理解用户需求,设计合理的决策以服务用户。其核心功能在于解析感知模块传输的多模态数据。检测驾乘人员的行为、状态及当前所处场景,依据驾乘人员行为序列及历史数据预测用户意图。决策机制的预期是既能精准理解用户显性需求,又能主动预测隐性需求。该模块算法的准确性、高效性直接决定认知座舱的系统性能及用户体验感。

主动交互模块是认知座舱的服务输出终端。当认知决策引擎完成情境建模并生成优化策略后,交互模块通过多模态交互执行服务指令,实现座舱系统与用户、外部环境的协同交互。该模块支持驾驶任务辅助、乘员舒适度调节、信息服务推送等多元化功能场景。

进化评估模块构建了基于评价反馈的自适应优化机制。该模块通过交互时长、错误操作率等隐式反馈与满意度问卷等显式评分量化用户对服务的接受度,并利用数字孪生技术构建虚拟测试环境,持续优化感知算法与决策模型。这种基于数据驱动的迭代机制优化了系统的情境适应能力。用户体验的量化评估需要建立多维指标体系,包括任务完成效率、认知负荷[12,23-24]等客观指标,以及可用性、愉悦度等主观评价维度。

随着大语言模型赋能认知座舱系统,座舱能通过持续学习用户个性化需求、多样化行为模式与交互体验信息,不断迭代优化其意图理解与决策生成能力,形成以驾乘人员为中心的循环反馈与自动进化,促使座舱向高阶认知、全面智能演进。

2.2 高阶认知座舱交互关键技术

2.2.1 多模感知

感知模块的主要任务是监测驾乘人员状态,结合座舱场景及外部环境信息传输至认知决策模块。在当前及中长期的技术演进阶段,车辆控制系统将持续处于人机共驾的过渡模式,车辆控制权分配将持续遵循人机混合决策范式,实时监测驾驶员是否出现注意力不集中是辅助构建控制权动态分配算法,实现接管/示警需求的精准预测与适时干预的前提。在驾驶行为研究中,注意力不集中主要表现为无其他干扰的情况下,驾驶员对关键安全驾驶活动的关注度降低[25]。通常由两种因素引发分别是分心[26-27]与疲劳[28-30]。对疲劳检测关注驾驶员的可能导致警觉性或驾驶性能下降的生理状态;对分心检测的核心是识别驾驶员注意力从主要驾驶任务转移的行为。识别驾驶员分心、疲劳方法主要包括基于车辆传感器数据的识别方法[31-32];基于生理状态的识别方法;基于视频图像的识别方法。基于车辆传感器数据的识别方法通过惯性测量单元(IMU)[33]、GPS[34-35]和外部摄像头[36-37]等传感器实时监测车辆状态。采集车速、偏航角以及车道保持等数据,与正常驾驶时的车辆数据进行多变量相关分析,通过两者的数据误差评估驾驶行为的合理性,从而评估分心/疲劳。GAO Zhenhai 等[38]提出一种基于方向盘转角时间序列分析的困倦检测方法,提高了疲劳分类准确性。ZHANG Weihao等[39]基于二元Logistic 回归和Fisher 判别分析,利用车道保持误差来区分正常和分心驾驶。基于生理信号的检测方法是通过采集、记录、检测和分析能反映驾驶员分心、疲劳状态的各种生理信号以检测分心及疲劳。研究表明,当处于注意力不集中状态时,驾驶员的生理参数会与标准状态明显不同,因此,可通过驾驶员生理信号的变化来评估其疲劳程度。主要方法是通过脑电图[40-41](EEG)、心电图[42-43](ECG)、眼电图[44](EOG)和表面肌电图[45-47]等生物电信号的变化来检测驾驶员的生理信息。脑电图被认为是疲劳识别的“金标准”,MORALES等[48]设计单通道脑电设备用于评估驾驶员疲劳水平,心电图的参数心率(HR)与(HRV)通常被用于检测疲劳。GROMER 等[49]通过采集分析驾驶员的HRV 数据识别驾驶员的困倦状态。眼电图信号反映了驾驶员的眼睛注视方向。ARTANTO 等[50]发明了一种贴附在眼睑皮肤上的眼电信号装备,通过检测眼睑闭合识别疲劳,解决了通用眼动仪易遮挡驾驶员的视野的问题。SHI Shengyang 等[51]采集表面肌电信号通过K 近邻分类器分类以检测疲劳状态。基于视频图像的识别方法[52-53]通过视觉传感器获取驾驶员面容图像,通过人脸识别、面部特征点定位等技术提取特征以检测驾驶员状态。BAKHEET 等[54]采用自适应限对比度直方图均衡算法对人脸图像进行预处理,采用增强的主动形状模型算法定位驾驶员眼部区域。ADHINATA 等[55]提出一种将Face Net 算法的特征提取与K-NN 分类相结合的疲劳驾驶检测方法。

自动驾驶系统能支持驾驶员参与次要任务,影响驾驶员的工作负荷。研究人员通过工作负荷检测全面评估驾驶任务或相关任务对驾驶员认知和身体的综合需求。WEI Wanyu 等[56]提出一种基于多模态数据融合的驾驶员心理负荷分类方法,通过量化生理信号、交通条件及环境变量实现综合评估。WANG Ange 等[57]针对L3 级智能车辆,提出基于Transformer编码器的深度学习框架,通过建模数据时序特性评估驾驶员的认知负荷水平。

在驾乘人员对驾乘体验高安全、高愉悦、高认同等新需求的推动下,情感交互逐步成为新兴学术热点[58]。情感交互的目的是赋予高阶认知座舱感知、理解和生成情感表达的能力,通过情绪感知能辅助高阶认知座舱系统优化驾驶员的情绪,增强其对自动驾驶的接受性。早期对情绪感知的研究重点在于提升用户参与度和安全性。研究主要集中于以下两方面,一是挖掘路怒与危险或攻击性驾驶行为之间的内在联系,二是探究负面情绪对驾驶决策和道路安全的影响的现象和机理。针对路怒与驾驶行为关系的研究,研究人员通过问卷调查[59]、驾驶模拟器试验[60]等方法构建路怒情绪与危险/攻击性驾驶行为之间的关联模型,其中驾驶愤怒量表[61](DAS)是评估各类交通情境下驾驶员愤怒程度的通用工具。针对路怒对驾驶行为负面影响的研究表明,路怒情绪显著影响驾驶行为模式,具体表现包括车速提升[62]、跟驰间距缩短[63]、闯红灯频率增加[64]以及攻击性驾驶行为增多。此外,这类情绪状态还与高频鸣笛、礼让行为减少等不良驾驶习惯强相关。驾驶情境特异性愤怒[65]、冲动性及自我控制力[66]等个体特征在愤怒情绪与驾驶行为的因果关系中起关键调节作用。中期研究聚焦于情绪识别与监测技术的突破及其在情绪调节中的应用。该阶段的核心进展包括基于卷积神经网络(CNN)实现了对驾驶员面部表情[67]、生理信号[68]和驾驶员姿态[69]的特征提取及分类,实现高精准的情绪识别;开发鲁棒性系统[70]以采集和标注驾驶员的情绪数据,实现了数据的实时监测与标准化。开发了支持实时情绪状态可视化的交互界面[71],支持交互反馈调节。确保高阶认知座舱情绪感知技术在复杂驾驶及极端环境下的鲁棒性成为研究重点。

多模态融合提升感知性能是当前研究的核心,多模态融合能有效提高座舱在极端场景下的感知性能。在复杂多变的驾驶环境中,单一的传感器或检测技术可能会遇到困难或误报。多模态融合能增强系统的鲁棒性和准确性。

2.2.2 认知决策

高阶认知座舱的人机交互范式由被动响应向主动认知演进,对驾驶员意图的精确预测成为实现高阶主动交互的核心使能技术。驾乘人员与座舱的交互按照交互方式分为显示和隐式交互[72]。显式交互指用户明确、有意识地表达意图和需求,具有确定性和直接性。例如基于语音[73-75]、触觉[76]及手势的交互[77]。隐式交互聚焦非直接交互,座舱通过多模态传感技术提取用户的非结构化行为表征,如身体动作、生理信号、面部表情和环境因素等,实现驾驶情境下的非指令式需求预测与自主服务触发[78]。实现高级别智能化依赖于对隐式交互意图的精准理解。

当前,智能驾驶舱意图预测技术已在三大功能域实现差异化应用。在驾驶控制领域,研究聚焦于基于认知状态的安全意图预测。具体而言,通过多模态传感系统实时采集驾驶员面部表情、眼球运动、心率和驾驶行为,基于多维特征,构建预测模型识别分心、疲劳等危险状态,并触发分级预警系统以实现主动安全干预。FASAMNADE 等[79]构建了基于模糊逻辑的动态贝叶斯分心严重程度分类模型,通过融合驾驶员面部朝向、行为活动特征、手部运动轨迹等多模态输入数据以及历史分心记录预测驾驶员分心的严重程度,为主动安全系统提供分级预警决策依据。XIAO Huafei等[80]提出基于深度迁移学习的算法,通过实时采集的驾驶员面部图像,实现自然驾驶场景下的情绪状态预测。在乘坐舒适领域,研究聚焦于情感驱动的主动安抚交互和座舱部件调节意图预测。在情感安抚意图预测方面,LI Wenbo 等[81]提出将驾驶员面部表情和认知状态特征作为输入预测驾驶员情绪,从而实现情感化人机交互。在部件调节意图预测方面,胡杰等[82]提出双模型耦合方法,结合习惯温度预测模型和时间序列温度预测模型实时预测空调设置。在信息娱乐领域,研究聚焦于情境感知、导航意图预测和音乐推荐。FERENC 等[83]研究模糊逻辑在情境感知预测中的有效性,采用多维关键预测因素集合实现准确的情境感知评估。LI Yu 等[84]构建模糊推理系统,使用导航地图中的兴趣点数据作为语义线索, 推断车辆周围的各种驾驶环境。MUKHOPADHYAY 等[85]提出基于内容特征的协同过滤和K均值聚类的音乐推荐算法。

上述隐式意图预测方法面临以下局限:首先,传统基于规则或数据驱动的轻量化模型方法缺乏可扩展性,仅适用于独立、单任务的意图预测。对于驾舱多源多维的复杂需求则需要多智能系统协同工作。其次,整个推理过程类似于“黑箱”,缺乏直观的可解释性和透明度,此外,现有系统通常缺乏对人类社交情境的建模能力,导致行为理解的局限性,无法有效解析社交礼仪、文化差异等语境依赖行为且适应性不足,难以应对突发社交场景。

大模型的快速发展为解决这些挑战提供了新的技术范式。大语言模型(LLMs)[86-89]通过在大规模跨领域语料(社交互动、人类行为等)上的预训练,使模型具备强大的泛化能力和常识推理能力,同时内化了丰富的人类社交背景知识。大语言模型的核心优势在于能建模复杂的社交情境认知,包括对隐含规则的理解,从而有效弥补传统行为预测系统在社交智能方面的缺陷。基于海量数据训练获得的先验知识使LLMs 能更准确地推断未见场景中的用户意图,并通过自然语言生成提供符合人类认知习惯的可解释输出,显著提升了系统的透明度和用户体验。HiVeGPT[19]支持对话并促进人类驾驶员与驾驶辅助系统间的交互。CHEN Yi 等[90]提出一种专为驾驶员行为意图预测设计的新型语言模型Cockpit-Llama,基于当前驾驶员动作、历史交互记录以及驾驶员与驾驶舱环境状态间的关联分析,实现预测意图,从而支持主动交互决策。

大模型作为高阶认知座舱系统演进的核心驱动力,推动人车交互从基础感知层面向高阶认知智能演进。大模型赋能认知座舱能通过以下机制重构智能服务范式。

(1)利用大模型强大的多模态语义理解能力,精准解析用户输入的语音、手势等多源异构数据,深度挖掘驾乘人员潜在需求。

(2)基于大模型的大规模参数知识库和复杂场景推理能力,实现驾驶情境的实时感知与服务需求的超前预测。

(3)通过大模型的自然语言生成技术,动态构建符合用户个性化特征的交互内容与服务推荐。大模型赋能智能座舱推动座舱完成从被动响应到主动服务的范式跃迁,提升人机交互的拟真度与服务系统的预见性,为汽车座舱向高阶认知智能化发展提供关键技术基础。

2.2.3 主动交互

视觉交互是汽车领域最传统、信息密度最高的交互方式,中央显示屏集成视觉交互多项交互技术[91],能承载更美观的视觉设计、更丰富的功能控制和更具科技感的驾乘体验,已在现代车辆中普及。低头显示器装配于中控台上,驾驶员需由路面转移视线以实现查看提示、阅读信息等操作,由此导致注意力分散、认知负荷增加,降低主要任务的执行能力。抬头显示器(HUD)和头戴式显示器(HMD)设计将虚拟信息元素和真实场景相融合,能有效缓解上述问题,且具有体验沉浸和信息丰富的优势。HUD 通过挡风玻璃将道路环境信息投影于前方道路上,避免用户视线转移、限制驾驶员分心、提升驾乘安全性。AR 全息技术促使HUD 向AR-HUD 技术方向演进,汽车挡风玻璃作为全息显示单元,提供道路交叉引导、自车道路况分析[93]、道路障碍物虚拟透视等服务。AR-HUD 技术能提供核心驾驶信息及信息娱乐功能,基于受抑全内反射(FTIR)原理的新型全息触控显示器,能实现用户与空中立体影像的直接交互。头戴显示器能确保显示屏始终位于驾驶员视野中央。HMD 是一种穿戴式显示设备,搭配单目/双目光学显示设备。HUD与HMD 的技术难点是由照明与混色引起的数字图像模糊问题,需要对背景场景和环境光采样,以实现AR 图像亮度、颜色显示的自适应调整[94];叠加显示系统将信息内容直接投射于驾驶员视野中,可能导致前方道路真实场景中的关键信息被遮盖,进而增加事故发生的风险[95]。HUD/HMD必须部署高鲁棒性的配准算法,以识别并显示环境中的危险因素,避免出现信息遗漏问题影响行驶安全性。

语音交互内容包括通过语音用户界面接收并分析用户指令和基于语音交互的信息提供、功能推荐及建议反馈。语音交互是感知模块的核心,具有不可替代性。其优势为增强座舱的趣味性、情感性及操作便捷性,能为驾驶员保持视线不偏离道路,上肢在操纵方向盘或换挡机构的状态下与车辆实现交互提供可能,从而显著降低驾驶员的注意力分散和视觉认知负荷。功能性语音助手现已逐渐投入汽车应用领域,如BMW 的智能个人助理[96]。语音助手能执行道路交通状况预警、信息娱乐建议、日历事件提醒、舱内温度控制等多项任务。数字语音助手(VA)能提醒驾驶员避让紧急车辆。紧急车辆在执行特定任务时伴随有特征性的警笛声,基于声学的紧急车辆检测方法以及语音预警能协助驾驶员提升态势认知并及时避让。语音交互能针对驾驶员状态有效改善其疲劳与分心情况:研究表明,在易引发疲劳状态的驾驶场景中,与其他乘员交谈能协助驾驶员保持清醒和警觉[97];与VA 进行非指令性的自由对话能更有效地减少驾驶员分心[73,98],短暂且间歇性的谈话方式有助于更好地平衡警觉和专注。因此,语音交互技术的演进路径为采用大语言模型实现高阶认知座舱的自然语言主动交互能力,摆脱人车交互对预定义关键词及用户指令的依赖。考虑到用户追求音频收听、提示获取的个性化、私密性,针对靠近用户位置的扬声器创建个人音频区域避免音频交叉干扰,实现高舒适性和高娱乐性,推动了汽车制造商对个人音频概念的探索和实施。语音交互性能受识别速度及精度影响,难以保证高效率、高精度。

随着高阶认知座舱的应用,驾驶员所能与需要接收的信息爆炸性增长,视觉与听觉交互能力趋于饱和,为了缓解驾驶员的视听压力和减少视听交互带来的注意力分散,需要开辟新的交互信道。触觉交互包括触觉和动觉模态,驾乘人员触觉感知与理解来源于皮肤信息,动觉感知来源于对身体位置、运动的感知,触觉交互的特殊性在于通过物体、环境接触与乘员实现交互,其优势如下。

(1)警示推荐信息直接通过皮肤传感、反馈,具有低认知负荷。

(2)具有直观性、自然性,适用于紧急危险态势下的提示预警。

(3)人-舱通信具有离散性,避免信息交叉、互相干扰,交互具有私密性。

(4)具有高分辨率[99],保证交互灵敏性。

(5)相较于语音、视觉交互,触觉反馈时间短,具有反馈高效性。

振动是最常见的触觉反馈形式,能提醒困倦或分心的驾驶员集中注意力,并有效警告驾驶员潜在的危险情况,例如停车期间发生碰撞[100]、车道偏离[101]、超速[102]等。当前触觉反馈技术仍面临信息编码效率低的技术瓶颈。虽然已有研究成功开发了基于触觉的导航辅助系统,但由于单一振动模态的信息承载能力有限,系统需配置具有八自由度振动输出的可穿戴设备[103],或部署5×5 高密度触觉反馈阵列[104]。这种复杂的振动编码方案要求驾驶员记忆并解析多维触觉反馈信息“密码表”,导致高认知负荷[105],甚至引发二次分心,且难以提供详细指令。在当前技术条件下,触觉反馈更适用于传递紧急告警和基础控制指令等低复杂度信息。

高阶认知座舱交互的信息高密度与用户指令高复杂度导致单模态交互模式难以满足复杂多变的人车交互需求。多模态交互系统定义为能协同处理两种及以上组合输入模式,并与多模态输出系统相协调的智能系统[106]。系统通过多通道输入输出机制,能根据实时驾驶场景和驾驶员认知状态动态调整交互方式,实现以下核心功能。

(1)模态互补:通过跨模态协同弥补单一模态的感知局限。

(2)结果验证:利用多源信息交叉验证交互准确性。

(3)错误纠正:通过模态间约束关系修正识别偏差。

在多模态输入处理方面,系统需建立模态优先级评估机制,基于目标操作特性动态选择以下处理策略。

(1)时间级联模式:时序排列模态输入,利用早期模态的局部信息约束后续模态解析。

(2)冗余并行模式:允许多种交互模式同步进行以提升可靠性。

(3)特征融合模式:将异构模态信息整合为统一交互语义。

多模态主动认知交互正在推动汽车座舱人机交互范式的根本性变革。基于场景驱动的服务推荐机制通过深度挖掘用户行为数据,精准构建用户需求画像,进而生成具有高接受度的个性化交互策略,是高阶认知座舱的重要发展方向。

2.2.4 评估进化

对高阶认知座舱的评估主要考虑两个层面:从用户体验角度评估座舱是否满足用户需求,主要针对高效性与愉悦度;从功能服务角度评估座舱产品的先进性,主要针对安全性与智能化。

用户体验指用户在使用产品过程中形成的综合性感知,包括情感反应、认知交互、服务体验以及生理和心理层面的反馈等。高阶认知座舱人机交互研究中,舒适性作为用户体验的关键维度,因其对用户的技术接受度和系统信任度的显著影响[107],已成为产学研界共同关注的焦点问题。舒适度评价包括主观评价、客观评价和主客观融合的评价方法[108],针对舒适性影响因素,通过数据测量、乘客评分构建座舱舒适度的评价模型。座舱环境包括振动、噪声、温湿度、光照等多个物理场。振动场影响振动舒适性,常用客观评价方法是以座椅为对象,测量车辆振动、加速度等指标以确定舒适度[109]。车辆的垂直振动和换挡冲击对乘员的影响具有个体差异性,振动传递给乘客后成人和儿童的不舒适感存在较大差异[110-111]。噪声场影响声舒适性,噪音会导致压力并干扰注意力,影响驾乘人员的认知表现,干扰其执行复杂任务。通过假人试验和数据统计,能获得车辆内的噪音水平,进而建立噪音与舒适度之间的关系[112-113]。车辆声学舒适度指数可用于建立优化模型,通过研究噪声与振动之间的关联特性,能揭示座舱中声学舒适度的机理[114]。温湿度场影响热舒适性,与驾乘人员的乘坐体验和出行效率存在强相关性。研究表明太阳辐射、车身隔热效果、平均辐射温度和暴露时间均为影响热舒适性的因素[115]。通过传感器监测座舱内的温度分布进行主动温控调节,能优化座舱温度场、提高热舒适度[116]。光照场影响照明舒适性,与乘员情绪及认知负荷存在强相关性。通过个性化的氛围灯照明系统和阅读灯照明系统优化光线环境,根据乘客需求调控颜色和亮度,增强定制化的氛围体验[117]。座舱内的照明受到座舱仪表的影响,眩光问题易诱发驾驶疲劳影响驾驶员操纵性能[118]。除座舱物理场外,乘客的个体特征、坐姿等也会影响人车交互的舒适性[119]。当前座舱舒适性研究聚焦于单因素影响分析,随着座舱智能化的逐步升级,单一因素难以满足对高阶认知座舱舒适度的评价需求。面向车内多物理场环境,挖掘多场环境因素对舒适度的耦合交互影响机制,建立复杂环境的综合评价方法能优化评价的准确性及全面性。CHEN Fei等[120]基于机器学习算法建立汽车座舱舒适度评价模型,实现针对座舱物理环境及人机交互的多因素综合评价。YANG Jianjun 等[121]采集了包括噪声、光线、温度和人机交互舒适度4 个维度的乘员评价数据。通过主客观融合,构建了座舱舒适度综合评价模型。

座舱产品性能评估体系中,主要采用标准化客观测试方法,通过量化测试数据并转化为可比评分,表征不同产品的技术特性差异。高阶认知座舱的客观评估包括实验室静态测试、模拟驾驶平台测试和实际道路测试。实验室静态测试在车辆静止状态下进行,采用人工声学测试系统评估语音交互性能,使用高精度触控模拟装置测试屏幕响应特性,并配置专业光学采集设备记录人机交互过程。模拟驾驶平台测试基于高逼真度驾驶模拟器构建,集成多通道视听模拟系统,配备动态驾驶平台,建立标准化试验接口协议,部署多模态数据采集网络,并开发专业评价管理软件,重点评估次任务操作安全性,通过同步采集驾驶员行为数据与人机交互数据建立多维度交叉分析模型。实际道路测试则在真实交通环境中验证系统功能的完备性,包括驾驶辅助、实时导航等基础功能验证,能源补给点自动规划、目的地智能推荐等智能服务测试,以及特殊天气、异常路况等复杂场景评估,通过实验室可控环境测试与真实道路验证相结合的方式全面检验智能座舱的各项性能指标。

高阶认知座舱与大模型的融合发展已成为提升行业用户体验的关键驱动力,同时也对相关研究者、产业从业者及终端用户提出了新的挑战——如何科学评估高阶认知座舱大模型的能力特征与用户体验。MA Jun 等[122]提出的评价体系P-CAFE,从认知架构、用户体验和大模型能力特征领域出发,提出了感知、认知、行动、反馈和进化5 个维度的指标。大语言模型(LLMs)[123-124]的快速发展为视觉语言模型(VLMs)提供了关键的技术支撑。视觉语言模型(VLMs)与车载系统的深度融合能重塑智能汽车的交互范式和安全体系,其核心能力在于执行视觉问答(VQA)等关键任务上。当前研究领域已有DriveBench[125]和NuScenesQA[126]等基准测试体系,然而这些评估框架主要聚焦于自动驾驶决策场景的VQA 性能评估,在提升驾乘体验的非决策性交互场景方面存在以下两方面局限。

(1)缺乏面向高阶认知座舱非决策场景VLM性能评估的综合基准。

(2)现有基于GPT[127-128]的自动化评估方法采用单一标准,难以适应不同类型查询的差异化需求。

LIN 等[129]提出IntelliCockpitBench 基准,涵盖多样化的汽车场景:包含前视、侧视和后视摄像头图像,覆盖不同道路类型、天气条件及座舱内景,同时整合行驶与静止状态数据。基准中所有图像和查询均通过真实性验证,与现实场景具有高一致性。

2.3 舱驾一体化

智能驾驶系统与认知座舱系统的架构设计长期相互独立,前者聚焦外部行车环境的感知与车辆决策控制,在驾驶员状态监控与行为意图理解方面存在局限性;后者侧重舱内人机交互与乘员体验优化的实现,缺乏对实时驾驶情境的协同响应,二者缺乏深层次的情境贯通与功能联动。高阶智能驾驶系统能释放驾驶员所受约束,支持驾驶员执行次要驾驶任务,同时共享控制为安全及时引入新的脆弱性。智能驾驶系统需座舱系统提供实时精准的驾驶员状态感知信息,并具备高情境适应性的交互能力;认知座舱需依据驾驶场景的复杂度与风险等级,实现信息呈现与交互策略的动态优化,以保障行车安全性与用户体验感。推动智能驾驶与认知座舱的一体化融合,在功能层面实现双向交互与协同优化,已成为汽车智能化的关键发展方向。

2.3.1 舱驾一体化感知

舱驾一体化基于多模态感知的驾驶员状态与驾驶环境融合,将驾驶员内部状态与车辆外部环境进行统一建模,为智能系统决策提供全景感知输入。其主要任务包括驾驶员行为预测、驾驶员状态检测和接管识别[130]。

驾驶员通常根据驾驶场景车辆状态及个人偏好决定其驾驶行为,驾驶行为预测通常基于驾驶员信息或通过对驾驶场景建模来实现。JAIN等[131]提出三层AIO-HMM 网络,采用分层架构,分别对驾驶环境信息和驾驶员状态信息进行特征提取与建模,以揭示外部场景变化与驾驶员内在反应耦合关系,进而输出驾驶员行为的概率分布。传统的随机森林和隐马尔可夫模型等浅层网络模型的特征表达能力具有局限性,导致其仅能处理有限时间窗口内的时间序列数据。相较而言,神经网络能更高效地提取特征并实现更优的数据表示。长短期记忆网络(LSTM)[132]及具备抗遗忘机制的卷积神经网络[133]等结构能显著优化长时依赖和复杂特征模式的建模能力。XING Yang 等[134]提出了基于带有LSTM 单元的循环神经网络的驾驶员行为预测模型。

传统的驾驶员状态检测研究通常局限于驾驶员自身的生理信号与行为特征。基于舱驾一体化的驾驶员状态检测方法则引入多模态融合视角,将驾驶员状态、动态驾驶场景及车辆运行参数纳入统一分析框架,旨在揭示三者间复杂的交互机制。其优势为拓展了状态感知的维度,促使自动驾驶系统深入理解驾驶状态与场景语境间的耦合关系,从而优化决策的态势感知能力。GUO Zizheng 等[135]将脑电图(EEG)信号与驾驶场景中的路况相结合,以评估驾驶员的警觉水平。

复杂环境下的完全自动驾驶系统仍面临技术挑战,包括对高度动态与不确定场景的实时感知、极端天气与复杂交通流中的可靠决策,以及突发状况下安全性与通行效率的协同优化等。人车共驾作为关键过渡模式,旨在确保自动驾驶系统在设计运行域(ODD)外的安全驾驶。人机共驾的核心特征为人类驾驶员与自动化系统在控制权上的深度交互与动态协作[136],人与系统共享并交换控制权诱发接管安全问题。一方面,在条件自动化驾驶模式下,驾驶员执行非驾驶相关任务导致驾驶员注意力分散及疲劳积累,进而削弱其态势感知能力,降低驾驶性能[137];另一方面,高复杂性、不确定性的驾驶环境导致自动驾驶系统超出其设计运行域,驾驶员须不定期接管控制权[138],重新进入控制回路并有效接管车辆。接管表现直接决定车辆的运行状态与轨迹稳定性,进而影响行车安全。研究人员依据驾驶员状态信息[139-140]及动态驾驶场景信息,估计驾驶员的态势感知,预测其接管表现。舱驾一体化接管问题研究的优势为深度融合驾驶员内部状态与外部环境信息,能实现更精准的接管准备程度的预测与分类。HAYASHI 等[141]提出态势感知性能预测模型,该模型融合驾驶员的视觉注意力区域及驾驶场景中车辆和障碍物的信息,通过支持向量机(SVM)对态势感知性能进行分类。QIU Yuning等[142]采用3D 卷积提取驾驶员注视热图和驾驶场景语义分割图像并与驾驶员的生理信号和车辆状态相结合,以实现驾驶员接管意图预测。

在人机共驾系统中,驾驶员作为人-车-路闭环系统中的关键节点,其状态行为与系统的稳定性及安全性强相关。不同驾驶员的生理特征与驾驶风格存在差异。研究表明[143],相同疲劳程度下,不同驾驶员的眨眼持续时间存在显著差异。传统舱驾一体化感知侧重共性驾驶特征,缺乏对个性化特征影响状态识别机制的挖掘,导致驾驶员成为“人-车-路”闭环中制约系统可靠性的关键因素[144]。个性化驾驶员感知包括驾驶员状态检测和驾驶风格识别。

个性化驾驶员状态检测通过引入驾驶员特异性特征,旨在提升状态识别的准确性与鲁棒性。该技术通过识别不同驾驶员之间生理信号(如脑电信号、皮电信号、光电容积脉搏波等)和外部特征(如面部特征等)的差异性以实现高精准识别。CHOI 等[145]提出一种基于决策边界优化的个性化建模方法。通过选取位于当前决策边界的数据样本,将其与新增个性化数据融合,用于迭代更新决策边界。通过融合通用数据集上训练的全局模型与局部个性化模型,优化模型的个性化性能。CHENG Ming 等[146]提出一种免校准的感知方案,能依据不同驾驶员的生理特征自适应调整眼睛闭合的判断阈值,从而有效缓解因眼部形态差异所导致的疲劳状态误判问题。

驾驶风格识别旨在优化舱驾一体化决策的个体适应性。该技术不仅能实现驾驶决策的个性化适配,还能有效识别并干预不良驾驶行为,以实现驾驶任务的高安全性。机器学习算法能通过大量驾驶数据自动推算不同驾驶风格的阈值,采集不同驾驶场景的数据,能提高模型的泛化性,相较于统计学方法具有更好的场景适应性。MOHAMMADNAZAR等[147]提出基于K-Means 聚类的驾驶风格分类方法,通过输入车速、横向和纵向加速度实现驾驶风格的三分类。CAI Yingfeng 等[148]提出一种融合时序建模能力的CNN-LSTM 驾驶风格识别网络。该模型首先通过卷积神经网络提取驾驶风格,进而采用LSTM 建模其动态时序依赖关系,实现驾驶风格的精确分类。

2.3.2 舱驾一体化决策

舱驾一体化决策旨在将驾驶员状态信息嵌入决策闭环,以实现对驾驶员特征与动态场景上下文的一体化建模与协同决策。该算法通过集成多模态感知数据,使系统能胜任人-车-环境耦合情境的决策任务,此类复杂场景通常超出了单一认知座舱或自动驾驶子系统能独立处理的范畴。其主要任务包括车道保持、避障和态势感知增强。

舱驾一体化车道保持决策通过融合驾驶员状态与车道信息,生成车道偏离预警或触发纠偏转向控制,旨在有效干预车辆偏离行为,以最小化对驾驶员的干扰为优化目标的同时,保证驾驶安全性。考虑到驾驶员视线方向与车辆运动轨迹具有高一致性,其视线与道路曲率强相关。因此,视觉信息能作为表征车道偏移的指标。研究表明,驾驶员的眼动信息与车道信息能用于识别无意识车道偏离。POHL 等[149]构建基于规则的车道干预模型,同时识别到驾驶员分心与车道偏离即采用电动助力转向器提供额外的转矩偏移主动干预。REZAEI 等[150]通过分析驾驶员瞳孔形态、车道标线、前车距离及环境湿度等信息,识别驾驶员是否分心。各类输入信息均被赋阈值,通过语言隶属函数将连续型区间值映射为语言变量,采用模糊推理机制决策是否启动车道偏离干预。

舱驾一体化避障决策通过实时感知驾驶员状态与驾驶环境动态信息,实现对行车风险的精准评估,并依据风险等级启动分级预警或触发自动紧急制动系统,从而规避潜在碰撞事故。ZAMORA等[151]提出一种多智能体碰撞预警框架,该框架在既有结构基础上融合本车行为信息,并依据5 类典型危险驾驶场景构建了基于规则的预警生成系统。基于规则的决策方法虽在工程部署层面具有简便性,但其泛化能力存在明显局限。针对特定场景设计的规则体系难以适应未知场景的复杂性与不确定性。机器学习算法由于其数据驱动特性,能实现对多样性场景的泛化适应,且非线性机器学习模型相较于规则模型具有更高精度。ARMAND 等[152]通过贝叶斯网络融合驾驶员意图、驾驶场景和车辆状态,以评估交叉路口的危险级别及所需的驾驶辅助类别。

舱驾一体化态势增强决策通过融合驾驶员的实时注视行为与外部动态驾驶环境信息,构建人-车-环境协同感知框架。识别驾驶员在当前视觉搜索模式下可能遗漏的关键环境要素并生成针对性提示,从而优化驾驶员对复杂行车环境的态势感知能力,保证其决策的可靠性。PETERSSON 等[153]提出交通标志漏看提醒系统。该系统集成包括驾驶员头部姿态、视线方向、车辆状态参数等多维度信息实现决策判断,决策机制依据两个关键判别条件:一是检测驾驶员视线是否落于限速标志区域内;二是判断当前车辆速度是否超出限速要求。若驾驶员未注视限速标志且车辆超速,系统将主动触发预警提示。

驾驶员异质性是其内在的固有特征,主要表现为两种形式:一是个体间异质性,即不同驾驶员对相同驾驶情境作出的差异性行为;二是个体内异质性,即同一驾驶员在驾驶过程中因状态波动而产生的行为随机性[154]。异质性导致驾驶员行为与状态难以被统一建模准确描述,可能导致舱驾一体化决策失效。构建个性化驾驶模型以实现决策适配,建立表征状态依赖行为随机性的推断机制,能有效提升舱驾一体化决策的鲁棒性与可靠性。

驾驶员个体间的异质性能表征为不同时空驾驶情境中行为模式与决策意图的差异性。为减缓此类异质性对系统性能的负面影响,需分析建模驾驶员驾驶风格特征。通过在舱驾一体化决策中融入个性化驾驶员模型,最小化系统指令与驾驶员操作意图之间的差异性,从而生成适配个体偏好的驾驶策略。融合个性化驾驶员特征的跟驰、换道及制动行为模型,旨在实现驾驶辅助系统对个体差异的适应能力,增强人车协同决策的流畅性与一致性。跟驰行为指驾驶员在保持车道的同时,与前车及后车间的纵向交互行为。构建个性化跟驰模型能模拟和预测驾驶员的跟车行为特性,实现个性化跟驰控制。数据驱动模型利用大量驾驶数据,通过强化学习和CNN算法建立个性化驾驶员跟车模型,识别个性化驾驶员特征与驾驶场景之间的复杂关系。QIN Pinpin等[155]提出基于CNN-LSTM 的跟驰模型,将时序驾驶数据输入CNN 以提取车辆参数间的空间特征,进而采用LSTM 实现对跟车速度的准确预测。该模型能生成高精准、多样化驾驶行为序列,且具有良好的泛化性,能适应不同驾驶风格。神经网络训练依赖数据标签,而无监督学习模型及强化学习方法能在无监督条件下从数据中自主挖掘潜在关系。LIAO Yaping 等[156]通过引入LSTM 记忆单元使智能体能融合历史与实时状态信息,构建具备类人驾驶记忆的决策机制,针对不同驾驶风格设计差异化奖励函数。有别于传统参数拟合方法,该强化学习框架能通过数据更新适应不同驾驶风格,有效缓解驾驶员异质性问题。换道行为指车辆自发或被迫从当前车道行驶至其他车道,描述了自车与其他交通参与者间的横向交互。ZHANG Yifan 等[157]考虑周围车辆和自车驾驶风格对轨迹的影响,提出驾驶员操作轮廓(DOP)概念。将自车与他车轨迹转换为DOP,采用CNN 网络提取驾驶风格信息,结合环境因素,输出换道轨迹。考虑到神经网络具有可解释性差、难以追溯和解释网络决策错误机理的问题,ZHU Bing 等[158]提出一种基于门控循环单元和安全场的分层学习换道模型框架,构建包括换道意图识别层、轨迹规划层和控制执行层的3 层架构,引入安全场实现对驾驶轨迹的实时监督,模型能缓解神经网络黑盒导致的问题。驾驶员特征对制动行为的影响主要包括碰撞预警阈值的设置差异以及制动控制策略的选择偏好。IRANMANESH 等[159]考虑驾驶员分心状态对碰撞预警阈值的影响,根据驾驶员的制动数据与分心状态实时动态自适应微调制动预警阈值。ZHU Bing 等[160]采用GA-SVM 算法将驾驶员驾驶风格分为3 类,基于不同的制动踏板压力设计了3 种个性化制动控制策略,通过制动控制策略与驾驶风格匹配,优化驾驶舒适性。

驾驶员的个体内异质性是驾驶不确定性生成的内在机理之一。驾驶决策可被视为一个受多源动态变量调控的随机过程,变量涵盖驾驶员的生-心理状态(如情绪波动、疲劳程度与注意力水平)、短期行为意图以及实时场景语义等多重维度。上述因素的交互与演化,导致驾驶员在特定情境中可能产生偏离预期范式的非确定性行为模式,导致驾驶状态预测与系统协同控制的高复杂度。随机模型预测控制是应对驾驶过程中不确定性的主流控制方法。该方法基于系统不确定性具有随机特性的假设,通过统计分析对系统潜在的不确定性行为进行概率分布建模,并在此基础上构建具有概率约束的优化问题,从而实现对系统未来状态的预测与鲁棒控制[161]。LI Wenjun 等[162]采用随机模型预测控制方法,建模驾驶员处于信号决策困境区中的行为决策过程,实现对车辆在困境区内的运动学与动力学行为的精准表征。考虑到驾驶员行为具有随机性与高度变异性,构建能准确描述并预测其动态特征的数学模型是当前研究面临的核心难题。MIYAJIMA等[163]采用数据驱动方法,基于不同交通条件下收集的大量驾驶数据构建驾驶员行为模型。HUBMANN等[164]通过引入启发式方法,对部分可观测马尔可夫决策过程问题进行近似解搜索,提高了概率预测的收敛性。同时考虑运动规划中特定因素的不确定性提高了算法的收敛效率。

3 高阶认知座舱的挑战和展望

3.1 高阶认知座舱的技术难点

3.1.1 需求洞察力不足导致主动交互场景低覆盖度

现有工程师规则驱动的场景描述方法存在拓展性与泛化性瓶颈。具体表现为场景覆盖度不足,基于有限先验知识构建的规则体系难以完整刻画真实驾乘场景的多样性与复杂性;需求泛化能力弱,静态规则库无法适应不同用户群体的差异化需求;缺乏用户体验定量评估数据及有效的人类反馈机制,导致功能迭代陷入局部最优,系统难以实现持续进化。这种需求洞察力的不足直接造成功能开发与用户真实需求不适配。

3.1.2 通识交互理解能力不足导致主动交互低认同度

驾乘人员行为序列与交互意图之间存在着复杂的非线性时空关联特性。具体表现为:多数交互意图为特定场景下乘员时空行为序列所蕴含的隐性表达,数据与规则结合的意图推理方式难以理解隐性意图,导致意图预测模型难以在稀疏关联度数据的驱动下实现兼顾高精准的人舱交互意图预测;意图表达具有显著的情境依赖性,相同行为在不同场景下映射的交互意图可能存在差异,通过大模型微调的方法难以实现面向座舱交互专用场景的理解,同时会导致模型低实时性,从而影响交互效率。座舱主动交互需要提高模型通识理解能力,结合知识增强推理能力。

3.1.3 主次任务安全协调不足导致主动交互低安全度

舱驾一体化下驾驶员任务与自动化任务的分布式特性以及协调缺陷可能性的增加,为驾驶舱交互带来预期的功能安全问题。在L1~L3 级自动驾驶条件下,频繁的控制权交接过程成为安全隐患的重要来源,驾驶员在自动驾驶任务中的分离状态可能导致其态势感知能力下降。智能驾驶舱需要通过判断人机自然安全切换控制权的时刻并优化交互设计来弥合这一安全缺口,包括提供清晰直观的环境状态、精简有效的交互内容设计以及多通道融合的警告等。

3.1.4 大模型赋能高阶认知座舱导致主动交互低实时度

多模态大模型作为高阶认知座舱核心引擎,能突破上述理解、推理、协调、进化挑战。同时,座舱大模型存在数据依赖性、模型完备性与车载实时性矛盾等瓶颈。具体表现在数据闭环困境,模型性能提升依赖于大量真实输入数据,但车载环境的数据采集面临隐私保护、存储容量和传输带宽等多重约束,导致模型难以持续迭代优化。完备性悖论,模型规模扩大能提升泛化能力,但其在车载计算平台上的部署会导致推理延迟随参数量增大,并呈非线性增长,与实时交互需求产生根本冲突。动态适应滞后,传统离线训练-在线推理的模式难以适应驾驶场景的强时变性,而车载环境下的在线学习难以保证模型的稳定性及行车安全性。

3.2 高阶认知座舱的发展展望

3.2.1 多模态融合提升感知性能

未来的高阶认知座舱将通过融合语音、视觉、触觉等多种模态的人机交互方式,显著增强单一模式的感知能力,从而提升座舱的整体感知与人机交互体验。这将促使座舱从被动响应转向更主动的智能。通过多模态感知系统,座舱将能主动洞察驾乘人员的需求,并在适当时机提供相应的服务与反馈。此外,探索嗅觉、触觉反馈等新兴交互维度的应用潜力也将成为未来发展的重要方向。例如,可以通过车内香氛系统营造特定情境,或通过生理/情感状态识别等技术深入洞察驾乘人员的状态和需求,从而提供个性化服务与实时反馈。虽然脑机接口等前沿技术在信号精度、可靠性、用户接受度与伦理法规等方面仍处于早期探索阶段,但其长远潜力值得持续关注。

3.2.2 中央计算平台加速舱驾融合

汽车电子电气架构正向集中化演进,高阶认知座舱的硬件将依托高性能域控制器与中央计算单元,实现更深层次的跨域融合,从而更好地支持新功能部署与升级,提升用户体验,同时缩短开发周期,降低整车成本。随着车规级计算芯片算力的不断提升,在单颗系统级芯片同时运行认知座舱和智能驾驶功能已成为可能。然而,更高的集成度对软件设计和硬件选型提出了新的挑战。未来的研究重点将放在跨域资源管理、高等级功能安全架构、高可靠性冗余设计及散热能耗优化等方面,以确保在统一计算平台下实现多任务协同的高可靠性、高效性及安全性。

3.2.3 软件架构构建跨域协同

未来的高阶认知座舱趋向于采用更加统一、开放的软件架构,逐步从当前各功能域分散的多个系统,转向跨域协同的整车操作系统(OS)平台。行业正从“软件定义”深入发展,逐步迈向强调“生态定义”的新阶段,即围绕“车辆-用户”体验构建丰富的应用与服务生态,完善车载应用资源,并大幅提升软硬件兼容适配性。未来的研发重点包括模块化的分层设计,通过严格的空间隔离与功能安全划分确保关键任务的高安全性与可靠性,以及将AI 能力深度融入操作系统底层,以支持更加主动智能的座舱服务。座舱功能迭代将更多依赖软件生态而非单一硬件,推动软硬一体的平台化解决方案普及。

3.2.4 大模型深化交互意图预测

大规模预训练模型技术的引入将显著提升未来座舱的人机智能交互水平。利用大模型的强大语义理解与上下文推理能力,并结合基于专家经验与座舱交互数据构建的知识图谱所提供的结构化领域知识,有望显著提升意图预测的精度和理解用户复杂指令的能力。在充足算力与数据的支持下,大模型驱动的车载助手将能更精准地理解和解析用户语音指令,甚至预测其潜在意图。未来研发重点将包括大模型在车端的轻量化部署与优化,以及高效的端云协同策略,以满足严苛的实时性要求并保障数据隐私。此外,还需加强对AI 模型行为的可控性与可解释性研究,避免大模型在执行过程中产生幻觉、偏见或不可控行为,从而引入安全风险,确保座舱智能服务的安全可靠。

4 结语

作为人车交互的核心载体,高阶认知座舱是智能汽车前沿技术高度集成化的应用空间以及汽车产业智能化转型的重要战略突破点,目前已成为产学研各界关注的焦点。高阶认知座舱通过感知-认知-决策-优化的闭环技术链路,构建以人为中心的智能交互新范式。本文首先阐述了智能座舱的定义和智能化分级,梳理高阶认知座舱技术架构与人车交互流程,聚焦高阶认知座舱人车交互的前沿技术演进,梳理大语言模型在交互智能中的作用机制。相较于传统规则驱动方法,大语言模型能通过深层语义建模实现对复杂语境的自适应理解,实现高精度意图识别与语境泛化,从而提升座舱对动态场景与个性化需求的响应能力。同时,探讨舱驾一体化框架下的多模态状态感知与协同决策方法,强调其在人-车-环境三域信息融合、接管安全性保障与决策一致性优化中的核心价值,为高阶认知座舱的实现提供了关键支撑。最后,分析了高阶认知座舱领域面临的挑战和机遇。需求洞察力不足导致主动交互场景低覆盖度,通识交互理解能力不足导致主动交互低认同度,主次任务安全协调不足导致主动交互低安全度,大模型赋能高阶认知座舱导致主动交互低实时度是未来座舱研究的重点与难点。未来高阶认知座舱的发展轨迹将依赖于多模态感知和大模型驱动的交互技术,提高座舱算力与推理模型方面的创新能力,持续性能优化并向全面认知智能座舱转型。

参考文献

[1] LI Wenbo,CAO Dongpu,TAN Ruichen,et al.Intelligent Cockpit for Intelligent Connected Vehicles:Definition,Taxonomy,Technology and Evaluation[J].IEEE Transactions on Intelligent Vehicles,2024,9(2):3140-3153.

[2] On-Road Automated Driving (ORAD) Committee.Taxonomy and Definitions for Terms Related to Driving Automation Systems for On-Road Motor Vehicles[M].Warrendale:SAE International,2021.

[3] LI Shuling,ZHANG Tingru,LIU Na,et al.Drivers’Attitudes,Preference,and Acceptance of In-Vehicle Anger Intervention Systems and Their Relationships to Demographic and Personality Characteristics [J].International Journal of Industrial Ergonomics,2020,75:102899.1-102899.20.

[4] XING Yang,LV Chen,CAO Dongpu,et al.Toward Human-Vehicle Collaboration:Review and Perspectives on Human-Centered Collaborative Automated Driving[J].Transportation Research Part C:Emerging Technologies,2021,128:103199.1-103199.26.

[5] CAPALLERA M,ANGELINI L,METEIER Q,et al.Human-Vehicle Interaction to Support Driver's Situation Awareness in Automated Vehicles:A Systematic Review[J].IEEE Transactions on Intelligent Vehicles,2023,8(3):2551-2567.

[6] 张进华.汽车智能座舱分级与综合评价白皮书[Z].北京: 中国汽车工程学会,2023.ZHANG Jinhua.White Paper on Classification and Comprehensive Evaluation of Automotive Intelligent Cockpits [Z].Beijing:China Society of Automotive Engineers,2023.(in Chinese)

[7] QUANTE L,ZHANG Meng,PREUK K,et al.Human Performance in Critical Scenarios as a Benchmark for Highly Automated Vehicles[J].Automotive Innovation,2021,4(3):274-283.

[8] TEYEB I,SNOUN A,JEMAI O,et al.Fuzzy Logic Decision Support System for Hypovigilance Detection Based on CNN Feature Extractor and WN Classifier[J].Journal of Computer Sciences,2018,14(11):1546-1564.

[9] AN Zhe,XU Xiping,YANG Jinhua,et al.A Real-Time Three-Dimensional Tracking and Registration Method in the AR-HUD System[J].IEEE Access,2018,6:43749-43757.

[10] 李健,吴小青,许海霞,等.汽车零重力座椅的设计分析和发展趋势[J].汽车零部件,2023(2):76-79.LI Jian,WU Xiaoqing,XU Haixia,et al.Design Analysis and Development Trend of Automotive Zero-Gravity Seats[J].Automobile Parts,2023(2):76-79.(in Chinese)

[11] LIN Y D,CHU E T H,CHANG E,et al.Smoothed Graphic User Interaction on Smartphones with Motion Prediction[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2020,50(4):1429-1441

[12] YANG Jianjun,XING Shanshan,CHEN Yimeng,et al.An Evaluation Model for the Comfort of Vehicle Intelligent Cockpits Based on Passenger Experience[J].Sustainability,2022,14(11):1-19.

[13] 吴冠琦,牛瑞坤,卢军锋,等.一种自动升降座椅的设计与研究[J].汽车实用技术,2023,48(24):44-48.WU Guanqi,NIU Ruikun,LU Junfeng,et al.Design and Research of an Automatically Adjustable Seat[J].Automobile Applied Technology,2023,48(24):44-48.(in Chinese).

[14] ROCHE F,BRANDENBURG S.Should the Urgency of Visual-Tactile Takeover Requests Match the Criticality of Takeover Situations?[J].IEEE Transactions on Intelligent Vehicles,2020,5(2):306-313.

[15] LIU Huaping,SUN Fuchun,FANG Bin,et al.Cross-Modal Zero-Shot-Learning for Tactile Object Recognition[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2020,50(7):2466-2474.

[16] HASENJÄGER M,HECKMANN M,WERSING H.A Survey of Personalization for Advanced Driver Assistance Systems[J].IEEE Transactions on Intelligent Vehicles,2020,5(2):335-344.

[17] TASAKI T,MORIYA A,HOTTA A,et al.Depth Perception Control by Hiding Displayed Images Based on Car Vibration for Monocular Head-up Display[C]//2012 IEEE International Symposium on Mixed and Augmented Reality (ISMAR),Nov.5-8,2012,Atlanta,GA,USA.Piscataway NJ:IEEE,c2012:323-324.

[18] SUN Xiaohua,CHEN Honggao,SHI Jintian,et al.From HMI to HRI:Human-Vehicle Interaction Design for Smart Cockpit[C]//Proceedings of the 20th International Conference on Human-Computer Interaction,Part 2,July 15-20,2018,Las Vegas,NV,USA.Berlin:Springer International Publishing,2018:440-454.

[19] ZHANG Junping,PU Jian,XUE Jianru,et al.HiVeGPT:Human-Machine-Augmented Intelligent Vehicles with Generative Pre-Trained Transformer[J].IEEE Transactions on Intelligent Vehicles,2023,8(3):2027-2033.

[20] LI Wenbo,WU Lei,WANG Cong,et al.Intelligent Cockpit for Intelligent Vehicle in Metaverse:A Case Study of Empathetic Auditory Regulation of Human Emotion[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2023,53(4):2173-2187.

[21] BIONDI F,ALVAREZ I,JEONG K A.Human-Vehicle Cooperation in Automated Driving:A Multidisciplinary Review and Appraisal[J].International Journal of Human-Computer Interaction,2019,35(11):932-946.

[22] MANJAKKAL L,YIN L,NATHAN A,et al.Energy Autonomous Sweat-Based Wearable Systems[J].Advanced Materials,2021,33(35):2100899.1-2100899.23.

[23] ZHANG Tianming,REN Jindong.Research on Seat Static Comfort Evaluation Based on Objective Interface Pressure[J].SAE International Journal of Commercial Vehicles,2023,16(4):341-348.

[24] GAO Yanlong,FISCHER T,PATERNOSTER S,et al.Evaluating Lower Body Driving Posture Regarding Gas Pedal Control and Emergency Braking:A Pilot Study[J].International Journal of Industrial Ergonomics,2022,91:103357.1-103357.8.

[25] REGAN M,LEE J,YOUNG K.Driver Distraction:Theory,Effects,and Mitigation[M].Florida:CRC Press,2008.

[26] SHAJARI A,ASADI H,GLASER S,et al.Detection of Driving Distractions and Their Impacts[J].Journal of Advanced Transportation,2023,2023(1):2118553.1-2118553.17.

[27] MOU Luntian,CHANG Jiali,ZHOU Chao,et al.Multimodal Driver Distraction Detection Using Dual-Channel Network of CNN and Transformer[J].Expert Systems with Applications,2023,234:121066.1-121066.8.

[28] CHEN Chuangquan,JI Zhouyu,SUN Yu,et al.Self-Attentive Channel-Connectivity Capsule Network for EEG-Based Driving Fatigue Detection[J].IEEE Transactions on Neural Systems and Rehabilitation Engineering,2023,31:3152-3162.

[29] LYU Hongguang,YUE Jingwen,ZHANG Wenjun,et al.Fatigue Detection for Ship OOWs Based on Input Data Features,from the Perspective of Comparison with Vehicle Drivers:A Review[J].IEEE Sensors Journal,2023,23(14):15239-15252.

[30] AKROUT B,MAHDI W.A Novel Approach for Driver Fatigue Detection Based on Visual Characteristics Analysis[J].Journal of Ambient Intelligence and Humanized Computing,2023,14(1):527-552.

[31] LI Rui,CHEN Y V,ZHANG Linghao.A Method for Fatigue Detection Based on Driver's Steering Wheel Grip[J].International Journal of Industrial Ergonomics,2021,82:103083.1-103083.10.

[32] HE Hongwen,WANG Chen,JIA Hui.A Single-Pedal Regenerative Braking Control Strategy of Accelerator Pedal for Electric Vehicles Based on Adaptive Fuzzy Control Algorithm[J].Energy Procedia,2018,152:624-629.

[33] XIE Ziyang,LI Li,XU Xu.Real-Time Driving Distraction Recognition Through a Wrist-Mounted Accelerometer[J].Human Factors,2022,64(8):1412-1428.

[34] PAPATHEOCHAROUS E,KAISER C,MOSER J,et al.Monitoring Distracted Driving Behaviours with Smartphones:An Extended Systematic Literature Review[J].Sensors,2023,23(17):1-39.

[35] SAJID HASAN A,JALAYER M,HEITMANN E,et al.Distracted Driving Crashes:A Review on Data Collection,Analysis,and Crash Prevention Methods[J].Transportation Research Record,2022,2676(8):423-434.

[36] MICHELARAKI E,KATRAKAZAS C,KAISER S,et al.Real-Time Monitoring of Driver Distraction:State-ofthe-Art and Future Insights[J].Accident Analysis &Prevention,2023,192:107241.1-107241.15.

[37] KASHEVNIK A,SHCHEDRIN R,KAISER C,et al.Driver Distraction Detection Methods:A Literature Review and Framework[J].IEEE Access,2021,9:60063-60076.

[38] GAO Zhenhai,LE D D,HU Hongyu,et al.Driver Drowsiness Detection Based on Time Series Analysis of Steering Wheel Angular Velocity [C]//2017 9th International Conference on Measuring Technology and Mechatronics Automation (ICMTMA),Jan.14-15,2017,Changsha,China.Piscataway NJ:IEEE,c2017:99-101.

[39] ZHANG Weihao,ZHANG Huiyan.Research on Distracted Driving Identification of Truck Drivers Based on Simulated Driving Experiment[J].IOP Conference Series:Earth and Environmental Science,2021,638(1):012039.1-012039.7.

[40] LUO Haowen,QIU Taorong,LIU Chao,et al.Research on Fatigue Driving Detection Using Forehead EEG Based on Adaptive Multi-Scale Entropy[J].Biomedical Signal Processing and Control,2019,51:50-58.

[41] HWANG T,KIM M,HONG S,et al.Driver Drowsiness Detection Using the In-Ear EEG[C]//2016 38th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC),Aug.16-20,2016,Orlando,FL,USA.Piscataway NJ:IEEE,c2016:4646-4649.

[42] HARTLEY L R,ARNOLD P K,SMYTHE G,et al.Indicators of Fatigue in Truck Drivers[J].Applied Ergonomics,1994,25(3):143-156.

[43] WILSON G F,O'DONNELL R D.Measurement of Operator Workload with the Neuropsychological Workload Test Battery[J].Advances in Psychology,1988,52:63-100.

[44] THORSLUND B,ANUND A,FORSMAN A,et al.Electrooculogram Analysis and Development of a System for Defining Stages of Drowsiness:Master's Thesis Project in Biomedical Engineering, Reprint from Linkoeping University,Dept.Biomedical Engineering,LIU-IMT-EX-351,Linkoeping 2003[J].VTI SAERTRYCK,2004,355A:1-44.

[45] FU Rongrong,WANG Hong.Detection of Driving Fatigue by Using Noncontact EMG and ECG Signals Measurement System[J].International Journal of Neural Systems,2014,24(3):1450006.1-1450006.15.

[46] BALASUBRAMANIAN V,ADALARASU K.EMGBased Analysis of Change in Muscle Activity During Simulated Driving[J].Journal of Bodywork and Movement Therapies,2007,11(2):151-158.

[47] KHUSHABA R N,KODAGODA S,LAL S,et al.Driver Drowsiness Classification Using Fuzzy Wavelet-Packet-Based Feature-Extraction Algorithm[J].IEEE Transactions on Biomedical Engineering,2011,58(1):121-131.

[48] MORALES J M,RUIZ-RABELO J F,DIAZ-PIEDRA C,et al.Detecting Mental Workload in Surgical Teams Using a Wearable Single-Channel Electroence-Phalographic Device[J].Journal of Surgical Education,2019,76(4):1107-1115.

[49] GROMER M,SALB D,WALZER T,et al.ECG Sensor for Detection of Driver’s Drowsiness[J].Procedia Computer Science,2019,159:1938-1946.

[50] ARTANTO D,SULISTYANTO M P,PRANOWO I D,et al.Drowsiness Detection System Based on Eye-Closure Using a Low-Cost EMG and ESP8266[C]//2017 2nd International Conferences on Information Technology, Information Systems and Electrical Engineering (ICITISEE),Nov.1-2,2017,Yogyakarta,Indonesia.Piscataway NJ:IEEE,c2017:235-238.

[51] SHI Shengyang,TANG Wenzhong,WANG Yanyang.A Review on Fatigue Driving Detection[J].ITM Web of Conferences,2017,12:01019.1-01019.7.

[52] YANG Chao,WANG Xuyu,MAO Shiwen.Unsupervised Drowsy Driving Detection with RFID [J].IEEE Transactions on Vehicular Technology,2020,69(8):8151-8163.

[53] YOU Feng,GONG Yunbo,TU Haiqing,et al.A Fatigue Driving Detection Algorithm Based on Facial Motion Information Entropy[J].Journal of Advanced Transportation,2020,2020(1):8851485.1-8851485.17.

[54] BAKHEET S,AL-HAMADI A.A Framework for Instantaneous Driver Drowsiness Detection Based on Improved HOG Features and Naïve Bayesian Classification[J].Brain Sciences,2021,11(2):1-15.

[55] ADHINATA F D,RAKHMADANI D P,WIJAYANTO D.Fatigue Detection on Face Image Using Facenet Algorithm and K-Nearest Neighbor Classifier[J].Journal of Information Systems Engineering and Business Intelligence,2021,7(1):22-30.

[56] WEI Wanyu,FU Xinsha,ZHONG Shiyu,et al.Driver's Mental Workload Classification Using Physiological,Traffic Flow and Environmental Factors[J].Transportation Research Part F:Traffic Psychology and Behaviour,2023,94:151-169.

[57] WANG Ange,WANG Jiyao,SHI Wenxin,et al.Cognitive Workload Estimation in Conditionally Automated Vehicles Using Transformer Networks Based on Physiological Signals[J].Transportation Research Record,2024,2678(12):1183-1196.

[58] LI Wenbo,TAN Ruichen,XING Yang,et al.A Multimodal Psychological,Physiological and Behavioural Dataset for Human Emotions in Driving Tasks[J].Scientific Data,2022,9(1):1-20.

[59] SEKADAKIS M,KALLIDONI M,KATRAKAZAS C,et al.The HADRIAN Novel Human-Machine Interface Prototype for Automated Driving:Safety and Impact Assessment[J].European Transport Research Review,2024,16(1):1-15.

[60] LI Haitao,PENG Tao,WANG Bangan,et al.Safedrive Dreamer: Navigating Safety-Critical Scenarios in Autonomous Driving with World Models[J].Alexandria Engineering Journal,2025,111:92-106.

[61] FORBES D,LEARDMANN C A,LAWRENCE-WOOD E,et al.Three-Item Dimensions of Anger Reactions Scale[J].JAMA Network Open,2024,7(2):1-12.

[62] ZHANG Qian,GE Yan,QU Weina.The Effect of Relaxing Music on Driving Anger and Performance in a Simulated Car-Following Task[J].Human Factors and Ergonomics in Manufacturing & Service Industries,2024,34(5):386-395.

[63] SAHU P K,MARAZI N F,MAJUMDAR B B,et al.How are Sociodemographic Differences Contributing to Red Light Violation Behavior?The Underlying Role of Gender,Age,Driving Experience,and Income[J].Transportation Letters,2025,17(2):341-355.

[64] HASSAN A,LEE C,CRAMER K,et al.Analysis of Driver Characteristics,Self-Reported Psychology Measures and Driving Performance Measures Associated with Aggressive Driving[J].Accident Analysis and Prevention,2023,188:107097.1-107097.15.

[65] SUN Y,WANG R,ZHANG H,et al.Driving Fingerprinting Enhances Drowsy Driving Detection:Tailoring to Individual Driver Characteristics[J].Accident Analysis and Prevention,2024,208:107812.1-107812.21.

[66] BAKER N S,VANHOOK C,ZIMINSKI D,et al.“I am a Survivor!”:Violently Injured Black Men’s Perceptions of Labeling After a Violent Firearm Injury[J].Journal of Urban Health,2024,101(3):535-543.

[67] MOHAN K,SEAL A,KREJCAR O,et al.Facial Expression Recognition Using Local Gravitational Force Descriptor-Based Deep Convolution Neural Networks[J].IEEE Transactions on Instrumentation and Measurement,2021,70:1-12.

[68] FANG Zhiwei.A High-Efficient Hybrid Physics-Informed Neural Networks Based on Convolutional Neural Network[J].IEEE Transactions on Neural Networks and Learning Systems,2022,33(10):5514-5526.

[69] GEORGAKOPOULOS S V,KOTTARI K,DELIBASIS K,et al.Pose Recognition Using Convolutional Neural Networks on Omni-Directional Images[J].Neurocomputing,2018,280:23-31.

[70] XIANG Guoliang,YAO Song,DENG Hanwen,et al.A Multi-Modal Driver Emotion Dataset and Study:Including Facial Expressions and Synchronized Physiological Signals[J].Engineering Applications of Artificial Intelligence,2024,130:107772.1-107772.11.

[71] LUO Yuyu,QIN Xuedi,CHAI Chengliang,et al.Steerable Self-Driving Data Visualization[J].IEEE Transactions on Knowledge and Data Engineering,2022,34(1):475-490.

[72] SON Y S,KIM W,LEE S H,et al.Robust Multirate Control Scheme with Predictive Virtual Lanes for Lane-Keeping System of Autonomous Highway Driving[J].IEEE Transactions on Vehicular Technology,2015,64(8):3378-3391.

[73] LARGE D R,BURNETT G,ANTROBUS V,et al.Driven to Discussion:Engaging Drivers in Conversation with a Digital Assistant as a Countermeasure to Passive Task-Related Fatigue[J].IET Intelligent Transport Systems,2018,12(6):420-426.

[74] WONG P N Y,BRUMBY D P,BABU H V R,et al.Voices in Self-Driving Cars Should be Assertive to More Quickly Grab a Distracted Driver's Attention[C]//Proceedings of the 11th International Conference on Automotive User Interfaces and Interactive Vehicular Applications,Sept.21-25,2019,Utrecht,Netherlands.New York:Association for Computing Machinery,2019:165-176.

[75] POLITIS I,LANGDON P,ADEBAYO D,et al.An Evaluation of Inclusive Dialogue-Based Interfaces for the Takeover of Control in Autonomous Cars[C]//Proceedings of the 23rd International Conference on Intelligent User Interfaces,Mar.7-11,Tokyo,Japan.New York:Association for Computing Machinery,2018:601-606.

[76] KABOLI M,WALKER R,CHENG G.In-Hand Object Recognition via Texture Properties with Robotic Hands,Artificial Skin, and Novel Tactile Descriptors[C]//2015 IEEE-RAS 15th International Conference on Humanoid Robots(Humanoids),Nov.3-5,Seoul,Korea(South).Piscataway NJ:IEEE,c2015:1155-1160.

[77] LEE S H,YOON S O.User Interface for In-Vehicle Systems with On-Wheel Finger Spreading Gestures and Head-up Displays[J].Journal of Computational Design and Engineering,2020,7(6):700-721.

[78] LI Bai,CAO Dongpu,TANG Shiqi,et al.Sharing Traffic Priorities via Cyber-Physical-Social Intelligence:A Lane-Free Autonomous Intersection Management Method in Metaverse[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2023,53(4):2025-2036.

[79] FASANMADE A,HE Y,AL-BAYATTI A H,et al.A Fuzzy-Logic Approach to Dynamic Bayesian Severity Level Classification of Driver Distraction Using Image Recognition[J].IEEE Access,2020,8:95197-95207.

[80] XIAO Huafei,LI Wenbo,ZENG Guanzhong,et al.On-Road Driver Emotion Recognition Using Facial Expression[J].Applied Sciences,2022,12(2):1-20.

[81] LI Wenbo,XUE Jiyong,TAN Ruichen,et al.Global-Local-Feature-Fused Driver Speech Emotion Detection for Intelligent Cockpit in Automated Driving[J].IEEE Transactions on Intelligent Vehicles,2023,8(4):2684-2697.

[82] 胡杰,杨博闻,宋洪干.数据驱动的车载空调设定温度预测研究[J].机械科学与技术,2022,41(1):134-142.HU Jie,YANG Bowen,SONG Honggan.Data-Driven Prediction of Vehicle Air Conditioner Set Temperature[J].Mechanical Science and Technology for Aerospace Engineering,2022,41(1):134-142.(in Chinese)

[83] FERENC G,TIMOTIJEVIĆ D,TANASIJEVIĆ I,et al.Towards Enhanced Autonomous Driving Takeovers:Fuzzy Logic Perspective for Predicting Situational Awareness[J].Applied Sciences,2024,14(13):1-22.

[84] LI Yu,METZNER M,SCHWIEGER V.Driving Environment Inference from POI of Navigation Map:Fuzzy Logic and Machine Learning Approaches[J].Sensors,2023,23(22):1-33.

[85] MUKHOPADHYAY S,KUMAR A,PARASHAR D,et al.Enhanced Music Recommendation Systems:A Comparative Study of Content-Based Filtering and KMeans Clustering Approaches[J].Revue d'Intelligence Artificielle,2024,38(1):365-376.

[86] CHOWDHERY A,NARANG S,DEVLIN J,et al.PaLM:Scaling Language Modeling with Pathways[J].Journal of Machine Learning Research,2023,24:1-113.

[87] ZHENG Lianmin,CHIANG W L,SHENG Ying,et al.Judging LLM-as-a-Judge with MT-Bench and Chatbot Arena[J].Advances in Neural Information Processing Systems,2023,36:46595-46623.

[88] TOUVRON H,LAVRIL T,IZACARD G,et al.LLaMA:Open and Efficient Foundation Language Models[Z].arXiv Preprint:2302.13971,2023.

[89] TOUVRON H,MARTIN L,STONE K,et al.LLaMA 2:Open Foundation and Fine-Tuned Chat Models[Z].arXiv Preprint:2307.09288,2023.

[90] CHEN Yi,LI Chengzhe,YUAN Qirui,et al.Cockpit-LLaMA:Driver Intent Prediction in Intelligent Cockpit via Large Language Model [J].Sensors (Basel,Switzerland),2024,25(1):1-19.

[91] KIM J,RYU J H,HAN T M.Multimodal Interface Based on Novel HMI UI/UX for In-Vehicle Infotainment System[J].ETRI Journal,2015,37(4):793-803.

[92] BERRIEL R F,DE AGUIAR E,DE SOUZA A F,et al.Ego-Lane Analysis System (ELAS):Dataset and Algorithms[J].Image and Vision Computing,2017,68:64-75.

[93] NARZT W,POMBERGER G,FERSCHA A,et al.Augmented Reality Navigation Systems[J].Universal Access in the Information Society,2006,4(3):177-187.

[94] GABBARD J L,SWAN J E,HIX D,et al.Active Text Drawing Styles for Outdoor Augmented Reality:A User-Based Study and Design Implications[C]//2007 IEEE Virtual Reality Conference,Mar.10-14,2007,Charlotte,NC,USA.Piscataway NJ:IEEE,c2007:35-42.

[95] BROY N,GUO M,SCHNEEGASS S,et al.Introducing Novel Technologies in the Car:Conducting A Real-World Study to Test 3D Dashboards[C]//Proceedings of the 7th International Conference on Automotive User Interfaces and Interactive Vehicular Applications,Sept.1-3,2015,Nottingham,United Kingdom.New York:Association for Computing Machinery,2015:179-186.

[96] HORN N.Hey BMW,Now We’re Talking!BMWs are About to Get a Personality with the Company’s Intelligent Personal Assistant[Z].2018.

[97] ROSEKIND M R,GANDER P H,GREGORY K B,et al.Managing Fatigue in Operational Settings 1:Physiological Considerations and Counter-Measures[J].Hospital Topics,1997,75(3):23-30.

[98] ANTROBUS V,LARGE D,BURNETT G,et al.Enhancing Environmental Engagement with Natural Language Interfaces for In-Vehicle Navigation Systems[J].The Journal of Navigation,2019,72(3):513-527.

[99] SKEDUNG L,ARVIDSSON M,CHUNG J Y,et al.Feeling Small:Exploring the Tactile Perception Limits[J].Scientific Reports,2013,3(1):1-6.

[100]HIROKAWA M,UESUGI N,FURUGORI S,et al.Effect of Haptic Assistance on Learning Vehicle Reverse Parking Skills[J].IEEE Transactions on Haptics,2014,7(3):334-344.

[101]KATZOURAKIS D I,DE WINTER J C F,ALIREZAEI M,et al.Road-Departure Prevention in an Emergency Obstacle Avoidance Situation[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2014,44(5):621-629.

[102]ADELL E,VÁRHELYI A,HJÄLMDAHL M.Auditory and Haptic Systems for In-Car Speed Management—A Comparative Real Life Study[J].Transportation Research Part F:Traffic Psychology and Behaviour,2008,11(6):445-458.

[103]ASIF A,BOLL S.Right or Left:Tactile Display for Route Guidance of Drivers[J].Information Technology,2012,54(4):188-195.

[104]HWANG J,CHUNG K,HYUN J,et al.Development and Evaluation of an In-Vehicle Haptic Navigation System [C]//Information Technology Convergence,Secure and Trust Computing,and Data Management:ITCS 2012 & STA 2012,Sept.6-8,2012,Gwangju,South Korea.Dordrecht:Springer Netherlands,2012:47-53.

[105]GAFFARY Y,LÉCUYER A.The Use of Haptic and Tactile Information in the Car to Improve Driving Safety:A Review of Current Technologies[J].Frontiers in ICT,2018,5:1-11.

[106]JULIE A.Human Computer Interaction Handbook:Fundamentals,Evolving Technologies,and Emerging Applications[M].Florida:CRC Press,2012.

[107]BELLEM H,THIEL B,SCHRAUF M,et al.Comfort in Automated Driving:An Analysis of Preferences for Different Automated Driving Styles and Their Dependence on Personality Traits[J].Transportation Research Part F:Traffic Psychology and Behaviour,2018,55:90-100.

[108]NADDEO A,CAPPETTI N,D'ORIA C.Proposal of a New Quantitative Method for Postural Comfort Evaluation[J].International Journal of Industrial Ergonomics,2015,48:25-35.

[109]VER I L,BERANEK L L Noise and Vibration Control Engineering:Principles and Applications[M].Hoboken:John Wiley & Sons,2005.

[110]SEZGIN A,ARSLAN Y Z.Analysis of the Vertical Vibration Effects on Ride Comfort of Vehicle Driver[J].Journal of Vibroengineering,2012,14(2):1392-8716.

[111]WICHER J, WIĘCKOWSKI D.Influence of Vibrations of the Child Seat on the Comfort of Child's Ride in a Car[J].Maintenance and Reliability,2010,48(4):102-110.

[112]FLOR D,PENA D,PENA L,et al.Characterization of Noise Level Inside a Vehicle Under Different Conditions[J].Sensors,2020,20(9):1-19.

[113]DA SILVEIRA BRIZON C J,MEDEIROS E B.Combining Subjective and Objective Assessments to Improve Acoustic Comfort Evaluation of Motor Cars[J].Applied Acoustics,2012,73(9):913-920.

[114]JUNOH A K,NOPIAH Z M,MUHAMAD W Z W,et al.An Optimization Model of Noise and Vibration in Passenger Car Cabin[J].Advanced Materials Research,2012,383:6704-6709.

[115]DANCA P,VARTIRES A,DOGEANU A.An Overview of Current Methods for Thermal Comfort Assessment in Vehicle Cabin[J].Energy Procedia,2016,85:162-169.

[116]RUSSI L,GUIDORZI P,PULVIRENTI B,et al.Air Quality and Comfort Characterisation Within an Electric Vehicle Cabin in Heating and Cooling Operations[J].Sensors,2022,22(2):1-16.

[117]KIM T,SHUNAYEVA A,LEE G,et al.Sketching In-Vehicle Ambient Lighting in Virtual Reality with the Wizard-of-Oz Method[J].Digital Creativity,2022,33(1):49-63.

[118]ANANT S,VENI S.Safe Driving Using Vision-Based Hand Gesture Recognition System in Non-Uniform Illumination Conditions[J].Journal of ICT Research and Applications,2018,12(2):154-167.

[119]OH G T,LEE S Y,KO J J.Design and Implementation of Gesture Recognition and Safe Driving Assistance System Using Wearable Band Based on In-Vehicle HUD System[J].The Journal of Korean Institute of Communications and Information Sciences,2018,43:2192-2199.

[120]CHEN Fei,SHI Hongbo,YANG Jianjun,et al.Intelligent Car Cockpit Comfort Evaluation Model Based on SVM[J].IEEE Access,2024,12:27566-27577.

[121]YANG Jianjun,XING Shanshan,CHEN Yimeng,et al.An Evaluation Model for the Comfort of Vehicle Intelligent Cockpits Based on Passenger Experience[J].Sustainability,2022,14(11):1-19.

[122]MA Jun,WANG Meng,PANG Jinhui,et al.Development and Evaluation Study of Intelligent Cockpit in the Age of Large Models[Z].arXiv Preprint:2409.15795,2024.

[123]ZENG Aohan,XU Bin,WANG Bowen,et al.ChatGLM:A Family of Large Language Models from GLM-130B to GLM-4 All Tools[Z].arXiv Preprint:2406.12793,2024.

[124]ZHANG Dan,FENG Tao,XUE Lihong,et al.Parameter-Efficient Fine-Tuning for Foundation Models[Z].arXiv Preprint:2501.13787,2025.

[125]XIE Shaoyuan,KONG Lingdong,DONG Yuhao,et al.Are VLMs Ready for Autonomous Driving?An Empirical Study from the Reliability,Data,and Metric Perspectives[Z].arXiv Preprint:2501.04003,2025.

[126]QIAN Tianwen,CHEN Jingjing,ZHUO Linhai,et al.Nuscenes-QA:A Multi-Modal Visual Question Answering Benchmark for Autonomous Driving Scenario[C]//Proceedings of the 38th AAAI Conference on Artificial Intelligence,Feb.20-27,2024,Vancouver,Canada.2024:4542-4550.

[127]HURST A,LERER A,GOUCHER A P,et al.GPT-4o System Card[Z].arXiv Preprint:2410.21276,2024.

[128]ZHANG Dan,ZHOUBIAN Sining,CAI Min,et al.DataSciBench:An LLM Agent Benchmark for Data Science[Z].arXiv Preprint:2502.13897,2025.

[129]LIN L,CHAI S,WU J,et al.IntelliCockpitBench:A Comprehensive Benchmark to Evaluate VLMs for Intelligent Cockpit[C]//Findings of the Association for Computational Linguistics:ACL 2025.2025:15453-15475.

[130]ZHU Zhongpan,ZHAO Shuaijie,WANG Cheng,et al.A Review of Cockpit-Driving Integration for Human-Centric Autonomous Driving[Z].TechRxiv,24428014,2023.

[131]JAIN A,KOPPULA H S,RAGHAVAN B,et al.Car That Knows Before You Do: Anticipating Maneuvers via Learning Temporal Driving Models[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision,Dec.11-18,2015,Santiago,Chile.Piscataway NJ:IEEE,c2015:3182-3190.

[132]ZHOU Dong,LIU Hongyi,MA Huimin,et al.Driving Behavior Prediction Considering Cognitive Prior and Driving Context[J].IEEE Transactions on Intelligent Transportation Systems,2021,22(5):2669-2678.

[133]REKABDAR B,MOUSAS C.Dilated Convolutional Neural Network for Predicting Driver's Activity[C]//2018 21st International Conference on Intelligent Transportation Systems (ITSC),Nov.4-7,2018,Maui,HI,USA.Piscataway NJ:IEEE,c2018:3245-3250.

[134]XING Yang,LV Chen,WANG Huaji,et al.An Ensemble Deep Learning Approach for Driver Lane Change Intention Inference[J].Transportation Research Part C:Emerging Technologies,2020,115:102615.1-102615.19.

[135]GUO Zizheng,PAN Yufan,ZHAO Guozhen,et al.Detection of Driver Vigilance Level Using EEG Signals and Driving Contexts[J].IEEE Transactions on Reliability,2018,67(1):370-380.

[136]WANG Wenshuo,NA Xiaoxiang,CAO Dongpu,et al.Decision-Making in Driver-Automation Shared Control:A Review and Perspectives[J].IEEE/CAA Journal of Automatica Sinica,2020,7(5):1289-1307.

[137]WÖRLE J,METZ B,OTHERSEN I,et al.Sleep in Highly Automated Driving:Takeover Performance After Waking up[J].Accident Analysis & Prevention,2020,144:105617.1-105617.9.

[138]NAUJOKS F,HÖFLING S,PURUCKER C,et al.From Partial and High Automation to Manual Driving:Relationship Between Non-Driving Related Tasks,Drowsiness and Take-over Performance[J].Accident Analysis & Prevention,2018,121:28-42.

[139]LIANG Nade,YANG Jing,YU D,et al.Using Eye-Tracking to Investigate the Effects of Pre-Takeover Visual Engagement on Situation Awareness During Automated Driving[J].Accident Analysis & Prevention,2021,157:106143.1-106143.12.

[140]ZHOU Feng,YANG X J,DE WINTER J C F.Using Eye-Tracking Data to Predict Situation Awareness in Real Time During Takeover Transitions in Conditionally Automated Driving[J].IEEE Transactions on Intelligent Transportation Systems,2022,23(3):2284-2295.

[141]HAYASHI H,OKA N,KAMEZAKI M,et al.Development of a Situational Awareness Estimation Model Considering Traffic Environment for Unscheduled Takeover Situations[J].International Journal of Intelligent Transportation Systems Research,2021,19(1):167-181.

[142]QIU Yuning,BUSSO C,MISU T,et al.Incorporating Gaze Behavior Using Joint Embedding with Scene Context for Driver Takeover Detection[C]//ICASSP 2022-2022 IEEE International Conference on Acoustics,Speech and Signal Processing(ICASSP),May 23-27,2022,Singapore.Piscataway NJ:IEEE,c2022:4633-4637.

[143]INGRE M,ÅKERSTEDT T,PETERS B,et al.Subjective Sleepiness,Simulated Driving Performance and Blink Duration:Examining Individual Differences[J].Journal of Sleep Research,2006,15(1):47-53.

[144]LIN Na,ZONG Changfu,TOMIZUKA M,et al.An Overview on Study of Identification of Driver Behavior Characteristics for Automotive Control[J].Mathematical Problems in Engineering,2014,2014(1):569109.1-569109.15.

[145]CHOI M,SEO M,LEE J S,et al.Fuzzy Support Vector Machine-Based Personalizing Method to Address the Inter-Subject Variance Problem of Physiological Signals in a Driver Monitoring System[J].Artificial Intelligence in Medicine,2020,105:101843.1-101843.11.

[146]CHENG Ming,YAN Yunbing.Perception-Free Calibration of Eye Opening and Closing Threshold for Driver Fatigue Monitoring[J].IEEE Access,2022,10:125469-125476.

[147]MOHAMMADNAZAR A,ARVIN R,KHATTAK A J.Classifying Travelers'Driving Style Using Basic Safety Messages Generated by Connected Vehicles:Application of Unsupervised Machine Learning[J].Transportation Research Part C:Emerging Technologies,2021,122:102917.1-102917.18.

[148]CAI Yingfeng,ZHAO Ruidong,WANG Hai,et al.CNNLSTM Driving Style Classification Model Based on Driver Operation Time Series Data[J].IEEE Access,2023,11:16203-16212.

[149]POHL J,BIRK W,WESTERVALL L.A Driver-Distraction-Based Lane Keeping Assistance System[J].Proceedings of the Institution of Mechanical Engineers,Part I:Journal of Systems and Control Engineering,2007,221(4):541-552.

[150]REZAEI M,KLETTE R.Simultaneous Analysis of Driver Behaviour and Road Condition for Driver Distraction Detection[J].International Journal of Image and Data Fusion,2011,2(3):217-236.

[151]ZAMORA V,SIPELE O,LEDEZMA A,et al.Intelligent Agents for Supporting Driving Tasks:An Ontology-Based Alarms System[C]//Proceedings of the 3rd International Conference on Vehicle Technology and Intelligent Transport Systems(VEHITS 2017),April 22-24,2017,Porto,Portugal.Setúbal:Science and Technology Publications,Lda,2017:165-172.

[152]ARMAND A,FILLIAT D,IBAÑEZ-GUZMAN J.A Bayesian Framework for Preventive Assistance at Road Intersections [C]//2016 IEEE Intelligent Vehicles Symposium (IV),June 19-22,2016,Gothenburg,Sweden.Piscataway NJ:IEEE,c2016,1128-1134.

[153]PETERSSON L,FLETCHER L,ZELINSKY A,et al.Towards Safer Roads by Integration of Road Scene Monitoring and Vehicle Control[J].The International Journal of Robotics Research,2006,25(1):53-72.

[154]DING Zhezhang,XU Donghao,TU Chenfeng,et al.Driver Identification Through Heterogeneity Modeling in Car-Following Sequences[J].IEEE Transactions on Intelligent Transportation Systems,2022,23(10):17143-17156.

[155]QIN Pinpin,LI Hao,LI Ziming,et al.A CNN-LSTM Car Following Model Considering Generalization Ability[J].Sensors,2023,23(2):1-15.

[156]LIAO Yaping,YU Guizhen,CHEN Peng,et al.Modelling Personalised Car-Following Behaviour:A Memory-Based Deep Reinforcement Learning Approach[J].Transportmetrica A:Transport Science,2024,20(1):2035846.1-2035846.29.

[157]ZHANG Yifan,XU Qian,WANG Jianping,et al.A Learning Based Discretionary Lane-Change Decision-Making Model with Driving Style Awareness[J].IEEE Transactions on Intelligent Transportation Systems,2023,24(1):68-78.

[158]ZHU Bing,HAN Jiayi,ZHAO Jian,et al.Combined Hierarchical Learning Framework for Personalized Automatic Lane-Changing[J].IEEE Transactions on Intelligent Transportation Systems,2020,22(10):6275-6285.

[159]IRANMANESH SM, MAHJOUB HN, KAZEMI H,et al.An Adaptive Forward Collision Warning Framework Design Based on Driver Distraction[J].IEEE Transactions on Intelligent Transportation Systems,2018,19(12):3925-3934.

[160]ZHU Bing,ZHANG Yihan,ZHAO Jian,et al.Personalized Control Strategy of Electronic Brake Booster with Driving Behaviors Identification[J].IEEE Transactions on Vehicular Technology,2021,70(12):12593-12603.

[161]LI Bei,ROCHE R.Optimal Scheduling of Multiple Multi-Energysupply Microgrids Considering Future Prediction Impacts Based on Model Predictive Control[J].Energy,2020,197,117180.1-117180.11.

[162]LI Wenjun,TAN Lidong,LIN Ciyun.Modeling Driver Behavior in the Dilemma Zone Based on Stochastic Model Predictive Control[J].PLOS One,2021,16(2):1-21.

[163]MIYAJIMA C,TAKEDA K.Driver-Behavior Modeling Using On-Road Driving Data:A New Application for Behavior Signal Processing[J].IEEE Signal Processing Magazine,2016,33(6):14-21.

[164]HUBMANN C,SCHULZ J,BECKER M,et al.Automated Driving in Uncertain Environments:Planning with Interaction and Uncertain Maneuver Prediction[J].IEEE Transactions on Intelligent Vehicles,2018,3(1):5-17.

加入《阿宝说车》知识星球,可获得这些模块的相关学习资料(目前有研究报告,线上大咖分享、线下闭门会),包括16大板块,详细清单如下: