来源:云计算开源产业联盟

这份《2025大模型推理优化与部署实践产业洞察研究报告》系统性地分析了大模型推理优化与部署的关键趋势、技术路径、市场格局及行业实践。以下是对报告核心内容的梳理与总结:

一、核心趋势洞察

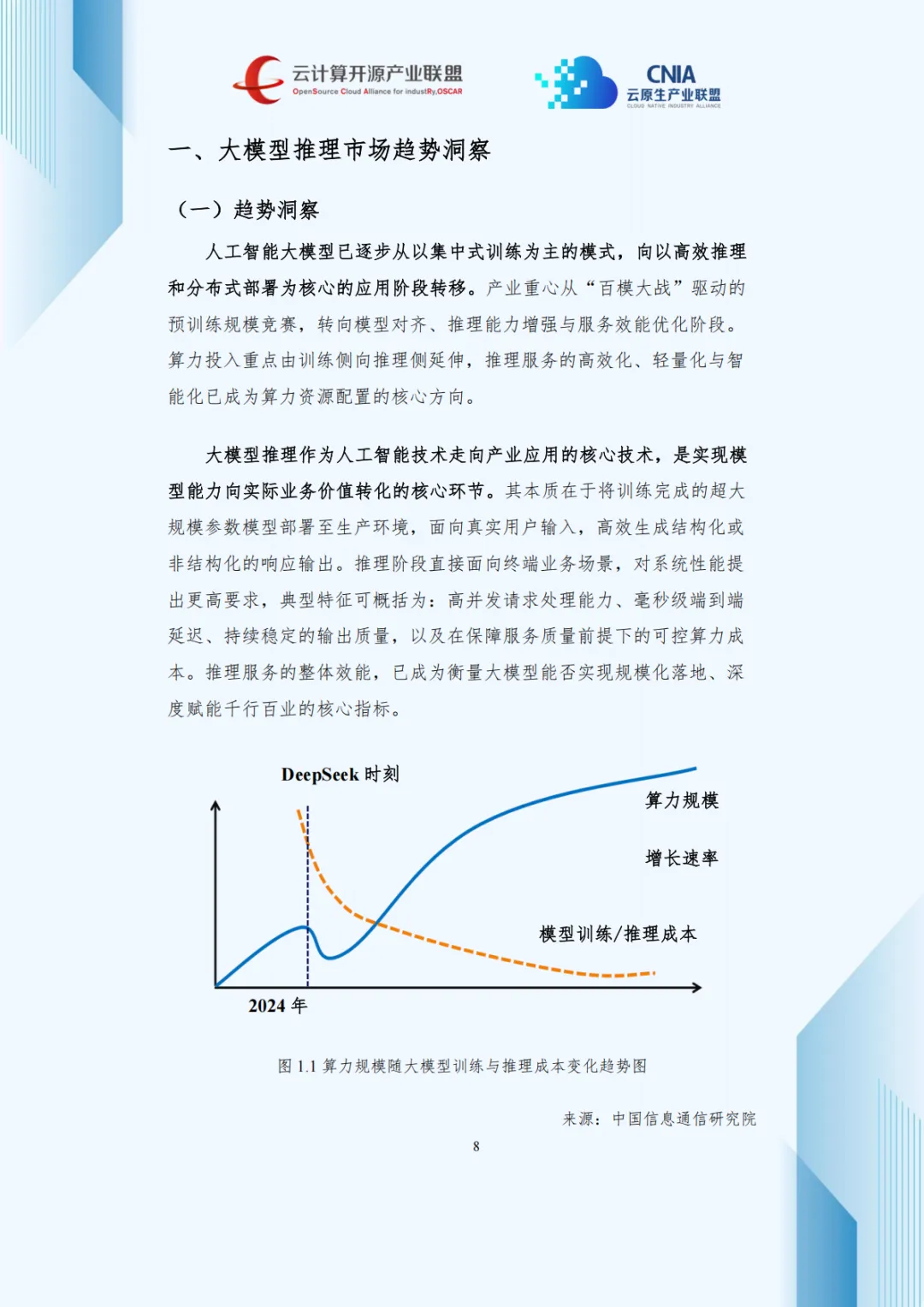

产业重心转移:从“百模大战”转向推理能力增强与服务效能优化,算力投入由训练侧向推理侧延伸。

成本与算力双驱动:开源大模型(如DeepSeek)推动推理成本下降,同时带动算力需求上升,形成“成本下行、算力上行”态势。

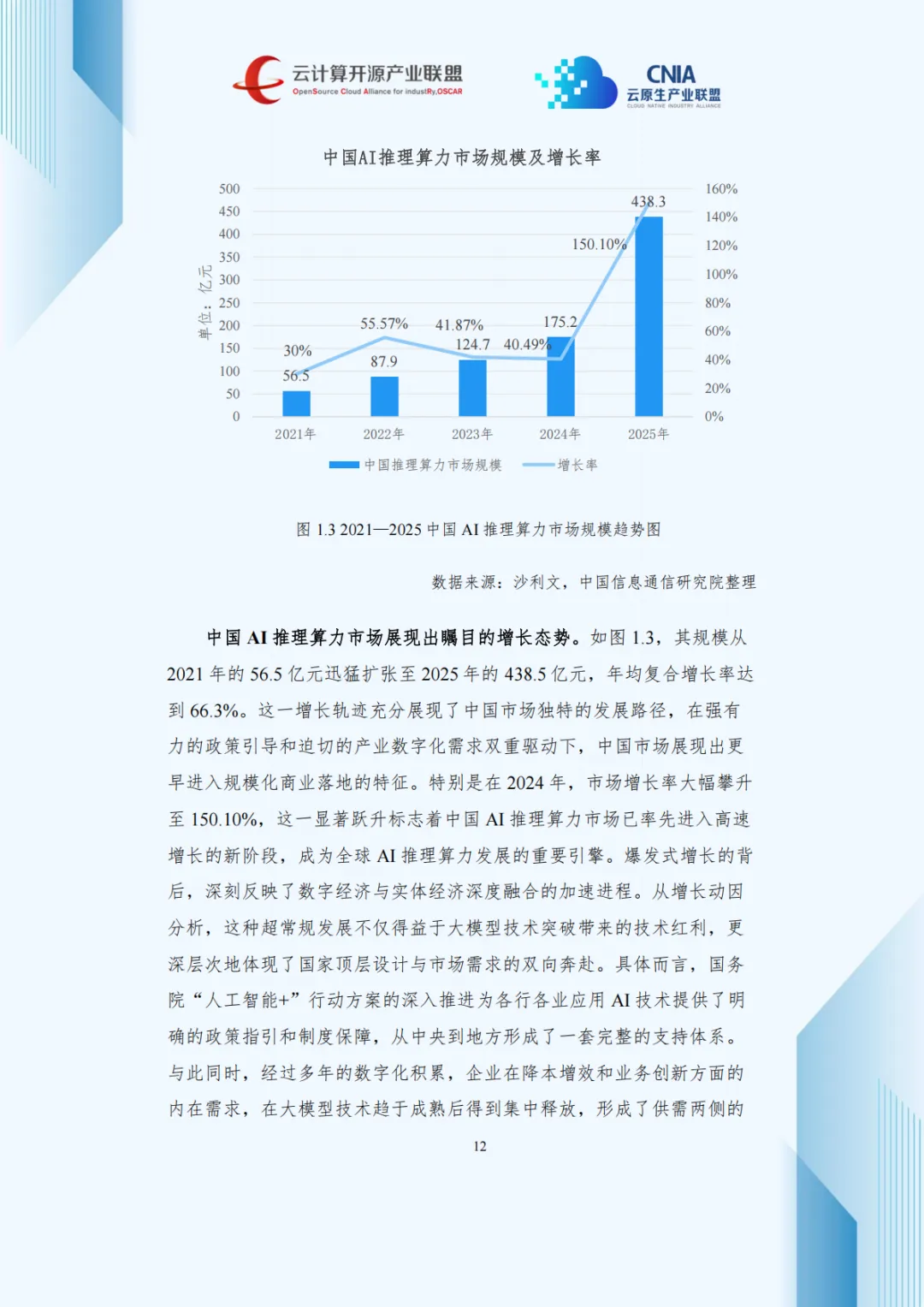

市场快速增长:2021—2025年,中国AI推理算力市场规模从56.5亿元增至438.5亿元,年均复合增长率达66.3%。

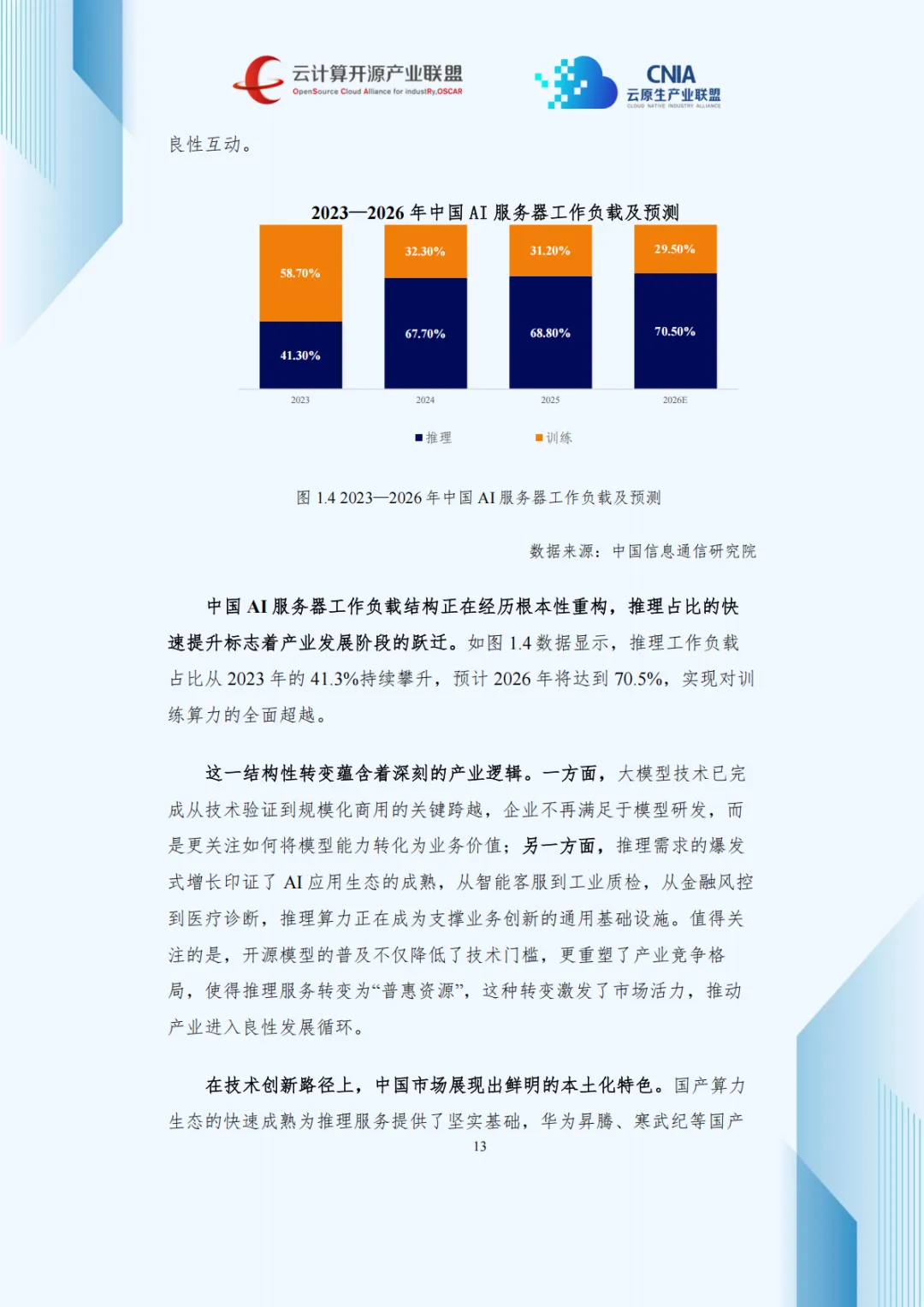

工作负载重构:推理负载占比预计2026年达70.5%,超越训练负载。

二、主流部署方式

| 模型即服务(MaaS) | ||

| 大模型推理一体机 | ||

| 私有化部署平台 | ||

| 云—边—端协同推理 |

三、推理优化技术体系

1. 硬件适配

GPU:通用性强,生态成熟

NPU:能效比高,专为神经网络优化

ASIC:定制化强,能效比极致(如Transformer专用芯片)

2. 推理引擎优化

PagedAttention:解决KV缓存内存碎片

连续批处理:提升GPU利用率至60%—80%

智能缓存与预取:优化内存访问与通信开销

3. 模型层优化

量化技术:INT4/INT8量化,显存降低60%—70%

知识蒸馏:小模型达到大模型90%性能

混合专家模型(MoE):稀疏激活,降低单token计算量

4. 并行计算

张量并行、流水线并行、数据并行、混合并行

P/D分离架构:Prefill与Decode阶段解耦,提升吞吐与响应速度

四、性能测试与评估

核心指标:QPS、TPM、TTFT、TPOT、E2E延迟、请求成功率等

测试方法:基于真实业务负载,采用渐进式压测与动态调度

实验结果:P/D分离架构可提升吞吐30%—50%,TTFT降低40%—60%

五、行业实践案例

六、发展趋势与建议

1. 技术趋势

系统级协同优化(软硬件结合)

云边端协同推理成为主流

自适应优化与动态调度

MoE与轻量化技术持续演进

2. 产业挑战

成本压力仍然显著

标准化缺失导致选型困难

复合型人才短缺

生态碎片化与安全合规要求高

3. 发展建议

建立统一性能测试标准

推动产学研用协同创新

加强复合型人才培养

优化政策环境与商业模式

七、报告价值

技术参考:为推理优化与部署提供全栈技术路径

商业决策:为企业选型、成本控制、部署策略提供依据

行业指南:推动标准化、规模化、安全合规的大模型应用

(本星球常年对接30万+报告智库,每日精选30+行业报告学习分享!)

免责声明:本社群只做内容收集和知识分享,严禁用于商业目的,报告版权归原撰写发布机构所有,相关报告通过公开合法渠道收集整理,如涉及侵权,请联系我们删除;如对报告内容存疑,请与撰写、发布机构联系。