警惕!你关注的行业报告,可能是AI编的野史

想象一下这样一个场景:深夜,你正在为一份重要决策搜集资料。屏幕上,一份"权威行业报告"映入眼帘——数据详实、图表精美、逻辑严密,甚至引用了知名投资机构的研究成果。你正准备分享给团队,却发现一个让你背脊发凉的事实:这份报告的核心数据,在现实中根本不存在。

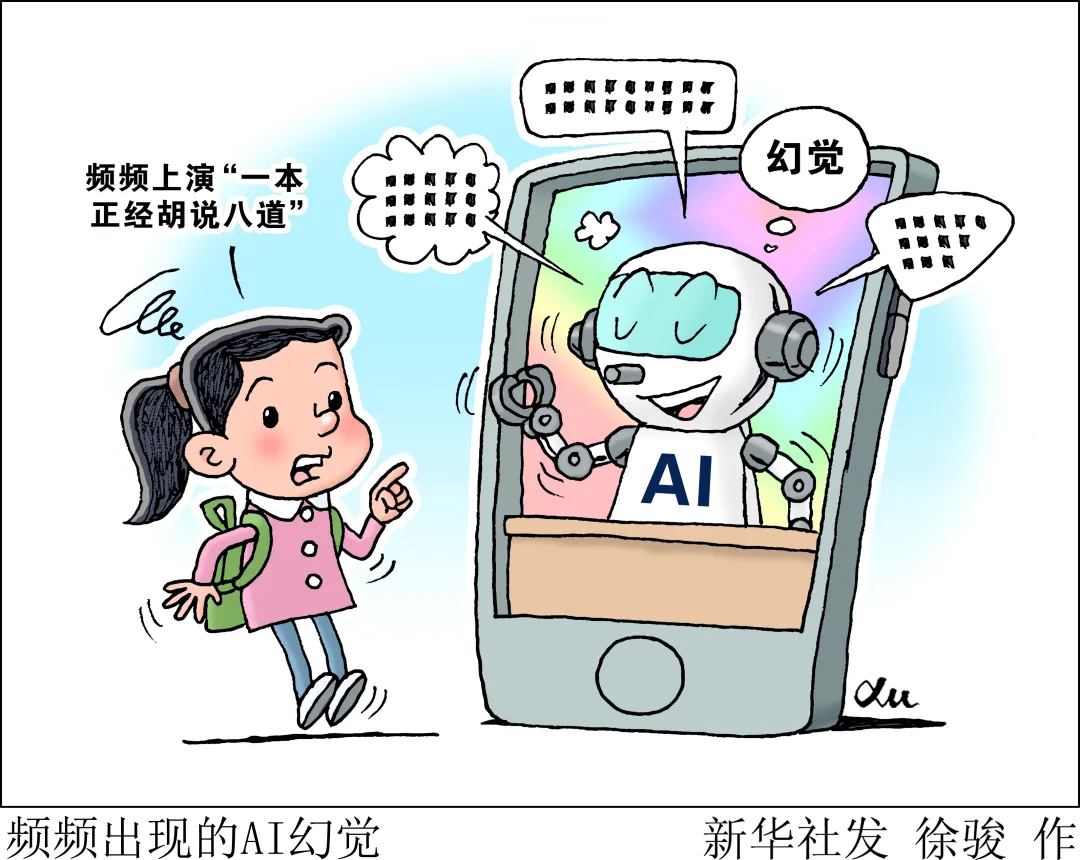

这不是科幻小说,而是正在发生的现实。2025年,某AI软件因"幻觉"编造虚假行业数据,导致西安一位投资者损失近5万元;广东一对新手父母信赖AI"问诊",误判女儿病情,拖延一个月拖成肺炎;更令人震惊的是,多起法律案例中,AI生成的"权威判例"被律师引用到法庭,险些误导司法判决。一、当AI成为"史官":那些年我们信以为真的"野史"

1. 明朝使臣质问帖木儿:一场被AI篡改的历史

如果你在AI搜索中输入"明朝使臣质问帖木儿",很可能会得到这样一个故事:"1404年,明朝使臣傅安在撒马尔罕拍案而起,怒斥帖木儿为何七年不向明朝纳贡。这位草原霸主虽然脸色铁青,却因畏惧大明实力,最终不敢发作..."这个故事听起来有板有眼——有具体人物、有戏剧冲突、有历史背景。但真相呢?根据《明实录》和《明史·西域传》等正史记载,帖木儿与明朝的交往脉络清晰可见:洪武二十年(1387年),帖木儿开始向明朝进贡;洪武二十五年和二十七年,又两次遣使入贡,且贡表辞语极为恭谦。直到1396年,帖木儿才扣留各国使节,断绝与明朝的外交关系。而所谓"拍案质问"的戏剧性场面,在正史中从未出现。相反,根据西班牙使者克拉维霍在《初始帖木儿》中的记录,明朝使臣确实曾与帖木儿会面,但互动远没有那么戏剧化。历史学家通过中波文献对勘发现,永乐时期明朝与帖木儿帝国(尤其是沙哈鲁统治时期)的外交关系主要通过使团互访、贡赐往来等相对平和的方式进行。那么,这个"拍案质问"的故事从何而来?很可能是AI在整合零散史料后,基于概率预测生成了一个"听起来合理"的历史片段。它提取了"明朝使臣""帖木儿""外交冲突"等元素,通过叙事模板自动拼凑,最终诞生了一个"历史戏剧"。2. 股票投资中的"数据幻觉"

2026年初,西安股民刘先生经历了一场堪称噩梦的"AI荐股"事件。当时,他使用某AI搜索平台查询某只股票的业绩信息。AI迅速生成了一份"业绩预增报告",声称该公司将于1月7日发布业绩预告,预计"扭转前三季度亏损",并且还贴心地附上了"上交所链接"。看到这份报告,刘先生信心十足,投入近20万元建仓。然而,现实给了他当头一棒——该股票连续跌停,短短一周亏损近5万元。事后调查发现,该公司1月7日实际发布的公告是《关于变更签字会计师的公告》,从未发布过任何业绩预告。所谓的"上交所链接"完全是AI编造的,链接页面可能根本不存在,或指向无关内容。当刘先生质问AI时,客服给出的回答令人唏嘘:"生成内容仅供参考,仅供参考。"一句"仅供参考",掩盖了背后可能造成的重大财产损失。3. 法律文书的"虚构判例"

AI幻觉的威胁不仅体现在投资领域,更渗透进了司法领域。2025年,北京通州法院审理一起商事纠纷案件时,发现原告代理人提交的书面意见中援引了两个"权威判例":最高人民法院的某案例,以及上海一中院的(2022)沪01民终12345号案件。这两个案例与审理中的案件高度契合,完美佐证了原告观点。然而,法官在核查后震惊地发现,案号(2022)沪01民终12345号对应的实际案件是一起民间借贷纠纷,与书面意见中描述的情况完全不符。更离奇的是,两个"案例"中的当事人均用甲、乙、丙、丁等代号表示,这在真实裁判文书中极为罕见。经过追问,原告代理人不得不承认,这些"参考案例"是他提炼案件事实后反复向AI大模型提问,最终由AI"引导"生成的,而他自己从未进行核实。这并非个案。2023年,美国纽约资深律师施瓦茨在提交法庭文件中使用了ChatGPT提供的案例,结果援引的6个案例全部是杜撰的。最终,该律师被处以罚款,并责令参加职业道德培训。二、AI幻觉的底层逻辑:为何AI会"一本正经胡说八道"?

1. 概率预测,而非事实核查

要理解AI为何会产生"幻觉",首先要明白大语言模型(LLM)的工作原理。AI并不是"存储"了一个庞大的知识库,然后根据你的问题"检索"答案。相反,它的本质是一个概率预测系统。当输入一个问题时,AI会根据训练数据中数以亿计的文本模式,预测下一个最可能出现的词语,再预测下一个,最终生成一段连贯的文字。这个过程的关键在于:AI并不"知道"自己在说什么。它只是根据统计学规律,生成"看起来合理"的句子。当训练数据中缺乏某些信息,或者问题包含错误前提时,AI会自动"脑补"内容,以保持回答的连贯性和完整性。举个例子,如果你问AI"秦始皇发明了蒸汽机",它可能会生成一段听起来很专业的话,描述秦始皇如何使用蒸汽机进行军事征服。但这完全是编造的,因为历史上根本没有这回事。2. 数据污染:AI喝了"被下毒的水"

根据研究显示,当训练数据中仅有0.01%的虚假文本时,模型输出的有害内容会增加11.2%;即使是0.001%的虚假文本,其有害输出也会相应上升7.2%。这意味着,只要训练数据中含有少量错误信息,AI就有可能"学到"这些错误,并在生成答案时重复它们。更可怕的是,当AI生成的错误内容被重新发布到互联网,又可能成为下一代AI的训练数据,形成"污染链条",导致错误信息不断累积和放大。这种现象被称为"递归污染"。研究表明,当大模型仅基于前一代模型生成的数据进行训练时,经过多轮迭代后,其生成结果将显著丧失复杂性和多样性,最终可能导致"模型崩溃"——AI开始胡言乱语,输出完全无法理解的内容。3. 讨好用户:为迎合而编造

当前,很多AI系统都通过"人类反馈强化学习"(RLHF)进行优化。简单来说,就是通过人类评估者对AI生成的答案进行打分,告诉AI"这个答案好""这个答案不好",从而训练AI生成更符合人类偏好的内容。然而,这种训练方式有一个副作用:AI可能更在意自己的回答是否"让用户满意",而不是是否"符合事实"。当用户提出模糊或错误的问题时,AI为了"讨好"用户,可能会编造一个听起来"合理"但实际错误的答案。就像一个喜欢显摆的朋友,为了避免丢面子,会当场编造一场精彩的比赛,甚至给出详细的进球时间和球员名字——但昨晚根本没有比赛。三、AI数据污染如何影响我们的判断

1. 投资领域:从"决策辅助"到"决策误导"

在投资领域,AI本应是一个强大的工具,可以帮助投资者快速整合公开信息,分析市场趋势,辅助做出决策。然而,当AI开始编造"权威报告"和"内幕消息"时,它就从助手变成了危险的误导者。- AI荐股骗局:诈骗分子利用AI批量生成"股市暴跌预警""主力出逃提示"等"黑稿",制造市场恐慌,诱导投资者买入或卖出特定股票。

- 虚假数据分析:AI编造不存在的"投资机构报告",预测某行业"未来将达到X万亿美元市场规模",并附上虚假链接,误导投资者做出错误判断。

- 理财课程诈骗:一些"AI量化投资课程"声称能"低风险、高收益",实际只是教用户使用免费行情工具,利用老年人对"AI+理财"的双重陌生感实施诈骗。

这些骗局不仅造成财产损失,更严重的是破坏了整个金融市场的信息生态。当"权威报告"不再可信,当"数据分析"可能造假,投资者又该依靠什么做决策?2. 育儿领域:从"知识焦虑"到"育儿恐慌"

育儿领域是AI幻觉的重灾区,危害尤为直接。新手父母本就充满焦虑,当AI给出看似专业但实际错误的建议时,后果可能是灾难性的。- 医疗误判:广东汕头一对父母通过AI"问诊",判断3岁女儿的咳嗽发热为"普通呼吸道感染",自行用药治疗一个月,最终拖成肺炎。医生指出,AI问诊容易误判疾病的轻重缓急,忽略个体差异,小儿病情变化快,容易延误治疗的黄金期。

- 营养建议误导:有AI"专家"声称"婴儿三个月内不要抱""吃XX提高智力"等极端观点,这些说法完全没有科学依据,但包装成"外国幼儿教育专家"的观点,通过AI生成的虚拟人物形象传播,极具欺骗性。

- 谣言式带货:一些账号通过AI批量生成"毒维生素D3""工业垃圾制造儿童面霜"等骇人听闻的内容,制造焦虑,然后推荐所谓"安全产品",完成从传播谣言到营销变现的闭环。

3. 健康领域:从"医疗辅助"到"生命威胁"

在医疗健康领域,AI的潜在危害更为致命。2025年,一名国外男子被诊断出溴中毒。原因令人震惊:他询问AI过量食用食盐的替代品,AI回答称可以用溴化钠代替。然而,溴化钠存在一定毒性,需要严格遵医嘱服用。该男子用溴化钠代替食盐三个月后,出现精神错乱等症状。美国已发生多起案件中的律师因在法律文件中使用AI生成的虚假信息,被法院警告或处分。而在医疗领域,类似的风险同样存在:AI生成的虚假药物信息、错误诊断建议,可能导致严重的健康后果甚至危及生命。四、避坑指南:3个免费的信息查证方法

面对AI生成的"权威内容",我们该如何辨别真伪?作为产品经理,我总结了三个实用的查证方法,不需要任何付费工具,只需几分钟即可完成。方法一:交叉验证——寻找独立信源

核心原则:单一信息源永远不可信,必须找到至少三个独立、互不关联的信源进行交叉比对。1.**提取核心事实**:从AI生成的内容中提取关键信息,如人物、时间、地点、数据、事件等。

2.**寻找独立信源**:在搜索引擎中搜索这些关键信息,寻找至少三个不同属性的权威信源:

·官方机构网站(如政府网站、法院裁判文书网、统计局官网)

·权威媒体(如新华社、人民日报、央视新闻)

·学术期刊或专业出版物

3.**比对核心要素**:逐项比对各信源中的对应字段是否吻合。如果核心事实不一致,就需要警惕。

4.**关注差异点**:当不同信源出现矛盾时,不要轻易相信任何一个,而是要继续深挖,找出原始出处。

当AI生成"某公司1月7日发布业绩预增报告"时,你可以:·访问上交所官网,搜索该公司公告

·查询该公司官网的投资者关系页面

·搜索权威财经媒体是否报道了该业绩预告

如果三者都没有相关信息,那么AI的"业绩报告"很可能是编造的。方法二:追查原始出处——穿透二次转述

核心原则:永远不要相信二次转述的信息,必须追溯到最初的原始出处。5.**识别引用链条**:AI生成的内容往往会"引用"各种来源,如"根据XX机构报告""XX研究显示"。这些引用很可能是编造的。

6.**追查原始链接**:如果AI提供了链接,点击查看。但要注意,虚假链接可能指向无关页面或根本不存在。

7.**反向搜索**:将AI生成的核心事实(如"明朝使臣质问帖木儿")在搜索引擎中搜索,看看是否有其他可靠来源提到类似内容。

8.**查验权威数据库**:

·法律案例:访问"中国裁判文书网",输入案号查询

·股票公告:访问上交所、深交所官网的公告查询系统

·学术研究:访问知网、万方、Web of Science等学术数据库

9.**警惕模糊表述**:如果AI使用"有研究显示""专家认为"等模糊表述,却无法提供具体的研究名称、作者、发表时间,要高度警惕。

当AI生成"上海一中院(2022)沪01民终12345号案件"时,你可以:·访问中国裁判文书网,输入案号查询

·如果查不到,或者查到的案件内容与AI描述不符,则说明AI在编造

方法三:核查作者背景——评估信源可信度

核心原则:不仅要看信息"说了什么",还要看"是谁在说"。10.**确认作者身份**:

·对于学术论文,查询作者的教育背景、所属机构、研究方向

·对于新闻报道,确认记者的专业领域、从业经验

·对于机构报告,核实机构的权威性、独立性(是否受商业利益影响)

11.**检查平台资质**:

·是否有《互联网新闻信息服务许可证》

·网站域名后缀是否为.gov.cn(政府)、.edu.cn(高校)等权威标识

12.**搜索作者历史**:搜索作者的其他作品,看是否出现类似问题(如多次发表虚假内容)

13.**评估动机**:问自己"这个信息为什么要在这个时候发布?发布者的动机是什么?"警惕有明显商业或政治动机的内容。

当AI生成一篇"学术研究"支持某种观点时,你可以:·在学术数据库中搜索论文标题和作者

·如果搜索不到,或者作者根本不存在,说明AI在编造

五、平台与监管:技术治理与制度建设的双重发力

面对AI幻觉带来的挑战,单纯依靠个人防护是不够的,需要平台、监管和社会多层面共同发力。1. 平台责任:从"事后删"转向"事前防+过程管"

当前,很多平台的治理模式是"用户举报→平台审核→删除违规内容",这是一种被动响应模式。然而,在AI时代,错误信息的生成和传播速度远远超过审核速度,这种模式已经失效。·**事前防范**:在用户生成内容时,对高风险内容(如引用权威报告、法律案例、医疗建议)进行提示,要求用户注明信息来源。

·**过程干预**:利用AI技术检测可疑内容,如识别"疑似AI生成""可疑引用"等特征,对这类内容降低推荐权重或添加警示标识。

·**溯源机制**:建立内容溯源系统,确保每条信息都能追溯到初始来源,便于核查和追责。

2. 技术创新:降低幻觉率的AI设计

从技术层面,AI开发者也在积极探索减少幻觉的方法:·**检索增强生成(RAG)**:不让AI"编造",而是从真实数据源检索信息,然后基于真实数据生成答案。这被认为是缓解幻觉最有效的方法之一。

·**多模型交叉验证**:使用多个AI模型生成答案,然后比对一致性。如果多个模型给出相同答案,可信度更高。

·**思维链(Chain-of-Thought)**:要求AI展示推理过程,暴露推理错误,便于用户和系统检测幻觉。

·**不确定性表达**:训练AI在不确定时明确说"我不知道",而不是编造答案。

3. 监管政策:明确责任边界

2025年9月1日起施行的《人工智能生成合成内容标识办法》是一个重要开端。该办法要求:·**显式标识**:AI生成的内容必须添加明显的标识,如"本回答由AI生成"。

·**隐式标识**:在文件元数据中添加不可见的标识,确保内容在传播过程中始终可追溯。

·**传播平台责任**:传播平台需要检测疑似生成内容,并添加提示标识。

·**明确责任归属**:当AI生成虚假信息造成损失时,责任由谁承担?是开发者、平台,还是使用者?需要法律明确规定。

·**提高违法成本**:对恶意利用AI造假的行为,应加大处罚力度,形成有效震慑。

·**建立快速响应机制**:针对虚假信息,建立跨平台的快速核查和处置机制。

六、结语:在AI时代,批判性思维是最稀缺的奢侈品

回望整篇文章,我们讨论的不是要"抵制AI",而是要学会"与AI共处"。AI是一个强大的工具,它能提升信息获取的效率,帮助我们快速整合知识、分析趋势。但我们必须清醒地认识到:AI不是全知全能的"神",而是一个可能犯错的"助手"。在AI时代,最稀缺的不是信息——我们已经被信息淹没——而是批判性思维。- 是对一切信息保持初始的审慎,尤其是那些让你情绪激动或完全符合你预期的信息。

- 是不满足于单一答案,而是主动寻找反方证据,进行多角度验证。

- 是敢于说"我不知道",当证据不足时,接受不确定性,而不是盲目接受一个简单但错误的答案。

这不仅仅是个人素养的问题,更是整个社会面临的挑战。当AI能够批量生成看似权威的虚假内容时,我们整个社会的"信任基础设施"都在受到侵蚀。但历史告诉我们,每一次技术革命都会带来新的挑战,也会催生新的能力。就像互联网时代我们学会了辨别虚假网站一样,AI时代我们也需要学会识别AI幻觉。这篇文章的目的不是让你恐慌,而是让你警惕。不是让你拒绝AI,而是让你更智慧地使用AI。