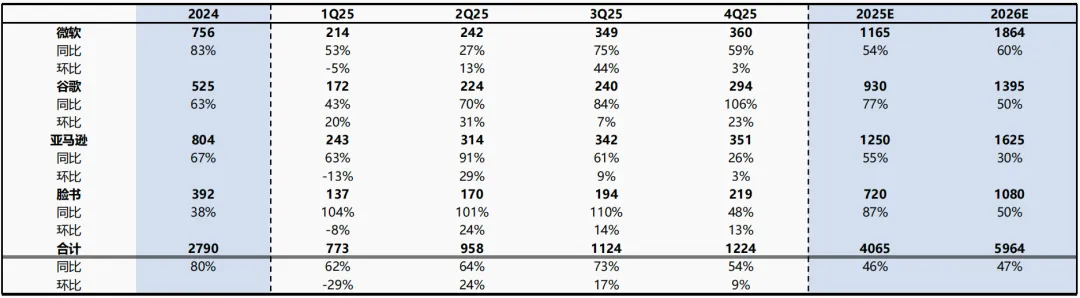

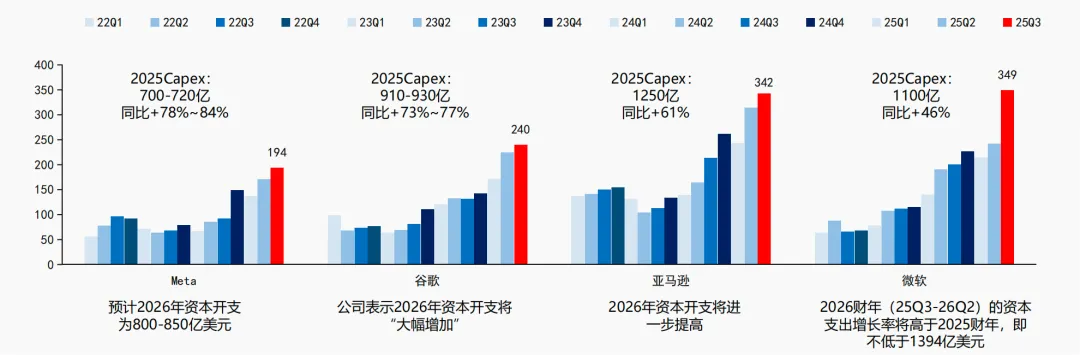

2026年算力景气度持续上行。微软、谷歌、Meta、亚马逊等海外大厂对2026年资本开支指引乐观,我们预计2025年、2026年四家大厂资本开支总和分别为4065、5964亿美元,分别同比+46%、47%,且用于投资AI算力及基础设施的比例有望持续提升。

目前,海外大厂仍以采购英伟达AI芯片为主,2026年AMD、海外大厂自研芯片有望快速放量。

互联侧:光摩尔定律,单卡价值量代际增加

1)光模块

一方面,端口速率按“1–2年一代”从10G/40G-100G/400G-800G/1.6T;另一方面,数据中心网络从“少量跨机柜光互连”走向leaf-spine扁平化、东西向流量主导,叠加AI训练集群由几十卡扩展到数百卡规模,使得光模块的用量、规格与单点价值量同步抬升。

未来,800G将加速规模化部署、1.6T进入导入期;同时LPO/CPO、硅光、AOC等路线让网络向“更低功耗、更高密度、更高可靠”演进。

2)PCB

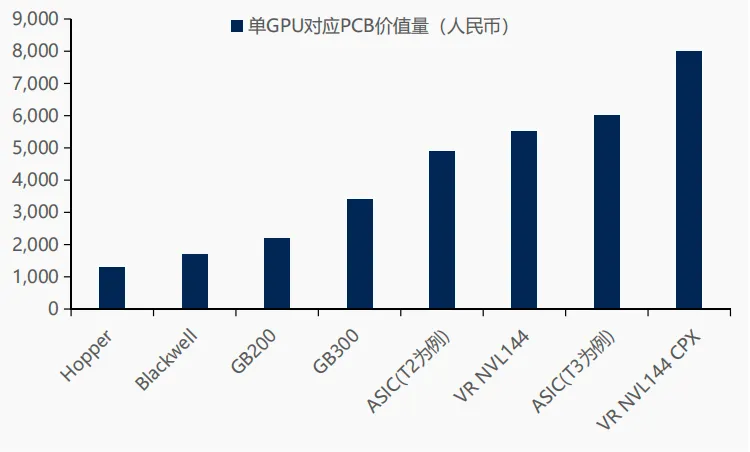

行业进入AI驱动的新周期,需求结构发生根本性转变。AI服务器集群建设带来算力板卡、交换机与光模块的同步升级,推动PCB需求量和单价双升。

随着算力架构从GPU服务器向正交化、无线缆化演进,信号链条更短、对材料损耗更敏感,PCB成为AI硬件中最核心的互联与供电载体之一。本轮AI周期不同于5G周期的“高峰—回落”型特征,而呈现“技术迭代带动持续渗透”的长周期属性。

3)冷却侧:

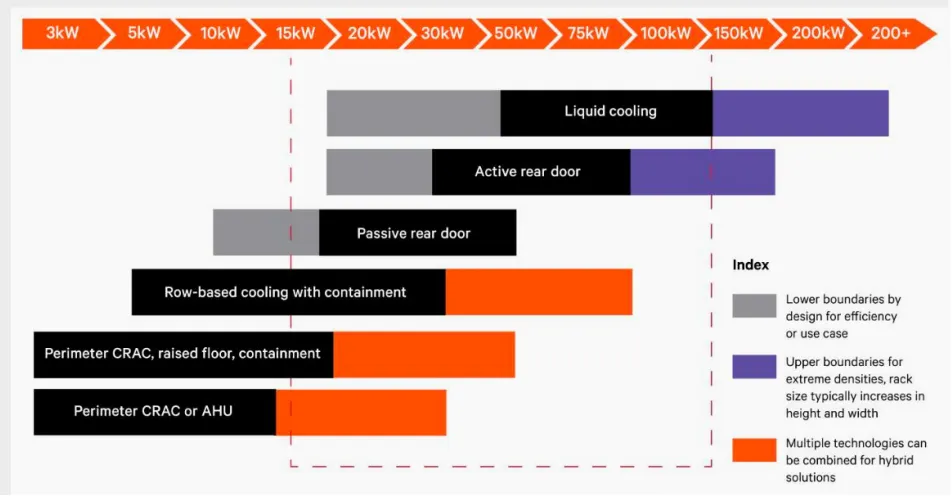

功率密度持续提升,液冷大势所需。根据Vertiv数据显示,AI GPU机架的峰值密度有望从2024年的130kW到2029年突破1MW,采用液冷技术是大势所趋。

海外机柜算力密度提升直接带来二次侧及ICT设备侧价值量的提升,其中,CDU、冷板价值量占比较高。

4)供电侧:

AIDC供配电路径演变,关注HVDC、SST领域。

随着AI服务器功率的持续提升,传统供配电架构下配电房占地面积大幅提升、电能传递损耗大幅增长,迫切需要通过供配电架构升级减少占地面积、提升系统效率、减少用铜量、提升分布式能源接入能力。

我们预计,AIDC供配电方式将遵循UPS-HVDC-SST路径演变,2026年行业催化有望持续。

微软

3Q25公司Capex(包含融资租赁)为349亿美金,同比+75%、环比+44%,且根据电话会议披露信息,预计FY2026(本季度3Q25为微软FY1Q26)资本开支增速高速FY2025。

此处假设4Q25 Capex环比微增,为360亿美金,则2025全年资本开支为1165亿美金,同比+54%,假设2026年Capex增速为60%,则2026年资本开支为1864亿美金。

谷歌

3Q25公司资本开支为240亿美金,同比+84%、环比+7%,且根据电话会议披露信息,2025年Capex指引上调至910-930亿美金(前值为850亿美金),则4Q25 Capex预计为294亿美金;且指引2026年资本开支将显著增长,假设2026年资本开支增速为50%,则2026年资本开支为1395亿美金。

亚马逊

3Q25公司资本开支为342亿美金,同比+61%、环比+9%,且根据电话会议披露信息,2025年Capex指引1250亿美金,则4Q25 Capex预计为351亿美金,且指引2026年资本开支持续增长。

此外,亚马逊在电话会议披露,为满足公司对AI需求,过去12个月中增加了3.8GW电力容量(目前是22年2倍),预计4Q25新增1GW,且2027年电力容量预计翻倍;假设2026年资本开支增速为30%,则2026年资本开支为1625亿美金。

Meta

3Q25公司资本开支为194亿美金,同比+110%、环比+14%,且根据电话会议披露信息,2025年Capex指引上调至700-720亿美金(前值为660-720亿美金),则4Q24 Capex预计为219亿美金,且指引2026年资本开支增长将显著高于2025年,假设2026年资本开支增速为50%,则2026年资本开支为1080亿美金。

图1:海外大厂Capex及预期

01

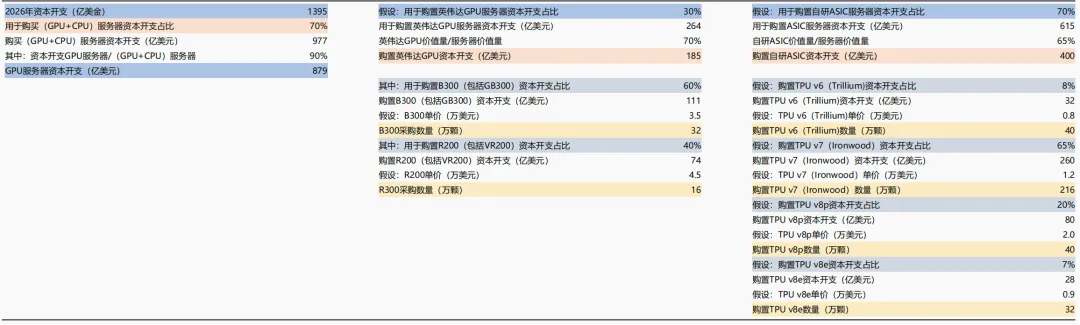

微软-2026年芯片需求测算

微软2026年芯片需求测算:主要购买英伟达芯片,其次为AMD和自研Maia芯片。

GPU服务器资本开支:根据前文测算,2026年资本开支为1864亿美金,根据微软3Q25电话会披露数据,约50%资本开支用于购买GPU、CPU服务器,且预期比例持续提升;我们假设用于购买GPU、CPU服务器的资本开支占比为60%,且GPU服务器在其中占比为90%(由于GPU服务器ASP大幅高于CPU服务器),则2026年用于购买GPU服务器的资本开支为1007亿美金。

采购英伟达芯片:考虑到芯片性能、运行稳定性、兼容性等维度,微软仍以采购英伟达芯片为主,假设2026年采购英伟达GPU服务器资本开支占比为85%,则对应购置英伟达服务器资本开支为856亿美金,假设AI芯片占服务器价值量为70%,对应英伟达GPU芯片价值量为599亿美金,分别假设采购英伟达B300(包括GB300)、R200(包括VR200)资本开支占比为55%、45%,假设B300、R200单价分别为3.5、4.5万美元(考虑到性能提升、HBM及晶圆成本提升等因素),对应B300、R200采购量分别为94、60万颗。

采购AMD芯片:AMD芯片快速迭代发展,MI400系列芯片性能表现出色,预计2026年微软将采购部分AMD芯片作为补充,此处假设采购AMD GPU服务器资本开支占比为10%,且用于购置MI355、MI400资本开支占比分别为5%、95%,且假设MI355、MI400芯片单价分别为2.5、3.5万美金,对应MI355、MI400采购量分别为1、19万颗。

自研ASIC芯片:2026年微软自研芯片Maia200、Maia300有望放量,此处假设自研ASIC服务器资本开支占比为5%,ASIC芯片占服务器价值量为50%,对应自研ASIC资本开支为25亿美金,假设购置Maia200、Maia300资本开支占比分别为25%、75%,假设Maia200、Maia300单价分别为0.5、0.7万美金,对应Maia200、Maia300采购量分别为11.6、27.5万颗。

图2:微软-2026年芯片需求测算

02

谷歌-2026年芯片需求测算

谷歌2026年芯片需求测算:自研TPU为主,同时采购英伟达GPU主要供云客户使用。

GPU服务器资本开支:根据前文测算,2026年资本开支为1395亿美金,根据谷歌3Q25电话会披露数据,约60%资本开支用于购买服务器,且预期比例持续提升;我们假设用于购买GPU、CPU服务器的资本开支占比为70%,且GPU服务器在其中占比为90%(由于GPU服务器ASP大幅高于CPU服务器),则2026年用于购买GPU服务器的资本开支为879亿美金。

自研ASIC芯片:考虑到谷歌自研TPU芯片性能出色、性价比高,且谷歌主要AI任务(大模型训练、推理等)主要依靠自研TPU芯片,此处假设自研ASIC服务器资本开支占比为70%,ASIC芯片占服务器价值量为65%(谷歌TPU芯片性能强大,ASP相对较高),对应自研ASIC资本开支为400亿美金,假设购置Trillium、Ironwood、TPU v8p、TPU v8e资本开支占比分别为8%、65%、20%、7%,假设单价分别为0.8、1.2、2.0、0.9万美金,对应采购量分别为40、216、40、32万颗。

采购英伟达芯片:谷歌采购英伟达芯片主要供云客户使用,假设2026年采购英伟达GPU服务器资本开支占比30%,AI芯片占服务器价值量为70%,对应英伟达GPU芯片价值量为185亿美金,分别假设采购英伟达B300(包括GB300)、R200(包括VR200)资本开支占比为60%、40%,假设B300、R200单价分别为3.5、4.5万美元,对应B300、R200采购量分别为32、16万颗。

图3:谷歌-2026年芯片需求测算

03

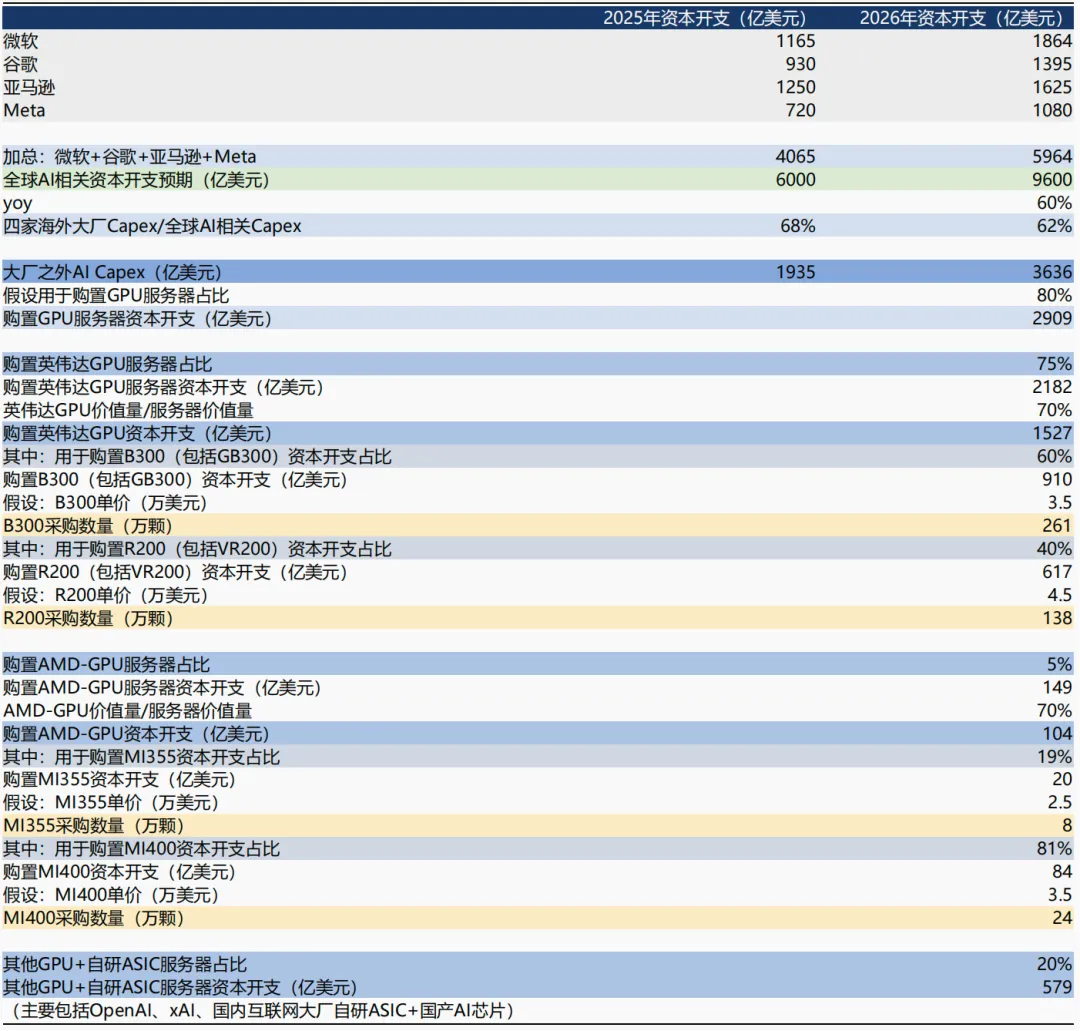

亚马逊-2026年芯片需求测算

亚马逊2026年芯片需求测算:主要购买英伟达芯片,其次为AMD和自研Trainium芯片。

GPU服务器资本开支:根据前文测算,2026年资本开支为1625亿美金,根据亚马逊3Q25电话会披露数据,其资本开支主要由AI基建和电商物流基建驱动;我们假设用于购买GPU、CPU服务器的资本开支占比为50%,且GPU服务器在其中占比为90%(由于GPU服务器ASP大幅高于CPU服务器),则2026年用于购买GPU服务器的资本开支为731亿美金。

采购英伟达芯片:考虑到芯片性能、运行稳定性、兼容性等维度,亚马逊仍以采购英伟达芯片为主,假设2026年采购英伟达GPU服务器资本开支占比为65%,AI芯片占服务器价值量为70%,对应英伟达GPU芯片价值量为333亿美金,分别假设采购英伟达B300(包括GB300)、R200(包括VR200)资本开支占比为55%、45%,假设B300、R200单价分别为3.5、4.5万美元(考虑到性能提升、HBM及晶圆成本提升等因素),对应B300、R200采购量分别为52、33万颗。

采购AMD芯片:AMD芯片快速迭代发展,MI400系列芯片性能表现出色,预计2026年亚马逊将采购部分AMD芯片作为补充,此处假设采购AMD GPU服务器资本开支占比为12%,对应资本开支为61亿美金,且用于购置MI355、MI400资本开支占比分别为5%、95%,且假设MI355、MI400芯片单价分别为2.5、3.5万美金,对应MI355、MI400采购量分别为1、17万颗。

自研ASIC芯片:亚马逊自研ASIC芯片启动时间较早,技术已经逐步成熟,预计2026年亚马逊自研芯片Trainium2.5、Trainium3快速放量,此处假设自研ASIC服务器资本开支占比为23%,ASIC芯片占服务器价值量为50%,对应自研ASIC资本开支为84亿美金,假设购置Trainium2.5、Trainium3资本开支占比分别为15%、85%,假设Trainium2.5、Trainium3单价分别为0.4、0.6万美金,对应Trainium2.5、Trainium3采购量分别为32、119万颗。

图4:亚马逊-2026年芯片需求测算

04

Meta-2026年芯片需求测算

Meta 2026年芯片需求测算:主要购买英伟达芯片,其次为AMD和自研MTIA芯片。

GPU服务器资本开支:根据前文测算,2026年资本开支为1080亿美金,根据Meta 3Q25电话会披露数据,其资本开支主要由AI基建驱动;我们假设用于购买GPU、CPU服务器的资本开支占比为60%,且GPU服务器在其中占比为90%(由于GPU服务器ASP大幅高于CPU服务器),则2026年用于购买GPU服务器的资本开支为583亿美金。

采购英伟达芯片:考虑到芯片性能、运行稳定性、兼容性等维度,Meta仍以采购英伟达芯片为主,假设2026年采购英伟达GPU服务器资本开支占比为80%,AI芯片占服务器价值量为70%,对应英伟达GPU芯片价值量为327亿美金,分别假设采购英伟达B300(包括GB300)、R200(包括VR200)资本开支占比为55%、45%,假设B300、R200单价分别为3.5、4.5万美元(考虑到性能提升、HBM及晶圆成本提升等因素),对应B300、R200采购量分别为51、33万颗。

采购AMD芯片:AMD芯片快速迭代发展,MI400系列芯片性能表现出色,预计2026年Meta将采购部分AMD芯片作为补充,此处假设采购AMD GPU服务器资本开支占比为15%,对应资本开支为61亿美金,且用于购置MI355、MI400资本开支占比分别为5%、95%,且假设MI355、MI400芯片单价分别为2.5、3.5万美金,对应MI355、MI400采购量分别为1、17万颗。

自研ASIC芯片:Meta自研ASIC芯片启动时间较晚,预计2026年亚马逊自研芯片MTIA 3将小规模放量,此处假设自研ASIC服务器资本开支占比为5%,ASIC芯片占服务器价值量为50%,对应自研ASIC资本开支为15亿美金,假设MTIA 3单价分别为0.5万美金,对应采购量分别为30万颗。

图5:Meta-2026年芯片需求测算

05

其他厂商-2026年芯片需求测算

其他厂商2026年芯片需求测算:以购买英伟达芯片为主,购买AMD和自研芯片为辅。

GPU服务器资本开支:根据2Q25英伟达电话会议披露信息,2025年全球AI相关Capex 约为6000亿美金,预计2年内翻倍,随着中国等地区加大对AI投入,我们假设2026年全球AI相关Capex增长至9600亿美金(同比+60%),则四家大厂之外的AI相关Capex 为3636亿美金,假设其中80%用于购买GPU服务器,则对应Capex为2909亿美金。

采购英伟达芯片:考虑到英伟达芯片稳定性好、生态成熟,目前全球其他厂商仍以采购英伟达芯片为主,假设2026年采购英伟达GPU服务器资本开支占比为75%,AI芯片占服务器价值量为70%,对应英伟达GPU芯片价值量为1527亿美金;考虑到R200系列服务器前期调试难度较大,以头部云厂商采购为主,所以假设其他厂商分别假设采购英伟达B300(包括GB300)、R200(包括VR200)资本开支占比为60%、40%,假设B300、R200单价分别为3.5、4.5万美元(考虑到性能提升、HBM及晶圆成本提升等因素),对应B300、R200采购量分别为261、138万颗。

采购AMD芯片:AMD芯片快速迭代发展,MI400系列芯片性能表现出色,预计2026年其他厂商将采购部分AMD芯片作为补充,此处假设采购AMD GPU服务器资本开支占比为5%,对应资本开支为104亿美金,且用于购置MI355、MI400资本开支占比分别为19%、81%,且假设MI355、MI400芯片单价分别为2.5、3.5万美金,对应MI355、MI400采购量分别为8、24万颗。

其他GPU+自研ASIC芯片:国内海光信息、摩尔线程、沐曦等GPU厂商快速发展,同时华为、寒武纪等均推出AI芯片方案,此外海外OpenAI、xAI有望发布自研ASIC芯片;此处,假设其他GPU+自研ASIC芯片资本开支占比为20%,对应579亿美金。

图6:其他厂商-2026年芯片需求测算

06

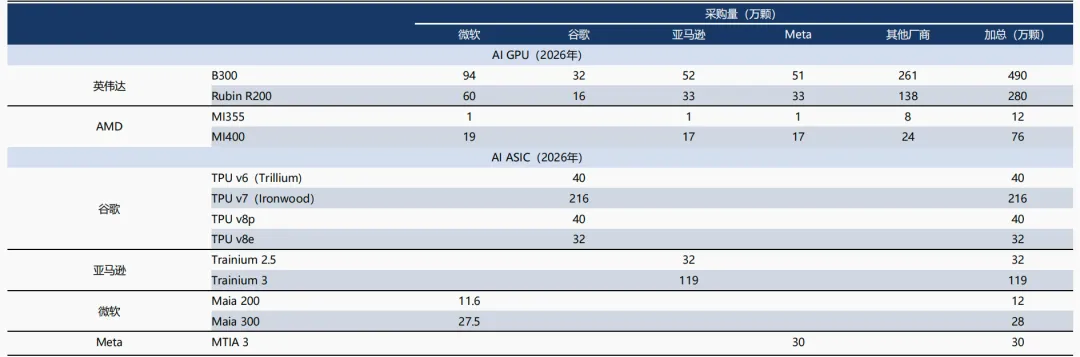

汇总-2026年芯片需求测算

2026年芯片需求测算:以英伟达芯片采购为主,海外大厂自研ASIC、AMD有望放量。

英伟达:2026年各厂商仍以英伟达芯片采购为主,根据上文测算结果,预计2026年英伟达芯片出货量一共770万颗,其中B300为490万颗(包括GB300系列),R200为280万颗(包括Rubin VR200系列)。

AMD:由于AMD MI400性能出色,预计2026年部分厂商会对AMD GPU进行采购,根据上文测算结果,预计2026年AMD芯片出货量一共为88万颗,其中MI355为12万颗,MI400为76万颗。

自研芯片:2026年大厂自研ASIC芯片预计快速放量,根据上文测算结果,预计2026年谷歌TPU合计出货量为328万颗,亚马逊Trainium出货量为151万颗,微软Maia出货量为40万颗,Meta MTIA出货量为30万颗。

图7:汇总-2026年芯片需求测算

02 互联侧:光模块+PCB持续迭代,量价齐升

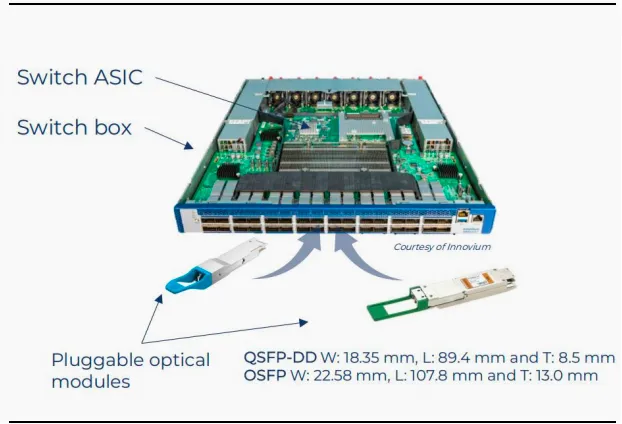

数据中心互联-光模块:光摩尔定律,单卡价值量代际增加

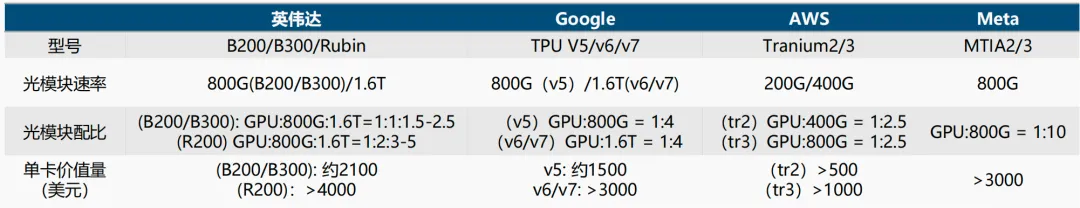

光摩尔定律,速率代际升级每1-2年一次。一方面,端口速率按“1–2年一代”从10G/40G-100G/400G-800G/1.6T;另一方面,数据中心网络从“少量跨机柜光互连”走向leaf-spine扁平化、东西向流量主导,叠加AI训练集群由几十卡扩展到数百卡规模,使得光模块的用量、规格与单点价值量同步抬升。

AI芯片领军企业英伟达等加速迭代其AI芯片性能,推动智算中心互联快速发展。英伟达芯片P/V/A/H/B等系列芯片架构由早期的每4年升级一次加速到每两年迭代升级一次,过去3年间,AI算力集群也从64个AI芯片组成的机柜发展到256个乃至288/576个AI芯片集群,芯片之间的网络连接速率也随之从400G演进至目前使用的1.6T。

价值量变化:单张AI加速卡对应的光模块价值量已进入千美元级(例如B200/B300约2100美元,更高代际方案可>4000美元;TPU v6/v7与Meta MTIA2/3亦在3000美元以上),光互连在单柜/单Pod里的投入代际翻倍增加。

未来趋势:光模块核心变量:“速率×端口密度×网络层级渗透率×集群规模”,量增和结构升级并存。800G将加速规模化部署、1.6T进入导入期,网络速率迭代快于芯片迭代;同时LPO/CPO、硅光、AOC等路线让网络向“更低功耗、更高密度、更高可靠”演进。

图8:可插拔光模块

图9:GPU单卡光模块价值量

03 数据中心互联-PCB:Rubin新架构推动PCB价值量数倍增长

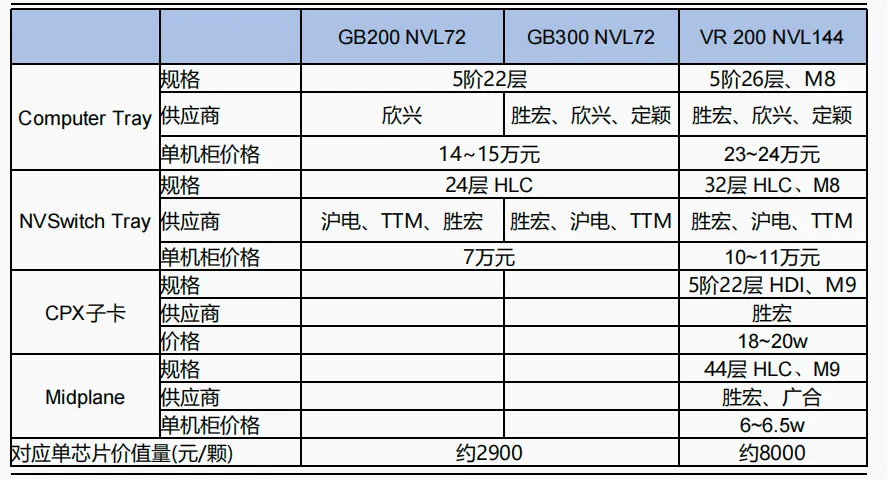

GB300 NVL72 PCB量价拆解:

1)Bianca板:使用M8级别覆铜板,规格为5阶22层HDI,单价约4000~4500元/块,单个GB200 NVL72机柜中需要18个Compute Tray,共36块Bianca板,合计单rack价值量约14~16万元;

2)Switch板:根据Semianalysis,Switch tray通过集成多颗NVSwitch芯片,构建低延迟、高带宽的GPU通信网络,使用M8级别覆铜板,规格为24层高多层PCB,单价约8000~8500元/块,单个GB200 NVL72机柜中需要9个Switch Tray,合计单rack价值量约7~7.5万元;

3)配板:包括ConnectX-7网卡板及DPU板等,对PCB要求较低,预计价值量单rack不超过3万元。根据上述测算,我们预计GB200 NVL72单机柜PCB价值量约23~25万元,单GPU对应PCB价值量为3000+元。

Vera Rubin CPX系列PCB量价拆解:

以NVL144 CPX为例(价值量最高的架构)

1)Computer Tray仍包含两块类似GB300的Bianca板,预计规格为5阶26层HDI,单机柜23~24万元;

2)Switch Tray预计使用M8级覆铜板的32层HLC,预计单机柜价值量为10~11万元;每个托盘内含有8个CPX GPU,放在4个子卡上,预计为5阶22层HDI,单柜价值量约18~20万元;

3)Midplane用于替代GB300 Tray中的跳线,连接Bianca主板、CX-9网卡和Bluefield DPU,由于其对于信号传输速率要求较高,我们认为其或将采用M9材料层高多层板,价值量约6~6.5万元。

图10:机柜内PCB价值量

图11:单GPU对应PCB价值量

04 冷却侧:功率密度持续提升,液冷大势所需

冷却侧:当前北美液冷价值量达到单KW 1千美金以上

液冷将是智算中心高功率密度散热主要方案。智算训练需要建立高度集中化的GPU集群,而智算中心GPU芯片的算力在不断提升,英伟达B200芯片TDP功耗已达1000W,由一颗Grace CPU与两颗Blackwell GPU组成的GB200超级芯片达到了2700W;其GPU架构从Blackwell继续进化为Rubin Ultra,Vertiv数据显示,AI GPU机架的峰值密度有望从2024年的130kW到2029年突破1MW,采用液冷技术是大势所趋。

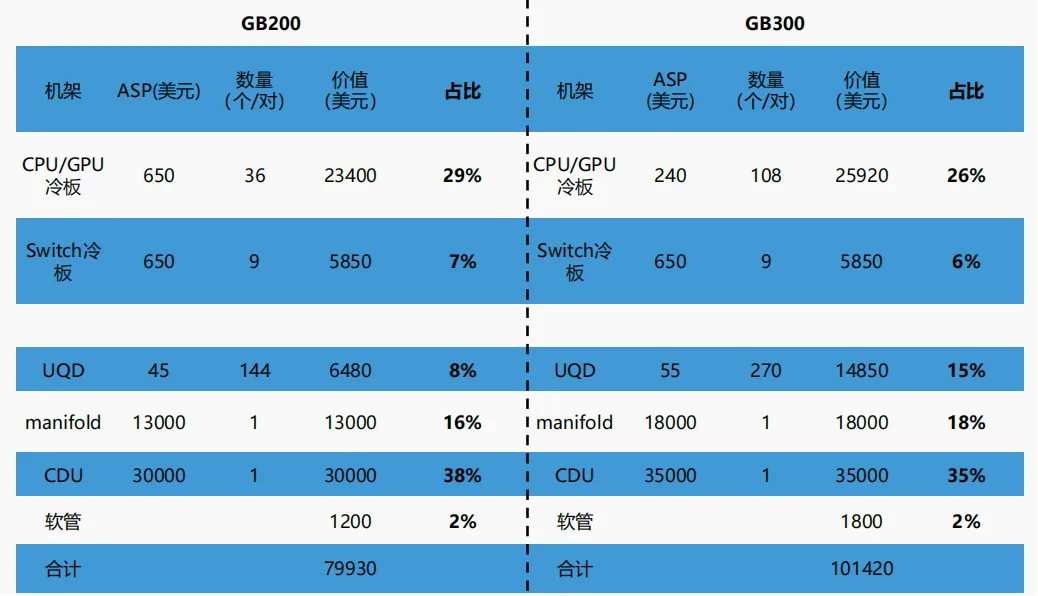

单颗GB200、GB300对应液冷价值量分别为1110/1409美元,当前可按照1-1.1k美元/kw计算北美液冷空间。GB200与GB300单机柜均72个GPU,经测算单机柜液冷价值量分别为79930美元和101420美元,对应单颗GB200/GB300液冷价值量分别为1110美元/1409美元。

考虑到GB200和GB300的单GPU功耗分别为1000w/1400w,得出当前海外液冷价值可基本按照1-1.1k美元/kw计算。R200功耗为1.8-2.3kw,单卡对应液冷价值量或达到2400美元。

图12:单机柜功率密度与适宜的散热方式

图13:单颗GPU及单KW对应液冷价值量测算

05 冷却侧:液冷零部件价值量拆分:冷板、CDU价值量占比较高

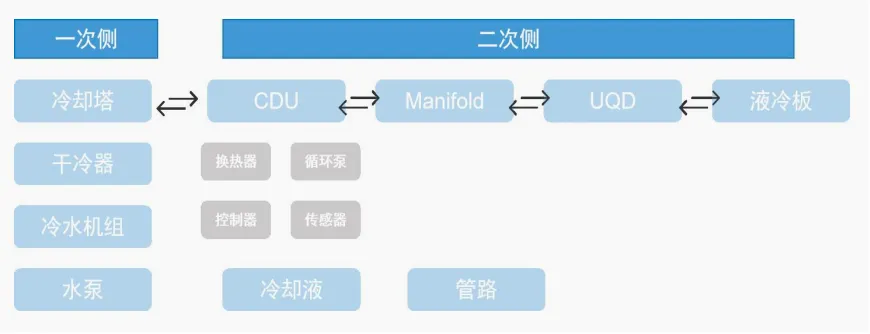

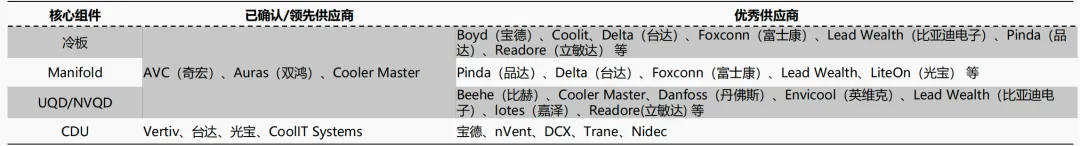

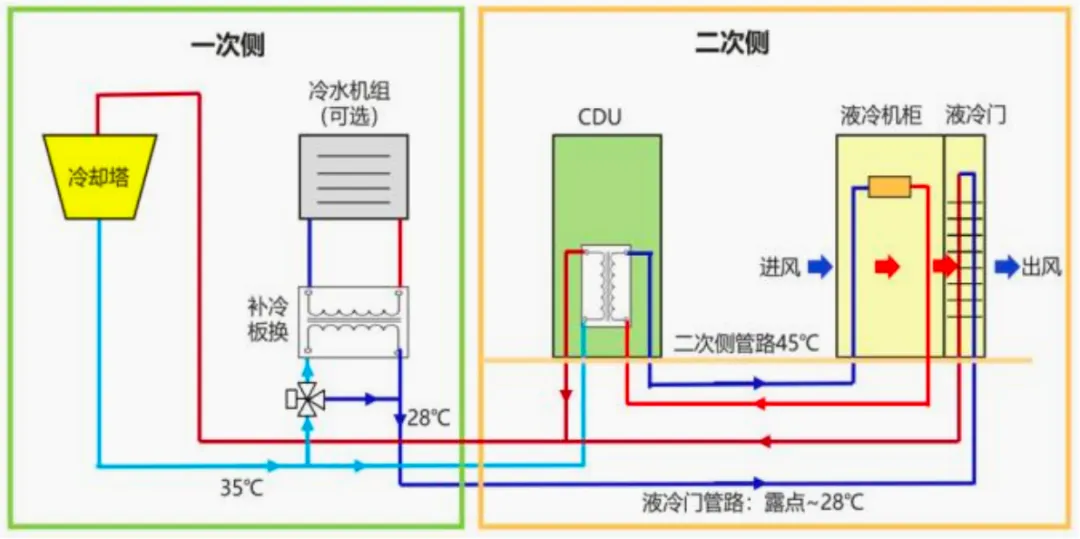

液冷系统分为机房侧和ICT设备侧两部分,机房侧包括一次侧和二次侧,一次侧是连接冷却塔到CDU,全液冷机柜的循环水系统,也称为一次管路或室外侧;二次侧是连接CDU到全液冷机柜中的液冷元器件的冷却循环水系统,也称为二次管路或室内侧。

ICT侧主要系机柜内部零部件如冷板、UQD等。海外机柜算力密度提升直接带来二次侧及ICT设备侧价值量的提升,CDU、冷板价值量占比较高。二次侧包括CDU、液冷机柜、列间空调、冷热气流隔离及封闭组件、动环系统,ICT侧包括机柜内部的冷板、UQD、柜内manifold等零部件:

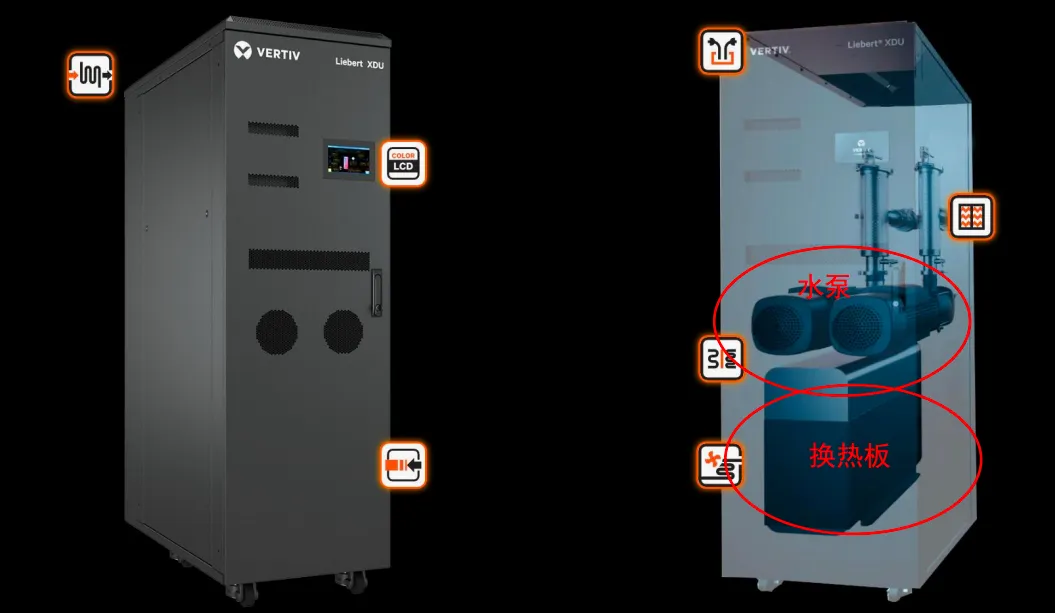

CDU:传统CDU功率在200-300kw,对应2000kw需要7个CDU,价值量占比ICT侧约30%;随着算力密度持续提升,CDU功率需求提升至接近单台2MW,在GB200及GB300中价值量占比提升至35%以上;

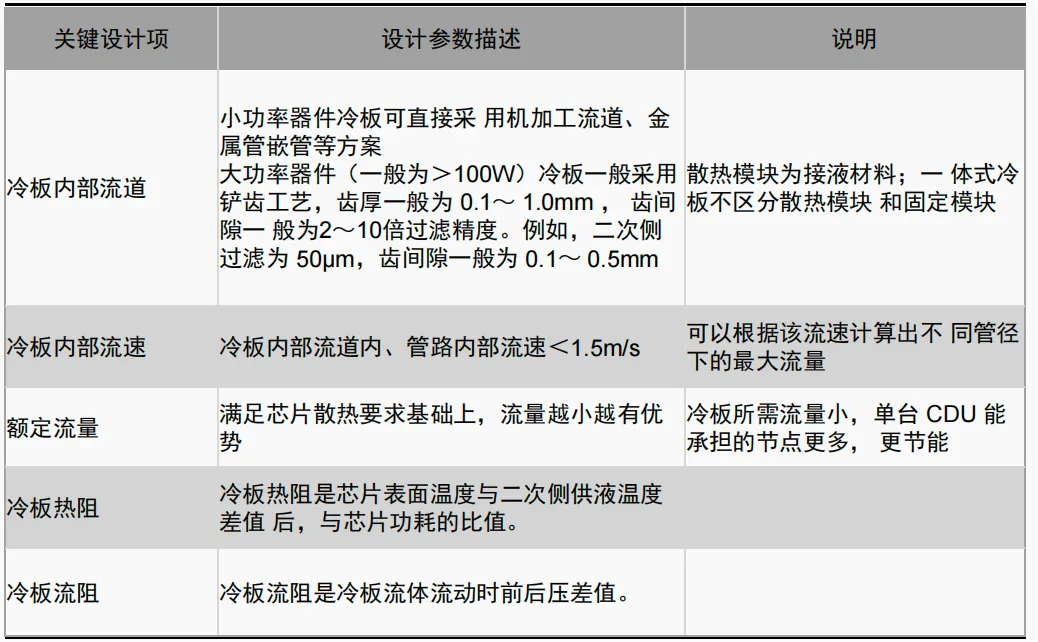

冷板:常用材料为紫铜、铝等,冷板设计需要考虑的关键指标包括冷板内部流道、内部流速、额定流量、冷板热阻以及冷板流阻,在NV GB200/GB300中占比约30%;未来MLCP(微通道水冷板)的应用有望使得冷板价值量提升3-5倍;

Manifold及UQD:整体占比为30%左右。

图14:英伟达GB200/GB300液冷方案成本对比

图15:英伟达GB200/GB300液冷方案

液冷产业链:上游为液冷系统零部件,中游为集成商

液冷产业链分为上中下游:

上游:主要为一次侧、二次侧、ICT侧的液冷零部件,包含冷却塔、冷水机组、CDU、Manifold、UQD、液冷板等;

中游:通常采购或自产上游液冷零部件,对接下游客户提供机房侧或者服务器侧的系统级液冷方案;

下游:数据中心服务商、运营商、互联网大厂等。

图16:上游液冷系统零部件示意图

图17:液冷全产业链

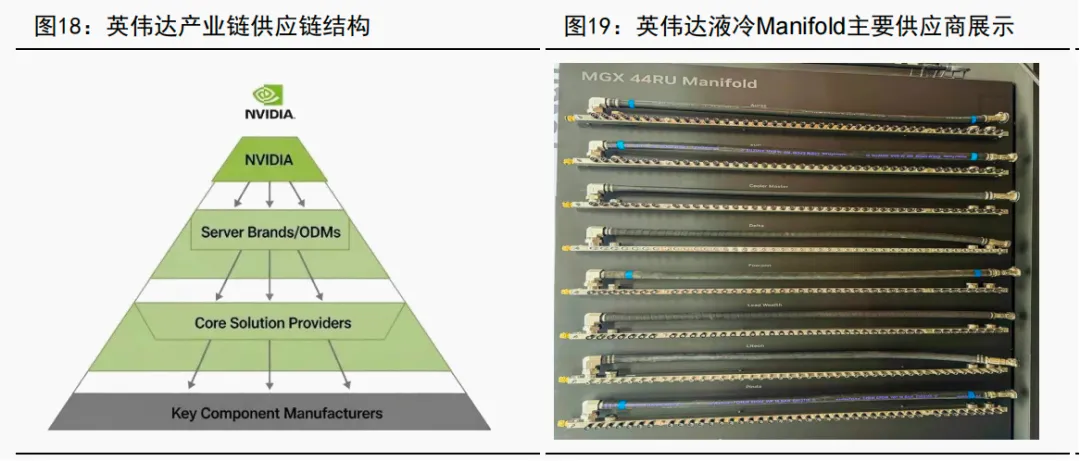

冷却侧:从英伟达液冷产业链看各环节竞争格局

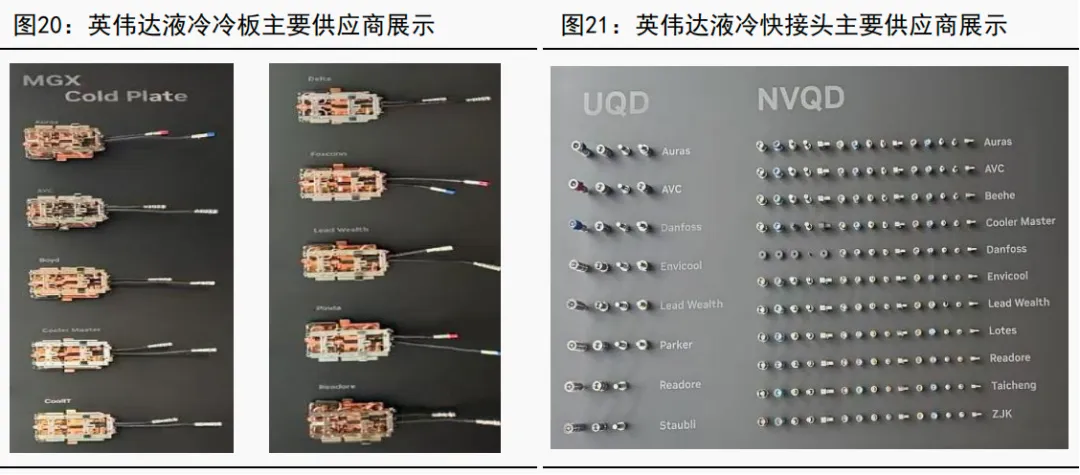

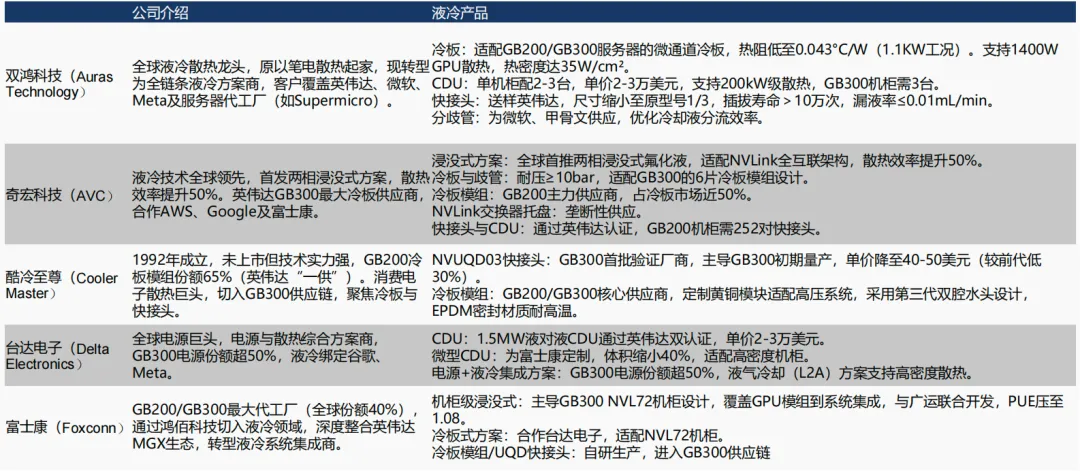

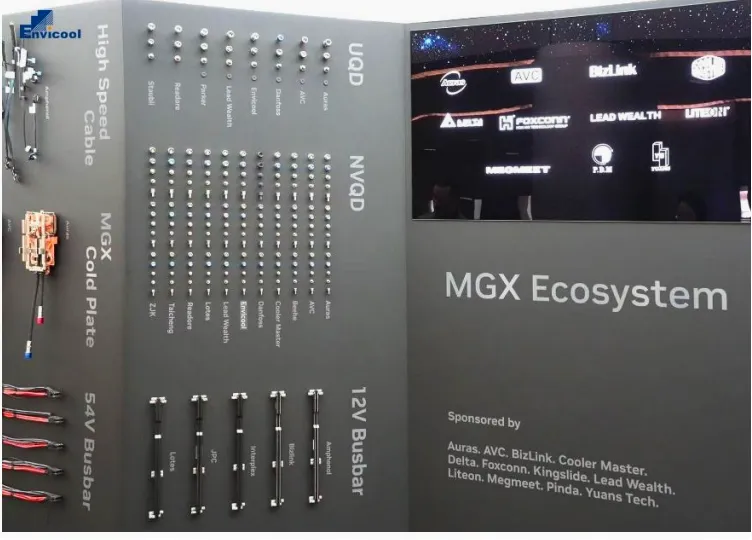

英伟达冷板、NVQD、Manifold等柜内零部件基本由AVC、CoolerMaster、双鸿供应,尤其是AVC和CoolerMaster在价值量较高的冷板环节占据主要份额。

CDU环节:Vertiv为核心供应商,占据主要份额。

海外和台资企业:在北美零部件环节仍占据主导

电子散热等零配件市场集中度高,以海外及台资企业为主。

全球热管主要生产企业有 Honeywell、 Fujkura、双鸿科技、奇鋐科技等。

奇宏,双鸿,台达电子等台资热管理厂商早期为台企ODM服务器厂商提供风冷散热解决方案,同时在液冷批量应用前,就配合英伟达做液冷散热预研。

随着液冷转为主流,早期配合英伟达开发液冷产品的台资厂商迅速拿下批量订单,所以台资液冷组件公司成为本轮人工智能的液冷需求最大受益方,预计占据全球70%以上的液冷组件市场份额。

但随着北美液冷需求迅速扩张,多个环节预计存在产能瓶颈,且以谷歌、Meta为代表的CSP并没有和台资深入绑定,部分大陆厂商有望凭借低成本、定制化服务等优势抢占市场。

图23:台企电子散热器件厂商

图24:台企厂商对比

竞争格局—系统级:综合能力是关键,绑定芯片方案有先发优势

液冷系统集成复杂难度成倍提升,考虑到设备温控稳定性,系统级能力要求高。

由风冷技术向液冷技术的转化过程中,系统集成复杂难度成倍提升,主要体现在:

1)设计难度增大:需要同时融合传热、流体、材料等学科;

2)供应商零部件差异明显:各个零部件的供应能力与匹配接口皆有差异,拉长系统开发时间,且无法达到系统最优;

3)采购难度加大:供应链需要协调多个供应商同时交付,增加采购负担;

4)后期运维难度显著提升:单一供应商不具有故障的系统解决能力。因此综合前期设计、后期运维的系统级能力成为液冷时期的壁垒。

温控的产品优势显现具有后验属性,长期的运行稳定依赖材料的选择、CDU冷量分配软件的优化设计、后期运维能力等综合系统及能力。

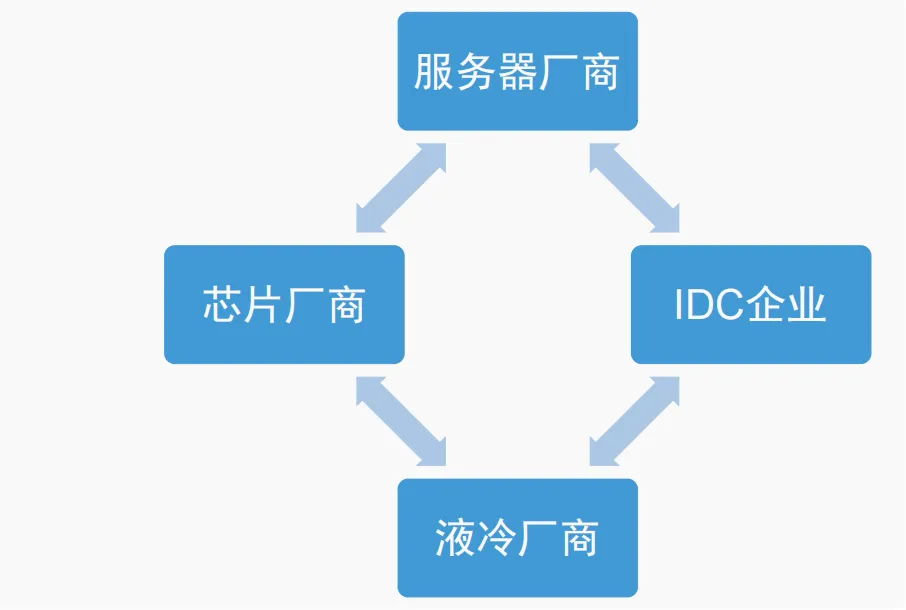

由于液冷系统复杂度提升,各环节的沟通协同有望进一步加强。

液冷相较于风冷而言,与服务器的匹配度要求进一步提升,无论是冷板式服务器(要求液冷冷板匹配服务器型号)还是浸没式服务器,都需要服务器、液冷厂商、IDC企业(业主)共同参与到设计等环节。而当前阶段,绑定加速卡芯片厂商的公司具备显著的先发优势。

图25:液冷数据中心系统复杂度增大

图26 :液冷时期各环节配合度有望进一步加强

竞争格局—零部件:制造环节有一定壁垒

液冷系统涉及零部件较多,不同零部件设计生产难度不同。以冷板式液冷为例,系统关键零部件包括冷板、快接头、Manifold、CDU等。

制造角度,冷板的制造难点在于针翅、微通道等定制化设计以确定合适的流速、流量、热阻等指标,但本身为机加工件,壁垒较低;快接头难点在于控制漏液问题;Manifold可采用316不锈钢+无缝焊接工艺;CDU核心部件为水泵+换热板,软件控制需具备及时响应高功率机柜等能力。

图27:冷板设计核心指标

图28:CDU内部核心部件是水泵与换热板

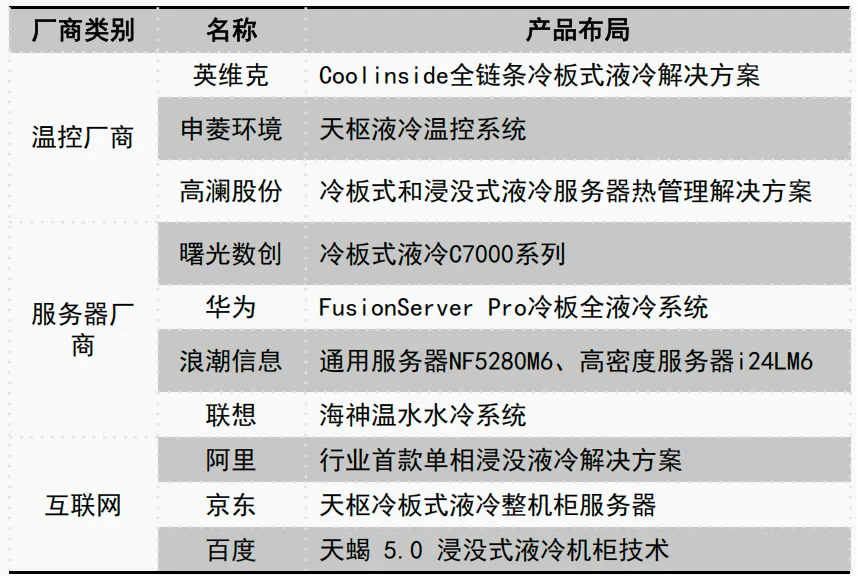

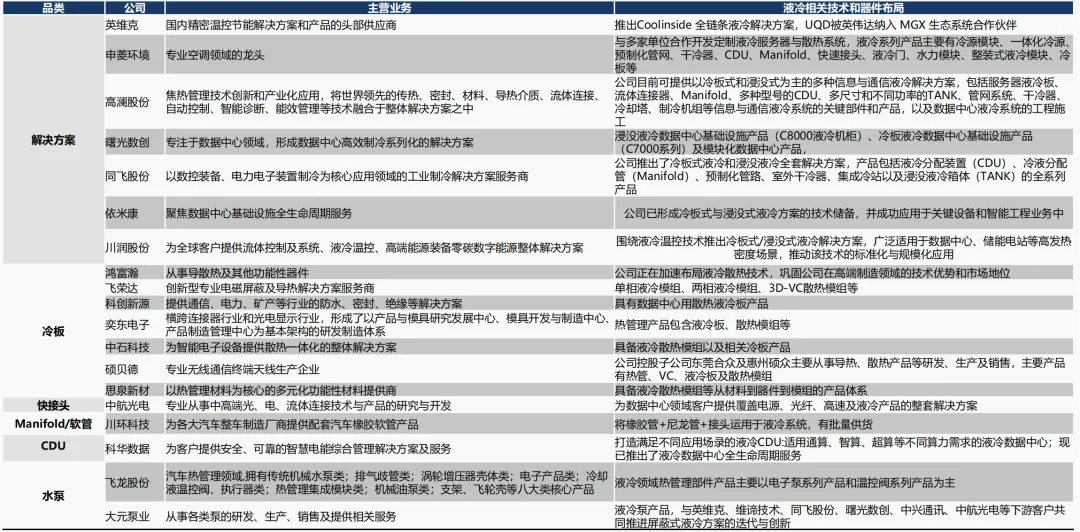

国产厂商:在温控、服务器及CSP云厂相继布局

全球AI发展趋势下,国内液冷供应商包括服务器、互联网厂商、温控设备商以及零配件公司均有参与,各自环节有各自的优势:

(1)温控设备厂商:深耕温控技术应用场景,对技术原理理解深厚,为客户提供定制化全链条解决方案及关键部件的设计制造,能够从系统角度出发提供整体解决方案。

(2)服务器厂商:贴近客户,可利用客户关系向上集成。

(3)互联网大厂:如阿里、华为,自身是客户或EPC,产业链位置领先,对具体应用场景需求更明确零配件公司:以某几类难度较高的配件进入到产业链中,逐步完善整体解决方案。

国产公司市场占有率有望持续提升。数据中心液冷产品大大增加了后期运维的支出和维护成本(定期做腐蚀、密封性、可靠性等检测),相较于国外企业,国产品牌在服务响应效率、产品设计灵活度、运维服务等方面更具有优势,预计国内温控厂商未来有望占据主要地位。

典型公司如英维克。

同时,原先其它消费电子领域的公司,通过跨界,也参与到竞争中,在国产替代背景下,份额提升,如飞荣达。总体来看,本土供应商前景可期。

图29:中游参与厂商对比

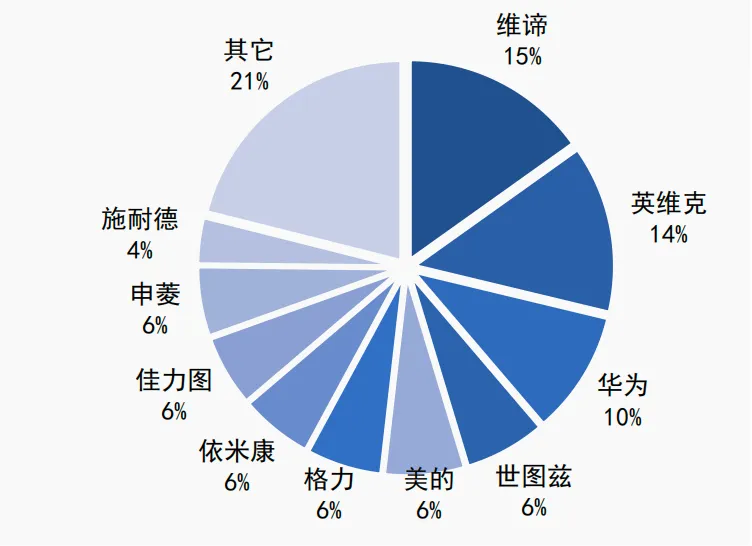

图30 :数据中心精密空调市场格局

图31:英维克的UQD产品已经进入英伟达供应链

国产厂商:以英维克为代表的国产温控厂商有望突破全球市场

专业温控厂商也有方案落地,呈现多方合作模式。目前,英维克、申菱环境和高澜股份已有液冷项目落地(字节马来西亚项目),是国内专业液冷温控供应商中的领先企业。

曙光数创为中科曙光系的温控厂商,主要客户为曙光系超算中心,以浸没式方案为主。

英维克通过与如Intel等相关芯片方案形成绑定的形式,目前优势较为突出。申菱环境、高澜股份等均有机会。

图32 :数据中心液冷温控可比公司综合对比

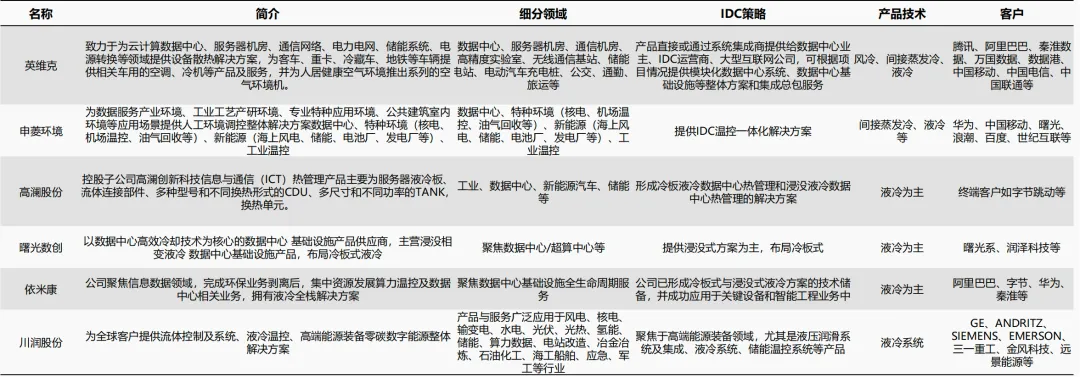

国内液冷产业链主要上市公司

图33:我国液冷产业链主要上市公司主营业务和相关液冷技术布局

07

04 供电侧:AIDC供配电路径演变,关注HVDC、SST领域

供电侧:北美云服务厂商资本开支超预期

北美四大云厂资本开支持续超预期。根据三季度财报数据,北美四大云厂进一步提高其全年资本开支计划,预计2025年资本开支规模接近4000亿美元,同比增长超过60%,AI算力基础设施投入持续加大。

其中,微软预计2025自然年Capex约1100亿美元,同比+46%;Meta上修2025年capex至700-720亿美元,同比+78%~+84%;谷歌全年Capex由850亿美元上修至910-930亿美元,同比+73%~+77%;亚马逊预计全年资本开支1250亿美元,同比+61%。

在AI数据中心的期初投资中,电源设备仅次于IT设备(包括服务器、网络设备、存储设备等)以及工程建设,约占整体投资的5%(根据服务器类型或有所差异)。

AIDC电源设备包括后备电源(以柴油发电机为主)、UPS(不间断电源)、配电设备及开关设备等,每GW的数据中心大概需要20亿美元以上的电源投资。

图34:北美四大云服务厂商季度资本开支(亿美元)

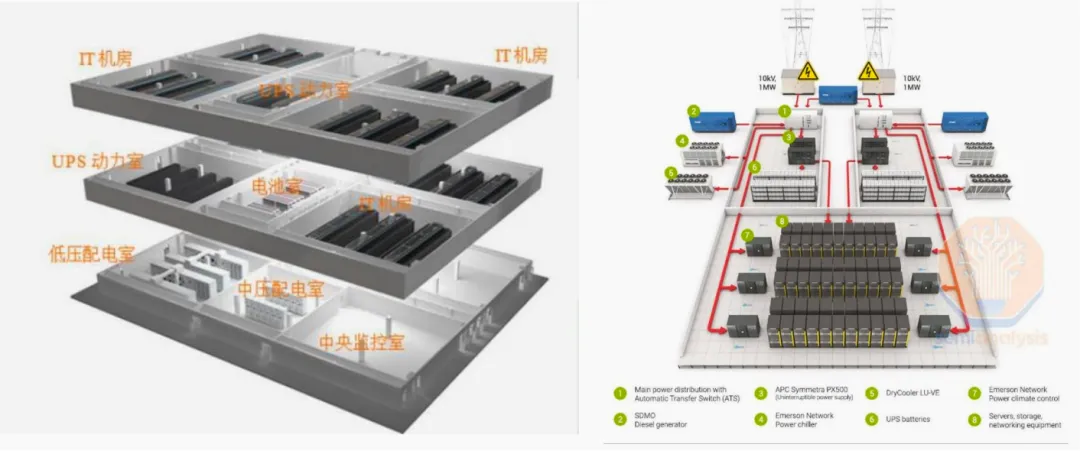

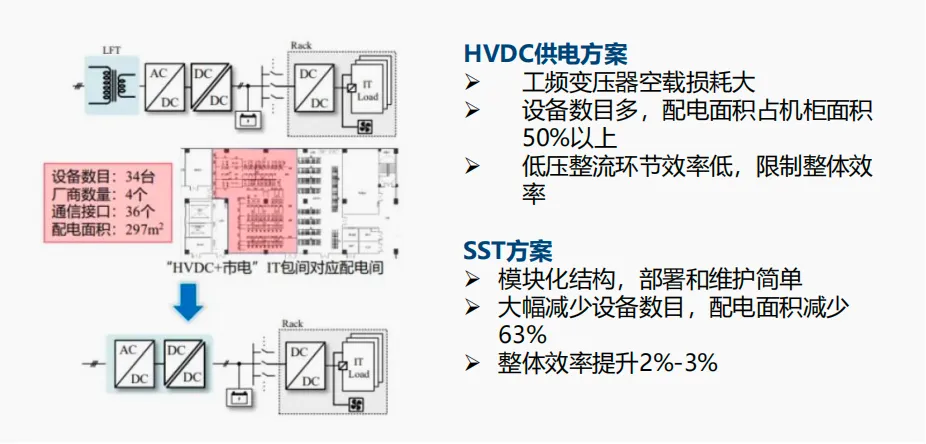

供电侧:智算中心供配电设备占地面积缩减、效率提升需求迫切

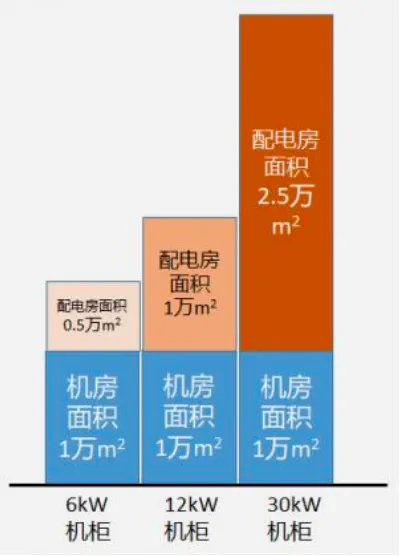

据统计,中压变配电设备、低压配电设备、电能质量处理设备、不间断电源设备、电池设备等及其辅助系统占地面积一般超过数据中心机柜面积的50%以上,且随着单IT机柜功率增加,配套供配电系统占地面积快速提升;减少数据中心供电系统的占地面积、提高数据中心空间利用率和土地资源利用率已经成为数据中心建设的重要指标。

根据ODCC测算,在机房面积为1万m2的场景下,单机柜功率若从6kW提升至30kW,则配电房面积将从0.5万m2提升至2.5万m2,配电房将侵占数据中心大部分土地空间。

此外,随着服务器功率的提升,AIDC用电量将快速提升,供配电链路效率对于项目经济性具有显著影响,提升效率成为AIDC的重要要求。目前数据中心供电链路中铜仍然作为主要导体,铜价持续上涨背景下减少用铜量也成为重要诉求。

图35:数据中心典型功能区分布图

图36:数据中心配电房占比面积与机柜功率关系

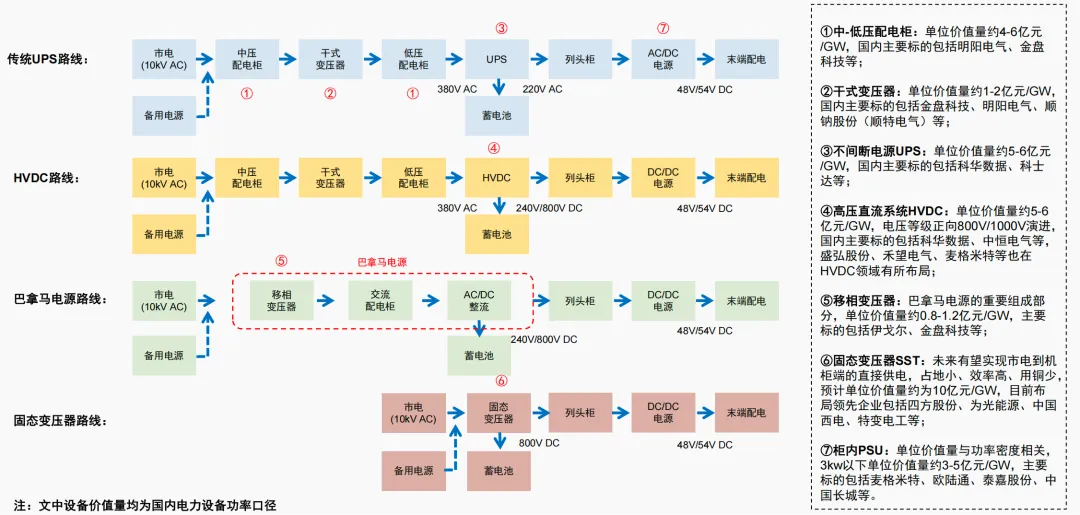

供电侧:AIDC供配电方式演进路线

AIDC供配电方式的演进围绕减小占地、提升效率、减少用铜量三大核心目标展开,同时要兼顾电网友好性、分布式能源接入便利性、技术方案成熟度等因素。

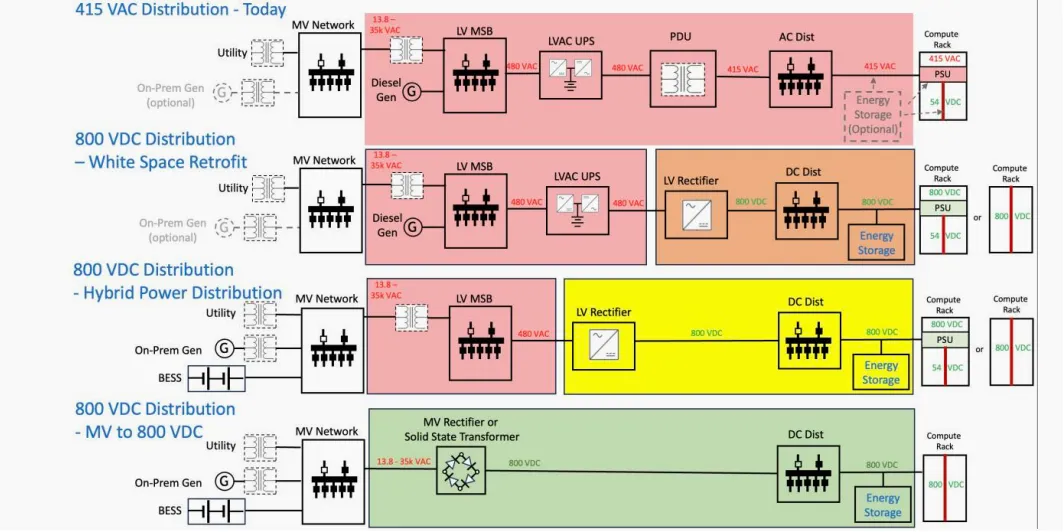

供电侧:800V直流供电方案逐步成为主流

目前UPS是国内外IDC数据中心供电方案的主流,但随着服务器电源功率提高以大规模算力集群的建设,UPS方案转换损耗大、结构复杂易故障、占地面积大等缺点日益凸显。

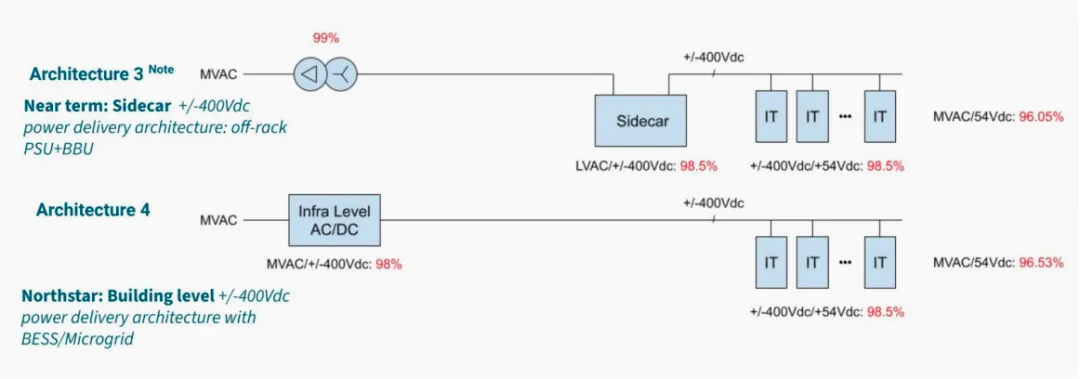

2024年10月,谷歌在 OCP(Open Compute Project)大会上介绍了应用于 AIDC 的±400Vdc 供电架构,其过渡期采用专用电源柜(Sidecar)方案,终极目标是将±400Vdc与电池备份整合至数据中心基础设施,与微电网、储能等结合,实现能效最大化(>96.5%)和计算密度跃升。

Meta及微软也在推进±400Vdc供电方案。

2025年5月,英伟达宣布将于2027年导入800V HVDC数据中心架构,以应对高功率AI服务器的需求。现行54V架构因铜缆过重、空间受限及能耗等问题,已无法支撑高密度运算。

800V HVDC通过单步AC/DC转换,提升能效5%、功率传输量85%,并减少45%铜材用量,降低系统复杂度与维护成本。英伟达与多家产业伙伴合作推动标准化生态系,预计可将总体拥有成本(TCO)降低30%,为生成式AI提供稳定高效的电力基础。

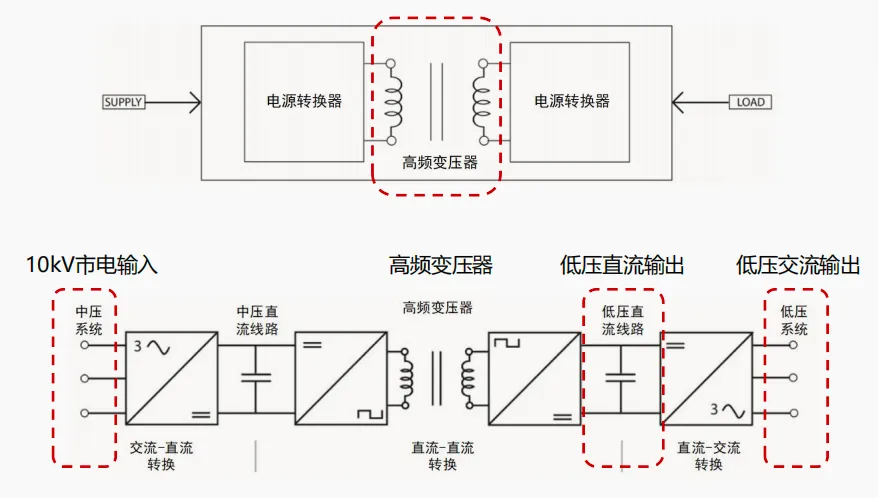

固态变压器(SST)也称为“能源路由器”或“电力电子变压器”,由电力电子变换器和高频变压器组成,可实现高压交流至低压直流/交流的电压变换及能量双向流动。固态变压器未来有望成为800V直流供电架构的核心组件,直接实现10kV交流到800V直流的转换,效率高达98%。

图37:±400V DC供电架构

图38:800V DC供电架构

供电侧:固态变压器(SST)有望成为AIDC终局供配电方案

固态变压器(SST)由电力电子变换器和高频变压器组成,可实现高压交流至低压直流/交流的电压变换及能量双向流动。

相较于传统的工频变压器,电力电子变压器不仅具备电压等级变换和电气隔离功能,还能够提供不同电压等级的多个直流端口,以满足直流电网或交直流混合电网中直流设备的需求,从而实现更加灵活和高效的电能管理,潜在应用场景包括数据中心、电动汽车、铁路牵引、新能源并网、直流配网等。

固态变压器具有几大突出优势:

其一,取消工频变压器环节,占地节省50%以上,系统效率提升2%以上;

其二,通过高频电力电子技术减少用铜量,最高可节省90%用铜量;其三,可实现直流设备灵活,是光伏、储能、充电的“能量路由器”;其四,可实现功率、电压、频率的精准实时控制,电网友好。

固态变压器技术难点体现在以下几方面:

其一,SST是电力电子装置和变压器原理相结合的产物,企业需要同时具备对于两者的深刻理解。

其二,SST是解决方案不是单一设备,是电网和服务器之间的唯一屏障,需要企业具备对电网特性和算力负载特性的深度理解。

其三,SST是中压(10-40kV)电力电子装置,与UPS/HVDC等低压装置存在较大差异。

图39:固态变压器原理示意图

图40:数据中心SST方案与HVDC方案对比

机会发现

算力侧:微软、谷歌、Meta、亚马逊等海外大厂对2026年资本开支指引乐观,我们预计2025年、2026年四家大厂资本开支总和分别为4065、5964亿美元,分别同比+46%、47%,且用于投资AI算力及基础设施的比例有望持续提升,2026年AI算力景气度持续上行,建议关注海光信息。

互联侧:

1)光模块:一方面,端口速率按“1–2年一代”从10G/40G-100G/400G-800G/1.6T;另一方面,数据中心网络从“少量跨机柜光互连”走向leafspine扁平化、东西向流量主导,叠加AI训练集群由几十卡扩展到数百卡规模,使得光模块的用量、规格与单点价值量同步抬升,建议关注光迅科技、华工科技。

2)PCB:随着算力架构从GPU服务器向正交化、无线缆化演进,信号链条更短、对材料损耗更敏感,PCB成为AI硬件中最核心的互连与供电载体之一,建议关注生益科技、胜宏科技、沪电股份、鹏鼎控股、东山精密、景旺电子、世运电路、芯碁微装。

冷却侧:根据Vertiv数据显示,AI GPU机架的峰值密度有望从2024年的130kW到2029年突破1MW,采用液冷技术是大势所趋,建议关注英维克。

供电侧:1)中国HVDC渗透率提升+800V HVDC试点应用;2)2026年固态变压器国内外试点落地催化行业情绪;3)英伟达服务器电源订单逐步落地,市场份额及单机柜价值量有望提高,建议关注麦格米特。

突发!跃居全球第一!阿里千问APP上线全新AI Agent功能之核心技术和架构深度分析!2026

百万亿空间!CES 2026后英伟达Rubin架构及供应链(存储/互联/液冷)变化解读!2026

万亿市场!持续增长!国内外人形机器人出货量排名深度洞察!2026

刚刚!突发开源!NVIDIA 宣布推出用于物理 AI 的全新开放模型、框架和 AI 基础设施之深度洞察!

突发!工信部印发《推动工业互联网平台高质量发展行动方案(2026-2028年)》深度洞察!2026

百万亿规模!英伟达最新Rubin平台AI计算架构及产业链深度剖析!2026

持续增长!百万亿市场!AI 基础设施之通信篇深度洞察!2026

突发!行业巨震!马斯克: 3年内机器人超越顶尖医生深度洞察!2026

今夜无眠!百万亿规模起飞!英伟达突发开源Alpamayo的全新自动驾驶汽车大模型之深度洞察!