2026年被视为全球数据中心架构的分水岭。随着Meta、微软、英特尔以及工业富联等科技与制造巨头最新财报的披露,一个由热力学限制驱动的“硬核基础设施”时代已然开启。这一年的核心叙事不再仅仅是算法的迭代,而是围绕着能量密度、散热效率以及资本开支(CapEx)效率的物理博弈。当单芯片功耗(TDP)向1000W甚至2000W进发时,传统的风冷技术已触及物理天花板,液冷技术从高性能计算(HPC)的边缘领域走向超大规模数据中心(Hyperscale)的舞台中央。

01.资本开支的物理转型:Meta与微软的算力军备竞赛

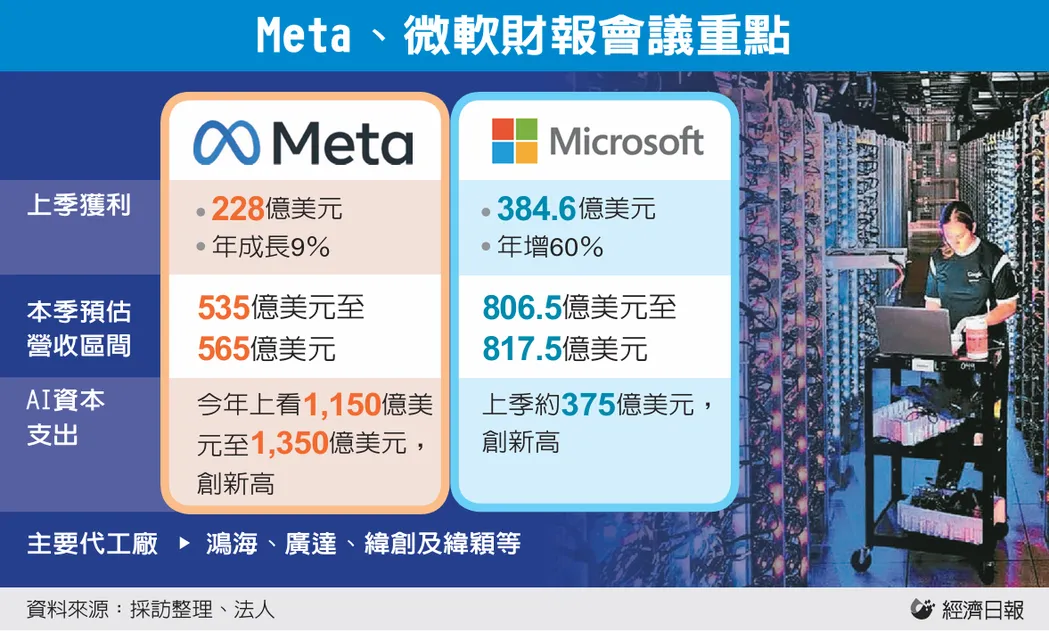

在2025财年及2026财年的最新财报中,Meta与微软展现出了惊人的资本投入规模。这种投入不仅仅是采购GPU,更是对整个物理环境的重构,尤其是液冷设施的全面普及。

Meta:从算法优化到物理主权的战略转移

Meta在2025年第三季度的营收达到了512.4亿美元,同比增长26%,而其背后的支撑力正是其庞大的基础设施投入。Meta管理层明确表示,2025年的资本开支预计在700亿至720亿美元之间,而2026年的资本开支将呈现“显著增长”。根据最新的预测,Meta在2026年的资本开支可能跃升至1150亿至1350亿美元的区间,重点投入于“Meta超级智能实验室”(Meta Superintelligence Labs)以及支撑其算力的核心基础设施。

这种资本投入的逻辑已经从“购买服务器”演变为“拥有能源、硬件和房产”。Meta正在建设多座吉瓦(GW)级别的园区,其中位于俄亥俄州新奥尔巴尼的Prometheus数据中心成为全球首个功率需求超过1吉瓦的设施。对于这种密度的设施,传统的空气流动已无法带走核心组件产生的巨大热量。Meta的“Catalina”AI机架设计已全面采用液冷技术,单机架功耗可达140kW,支持72颗NVIDIA GPU并行工作。

Meta平台基础设施与财务核心数据 (2025-2026) | 2025年数据/预测 | 2026年展望/目标 |

年度资本开支(CapEx) | 700-720 亿美元 | 1150-1350 亿美元 |

旗舰数据中心功率(Prometheus) | 建设中 | 1.0+ GW 级运行 |

液冷设施部署面积 | 4000万+ 平方英尺 | 全新AI站点标配 |

广告单价增长率 | 6% - 10% | 依赖AI推荐系统持续优化 |

研发投入(Q4单季) | 171 亿美元 | 持续扩张算力实验室人员 |

Meta的战略转型反映了一个深层次的行业洞察:在AI时代,算力不仅是逻辑,更是物理。通过将4000万平方英尺的数据中心空间转化为空气辅助液冷(AALC)架构,Meta预计新架构将带来31%的成本节约,这种节约并非来自减少支出,而是通过提高单位功率下的算力密度实现的。

微软:资源分配博弈与HXU的创新部署

微软在FY2026 Q2表现出了强劲的云增长,总营收达到813亿美元,其中Azure及其他云服务营收增长39%。然而,微软首席财务官Amy Hood在财报电话会议中透露了一个关键信息:如果不受供应短缺的限制,Azure的增长率本应超过40%。这里的“供应短缺”不仅指GPU,更指能够支持高功耗算力部署的高密度数据中心空间。

微软目前正处于一场“资源分配之战”中。新增的算力必须在外部Azure客户需求与内部AI产品(如Microsoft 365 Copilot、GitHub Copilot)之间进行权衡。为了应对这一挑战,微软在单一季度的资本开支激增至375亿美元,同比增长66%。

为了在现有设施中快速部署AI算力,微软推出了下一代热交换单元(HXU)。这是微软向开放计算项目(OCP)贡献的一项关键技术,旨在使液冷系统能够在现有的风冷数据中心内实现“无感集成”,其性能是现有型号的两倍,且无需对数据中心进行根本性改动。

微软对液冷的押注还体现在其对“零水耗”制冷系统的追求上。其两相浸没式液冷技术正在生产环境中进行测试,使用沸点仅为122°F(50°C)的介电液体,这比水的沸点低得多,能够使服务器功耗降低5-15%。这种对物理极致的追求,是微软维持其算力LTV(客户终身价值)长期竞争力的核心。

02.半导体演进的物理终点:TDP 2000W时代的到来

液冷市场的爆发,本质上是半导体功耗演进的必然结果。英特尔、NVIDIA以及AMD在2026年的产品路线图显示,单芯片的热设计功耗(TDP)正以非线性的速度攀升。

英特尔18A 工艺与 Clearwater Forest 的散热挑战

英特尔的最新财报显示,虽然整体营收略有波动,但其数据中心与人工智能(DCAI)业务已重回增长轨道,Q4营收达到47亿美元。英特尔未来算力版图的核心是基于 18A 工艺的 “Clearwater Forest” 处理器。这是首款大规模生产的采用 PowerVia 后端供电技术和 Foveros Direct 3D 封装的 CPU。

Clearwater Forest 的 288 核版本 TDP 约为 450W,虽然其每瓦性能比上一代提升了 30% 以上,但在高密度部署场景下,这种功耗依然是风冷技术的巨大挑战。英特尔预测,未来的 Xeon 处理器功耗可能达到 2000W。

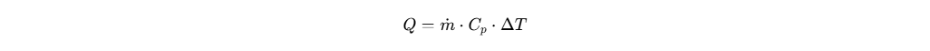

根据热学计算公式,当单芯片功率达到2000W 时,若要维持 10°C 的温升,所需的冷却液流量远超风冷的空气循环能力。因此,英特尔在2025-2026 年战略中最重要的拐点是从 R&D 转向大规模商业化,建立了“数据中心认证”计划,对壳牌(Shell)和埃克森美孚(ExxonMobil)的浸没式冷却液进行保修认证。

GPU的热力学重担:从 H100 到 B300

NVIDIA 的架构演进直接定义了液冷市场的刚需。2026年,NVIDIA 的 B200 和 B300 平台预计单芯片功耗将超过 1000W。在 GB200 NVL72 架构中,一个完整的机柜需要处理高达 120kW 至 300kW 的热负荷。

这种热负荷使得冷板式液冷(DLC)成为 2026 年企业级 AI 部署的标准。冷板式液冷通过将冷却液直接流经处理器表面的微通道(27-100 微米),能够带走 70-75% 的热量,而剩下的热量依然需要风冷辅助,这种“混合动力”模式是当前大多数超大规模部署的现实选择。

处理器及架构TDP 趋势 (2025-2026) | 处理器/平台 | 额定功耗(TDP/Rack Power) | 散热建议方式 |

NVIDIA Blackwell | B200/B300 | 1,000W+ per chip | 冷板式/浸没式 |

英特尔Xeon 6+ | Clearwater Forest | 300-500W per socket | 高级风冷/液冷 |

旗舰AI 训练架构 | GB200 NVL72 | 120kW - 300kW per rack | 必须液冷 |

边缘AI 推理 | 各种ASIC | 15kW - 35kW per rack | 增强风冷 |

03.工业富联:AI制造主权与供应链的纵向整合

工业富联在2025 年及 2026 年初的财报中展现了其作为全球 AI 服务器制造龙头的统治地位。其 AI 服务器营收暴增 150% 以上,云计算业务占总营收的比例首次突破 50%。

扫码免费进群

从组装到“液冷生命周期管理”

工业富联的成功不仅在于其庞大的规模,更在于其对液冷关键组件的掌控。财报显示,工业富联在 800G 高速交换机、液冷冷板、散热管路以及连接器领域的营收增速远超其整体营收增速。这种纵向整合使工业富联能够通过高毛利的组件销售来抵消 AI 服务器组装业务较低的毛利率,从而将 EBITDA 利润率提升至 4.5%-4.8% 的区间。

灯塔工厂与ESG 效率

工业富联 2025-2026 核心财务概览 | 数值(2025 H1) | 增长趋势(CAGR) |

总营收 | 501 亿美元 | 32% |

归属于股东净利润 | 16.8 亿美元 | 31% |

AI 服务器营收占比 | 占云计算营收40%+ | 150%+ 增速 |

800G 交换机营收 | 2024年全年的三倍 | 指数级增长 |

研发投入 | 14.8 亿美元 (年度) | 连续五年超10 亿美元 |

04.2026年全球液冷市场深度剖析:从“昂贵”到“刚需”

2026 年,液冷市场已经完成了从利基市场到主流市场的跨越。根据 Global Market Insights 的数据,全球数据中心液冷市场规模在 2026 年预计将达到 60 亿至 64 亿美元,并以超过 18% 的年复合增长率(CAGR)向 2035 年的 271 亿美元进发。

区域市场的二元博弈:北美vs. 中国

北美市场由于超大规模云提供商(AWS, Google, Microsoft)和先进半导体厂商(NVIDIA, AMD)的集中,占据了全球 41% 的市场份额。在这里,液冷被视为维持技术领先地位和降低长期运营成本(OpEx)的手段。

与此形成对比的是中国市场。由于政府对新建数据中心PUE 值的严格管控(特别是在一线城市),液冷已成为新建设施的“准入许可证”。

中国数据中心冷却市场预测(2025-2031) | 2025年基准 | 2026年预测 | 2031年目标 |

市场总额(百万美元) | 371.63 | 435.1 | 957.21 |

超大规模中心占比 | 46.02% | 持续扩张 | 复合增速17.62% |

液冷技术渗透率(营收) | 37.05% (Est) | 40% 突破 | 复合增速17.92% |

PUE 合规压力影响 | 中等 | 高 | 决定性因素 |

在中国市场,直接芯片制冷(D2C)仍占据主导,但浸没式冷却由于其在应对极端高功率密度(>50kW/机柜)时的卓越表现,正在 AI 超算中心和科研机构中快速扩张。阿里巴巴、百度等本地巨头正在通过自主开发的 ASIC 服务器全面配套液冷解决方案。

技术的“叉路口”:冷板式、浸没式与两相转变

2026 年,液冷技术的演进出现了明确的工程分层。

1.冷板式液冷(DLC):它是2026 年的基准方案,占据了约 42.85% 的液冷市场份额。其优势在于兼容性强,能够与现有的风冷基础设施快速集成,且维护模式与传统服务器相似。

2.浸没式液冷(Immersion):虽然基数较小,但其年复合增长率高达26.6%。随着单机架功耗向100kW 以上冲刺,浸没式冷却在降低 PUE 方面的物理极限优势使其在新建的 AI 原生数据中心中成为首选方案。

3.两相液冷(Two-Phase):当TDP 超过 1500W 时,单相冷却液所需的流速将导致管道侵蚀和严重的机械应力。利用冷却液汽化潜热的两相冷却技术预计将在 2026-2027 年迎来爆发,届时它将解决单相冷却在极端功率下的物理瓶颈。

05.供应链重塑与竞争格局:维谛技术的崛起与“液态生命周期”

在液冷时代,数据中心的基础设施厂商正经历着类似半导体行业的“估值重构”。

维谛技术(Vertiv):物理层面的架构师

维谛技术在2025 年表现优异,其有机销售额增长了 28%,这主要归功于冷板式制冷和冷却分配单元(CDU)的大规模采用。维谛技术的关键优势在于其与NVIDIA 的“Titan”合作伙伴关系,双方共同开发了针对 Blackwell 平台的 7MW 参考架构,将维谛的技术直接植入到全球最先进 AI 服务器的蓝图中。

维谛技术通过收购PurgeRite,实现了对整个“液体生命周期”的掌控,包括机械冲洗、流体管理和过滤。这对于缺乏管道管理经验的传统 IT 运维团队来说是一个巨大的卖点。

液冷基础设施核心玩家及市场地位(2025-2026) | 2025年市场份额 (Est) | 核心竞争力与动态 |

维谛技术(Vertiv) | 11.3% | 与NVIDIA 深度捆绑;全生命周期流体管理 |

施耐德电气(Schneider Electric) | 头部玩家 | 全球电力与IT 综合布局;模块化液冷设计 |

威图(Rittal) | 头部玩家 | OCP 标准的主导者;欧洲市场的统治力 |

Boyd (已被 Eaton 收购) | 头部玩家 | 先进冷板制造与热管理组件 |

CoolIT Systems | 专业领域领先者 | 2000kW+ 超大功率 CDU |

供应链的新兴瓶颈:快速连接器与工质稳定性

随着液冷技术的普及,供应链的瓶颈已从“能不能冷”转向了“稳不稳定”。2026 年,行业对连接器(Quick Disconnects)和流体化学稳定性的关注达到了顶峰。由于液冷涉及大量管道连接,任何微小的渗漏都可能导致数百万美元的硬件损毁。因此,拥有高精密加工能力和 100% 验证协议的厂商(如 Kingka Tech、nVent)正成为供应链中的关键节点。

06.总结与战略建议:迈向液冷原生时代

通过对Meta、微软、英特尔和工业富联最新财务数据的交叉分析,我们可以得出以下关于 2026 年及未来液冷市场的核心结论:

1.液冷已成为AI 准入门槛:2026 年,液冷不再是数据中心的选配项,而是高性能 AI 集群的必选项。渗透率预计将超过 50%。

2.资本开支的效率分水岭:巨头们不仅在买GPU,更在买算力的“物理环境”。能够在液冷架构上实现更低 PUE 和更高密度的公司,将拥有更低的算力单位成本(TCO)优势。

3.技术路线的混合化:2026 年不会是单一技术的统治,而是“冷板为主,浸没为辅,混合部署”的格局。即使是液冷服务器,仍有 20-30% 的热量由风冷处理,精密风扇和气流组织依然重要。

4.供应链的重心东移:以工业富联为代表的中国台湾和大陆厂商,凭借在精密金属加工、系统集成和验证方面的积累,已经在CDU、冷板和歧管(Manifolds)领域占据了主导地位。

5.服务与标准的爆发:随着复杂度的提升,液冷作为服务的模式(Managed Services)将快速增长。同时,英特尔、OCP 和 ASHRAE 正在加速标准的统一,以降低企业级市场的采用门槛。

对于数据中心运营商和投资者而言,2026 年的信号清晰而强烈:计算正从电子时代迈入光电热耦合的综合能源时代。在这个时代,胜负不在于算法的毫秒级优化,而在于能否在物理极限的边缘,稳健地管理每一瓦热量。那些能够率先完成液冷原生架构转型的实体,将掌握 AI 下半场的核心主权。