?期待Deepseek V4 编程有显著突破

看到圈内发现MLA代码库出现MODEL这样的信息,看来离发布快了

V32_FP8Sparse = 1MODEL1_FP8Sparse = 2, FP8KVCacheLayout.V32_FP8Sparse: (576, 512, 64, 128, 4),FP8KVCacheLayout.MODEL1_FP8Sparse: (512, 448, 64, 64, 7)

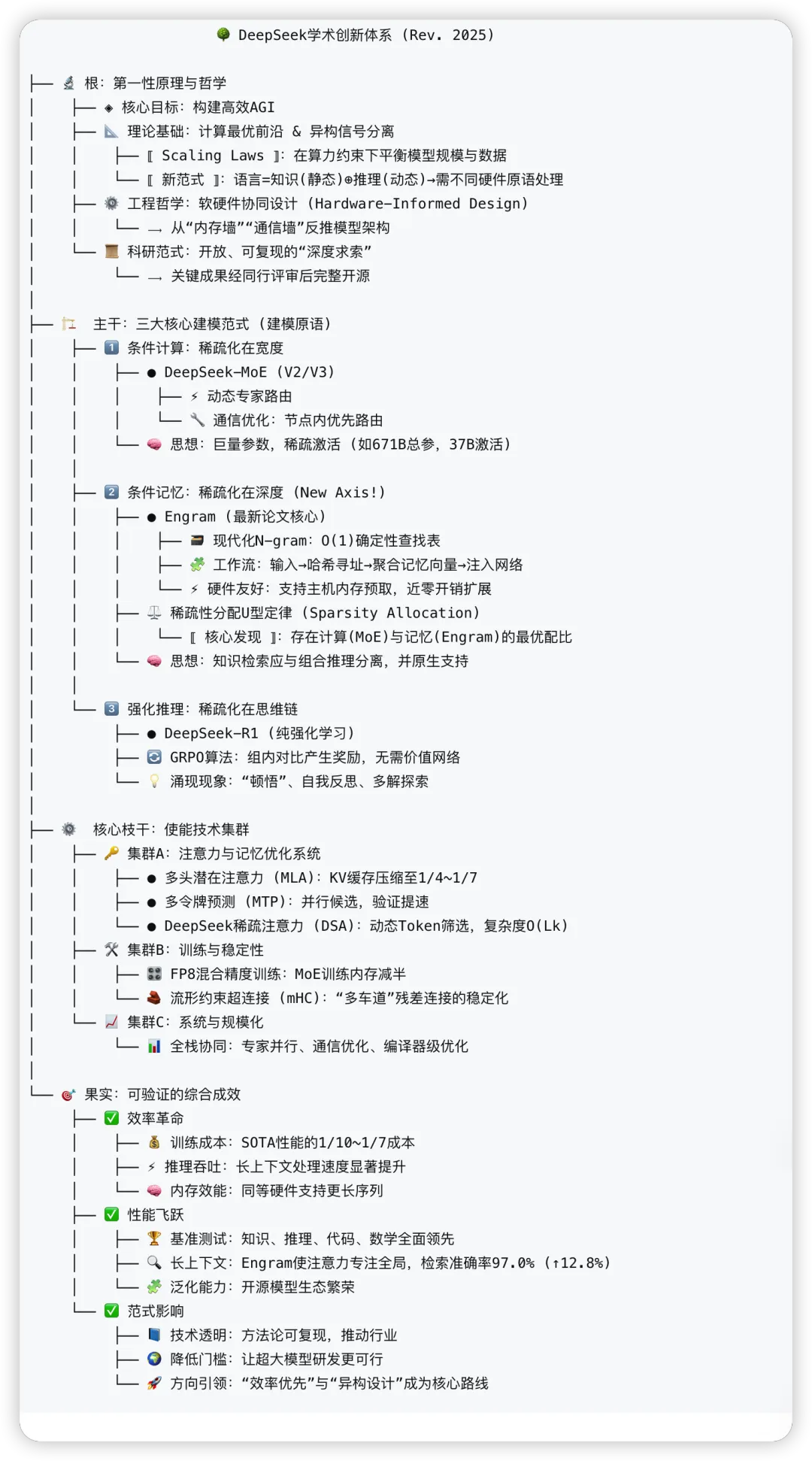

? 摘要

基于The Information独家报道(2026年2月中旬发布窗口)与学术论文技术分析,DeepSeek V4将是一个代码优先的超大规模混合专家模型 。核心创新在于三重稀疏架构的深度融合,特别是在超长代码上下文处理和编程推理能力方面实现革命性突破。

关键时间线与里程碑 :

2025年12月 :V3.2发布,在某些基准超越GPT-5 2026年1月 :mHC、Engram论文预印本发布 2026年2月中旬 :V4发布(农历新年期间) 技术准备度 :论文显示技术已成熟,集成窗口合理

一、代码能力突破的技术基础分析

1.1 代码能力的多维度支撑

代码能力 = 架构优化 + 数据策略 + 训练技术 ↓ ↓ ↓ 三重稀疏架构 多粒度代码数据 长上下文训练 (mHC+Engram+MoE) (AST+项目级) (256K+扩展)

1.2 超长编码提示处理的架构优势

挑战 mHC解决方案 Engram解决方案 协同效应 长程依赖 稳定梯度传播 局部模式检索 注意力专注全局结构 重复模式 分支间信息交换 N-gram快速检索 避免重复计算 API记忆 参数高效利用 静态哈希表存储 快速API调用 项目上下文 深层表示保留 分层知识缓存 跨文件理解

具体优化 :

Engram代码专用配置 :

N-gram阶数扩展:{2,3,4},覆盖代码模式 特殊token处理:保留代码缩进、括号等格式 AST-aware哈希:基于抽象语法树的检索优化

mHC代码特定扩展率 :

分支扩展率n=4→6(代码需要更多并行处理) 残差流形针对代码梯度模式优化

二、V4模型规模与技术参数更新推测

2.1 参数规模调整(基于代码优化需求)

组件 原推测 更新推测 调整原因 总参数 1.75T 1.9-2.2T 增加代码专用容量 Engram内存 400B 600-800B 存储代码库模式、API文档 MoE专家数 55路由 60-70路由 增加代码专业专家 激活参数 80B 90-100B 提升推理能力 上下文长度 256K 512K-1M 支持完整项目

2.2 代码专用架构特性

DeepSeek V4 Code-Enhanced Architecture├── 输入层│ ├── 标准Tokenizer (128K)│ └── 代码专用扩展 (AST tokens, API tokens)├── 核心层 (40层, 推测)│ ├── mHC残差连接 (n=6, 6分支)│ ├── MLA注意力 (40头, 512维)│ ├── Engram代码模块 (L2, L8, L15, L25)│ └── Code-MoE FFN (70专家, 含代码专业专家)├── 输出层│ ├── 标准语言建模头│ └── 代码补全专用头└── 训练优化 ├── 代码专用课程学习 └── 项目级批处理

2.3 代码专家分工推测

专家类型 数量 专业领域 激活策略 语法专家 15 语法解析、格式化 早期激活 API专家 20 API调用、库函数 模式匹配激活 算法专家 15 算法实现、优化 复杂任务激活 架构专家 10 设计模式、架构 高级任务激活 调试专家 5 错误检测、修复 后处理激活 共享专家 2-3 通用能力 始终激活

三、代码能力基准表现预测

3.1 HumanEval/MBPP预测

基准 GPT-4 Turbo Claude 3.5 V3.2 V4预测 提升 HumanEval 87.2% 90.1% 92.3% 96-98% +3.7-5.7pp MBPP 82.5% 85.3% 88.7% 93-95% +4.3-6.3pp CruxEval-i 75.4% 78.2% 81.5% 88-90% +6.5-8.5pp

3.2 长代码上下文评估预测

测试场景 当前SOTA V4预测能力 技术支撑 多文件项目 有限理解 完整项目理解 Engram项目级检索 代码库搜索 简单检索 语义搜索 + 依赖分析 mHC跨文件信息流 API文档整合 外部检索 内置API知识 Engram哈希表存储 实时协作 基础支持 智能冲突解决 MoE多专家协同

3.3 编程推理任务预测

任务类型 V3.2表现 V4预测提升 关键创新 算法设计 较强 显著提升 Engram模式库 + MoE算法专家 代码优化 中等 大幅提升 mHC稳定训练深层优化器 Bug修复 较强 革命性提升 调试专家 + 异常模式Engram 架构设计 有限 突破性提升 架构专家 + 设计模式Engram

四、发布策略与市场定位分析

4.1 发布时间窗口意义

农历新年期间发布的战略考量:

开发者关注度 :假期期间开发者有更多时间测试 媒体曝光 :相对安静的新闻周期,容易获得关注 技术准备 :避开欧美圣诞季,有充足集成时间 市场定位 :展示中国AI在代码领域的领先地位

4.2 竞争格局分析

竞争对手 代码能力 长上下文 发布时间 V4优势 GPT-5 优秀 256K 2025年 更长上下文、更低成本 Claude 3.5 很强 200K 2024年 更好的代码理解 Gemini 3.0 良好 128K 2025年 更优的API集成 CodeLlama 70B 专业 16K 2023年 规模与通用性优势

V4差异化定位 :

成本效率 :通过Engram降低长上下文计算成本 中国开发者生态 :更好的中文代码注释理解 开源友好 :可能延续部分开源策略

4.3 商业化路径推测

API定价策略 :

代码生成:低于GPT-4 Turbo 30-40% 长上下文:按项目计费而非token计费 企业版:支持私有代码库fine-tuning

产品集成 :

Cladue code/Opencode CLI VS Code/IntelliJ插件 GitHub Copilot替代方案 中国本土IDE深度集成

五、技术实现细节深度推测

5.1 训练数据策略更新

代码训练数据构成:├── 公共代码库 (50%)│ ├── GitHub精选项目 (30%)│ ├── 开源框架代码 (15%)│ └── 竞赛解决方案 (5%)├── 代码文档 (20%)│ ├── API文档 (12%)│ ├── 教程代码 (5%)│ └── Stack Overflow片段 (3%)├── 合成数据 (15%)│ ├── 代码变体生成 (8%)│ ├── 错误注入训练 (5%)│ └── 安全测试用例 (2%)└── 项目级数据 (15%) ├── 完整项目仓库 (10%) └── 多文件协作历史 (5%)

5.2 长上下文扩展技术

512K-1M上下文实现方案 :

分层注意力 :

局部窗口:4K tokens,Engram处理 全局摘要:每32K生成摘要,mHC跨层传播 项目记忆:Engram存储项目级模式

记忆压缩 :

代码重复模式压缩率:60-70% API调用序列压缩:哈希索引 注释与代码分离处理

渐进式训练 :

阶段1:16K标准训练 阶段2:128K扩展训练 阶段3:512K+项目级训练

5.3 推理优化推测

优化技术 应用于V4 预期效果 推测解码 代码补全 2-3倍加速 缓存优化 Engram预取 降低延迟40% 批处理优化 代码审查 吞吐量提升50% 量化部署 边缘部署 4bit量化,内存减半

六、潜在风险与技术挑战

6.1 技术集成风险

三重稀疏协调 :

mHC、Engram、MoE的梯度流协调 训练稳定性保障 内存访问冲突避免

长上下文质量 :

512K+上下文的一致性问题 位置编码外推能力 注意力稀疏化效率

代码安全性 :

代码生成的安全漏洞风险 恶意代码检测与防范 知识产权保护机制

6.2 市场竞争风险

追赶者快速跟进 :

OpenAI可能已布局类似技术 开源社区快速复制部分创新 专有技术保护难度

开发者习惯迁移 :

从Copilot迁移成本 生态工具链完善时间 社区认可度建立周期

6.3 工程化挑战

大规模部署 :

2T参数推理集群管理 多租户资源共享 突发流量处理

成本控制 :

训练成本估计:$50-80M 推理成本优化 硬件利用率最大化

七、生态系统影响预测

7.1 开发者工具链变革

V4可能催生的新工具 :

代码库AI助手 :理解整个代码库,提供架构建议 实时协作AI :多开发者协同编程智能辅助 AI驱动的IDE :从编码到部署的全流程智能化 代码安全扫描器 :基于AI的漏洞检测与修复

7.2 软件开发范式演进

从工具到伙伴 :

AI不仅是工具,而是设计伙伴 人类-AI结对编程成为常态 AI负责重复模式,人类专注创新

代码即数据 :

代码库成为AI训练数据源 动态学习团队编码风格 个性化代码生成

质量保证革命 :

AI驱动的自动化测试生成 实时代码审查与优化建议 预测性维护与重构

7.3 对中国AI生态影响

技术领导力展示 :

证明中国在AI前沿领域竞争力 吸引全球开发者关注中国技术 推动中国开源生态建设

产业应用加速 :

企业数字化转型加速 软件外包产业升级 教育体系变革

八、验证时间线与监控指标

8.1 关键验证时间点

时间点 验证内容 预期结果 2026年2月中旬 官方发布 确认架构、规模、基准成绩 发布后1周 社区测评 真实场景代码能力评估 发布后1个月 企业采用 API调用量、用户反馈 2026年Q2 生态建设 插件、工具链完善度

8.2 监控指标建议

技术指标 :

HumanEval/MBPP分数变化 长代码上下文处理质量 推理延迟与成本

市场指标 :

GitHub Copilot市场份额变化 企业采用率增长 开发者社区活跃度

生态指标 :

第三方工具集成数量 开源模型fine-tuning活动 教育机构采用情况

九、总结与战略建议

9.1 核心结论

DeepSeek V4将是一个代码优先、超长上下文、三重稀疏架构的2T参数混合专家模型。其核心创新在于:

架构革命 :mHC稳定训练 + Engram高效检索 + MoE条件计算 代码突破 :512K+项目级理解,超越现有所有竞品 成本优势 :通过稀疏化和硬件协同,实现更低推理成本 中国特色 :更好的中文代码支持,本土生态整合

9.2 战略建议

对于DeepSeek :

差异化定位 :强调代码能力和长上下文,避开通用大模型红海 开发者优先 :提供优秀的开发者体验和丰富的工具链 生态开放 :适度开源,建立开发者社区护城河 成本透明 :清晰的定价策略,吸引中小企业

对于行业观察者 :

关注集成进展 :技术集成难度是主要风险点 测试长上下文 :这是V4的核心卖点,需要重点验证 监控生态建设 :成功与否取决于生态而非单纯技术 评估中国AI进展 :V4是中国AI技术独立性的重要指标

9.3 最终预测置信度

维度 置信度 说明 2月中旬发布 85% 媒体信源可信度高 代码能力突破 80% 技术基础扎实 超长上下文 75% 论文支持但工程挑战大 三重稀疏架构 70% 技术集成复杂度高 2T参数规模 65% 成本考量可能调整

报告更新日期 :2026年1月信息源 :The Information报道 + 学术论文分析分析视角 :技术可行性 + 市场战略待验证假设 :发布时间、具体参数、基准成绩

技术推测基于公开信息,实际产品以官方发布为准。中国AI发展迅速,V4可能带来更多惊喜。

?期待Deepseek V4 编程有显著突破

看到圈内发现MLA代码库出现MODEL这样的信息,看来离发布快了

V32_FP8Sparse = 1MODEL1_FP8Sparse = 2, FP8KVCacheLayout.V32_FP8Sparse: (576, 512, 64, 128, 4),FP8KVCacheLayout.MODEL1_FP8Sparse: (512, 448, 64, 64, 7)

? 摘要

基于The Information独家报道(2026年2月中旬发布窗口)与学术论文技术分析,DeepSeek V4将是一个代码优先的超大规模混合专家模型 。核心创新在于三重稀疏架构的深度融合,特别是在超长代码上下文处理和编程推理能力方面实现革命性突破。

关键时间线与里程碑 :

2025年12月 :V3.2发布,在某些基准超越GPT-5 2026年1月 :mHC、Engram论文预印本发布 2026年2月中旬 :V4发布(农历新年期间) 技术准备度 :论文显示技术已成熟,集成窗口合理

一、代码能力突破的技术基础分析

1.1 代码能力的多维度支撑

代码能力 = 架构优化 + 数据策略 + 训练技术 ↓ ↓ ↓ 三重稀疏架构 多粒度代码数据 长上下文训练 (mHC+Engram+MoE) (AST+项目级) (256K+扩展)

1.2 超长编码提示处理的架构优势

挑战 mHC解决方案 Engram解决方案 协同效应 长程依赖 稳定梯度传播 局部模式检索 注意力专注全局结构 重复模式 分支间信息交换 N-gram快速检索 避免重复计算 API记忆 参数高效利用 静态哈希表存储 快速API调用 项目上下文 深层表示保留 分层知识缓存 跨文件理解

具体优化 :

Engram代码专用配置 :

N-gram阶数扩展:{2,3,4},覆盖代码模式 特殊token处理:保留代码缩进、括号等格式 AST-aware哈希:基于抽象语法树的检索优化

mHC代码特定扩展率 :

分支扩展率n=4→6(代码需要更多并行处理) 残差流形针对代码梯度模式优化

二、V4模型规模与技术参数更新推测

2.1 参数规模调整(基于代码优化需求)

组件 原推测 更新推测 调整原因 总参数 1.75T 1.9-2.2T 增加代码专用容量 Engram内存 400B 600-800B 存储代码库模式、API文档 MoE专家数 55路由 60-70路由 增加代码专业专家 激活参数 80B 90-100B 提升推理能力 上下文长度 256K 512K-1M 支持完整项目

2.2 代码专用架构特性

DeepSeek V4 Code-Enhanced Architecture├── 输入层│ ├── 标准Tokenizer (128K)│ └── 代码专用扩展 (AST tokens, API tokens)├── 核心层 (40层, 推测)│ ├── mHC残差连接 (n=6, 6分支)│ ├── MLA注意力 (40头, 512维)│ ├── Engram代码模块 (L2, L8, L15, L25)│ └── Code-MoE FFN (70专家, 含代码专业专家)├── 输出层│ ├── 标准语言建模头│ └── 代码补全专用头└── 训练优化 ├── 代码专用课程学习 └── 项目级批处理

2.3 代码专家分工推测

专家类型 数量 专业领域 激活策略 语法专家 15 语法解析、格式化 早期激活 API专家 20 API调用、库函数 模式匹配激活 算法专家 15 算法实现、优化 复杂任务激活 架构专家 10 设计模式、架构 高级任务激活 调试专家 5 错误检测、修复 后处理激活 共享专家 2-3 通用能力 始终激活

三、代码能力基准表现预测

3.1 HumanEval/MBPP预测

基准 GPT-4 Turbo Claude 3.5 V3.2 V4预测 提升 HumanEval 87.2% 90.1% 92.3% 96-98% +3.7-5.7pp MBPP 82.5% 85.3% 88.7% 93-95% +4.3-6.3pp CruxEval-i 75.4% 78.2% 81.5% 88-90% +6.5-8.5pp

3.2 长代码上下文评估预测

测试场景 当前SOTA V4预测能力 技术支撑 多文件项目 有限理解 完整项目理解 Engram项目级检索 代码库搜索 简单检索 语义搜索 + 依赖分析 mHC跨文件信息流 API文档整合 外部检索 内置API知识 Engram哈希表存储 实时协作 基础支持 智能冲突解决 MoE多专家协同

3.3 编程推理任务预测

任务类型 V3.2表现 V4预测提升 关键创新 算法设计 较强 显著提升 Engram模式库 + MoE算法专家 代码优化 中等 大幅提升 mHC稳定训练深层优化器 Bug修复 较强 革命性提升 调试专家 + 异常模式Engram 架构设计 有限 突破性提升 架构专家 + 设计模式Engram

四、发布策略与市场定位分析

4.1 发布时间窗口意义

农历新年期间发布的战略考量:

开发者关注度 :假期期间开发者有更多时间测试 媒体曝光 :相对安静的新闻周期,容易获得关注 技术准备 :避开欧美圣诞季,有充足集成时间 市场定位 :展示中国AI在代码领域的领先地位

4.2 竞争格局分析

竞争对手 代码能力 长上下文 发布时间 V4优势 GPT-5 优秀 256K 2025年 更长上下文、更低成本 Claude 3.5 很强 200K 2024年 更好的代码理解 Gemini 3.0 良好 128K 2025年 更优的API集成 CodeLlama 70B 专业 16K 2023年 规模与通用性优势

V4差异化定位 :

成本效率 :通过Engram降低长上下文计算成本 中国开发者生态 :更好的中文代码注释理解 开源友好 :可能延续部分开源策略

4.3 商业化路径推测

API定价策略 :

代码生成:低于GPT-4 Turbo 30-40% 长上下文:按项目计费而非token计费 企业版:支持私有代码库fine-tuning

产品集成 :

Cladue code/Opencode CLI VS Code/IntelliJ插件 GitHub Copilot替代方案 中国本土IDE深度集成

五、技术实现细节深度推测

5.1 训练数据策略更新

代码训练数据构成:├── 公共代码库 (50%)│ ├── GitHub精选项目 (30%)│ ├── 开源框架代码 (15%)│ └── 竞赛解决方案 (5%)├── 代码文档 (20%)│ ├── API文档 (12%)│ ├── 教程代码 (5%)│ └── Stack Overflow片段 (3%)├── 合成数据 (15%)│ ├── 代码变体生成 (8%)│ ├── 错误注入训练 (5%)│ └── 安全测试用例 (2%)└── 项目级数据 (15%) ├── 完整项目仓库 (10%) └── 多文件协作历史 (5%)

5.2 长上下文扩展技术

512K-1M上下文实现方案 :

分层注意力 :

局部窗口:4K tokens,Engram处理 全局摘要:每32K生成摘要,mHC跨层传播 项目记忆:Engram存储项目级模式

记忆压缩 :

代码重复模式压缩率:60-70% API调用序列压缩:哈希索引 注释与代码分离处理

渐进式训练 :

阶段1:16K标准训练 阶段2:128K扩展训练 阶段3:512K+项目级训练

5.3 推理优化推测

优化技术 应用于V4 预期效果 推测解码 代码补全 2-3倍加速 缓存优化 Engram预取 降低延迟40% 批处理优化 代码审查 吞吐量提升50% 量化部署 边缘部署 4bit量化,内存减半

六、潜在风险与技术挑战

6.1 技术集成风险

三重稀疏协调 :

mHC、Engram、MoE的梯度流协调 训练稳定性保障 内存访问冲突避免

长上下文质量 :

512K+上下文的一致性问题 位置编码外推能力 注意力稀疏化效率

代码安全性 :

代码生成的安全漏洞风险 恶意代码检测与防范 知识产权保护机制

6.2 市场竞争风险

追赶者快速跟进 :

OpenAI可能已布局类似技术 开源社区快速复制部分创新 专有技术保护难度

开发者习惯迁移 :

从Copilot迁移成本 生态工具链完善时间 社区认可度建立周期

6.3 工程化挑战

大规模部署 :

2T参数推理集群管理 多租户资源共享 突发流量处理

成本控制 :

训练成本估计:$50-80M 推理成本优化 硬件利用率最大化

七、生态系统影响预测

7.1 开发者工具链变革

V4可能催生的新工具 :

代码库AI助手 :理解整个代码库,提供架构建议 实时协作AI :多开发者协同编程智能辅助 AI驱动的IDE :从编码到部署的全流程智能化 代码安全扫描器 :基于AI的漏洞检测与修复

7.2 软件开发范式演进

从工具到伙伴 :

AI不仅是工具,而是设计伙伴 人类-AI结对编程成为常态 AI负责重复模式,人类专注创新

代码即数据 :

代码库成为AI训练数据源 动态学习团队编码风格 个性化代码生成

质量保证革命 :

AI驱动的自动化测试生成 实时代码审查与优化建议 预测性维护与重构

7.3 对中国AI生态影响

技术领导力展示 :

证明中国在AI前沿领域竞争力 吸引全球开发者关注中国技术 推动中国开源生态建设

产业应用加速 :

企业数字化转型加速 软件外包产业升级 教育体系变革

八、验证时间线与监控指标

8.1 关键验证时间点

时间点 验证内容 预期结果 2026年2月中旬 官方发布 确认架构、规模、基准成绩 发布后1周 社区测评 真实场景代码能力评估 发布后1个月 企业采用 API调用量、用户反馈 2026年Q2 生态建设 插件、工具链完善度

8.2 监控指标建议

技术指标 :

HumanEval/MBPP分数变化 长代码上下文处理质量 推理延迟与成本

市场指标 :

GitHub Copilot市场份额变化 企业采用率增长 开发者社区活跃度

生态指标 :

第三方工具集成数量 开源模型fine-tuning活动 教育机构采用情况

九、总结与战略建议

9.1 核心结论

DeepSeek V4将是一个代码优先、超长上下文、三重稀疏架构的2T参数混合专家模型。其核心创新在于:

架构革命 :mHC稳定训练 + Engram高效检索 + MoE条件计算 代码突破 :512K+项目级理解,超越现有所有竞品 成本优势 :通过稀疏化和硬件协同,实现更低推理成本 中国特色 :更好的中文代码支持,本土生态整合

9.2 战略建议

对于DeepSeek :

差异化定位 :强调代码能力和长上下文,避开通用大模型红海 开发者优先 :提供优秀的开发者体验和丰富的工具链 生态开放 :适度开源,建立开发者社区护城河 成本透明 :清晰的定价策略,吸引中小企业

对于行业观察者 :

关注集成进展 :技术集成难度是主要风险点 测试长上下文 :这是V4的核心卖点,需要重点验证 监控生态建设 :成功与否取决于生态而非单纯技术 评估中国AI进展 :V4是中国AI技术独立性的重要指标

9.3 最终预测置信度

维度 置信度 说明 2月中旬发布 85% 媒体信源可信度高 代码能力突破 80% 技术基础扎实 超长上下文 75% 论文支持但工程挑战大 三重稀疏架构 70% 技术集成复杂度高 2T参数规模 65% 成本考量可能调整

报告更新日期 :2026年1月信息源 :The Information报道 + 学术论文分析分析视角 :技术可行性 + 市场战略待验证假设 :发布时间、具体参数、基准成绩

技术推测基于公开信息,实际产品以官方发布为准。中国AI发展迅速,V4可能带来更多惊喜。

?期待Deepseek V4 编程有显著突破

看到圈内发现MLA代码库出现MODEL这样的信息,看来离发布快了

V32_FP8Sparse = 1MODEL1_FP8Sparse = 2,FP8KVCacheLayout.V32_FP8Sparse: (576, 512, 64, 128, 4),FP8KVCacheLayout.MODEL1_FP8Sparse: (512, 448, 64, 64, 7)

? 摘要

基于The Information独家报道(2026年2月中旬发布窗口)与学术论文技术分析,DeepSeek V4将是一个代码优先的超大规模混合专家模型 。核心创新在于三重稀疏架构的深度融合,特别是在超长代码上下文处理和编程推理能力方面实现革命性突破。

关键时间线与里程碑 :

2025年12月 :V3.2发布,在某些基准超越GPT-5 2026年1月 :mHC、Engram论文预印本发布 2026年2月中旬 :V4发布(农历新年期间) 技术准备度 :论文显示技术已成熟,集成窗口合理

一、代码能力突破的技术基础分析

1.1 代码能力的多维度支撑

代码能力 = 架构优化 + 数据策略 + 训练技术 ↓ ↓ ↓ 三重稀疏架构 多粒度代码数据 长上下文训练 (mHC+Engram+MoE) (AST+项目级) (256K+扩展)1.2 超长编码提示处理的架构优势

| 长程依赖 | |||

| 重复模式 | |||

| API记忆 | |||

| 项目上下文 |

具体优化 :

Engram代码专用配置 :

N-gram阶数扩展:{2,3,4},覆盖代码模式 特殊token处理:保留代码缩进、括号等格式 AST-aware哈希:基于抽象语法树的检索优化 mHC代码特定扩展率 :

分支扩展率n=4→6(代码需要更多并行处理) 残差流形针对代码梯度模式优化

二、V4模型规模与技术参数更新推测

2.1 参数规模调整(基于代码优化需求)

| 总参数 | 1.9-2.2T | ||

| Engram内存 | 600-800B | ||

| MoE专家数 | 60-70路由 | ||

| 激活参数 | 90-100B | ||

| 上下文长度 | 512K-1M |

2.2 代码专用架构特性

DeepSeek V4 Code-Enhanced Architecture├── 输入层│ ├── 标准Tokenizer (128K)│ └── 代码专用扩展 (AST tokens, API tokens)├── 核心层 (40层, 推测)│ ├── mHC残差连接 (n=6, 6分支)│ ├── MLA注意力 (40头, 512维)│ ├── Engram代码模块 (L2, L8, L15, L25)│ └── Code-MoE FFN (70专家, 含代码专业专家)├── 输出层│ ├── 标准语言建模头│ └── 代码补全专用头└── 训练优化 ├── 代码专用课程学习 └── 项目级批处理2.3 代码专家分工推测

| 语法专家 | |||

| API专家 | |||

| 算法专家 | |||

| 架构专家 | |||

| 调试专家 | |||

| 共享专家 |

三、代码能力基准表现预测

3.1 HumanEval/MBPP预测

| V4预测 | |||||

|---|---|---|---|---|---|

| 96-98% | |||||

| 93-95% | |||||

| 88-90% |

3.2 长代码上下文评估预测

| 多文件项目 | |||

| 代码库搜索 | |||

| API文档整合 | |||

| 实时协作 |

3.3 编程推理任务预测

| 算法设计 | |||

| 代码优化 | |||

| Bug修复 | |||

| 架构设计 |

四、发布策略与市场定位分析

4.1 发布时间窗口意义

农历新年期间发布的战略考量:

开发者关注度 :假期期间开发者有更多时间测试 媒体曝光 :相对安静的新闻周期,容易获得关注 技术准备 :避开欧美圣诞季,有充足集成时间 市场定位 :展示中国AI在代码领域的领先地位

4.2 竞争格局分析

| GPT-5 | ||||

| Claude 3.5 | ||||

| Gemini 3.0 | ||||

| CodeLlama 70B |

V4差异化定位 :

成本效率 :通过Engram降低长上下文计算成本 中国开发者生态 :更好的中文代码注释理解 开源友好 :可能延续部分开源策略

4.3 商业化路径推测

API定价策略 :

代码生成:低于GPT-4 Turbo 30-40% 长上下文:按项目计费而非token计费 企业版:支持私有代码库fine-tuning 产品集成 :

Cladue code/Opencode CLI VS Code/IntelliJ插件 GitHub Copilot替代方案 中国本土IDE深度集成

五、技术实现细节深度推测

5.1 训练数据策略更新

代码训练数据构成:├── 公共代码库 (50%)│ ├── GitHub精选项目 (30%)│ ├── 开源框架代码 (15%)│ └── 竞赛解决方案 (5%)├── 代码文档 (20%)│ ├── API文档 (12%)│ ├── 教程代码 (5%)│ └── Stack Overflow片段 (3%)├── 合成数据 (15%)│ ├── 代码变体生成 (8%)│ ├── 错误注入训练 (5%)│ └── 安全测试用例 (2%)└── 项目级数据 (15%) ├── 完整项目仓库 (10%) └── 多文件协作历史 (5%)5.2 长上下文扩展技术

512K-1M上下文实现方案 :

分层注意力 :

局部窗口:4K tokens,Engram处理 全局摘要:每32K生成摘要,mHC跨层传播 项目记忆:Engram存储项目级模式 记忆压缩 :

代码重复模式压缩率:60-70% API调用序列压缩:哈希索引 注释与代码分离处理 渐进式训练 :

阶段1:16K标准训练 阶段2:128K扩展训练 阶段3:512K+项目级训练

5.3 推理优化推测

| 推测解码 | ||

| 缓存优化 | ||

| 批处理优化 | ||

| 量化部署 |

六、潜在风险与技术挑战

6.1 技术集成风险

三重稀疏协调 :

mHC、Engram、MoE的梯度流协调 训练稳定性保障 内存访问冲突避免 长上下文质量 :

512K+上下文的一致性问题 位置编码外推能力 注意力稀疏化效率 代码安全性 :

代码生成的安全漏洞风险 恶意代码检测与防范 知识产权保护机制

6.2 市场竞争风险

追赶者快速跟进 :

OpenAI可能已布局类似技术 开源社区快速复制部分创新 专有技术保护难度 开发者习惯迁移 :

从Copilot迁移成本 生态工具链完善时间 社区认可度建立周期

6.3 工程化挑战

大规模部署 :

2T参数推理集群管理 多租户资源共享 突发流量处理 成本控制 :

训练成本估计:$50-80M 推理成本优化 硬件利用率最大化

七、生态系统影响预测

7.1 开发者工具链变革

V4可能催生的新工具 :

代码库AI助手 :理解整个代码库,提供架构建议 实时协作AI :多开发者协同编程智能辅助 AI驱动的IDE :从编码到部署的全流程智能化 代码安全扫描器 :基于AI的漏洞检测与修复

7.2 软件开发范式演进

从工具到伙伴 :

AI不仅是工具,而是设计伙伴 人类-AI结对编程成为常态 AI负责重复模式,人类专注创新 代码即数据 :

代码库成为AI训练数据源 动态学习团队编码风格 个性化代码生成 质量保证革命 :

AI驱动的自动化测试生成 实时代码审查与优化建议 预测性维护与重构

7.3 对中国AI生态影响

技术领导力展示 :

证明中国在AI前沿领域竞争力 吸引全球开发者关注中国技术 推动中国开源生态建设 产业应用加速 :

企业数字化转型加速 软件外包产业升级 教育体系变革

八、验证时间线与监控指标

8.1 关键验证时间点

| 2026年2月中旬 | ||

| 发布后1周 | ||

| 发布后1个月 | ||

| 2026年Q2 |

8.2 监控指标建议

技术指标 :

HumanEval/MBPP分数变化 长代码上下文处理质量 推理延迟与成本 市场指标 :

GitHub Copilot市场份额变化 企业采用率增长 开发者社区活跃度 生态指标 :

第三方工具集成数量 开源模型fine-tuning活动 教育机构采用情况

九、总结与战略建议

9.1 核心结论

DeepSeek V4将是一个代码优先、超长上下文、三重稀疏架构的2T参数混合专家模型。其核心创新在于:

架构革命 :mHC稳定训练 + Engram高效检索 + MoE条件计算 代码突破 :512K+项目级理解,超越现有所有竞品 成本优势 :通过稀疏化和硬件协同,实现更低推理成本 中国特色 :更好的中文代码支持,本土生态整合

9.2 战略建议

对于DeepSeek :

差异化定位 :强调代码能力和长上下文,避开通用大模型红海 开发者优先 :提供优秀的开发者体验和丰富的工具链 生态开放 :适度开源,建立开发者社区护城河 成本透明 :清晰的定价策略,吸引中小企业

对于行业观察者 :

关注集成进展 :技术集成难度是主要风险点 测试长上下文 :这是V4的核心卖点,需要重点验证 监控生态建设 :成功与否取决于生态而非单纯技术 评估中国AI进展 :V4是中国AI技术独立性的重要指标

9.3 最终预测置信度

| 2月中旬发布 | ||

| 代码能力突破 | ||

| 超长上下文 | ||

| 三重稀疏架构 | ||

| 2T参数规模 |

报告更新日期 :2026年1月信息源 :The Information报道 + 学术论文分析分析视角 :技术可行性 + 市场战略待验证假设 :发布时间、具体参数、基准成绩

技术推测基于公开信息,实际产品以官方发布为准。中国AI发展迅速,V4可能带来更多惊喜。

https://github.com/deepseek-ai/Engram

做小朋友也能听懂的人工智能

做文科生也能用的人工智能

做理科生也有启发的人工智能

做研究员也能看的人工智能

进一步了解智能体,可以关注我的新作品《Ai Agent实战指南》

进一步了解智能体,可以关注我的新作品《Ai Agent实战指南》