第一部分:生成式AI快速发展,技术奇点有望到来

第二部分:技术创新百花齐放,海外巨头引领创新

第三部分:风险提示

1.1发展历程:算法模型持续迭代,AI行业快速发展

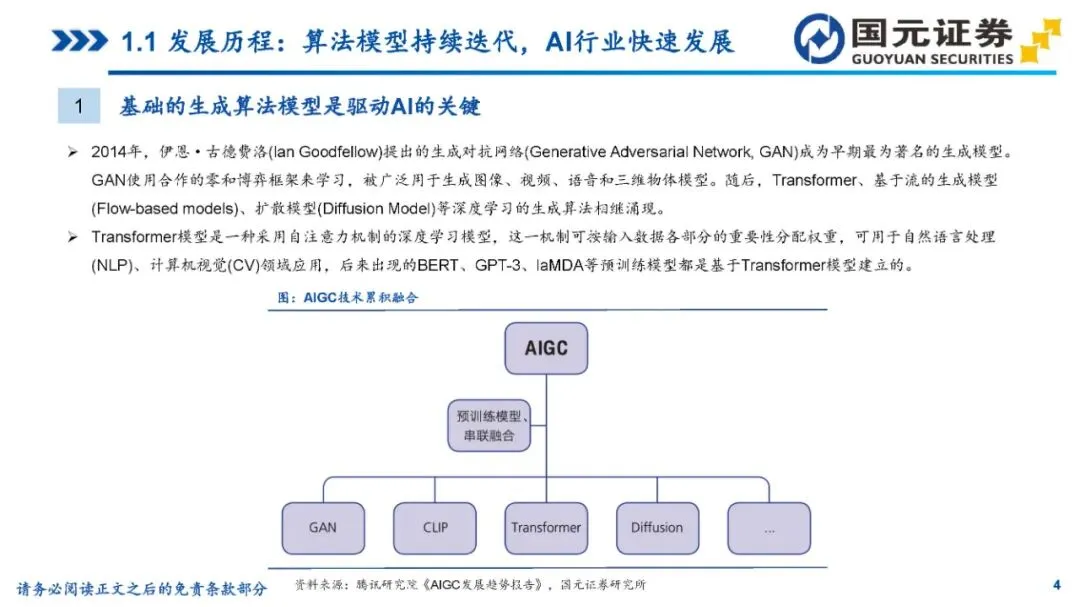

1基础的生成算法模型是驱动AI的关键

2014年,伊恩·古德费洛(lanGoodfellow)提出的生成对抗网络(GenerativeAdversarialNetwork,GAN)成为早期最为著名的生成模型。GAN使用合作的零和博弈框架来学习,被广泛用于生成图像、视频、语音和三维物体模型。随后,Transformer、基于流的生成模型(Flow-basedmodels)、扩散模型(DiffusionModel)等深度学习的生成算法相继涌现。

Transformer模型是一种采用自注意力机制的深度学习模型,这一机制可按输入数据各部分的重要性分配权重,可用于自然语言处理(NLP)、计算机视觉(CV)领域应用,后来出现的BERT、GPT-3、laMDA等预训练模型都是基于Transformer模型建立的。

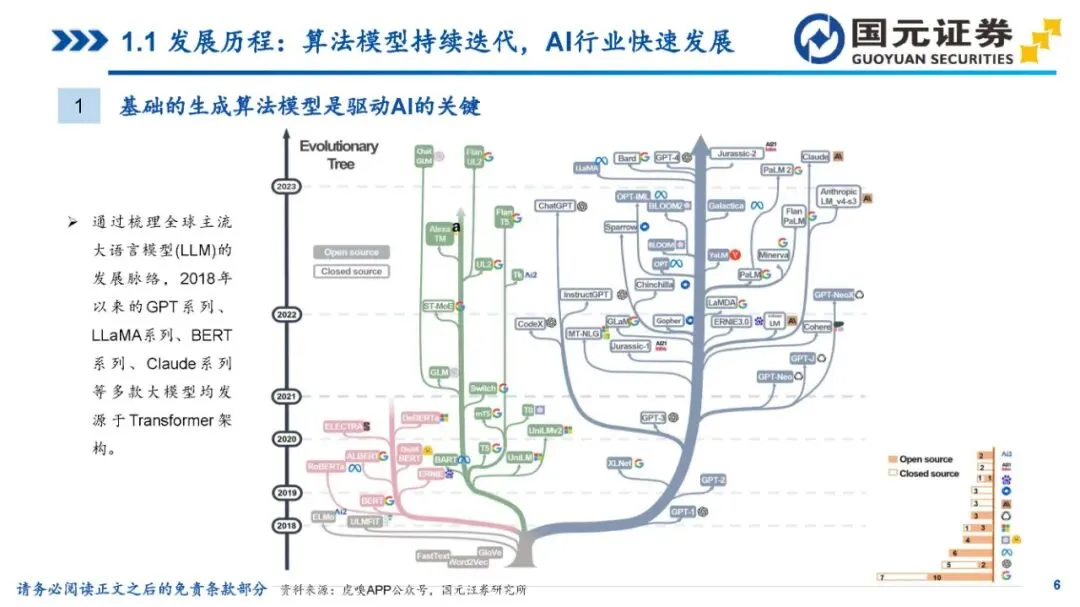

通过梳理全球主流大语言模型(LLM)的发展脉络,2018年以来的GPT系列、LLaMA系列、BERT系列、Claude系列等多款大模型均发源于Transformer架构。

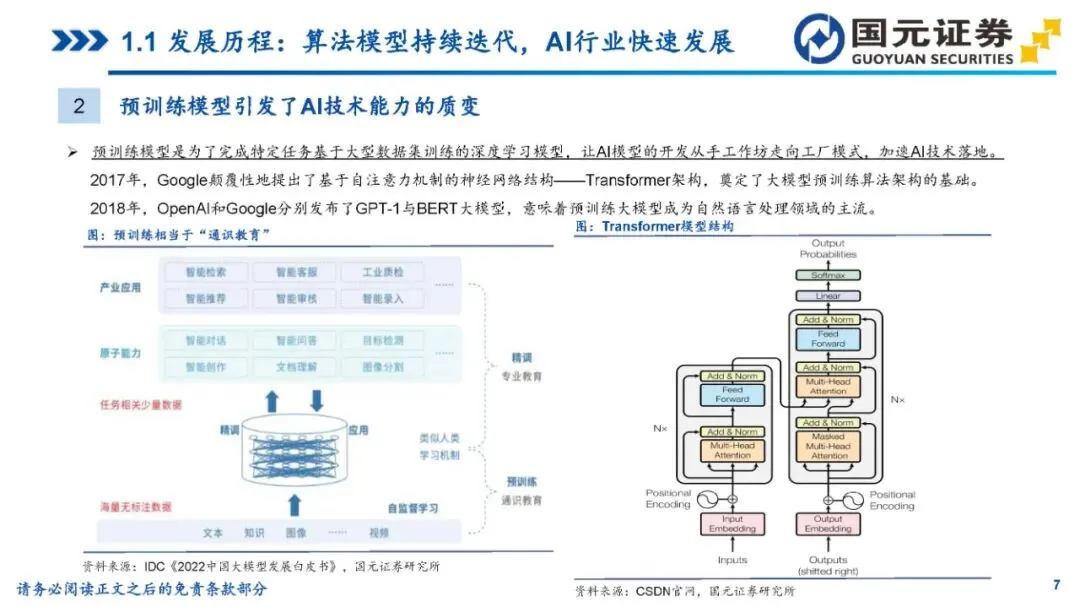

2预训练模型引发了AI技术能力的质变

预训练模型是为了完成特定任务基于大型数据集训练的深度学习模型,让AI模型的开发从手工作坊走向工厂模式,加速AI技术落地。

2017年,Google颠覆性地提出了基于自注意力机制的神经网络结构——Transformer架构,奠定了大模型预训练算法架构的基础。

2018年,OpenAI和Google分别发布了GPT-1与BERT大模型,意味着预训练大模型成为自然语言处理领域的主流。

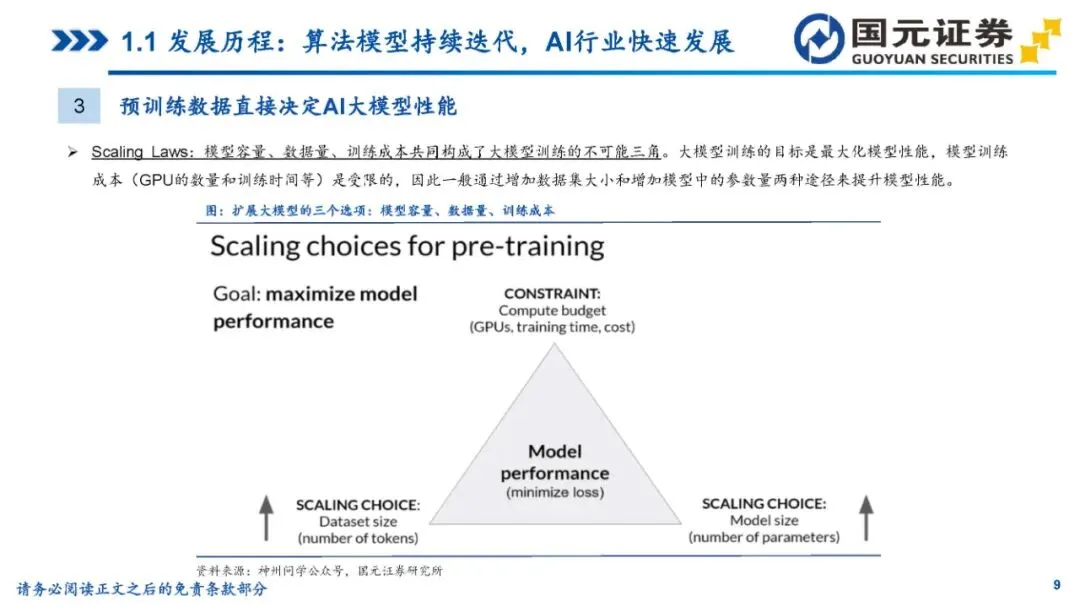

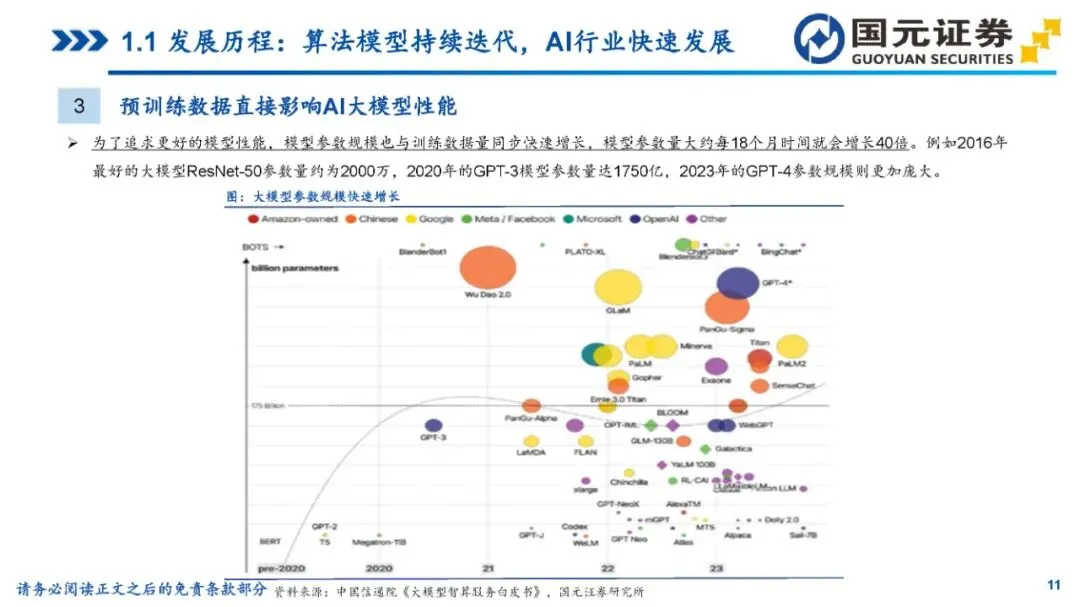

3预训练数据直接决定AI大模型性能

ScalingLaws:模型容量、数据量、训练成本共同构成了大模型训练的不可能三角。大模型训练的目标是最大化模型性能,模型训练成本(GPU的数量和训练时间等)是受限的,因此一般通过增加数据集大小和增加模型中的参数量两种途径来提升模型性能。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复或发消息“GAI47” 就可以获取《生成式人工智能行业专题研究:海外大模型篇:生成式AI加速创新,行业迎历史性机遇》专知下载链接

点击“阅读原文”,了解使用专知,查看获取100000+AI主题知识资料