LLM 天生无状态,每次对话都是全新开始。要让 AI 代理“拥有记忆”,核心挑战不是写入信息,而是如何判断何时应该忘记、如何忘得恰当。Leonie 的文章系统梳理了记忆类型与管理方法,并指出“遗忘”才是代理系统设计的真正难关。

核心亮点

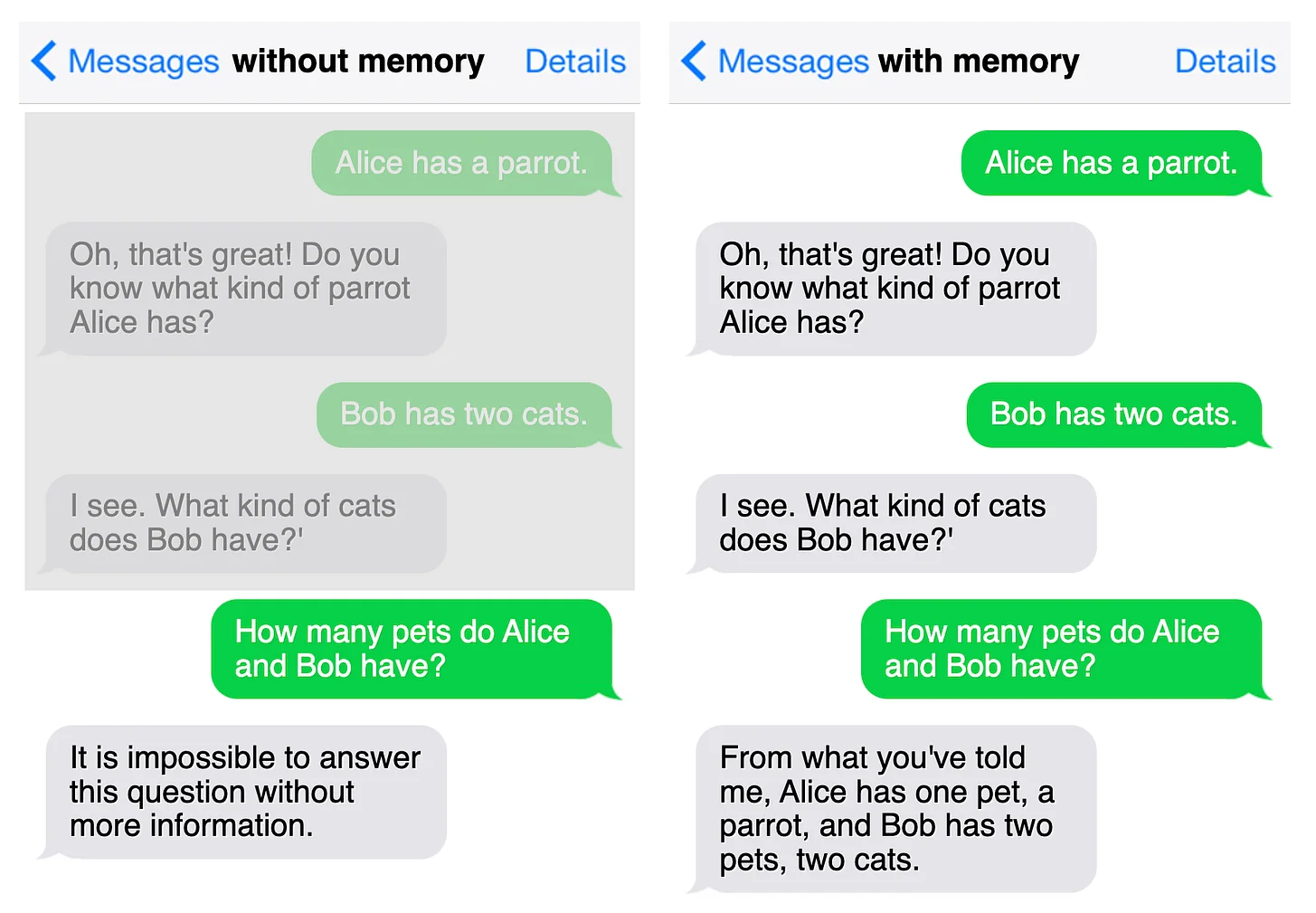

1. LLM 无状态,是代理记忆问题的根源

模型既不保留五分钟前的聊天,也不会自动为用户建立长期档案,一切记忆都必须人为搭建与管理。

2. 两大类记忆:短期 vs 长期

短期记忆:当前上下文窗口内的对话

长期记忆:外部数据库中的用户偏好、历史事件、知识等

3. 不同框架对记忆有不同划分

CoALA(类人认知模型):

工作记忆

语义记忆

情景记忆

程序记忆

Letta(架构导向):

消息缓冲

核心记忆

回忆记忆

档案记忆

这些框架强调不同层级的“信息保持方式”,反映现实中代理任务的多样性。

4. 最难的是“智能遗忘”

判断哪些信息已过时、哪些仍相关,是所有记忆系统的最大挑战。忘记不是简单清空,而是动态决策。

5. 记忆管理是一个完整循环

文章总结了记忆的四个关键动作:生成、存储、检索、更新/删除。 每一步都可能影响代理的一致性、个性化和行为可靠性。

6. 业界经验:让代理自己决定何时删除

相比复杂衰减函数,许多社区专家更认可“让模型自己判断记忆价值”,再决定是否丢弃。

7. 忘记不仅是技术问题,还涉及场景与隐私

记忆关乎

时间(何时仍相关)

情境(是否适用当前任务)

价值(对用户是否重要) 加上 GDPR“被遗忘权”等要求,使删除机制更具挑战。

8. 多个新兴记忆框架正在尝试解决

mem0、Letta、zep 等项目逐渐形成行业工具链,为代理构建长期记忆提供可复用基础。

全文请于下方附件处下载

#agent #记忆系统 #AI架构 #小红书可以发文件了 #长期记忆 #上下文管理 #Agent设计 #大模型应用 #AI系统设计 #人工智能趋势

核心亮点

1. LLM 无状态,是代理记忆问题的根源

模型既不保留五分钟前的聊天,也不会自动为用户建立长期档案,一切记忆都必须人为搭建与管理。

2. 两大类记忆:短期 vs 长期

短期记忆:当前上下文窗口内的对话

长期记忆:外部数据库中的用户偏好、历史事件、知识等

3. 不同框架对记忆有不同划分

CoALA(类人认知模型):

工作记忆

语义记忆

情景记忆

程序记忆

Letta(架构导向):

消息缓冲

核心记忆

回忆记忆

档案记忆

这些框架强调不同层级的“信息保持方式”,反映现实中代理任务的多样性。

4. 最难的是“智能遗忘”

判断哪些信息已过时、哪些仍相关,是所有记忆系统的最大挑战。忘记不是简单清空,而是动态决策。

5. 记忆管理是一个完整循环

文章总结了记忆的四个关键动作:生成、存储、检索、更新/删除。 每一步都可能影响代理的一致性、个性化和行为可靠性。

6. 业界经验:让代理自己决定何时删除

相比复杂衰减函数,许多社区专家更认可“让模型自己判断记忆价值”,再决定是否丢弃。

7. 忘记不仅是技术问题,还涉及场景与隐私

记忆关乎

时间(何时仍相关)

情境(是否适用当前任务)

价值(对用户是否重要) 加上 GDPR“被遗忘权”等要求,使删除机制更具挑战。

8. 多个新兴记忆框架正在尝试解决

mem0、Letta、zep 等项目逐渐形成行业工具链,为代理构建长期记忆提供可复用基础。

全文请于下方附件处下载

#agent #记忆系统 #AI架构 #小红书可以发文件了 #长期记忆 #上下文管理 #Agent设计 #大模型应用 #AI系统设计 #人工智能趋势