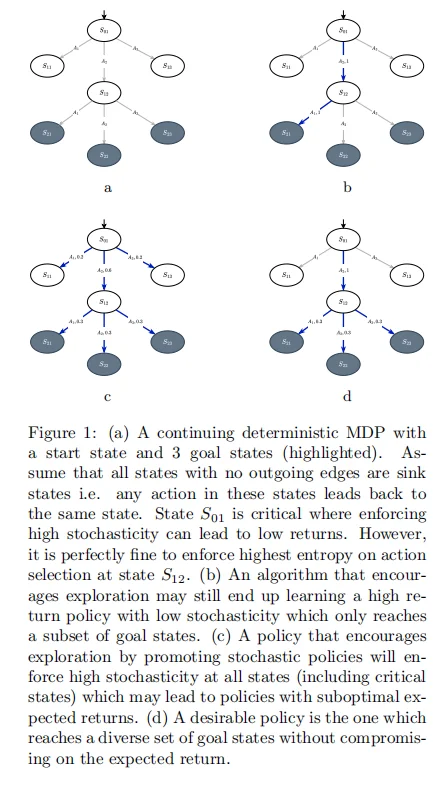

DeepMind最新研究《Dense and Diverse Goal Coverage in Multi Goal Reinforcement Learning》提出一种全新算法——DDGC(Dense & Diverse Goal Coverage),突破了传统强化学习在多目标场景中“高回报但低多样性”的局限。它能在保持高收益的同时,实现对多个目标状态的均衡覆盖,极大提升策略的鲁棒性与泛化能力。

核心亮点:

新目标函数设计:将“回报最大化”与“目标多样性”统一为一个可优化的目标函数 Z(π)=Jγ(π)+IS+(π)Z(\\pi)=J_\\gamma(\\pi)+I_{S+}(\\pi)Z(π)=Jγ(π)+IS+(π),兼顾回报与目标分布均匀性。

基于Frank–Wolfe框架:采用凸优化思路迭代更新策略混合,保证算法收敛性与可解释性。

自适应奖励机制:为稀疏目标设计自定义奖励 r(s)=1−d^(s)r(s)=1-d̂(s)r(s)=1−d^(s),使算法优先探索访问频率低的目标。

离线RL子例程集成:每步通过Fitted Q Iteration(FQI)更新策略,理论上提供 O(1/K)O(1/K)O(1/K) 的收敛界。

理论保障完善:提供严格性能上界与收敛性证明,误差来源(近似误差、采样误差)均被形式化量化。

支持连续空间扩展:结合连续版FQI(Fitted Actor-Critic)及离散化估计,适用于复杂机器人控制环境。

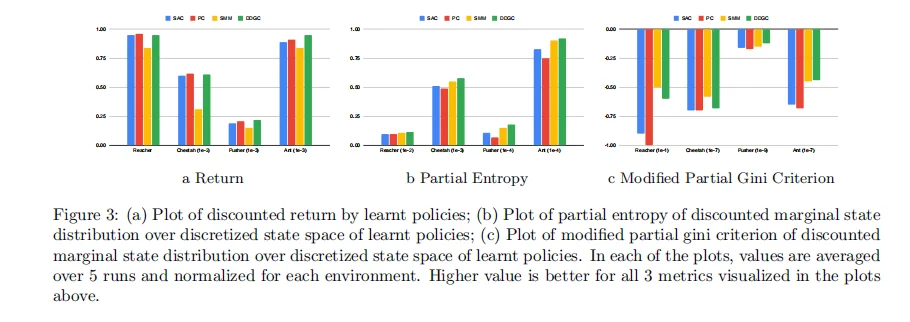

经验验证优越:在Reacher、Pusher、Ant、HalfCheetah等标准环境中,DDGC在“回报”与“目标多样性”两项指标上均优于SAC、SMM等基线。

应用场景 / 用户反馈 / 实验结果: 适用于多目标强化学习、机器人控制、自动探索、分子结构发现等需要多样目标覆盖的场景。 实验表明:

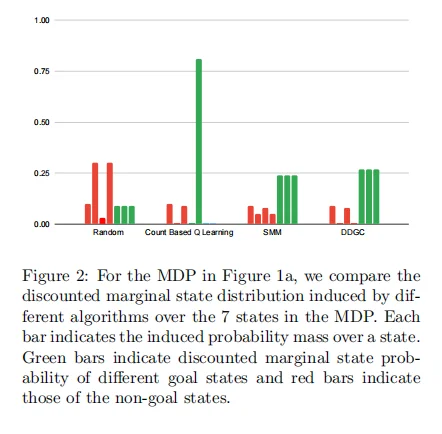

在合成MDP中,DDGC能在多个目标状态上实现近乎均匀分布;

在Brax多目标基准中,DDGC在保持高回报的同时实现最高“部分熵”和“Gini多样性”分数;

相比SAC仅聚焦单一路径,DDGC显著提升策略稳健性与泛化能力。

? 论文:arXiv:2510.25311v1

#强化学习 #DeepMind #多目标优化 #探索算法 #机器人控制 #AI研究 #分布式 #离线学习 #机器智能 #谷歌

核心亮点:

新目标函数设计:将“回报最大化”与“目标多样性”统一为一个可优化的目标函数 Z(π)=Jγ(π)+IS+(π)Z(\\pi)=J_\\gamma(\\pi)+I_{S+}(\\pi)Z(π)=Jγ(π)+IS+(π),兼顾回报与目标分布均匀性。

基于Frank–Wolfe框架:采用凸优化思路迭代更新策略混合,保证算法收敛性与可解释性。

自适应奖励机制:为稀疏目标设计自定义奖励 r(s)=1−d^(s)r(s)=1-d̂(s)r(s)=1−d^(s),使算法优先探索访问频率低的目标。

离线RL子例程集成:每步通过Fitted Q Iteration(FQI)更新策略,理论上提供 O(1/K)O(1/K)O(1/K) 的收敛界。

理论保障完善:提供严格性能上界与收敛性证明,误差来源(近似误差、采样误差)均被形式化量化。

支持连续空间扩展:结合连续版FQI(Fitted Actor-Critic)及离散化估计,适用于复杂机器人控制环境。

经验验证优越:在Reacher、Pusher、Ant、HalfCheetah等标准环境中,DDGC在“回报”与“目标多样性”两项指标上均优于SAC、SMM等基线。

应用场景 / 用户反馈 / 实验结果: 适用于多目标强化学习、机器人控制、自动探索、分子结构发现等需要多样目标覆盖的场景。 实验表明:

在合成MDP中,DDGC能在多个目标状态上实现近乎均匀分布;

在Brax多目标基准中,DDGC在保持高回报的同时实现最高“部分熵”和“Gini多样性”分数;

相比SAC仅聚焦单一路径,DDGC显著提升策略稳健性与泛化能力。

? 论文:arXiv:2510.25311v1

#强化学习 #DeepMind #多目标优化 #探索算法 #机器人控制 #AI研究 #分布式 #离线学习 #机器智能 #谷歌