вңЁ MeasureBenchжҳҜд»Җд№Ҳпјҹ

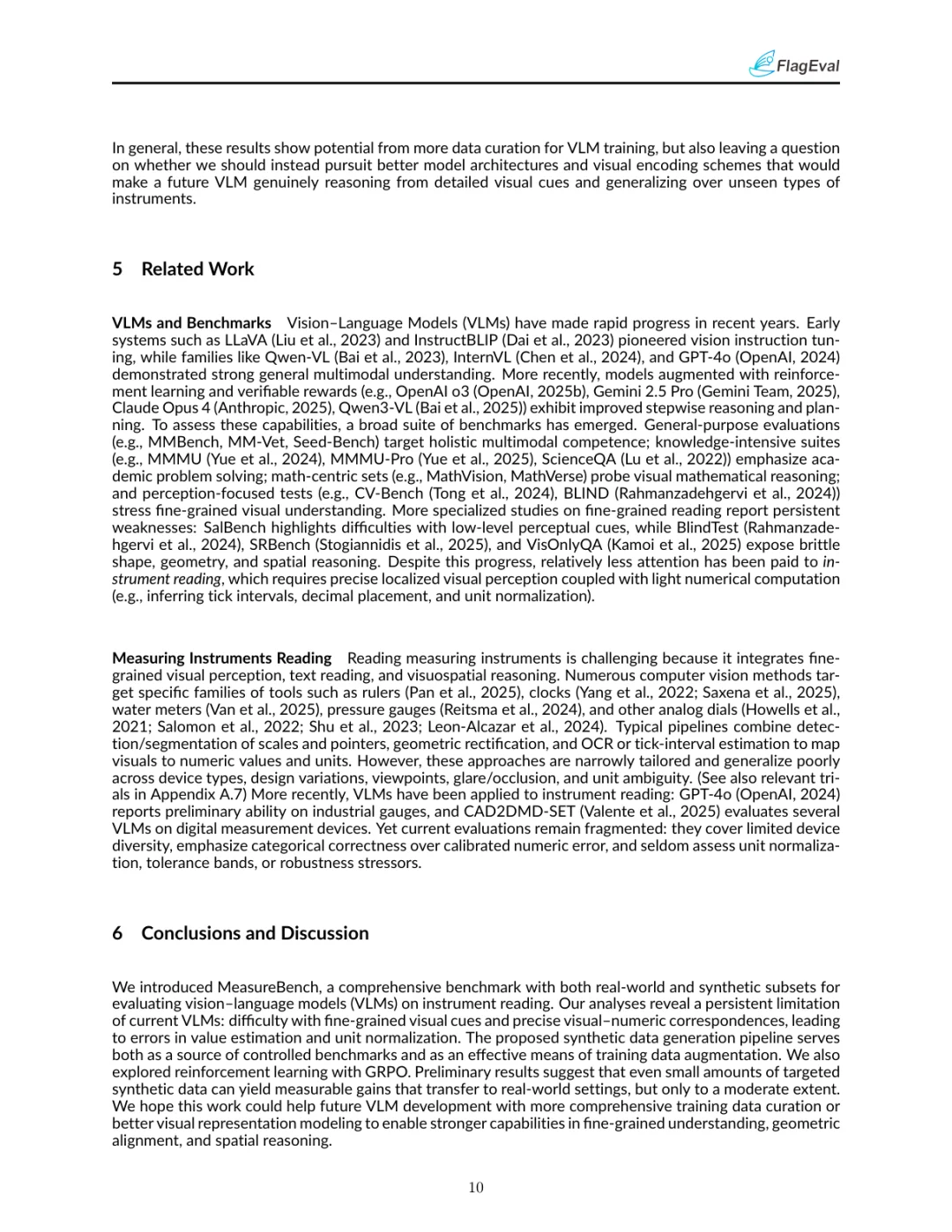

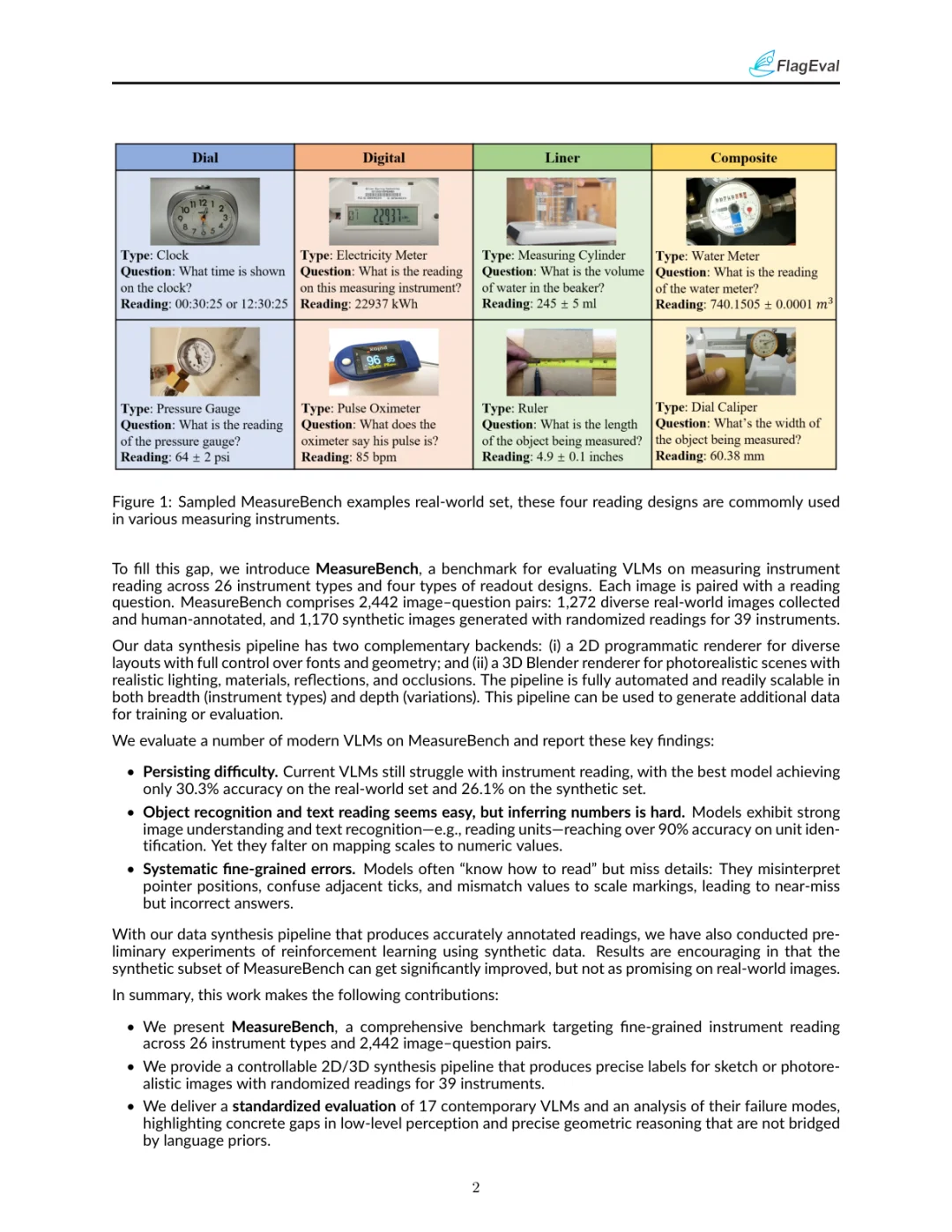

MeasureBenchжҳҜдёҖдёӘе…Ёйқўзҡ„еҹәеҮҶжөӢиҜ•пјҢж—ЁеңЁиҜ„дј°и§Ҷи§үиҜӯиЁҖжЁЎеһӢпјҲVLMsпјүеңЁиҜ»еҸ–жөӢйҮҸд»ӘеҷЁж–№йқўзҡ„жҖ§иғҪгҖӮиҜҘеҹәеҮҶжөӢиҜ•еҢ…жӢ¬2,442дёӘеӣҫеғҸ-й—®йўҳеҜ№пјҢе…¶дёӯ1,272дёӘжқҘиҮӘзңҹе®һдё–з•ҢпјҢ1,170дёӘжқҘиҮӘеҗҲжҲҗж•°жҚ®гҖӮиҝҷдәӣж•°жҚ®иҰҶзӣ–дәҶ26з§ҚдёҚеҗҢзұ»еһӢзҡ„жөӢйҮҸд»ӘеҷЁпјҢеҢ…жӢ¬жЁЎжӢҹиЎЁзӣҳгҖҒж•°еӯ—жҳҫзӨәгҖҒзәҝжҖ§еҲ»еәҰе’ҢеӨҚеҗҲиҜ»ж•°и®ҫи®ЎгҖӮйҖҡиҝҮиҝҷдәӣеӨҡж ·еҢ–зҡ„ж•°жҚ®пјҢMeasureBenchиғҪеӨҹе…ЁйқўиҜ„дј°VLMsеңЁз»ҶзІ’еәҰи§Ҷи§үзҗҶи§Јж–№йқўзҡ„иЎЁзҺ°гҖӮ

?пёҸMeasureBenchзҡ„ж•°жҚ®еҗҲжҲҗжЎҶжһ¶еҰӮдҪ•е·ҘдҪңпјҹ

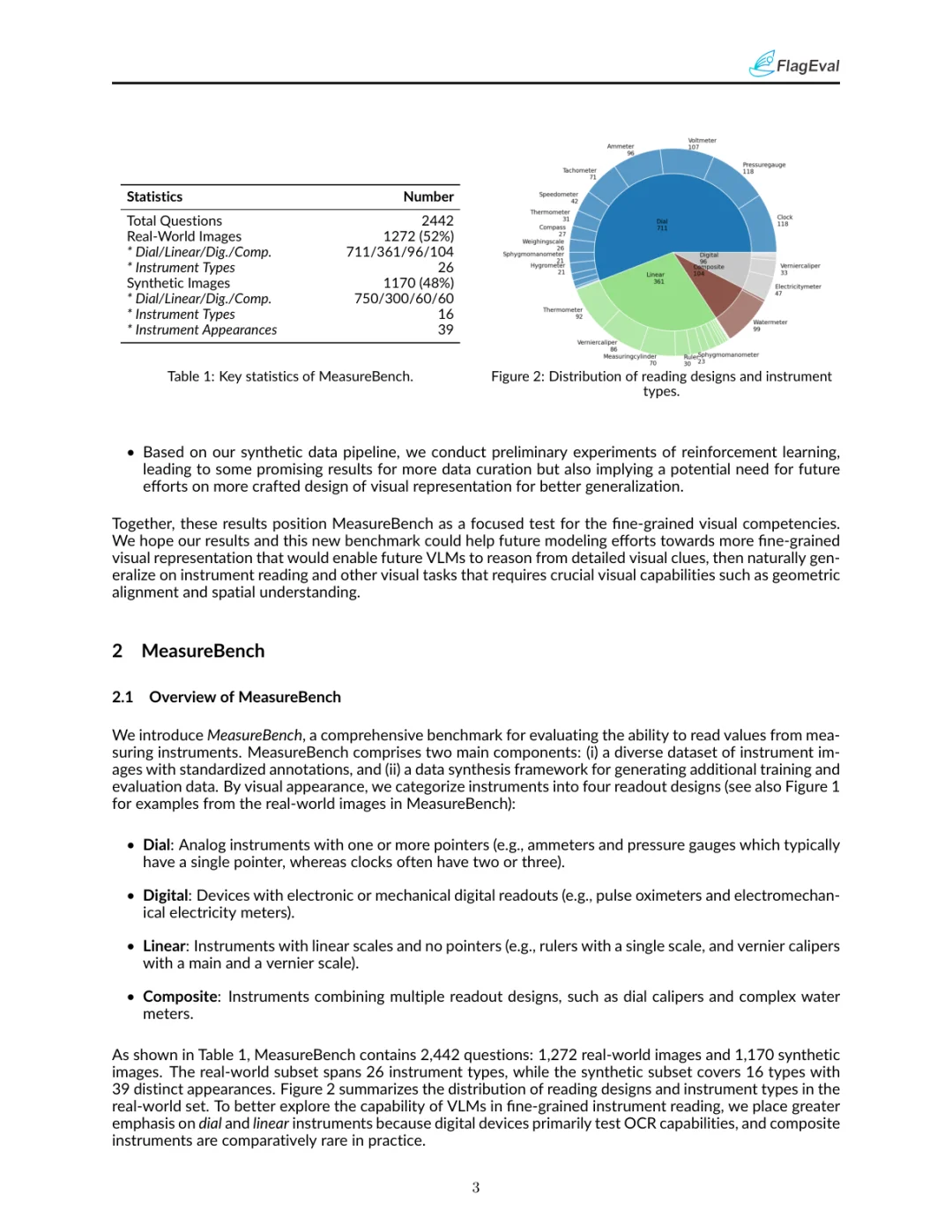

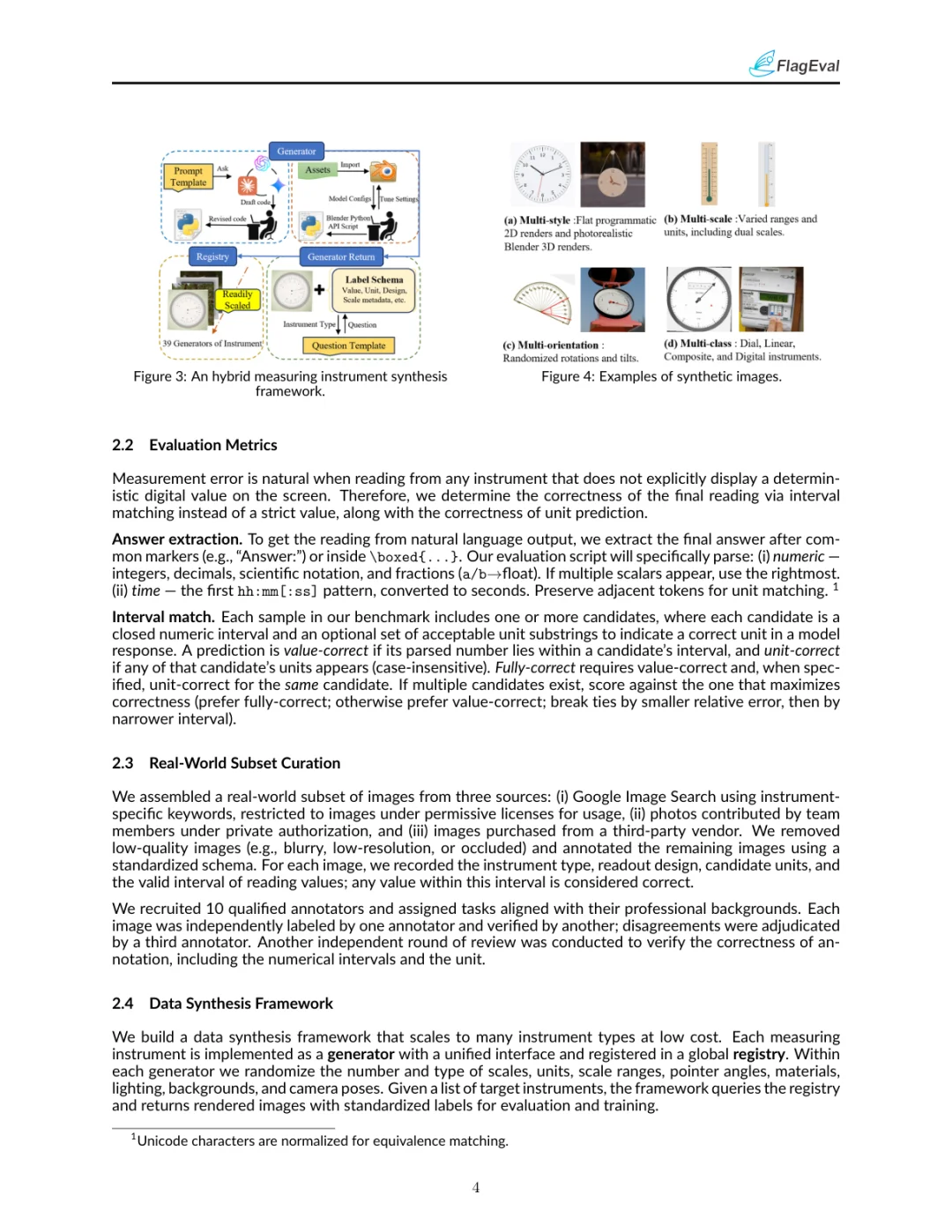

MeasureBenchзҡ„ж•°жҚ®еҗҲжҲҗжЎҶжһ¶иғҪеӨҹз”ҹжҲҗеӨҡж ·еҢ–зҡ„жөӢйҮҸд»ӘеҷЁеӣҫеғҸпјҢеҢ…жӢ¬2DзЁӢеәҸеҢ–жёІжҹ“е’Ң3Dзү©зҗҶжёІжҹ“дёӨз§Қи·Ҝеҫ„гҖӮ2DжёІжҹ“и·Ҝеҫ„дҪҝз”Ёд»Јз ҒжЁЎжқҝз”ҹжҲҗеӣҫеғҸпјҢйҖӮз”ЁдәҺеӨ§и§„жЁЎе®һйӘҢпјӣ3DжёІжҹ“и·Ҝеҫ„еҲҷдҪҝз”ЁBlenderз”ҹжҲҗйҖјзңҹзҡ„еӣҫеғҸпјҢеҮҸе°‘жЁЎжӢҹдёҺзңҹе®һдё–з•Ңзҡ„е·®и·қгҖӮиҜҘжЎҶжһ¶иғҪеӨҹйҡҸжңәеҢ–еҲ»еәҰгҖҒеҚ•дҪҚгҖҒжҢҮй’Ҳи§’еәҰгҖҒжқҗж–ҷгҖҒе…үз…§гҖҒиғҢжҷҜе’Ңзӣёжңәе§ҝжҖҒпјҢз”ҹжҲҗ39з§ҚдёҚеҗҢеӨ–и§Ӯзҡ„17з§Қд»ӘеҷЁзұ»еһӢпјҢжҜҸз§ҚеӨ–и§Ӯз”ҹжҲҗ30еј еӣҫеғҸпјҢжҖ»и®Ў1,170еј еҗҲжҲҗеӣҫеғҸгҖӮ

? MeasureBenchзҡ„иҜ„дј°з»“жһңеҰӮдҪ•пјҹ

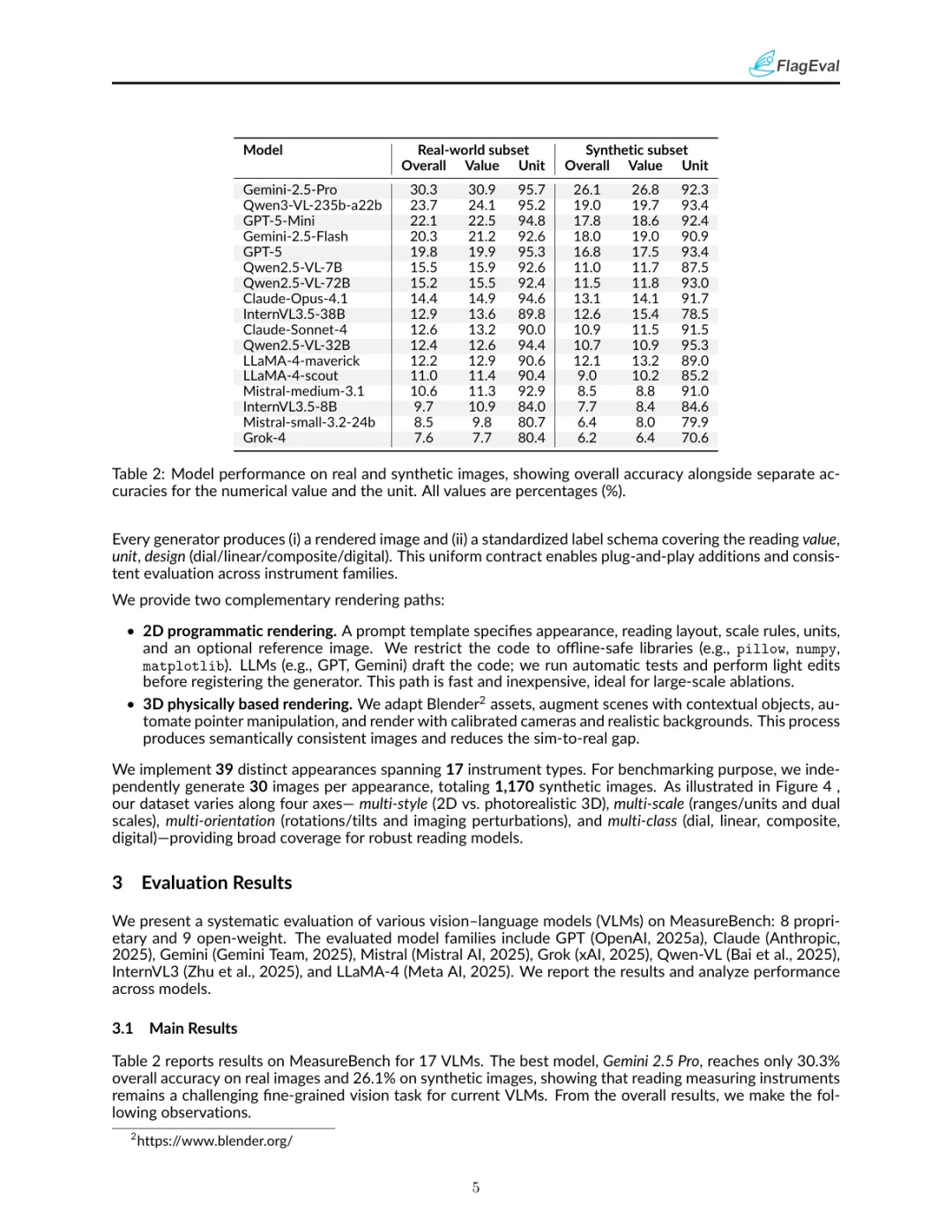

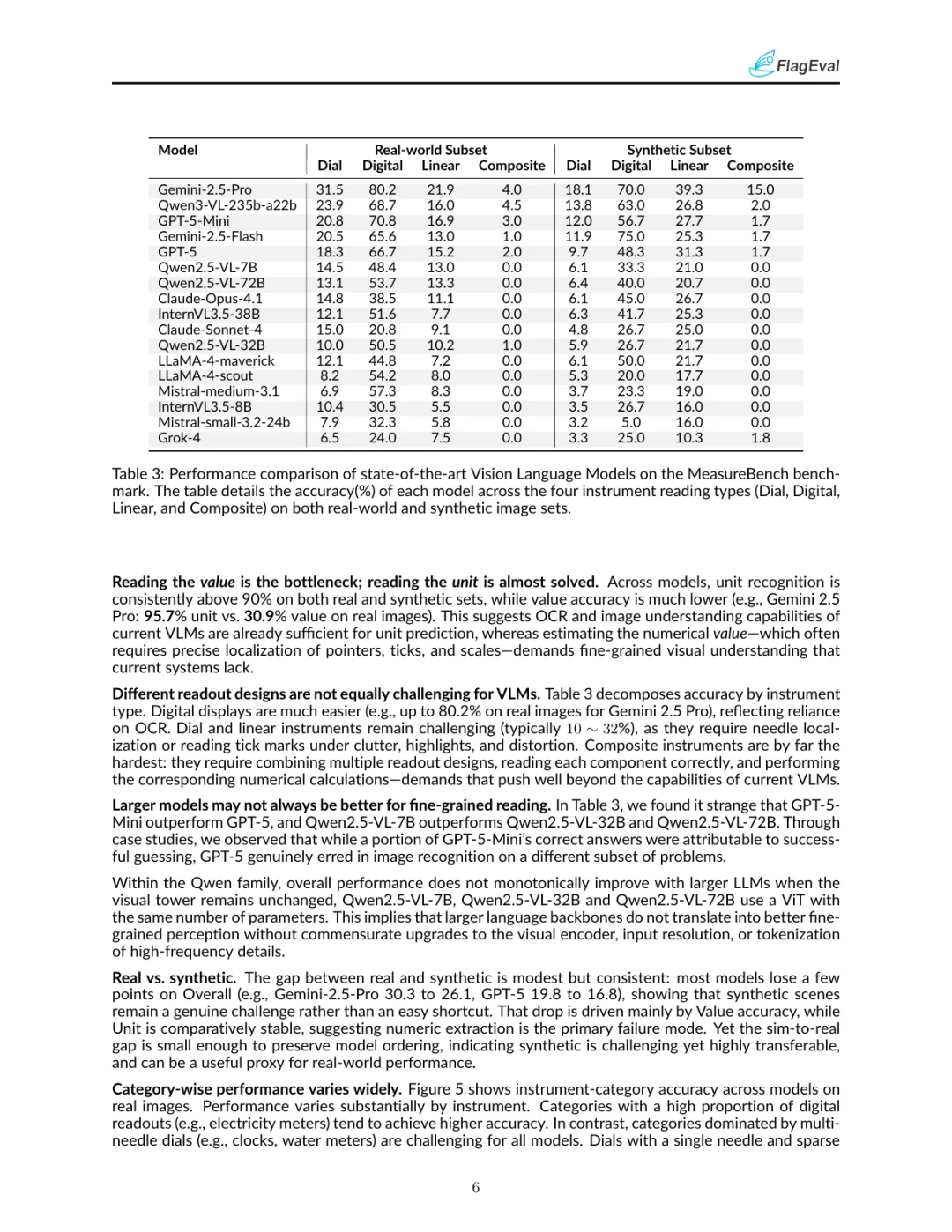

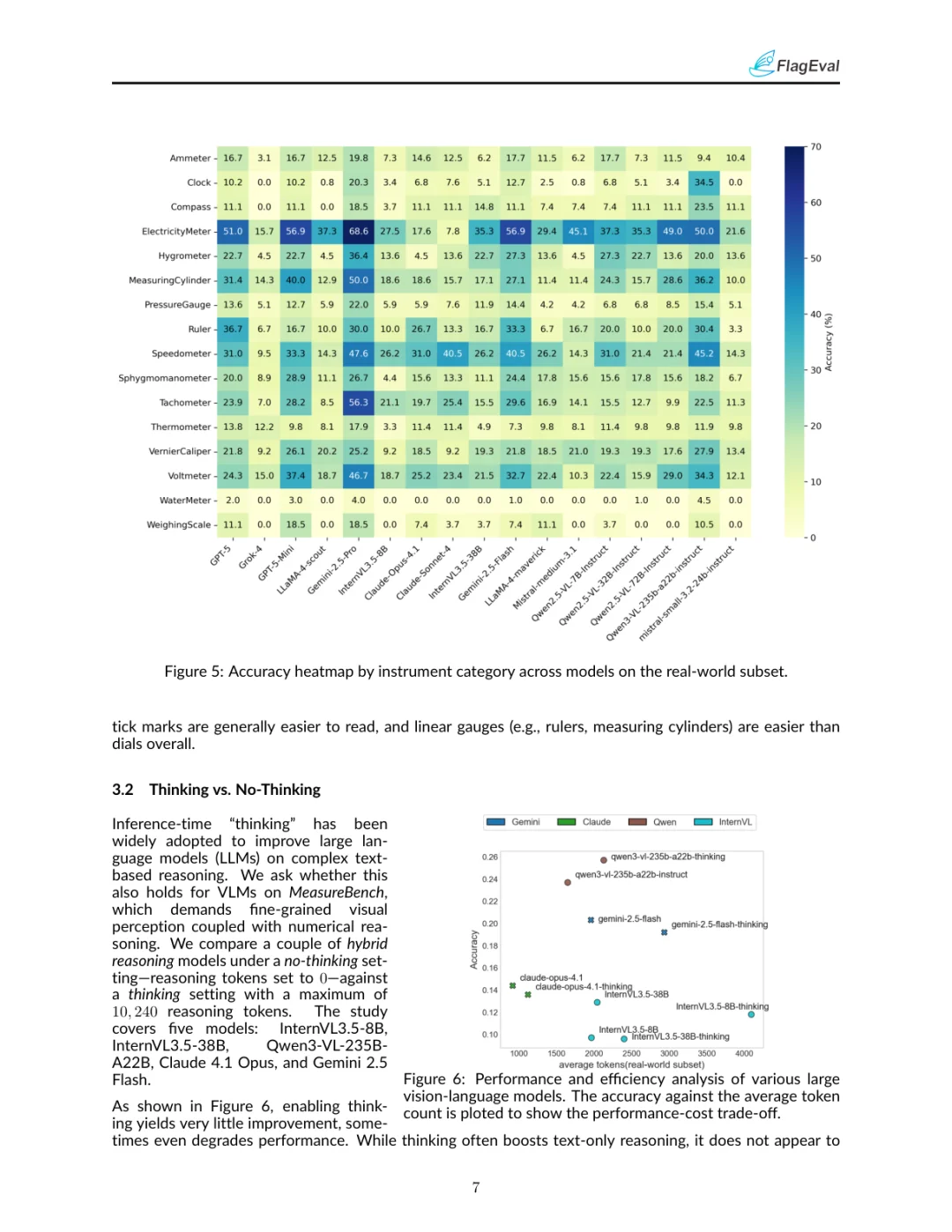

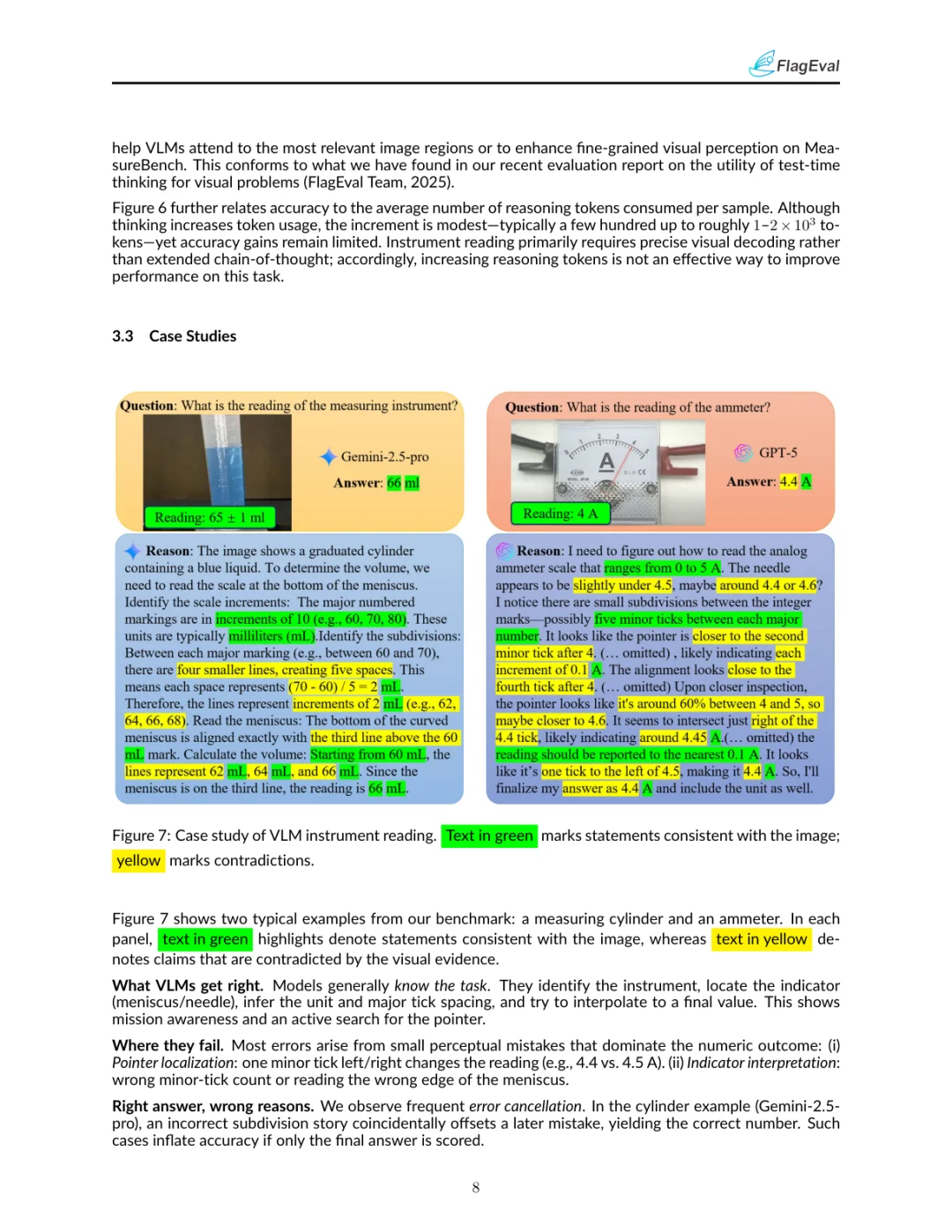

иҜ„дј°з»“жһңжҳҫзӨәпјҢеҚідҪҝжҳҜеҪ“еүҚжңҖе…Ҳиҝӣзҡ„VLMsеңЁиҜ»еҸ–жөӢйҮҸд»ӘеҷЁж–№йқўд»Қ然йқўдёҙе·ЁеӨ§жҢ‘жҲҳгҖӮдҫӢеҰӮпјҢGemini 2.5 ProеңЁзңҹе®һеӣҫеғҸдёҠзҡ„еҮҶзЎ®зҺҮдёә30.3%пјҢеңЁеҗҲжҲҗеӣҫеғҸдёҠзҡ„еҮҶзЎ®зҺҮдёә26.1%гҖӮе°Ҫз®ЎиҝҷдәӣжЁЎеһӢеңЁиҜҶеҲ«еҚ•дҪҚж–№йқўиЎЁзҺ°иүҜеҘҪпјҲеҮҶзЎ®зҺҮи¶…иҝҮ90%пјүпјҢдҪҶеңЁиҜ»еҸ–ж•°еҖјж—¶еҚҙз»ҸеёёеҮәй”ҷпјҢе°Өе…¶жҳҜеңЁжҢҮй’Ҳе®ҡдҪҚе’ҢеҲ»еәҰиҜ»еҸ–ж–№йқўгҖӮдёҚеҗҢзұ»еһӢзҡ„иҜ»ж•°и®ҫи®ЎеҜ№VLMsзҡ„жҢ‘жҲҳд№ҹдёҚеҗҢпјҢж•°еӯ—жҳҫзӨәзӣёеҜ№е®№жҳ“пјҢиҖҢжЁЎжӢҹиЎЁзӣҳе’ҢзәҝжҖ§еҲ»еәҰеҲҷжӣҙдёәеӣ°йҡҫгҖӮ

? MeasureBenchзҡ„ејәеҢ–еӯҰд№ е®һйӘҢз»“жһңеҰӮдҪ•пјҹ

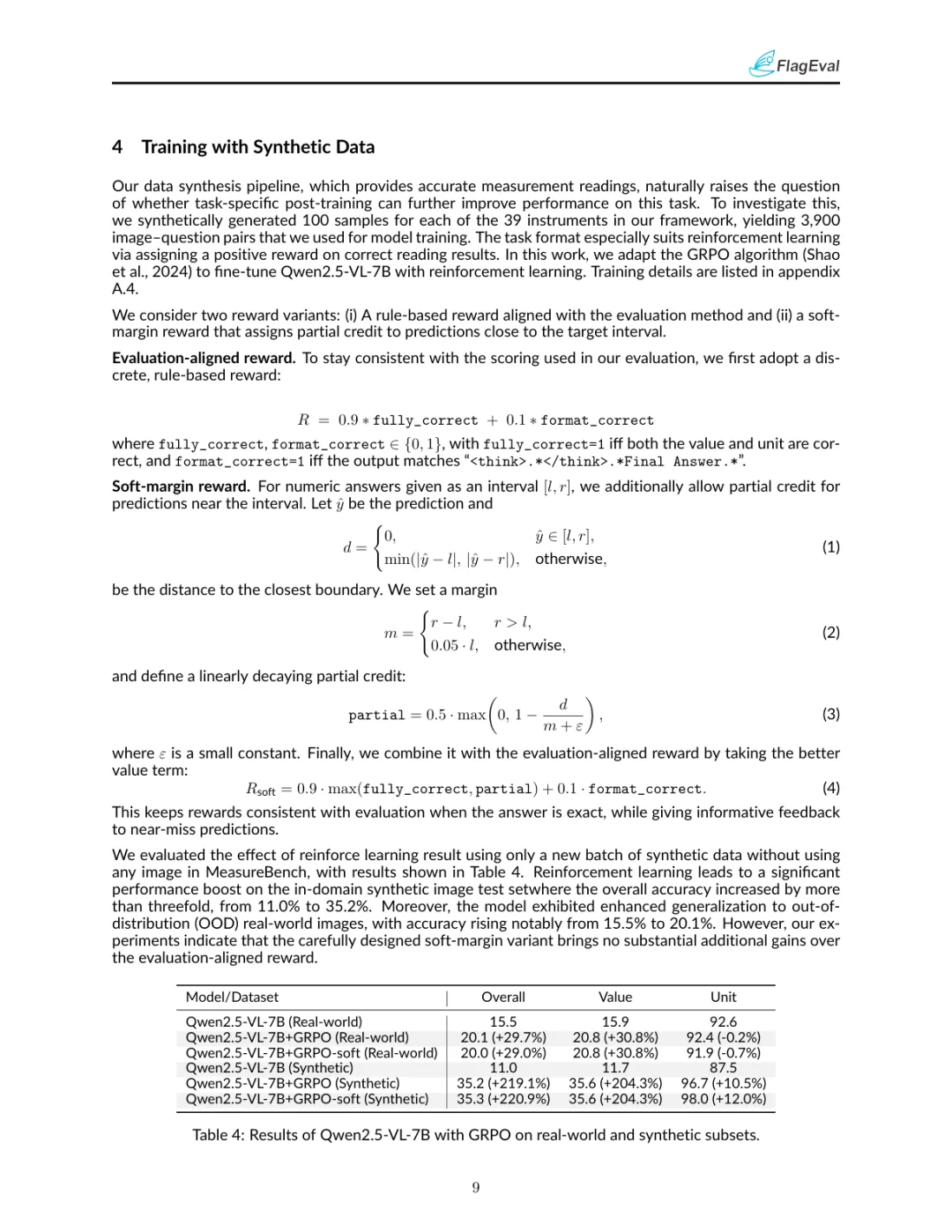

дҪҝз”ЁеҗҲжҲҗж•°жҚ®иҝӣиЎҢејәеҢ–еӯҰд№ зҡ„еҲқжӯҘе®һйӘҢжҳҫзӨәпјҢжЁЎеһӢеңЁеҗҲжҲҗж•°жҚ®йӣҶдёҠзҡ„жҖ§иғҪжҳҫи‘—жҸҗеҚҮпјҢд»Һ11.0%жҸҗй«ҳеҲ°35.2%гҖӮ然иҖҢпјҢиҝҷз§ҚжҸҗеҚҮеңЁзңҹе®һдё–з•ҢеӣҫеғҸдёҠзҡ„ж•ҲжһңиҫғдёәжңүйҷҗпјҢеҮҶзЎ®зҺҮд»Һ15.5%жҸҗй«ҳеҲ°20.1%гҖӮиҝҷиЎЁжҳҺеҗҲжҲҗж•°жҚ®иҷҪ然жңүеҠ©дәҺжЁЎеһӢеӯҰд№ пјҢдҪҶд»Қ然еӯҳеңЁд»ҺжЁЎжӢҹеҲ°зңҹе®һдё–з•Ңзҡ„иҝҒ移问йўҳгҖӮ#жөӢйҮҸиҜ»еҸ– #и®Ўз®—жңәи§Ҷи§ү #ж•°жҚ®йӣҶ #еӨҡжЁЎжҖҒдәәе·ҘжҷәиғҪ #еӨ§жЁЎеһӢ

MeasureBenchжҳҜдёҖдёӘе…Ёйқўзҡ„еҹәеҮҶжөӢиҜ•пјҢж—ЁеңЁиҜ„дј°и§Ҷи§үиҜӯиЁҖжЁЎеһӢпјҲVLMsпјүеңЁиҜ»еҸ–жөӢйҮҸд»ӘеҷЁж–№йқўзҡ„жҖ§иғҪгҖӮиҜҘеҹәеҮҶжөӢиҜ•еҢ…жӢ¬2,442дёӘеӣҫеғҸ-й—®йўҳеҜ№пјҢе…¶дёӯ1,272дёӘжқҘиҮӘзңҹе®һдё–з•ҢпјҢ1,170дёӘжқҘиҮӘеҗҲжҲҗж•°жҚ®гҖӮиҝҷдәӣж•°жҚ®иҰҶзӣ–дәҶ26з§ҚдёҚеҗҢзұ»еһӢзҡ„жөӢйҮҸд»ӘеҷЁпјҢеҢ…жӢ¬жЁЎжӢҹиЎЁзӣҳгҖҒж•°еӯ—жҳҫзӨәгҖҒзәҝжҖ§еҲ»еәҰе’ҢеӨҚеҗҲиҜ»ж•°и®ҫи®ЎгҖӮйҖҡиҝҮиҝҷдәӣеӨҡж ·еҢ–зҡ„ж•°жҚ®пјҢMeasureBenchиғҪеӨҹе…ЁйқўиҜ„дј°VLMsеңЁз»ҶзІ’еәҰи§Ҷи§үзҗҶи§Јж–№йқўзҡ„иЎЁзҺ°гҖӮ

?пёҸMeasureBenchзҡ„ж•°жҚ®еҗҲжҲҗжЎҶжһ¶еҰӮдҪ•е·ҘдҪңпјҹ

MeasureBenchзҡ„ж•°жҚ®еҗҲжҲҗжЎҶжһ¶иғҪеӨҹз”ҹжҲҗеӨҡж ·еҢ–зҡ„жөӢйҮҸд»ӘеҷЁеӣҫеғҸпјҢеҢ…жӢ¬2DзЁӢеәҸеҢ–жёІжҹ“е’Ң3Dзү©зҗҶжёІжҹ“дёӨз§Қи·Ҝеҫ„гҖӮ2DжёІжҹ“и·Ҝеҫ„дҪҝз”Ёд»Јз ҒжЁЎжқҝз”ҹжҲҗеӣҫеғҸпјҢйҖӮз”ЁдәҺеӨ§и§„жЁЎе®һйӘҢпјӣ3DжёІжҹ“и·Ҝеҫ„еҲҷдҪҝз”ЁBlenderз”ҹжҲҗйҖјзңҹзҡ„еӣҫеғҸпјҢеҮҸе°‘жЁЎжӢҹдёҺзңҹе®һдё–з•Ңзҡ„е·®и·қгҖӮиҜҘжЎҶжһ¶иғҪеӨҹйҡҸжңәеҢ–еҲ»еәҰгҖҒеҚ•дҪҚгҖҒжҢҮй’Ҳи§’еәҰгҖҒжқҗж–ҷгҖҒе…үз…§гҖҒиғҢжҷҜе’Ңзӣёжңәе§ҝжҖҒпјҢз”ҹжҲҗ39з§ҚдёҚеҗҢеӨ–и§Ӯзҡ„17з§Қд»ӘеҷЁзұ»еһӢпјҢжҜҸз§ҚеӨ–и§Ӯз”ҹжҲҗ30еј еӣҫеғҸпјҢжҖ»и®Ў1,170еј еҗҲжҲҗеӣҫеғҸгҖӮ

? MeasureBenchзҡ„иҜ„дј°з»“жһңеҰӮдҪ•пјҹ

иҜ„дј°з»“жһңжҳҫзӨәпјҢеҚідҪҝжҳҜеҪ“еүҚжңҖе…Ҳиҝӣзҡ„VLMsеңЁиҜ»еҸ–жөӢйҮҸд»ӘеҷЁж–№йқўд»Қ然йқўдёҙе·ЁеӨ§жҢ‘жҲҳгҖӮдҫӢеҰӮпјҢGemini 2.5 ProеңЁзңҹе®һеӣҫеғҸдёҠзҡ„еҮҶзЎ®зҺҮдёә30.3%пјҢеңЁеҗҲжҲҗеӣҫеғҸдёҠзҡ„еҮҶзЎ®зҺҮдёә26.1%гҖӮе°Ҫз®ЎиҝҷдәӣжЁЎеһӢеңЁиҜҶеҲ«еҚ•дҪҚж–№йқўиЎЁзҺ°иүҜеҘҪпјҲеҮҶзЎ®зҺҮи¶…иҝҮ90%пјүпјҢдҪҶеңЁиҜ»еҸ–ж•°еҖјж—¶еҚҙз»ҸеёёеҮәй”ҷпјҢе°Өе…¶жҳҜеңЁжҢҮй’Ҳе®ҡдҪҚе’ҢеҲ»еәҰиҜ»еҸ–ж–№йқўгҖӮдёҚеҗҢзұ»еһӢзҡ„иҜ»ж•°и®ҫи®ЎеҜ№VLMsзҡ„жҢ‘жҲҳд№ҹдёҚеҗҢпјҢж•°еӯ—жҳҫзӨәзӣёеҜ№е®№жҳ“пјҢиҖҢжЁЎжӢҹиЎЁзӣҳе’ҢзәҝжҖ§еҲ»еәҰеҲҷжӣҙдёәеӣ°йҡҫгҖӮ

? MeasureBenchзҡ„ејәеҢ–еӯҰд№ е®һйӘҢз»“жһңеҰӮдҪ•пјҹ

дҪҝз”ЁеҗҲжҲҗж•°жҚ®иҝӣиЎҢејәеҢ–еӯҰд№ зҡ„еҲқжӯҘе®һйӘҢжҳҫзӨәпјҢжЁЎеһӢеңЁеҗҲжҲҗж•°жҚ®йӣҶдёҠзҡ„жҖ§иғҪжҳҫи‘—жҸҗеҚҮпјҢд»Һ11.0%жҸҗй«ҳеҲ°35.2%гҖӮ然иҖҢпјҢиҝҷз§ҚжҸҗеҚҮеңЁзңҹе®һдё–з•ҢеӣҫеғҸдёҠзҡ„ж•ҲжһңиҫғдёәжңүйҷҗпјҢеҮҶзЎ®зҺҮд»Һ15.5%жҸҗй«ҳеҲ°20.1%гҖӮиҝҷиЎЁжҳҺеҗҲжҲҗж•°жҚ®иҷҪ然жңүеҠ©дәҺжЁЎеһӢеӯҰд№ пјҢдҪҶд»Қ然еӯҳеңЁд»ҺжЁЎжӢҹеҲ°зңҹе®һдё–з•Ңзҡ„иҝҒ移问йўҳгҖӮ#жөӢйҮҸиҜ»еҸ– #и®Ўз®—жңәи§Ҷи§ү #ж•°жҚ®йӣҶ #еӨҡжЁЎжҖҒдәәе·ҘжҷәиғҪ #еӨ§жЁЎеһӢ