这篇我们接着聊,有了大纲之后,如何选择最合适的AI模型,并指挥它完成写作。

第二步:选择你的大模型

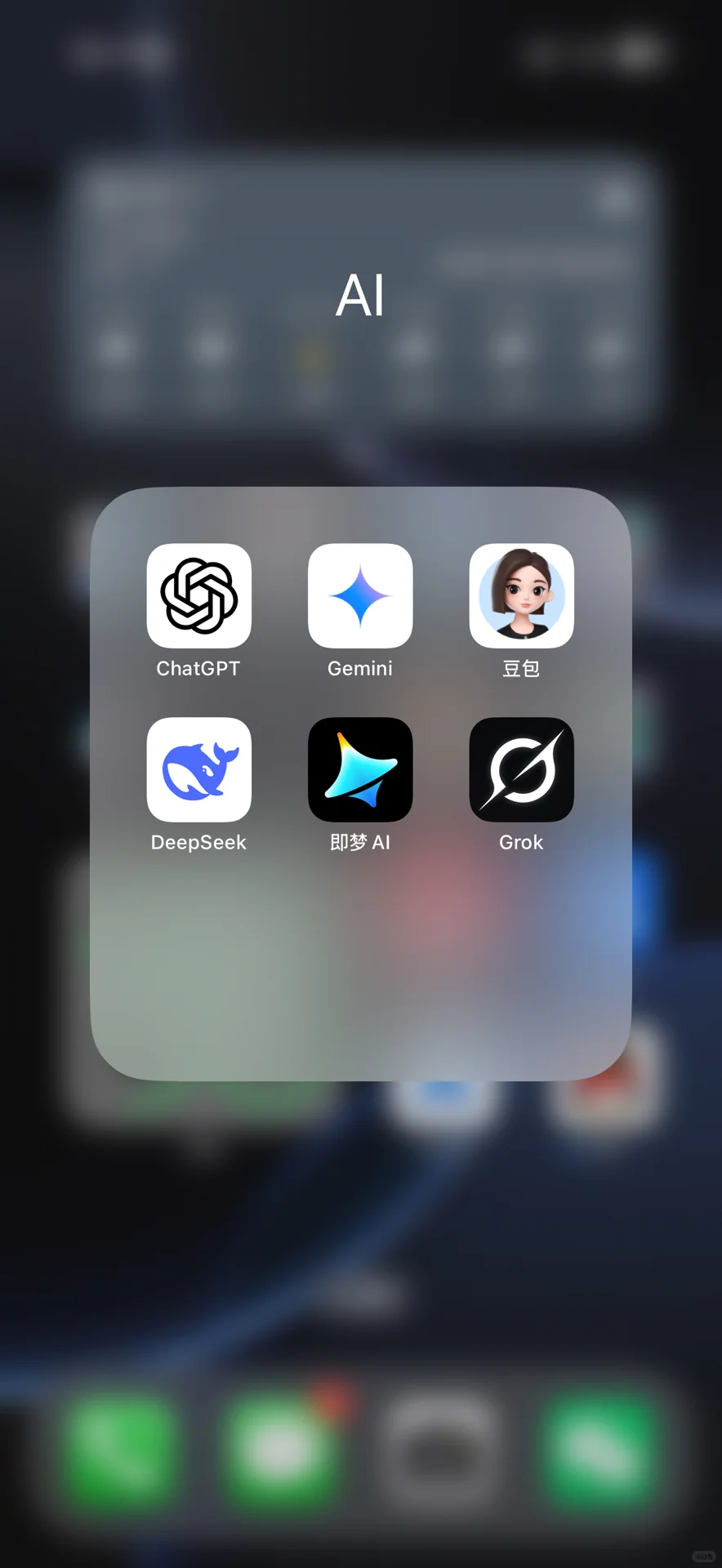

不同的“大语言模型 (LLM)”在底层架构和训练数据上各有侧重,也就直接导致大家各有侧重。(图2)

ChatGPT 这类模型强于语言的流畅性和对话的自然感,适合做头脑风暴和内容润色。

DeepSeek 这类模型在代码和逻辑推理上表现优异,处理技术逻辑严谨的内容时有优势。

而撰写长篇技术方案,最关键的一个技术指标是——“上下文窗口 ”。你可以把它理解为 AI 的“短期记忆容量”。窗口越大,AI 在生成长文时能记住的“前情提要”就越多。

如果模型“上下文窗口”不够大,写到方案的后半部分,它就会“忘记”前面的设定和要求,开始出现前后矛盾、逻辑断裂的“幻觉”现象。

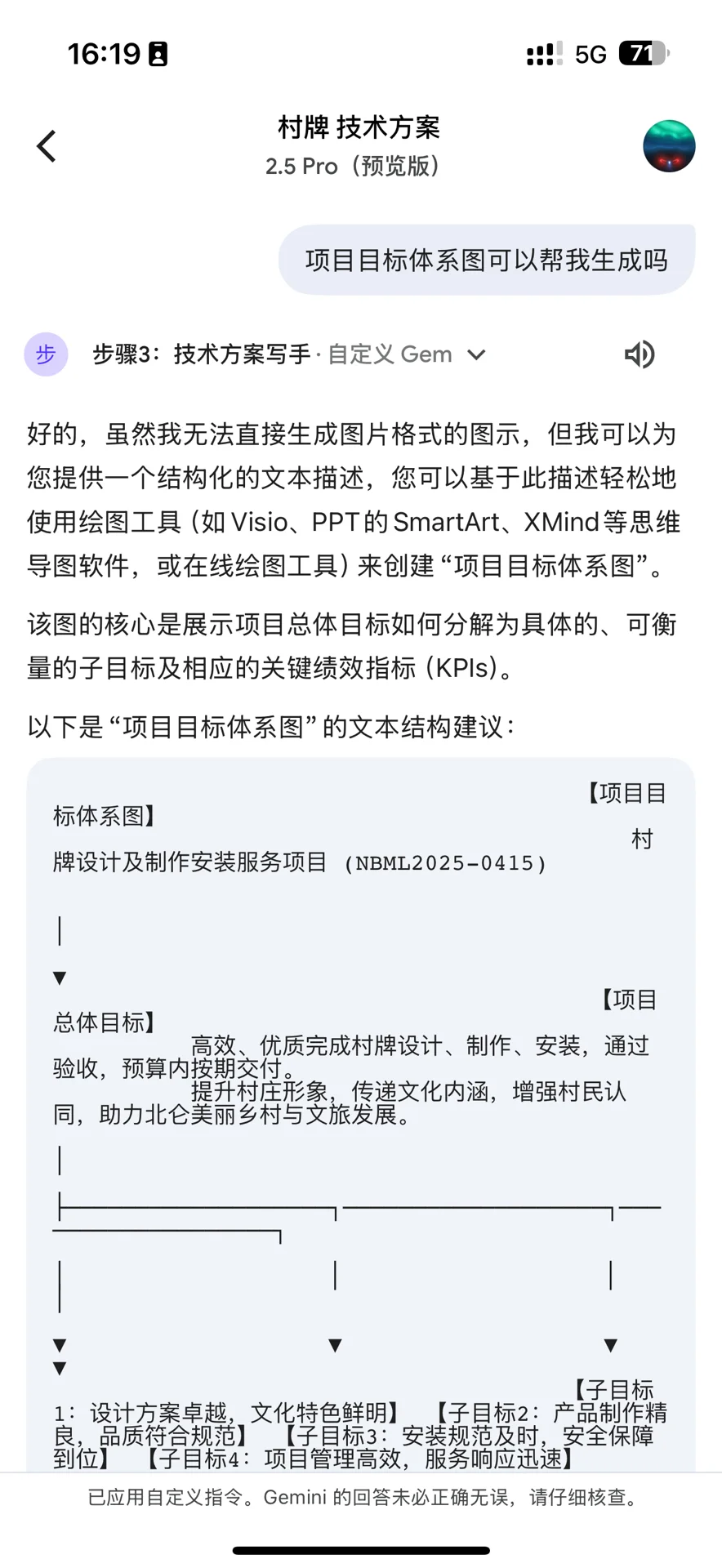

我测了很多模型,目前在用的是谷歌的 Gemini 2.5 Pro。它超大的上下文窗口,让它在处理长达数万字的技术方案时,依然能保持高度的连贯性和一致性,非常强大,当然,DeepSeek R1也不错。

第三步:巧用“提示词工程”

大纲和模型都就位了,接下来就是核心部分——提示词 (Prompt)。

很多人用 AI 写出的东西感觉“差点意思”,就是因为缺少了精心设计的提示词。一个好的 Prompt,不仅是提出问题,更是为 AI 设定了角色、口吻、格式、输出目标和约束条件。AI 会严格遵循你的“人设”和“规矩”来产出内容。

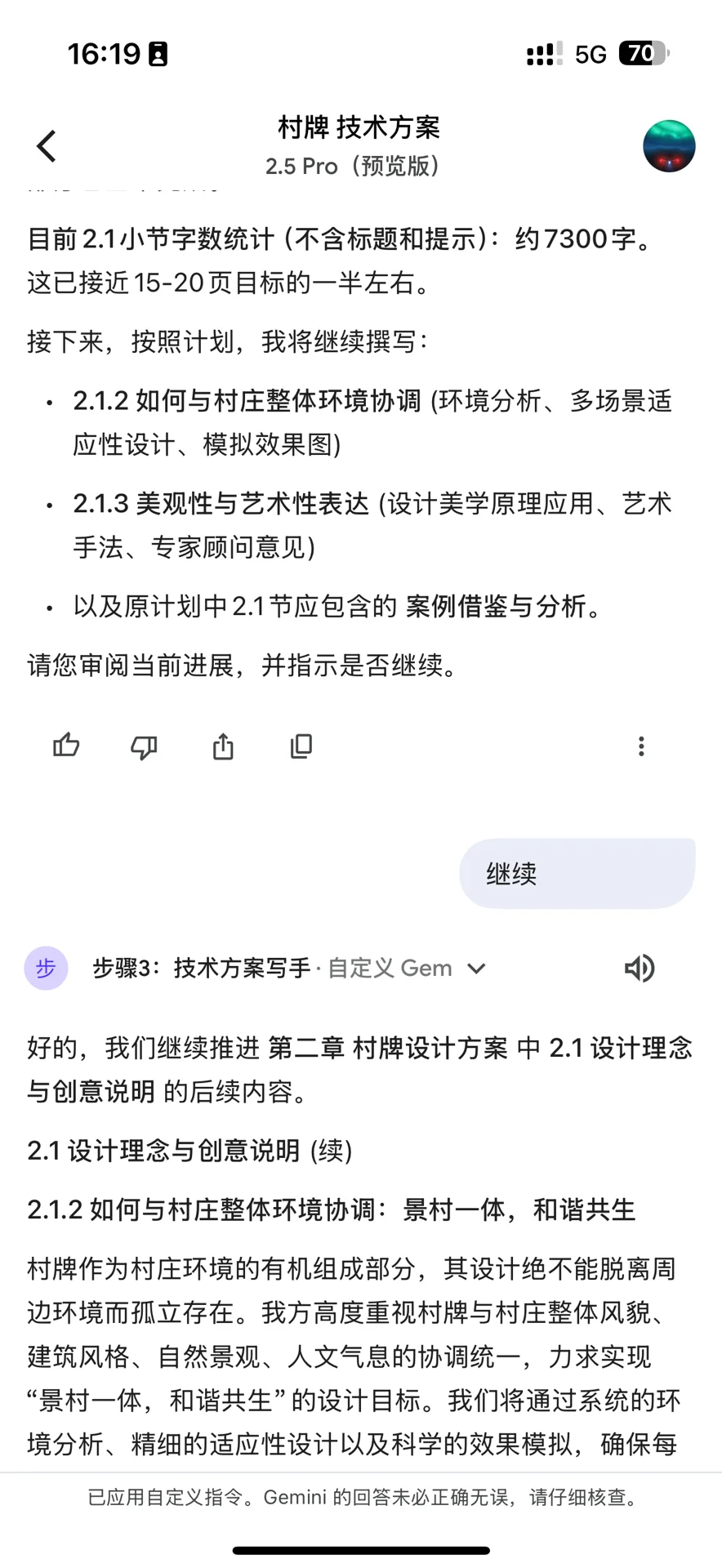

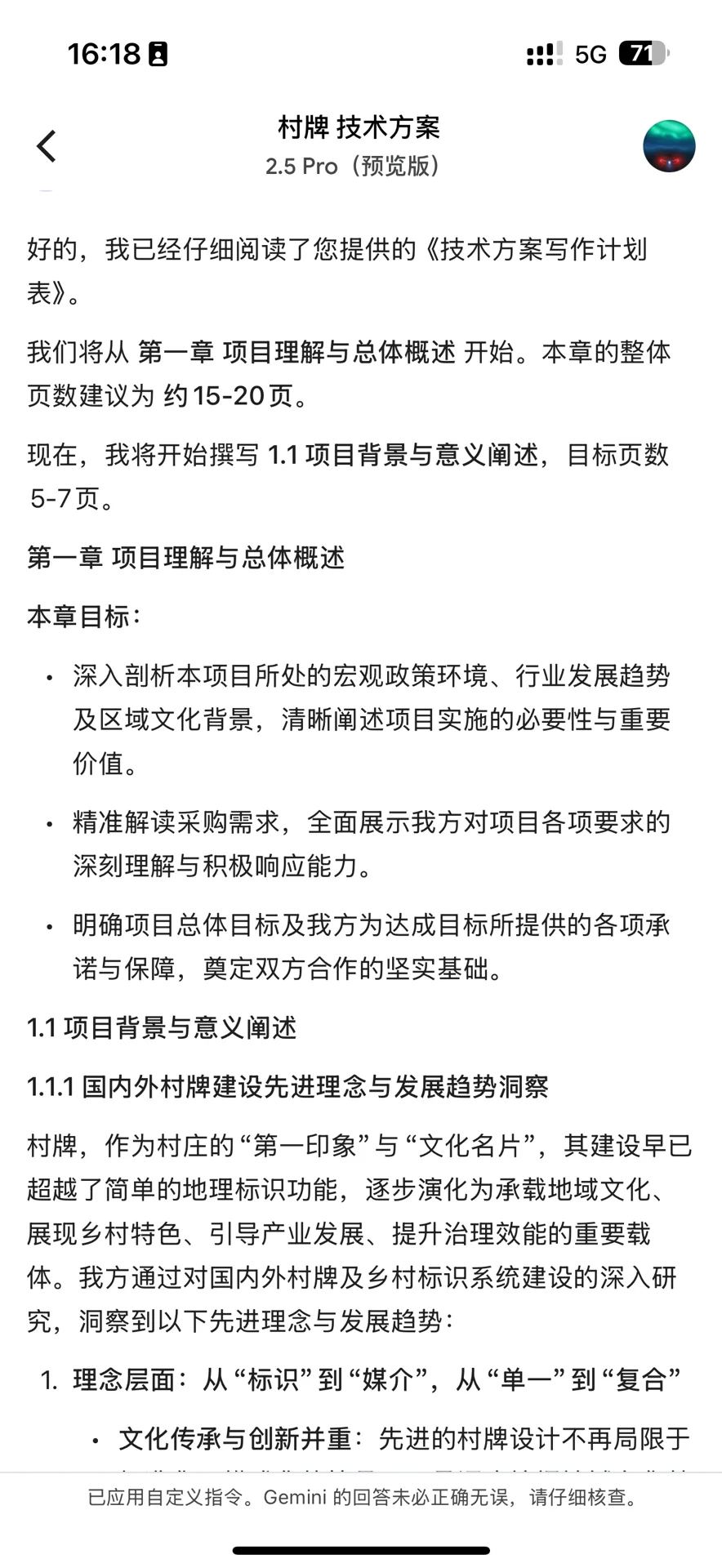

第四步:“分块生成”与“迭代优化”

由于 Token(可以理解为 AI 处理文本的最小单元)的限制,我们无法让 AI 一次性输出整份方案。所以,我们需要采用“分块生成”的策略。

分段输出: 让 AI 逐个章节或几个小节进行输出。

随时调优: 在过程中,如果不满意,可以随时打断并提出修改意见,进行迭代优化。

整合归档: 每完成一块,就复制到你的文档工具中。(这里我强烈推荐 WPS)

经过十几轮甚至几十轮的对话式生成和复制,你的方案初稿就完成了。最后我们人工进行润色,基本上大半天就能搞定一份高质量的技术方案。

这个方法虽然好用,解决了从 0 到 1 的核心产出问题,但它依然存在效率上的瓶颈。

下篇帖子我会分享一个更高效的方法,会复杂一些,但它已经让我实现了基本解放双手。

#Ai写标书 #ai工具 #标书

第二步:选择你的大模型

不同的“大语言模型 (LLM)”在底层架构和训练数据上各有侧重,也就直接导致大家各有侧重。(图2)

ChatGPT 这类模型强于语言的流畅性和对话的自然感,适合做头脑风暴和内容润色。

DeepSeek 这类模型在代码和逻辑推理上表现优异,处理技术逻辑严谨的内容时有优势。

而撰写长篇技术方案,最关键的一个技术指标是——“上下文窗口 ”。你可以把它理解为 AI 的“短期记忆容量”。窗口越大,AI 在生成长文时能记住的“前情提要”就越多。

如果模型“上下文窗口”不够大,写到方案的后半部分,它就会“忘记”前面的设定和要求,开始出现前后矛盾、逻辑断裂的“幻觉”现象。

我测了很多模型,目前在用的是谷歌的 Gemini 2.5 Pro。它超大的上下文窗口,让它在处理长达数万字的技术方案时,依然能保持高度的连贯性和一致性,非常强大,当然,DeepSeek R1也不错。

第三步:巧用“提示词工程”

大纲和模型都就位了,接下来就是核心部分——提示词 (Prompt)。

很多人用 AI 写出的东西感觉“差点意思”,就是因为缺少了精心设计的提示词。一个好的 Prompt,不仅是提出问题,更是为 AI 设定了角色、口吻、格式、输出目标和约束条件。AI 会严格遵循你的“人设”和“规矩”来产出内容。

第四步:“分块生成”与“迭代优化”

由于 Token(可以理解为 AI 处理文本的最小单元)的限制,我们无法让 AI 一次性输出整份方案。所以,我们需要采用“分块生成”的策略。

分段输出: 让 AI 逐个章节或几个小节进行输出。

随时调优: 在过程中,如果不满意,可以随时打断并提出修改意见,进行迭代优化。

整合归档: 每完成一块,就复制到你的文档工具中。(这里我强烈推荐 WPS)

经过十几轮甚至几十轮的对话式生成和复制,你的方案初稿就完成了。最后我们人工进行润色,基本上大半天就能搞定一份高质量的技术方案。

这个方法虽然好用,解决了从 0 到 1 的核心产出问题,但它依然存在效率上的瓶颈。

下篇帖子我会分享一个更高效的方法,会复杂一些,但它已经让我实现了基本解放双手。

#Ai写标书 #ai工具 #标书