? 翰林侍读在此!给陛下奉上今日AI领域的论文速报!

? 右滑查看士子奏报,关注微臣,每天批阅更多奏章!

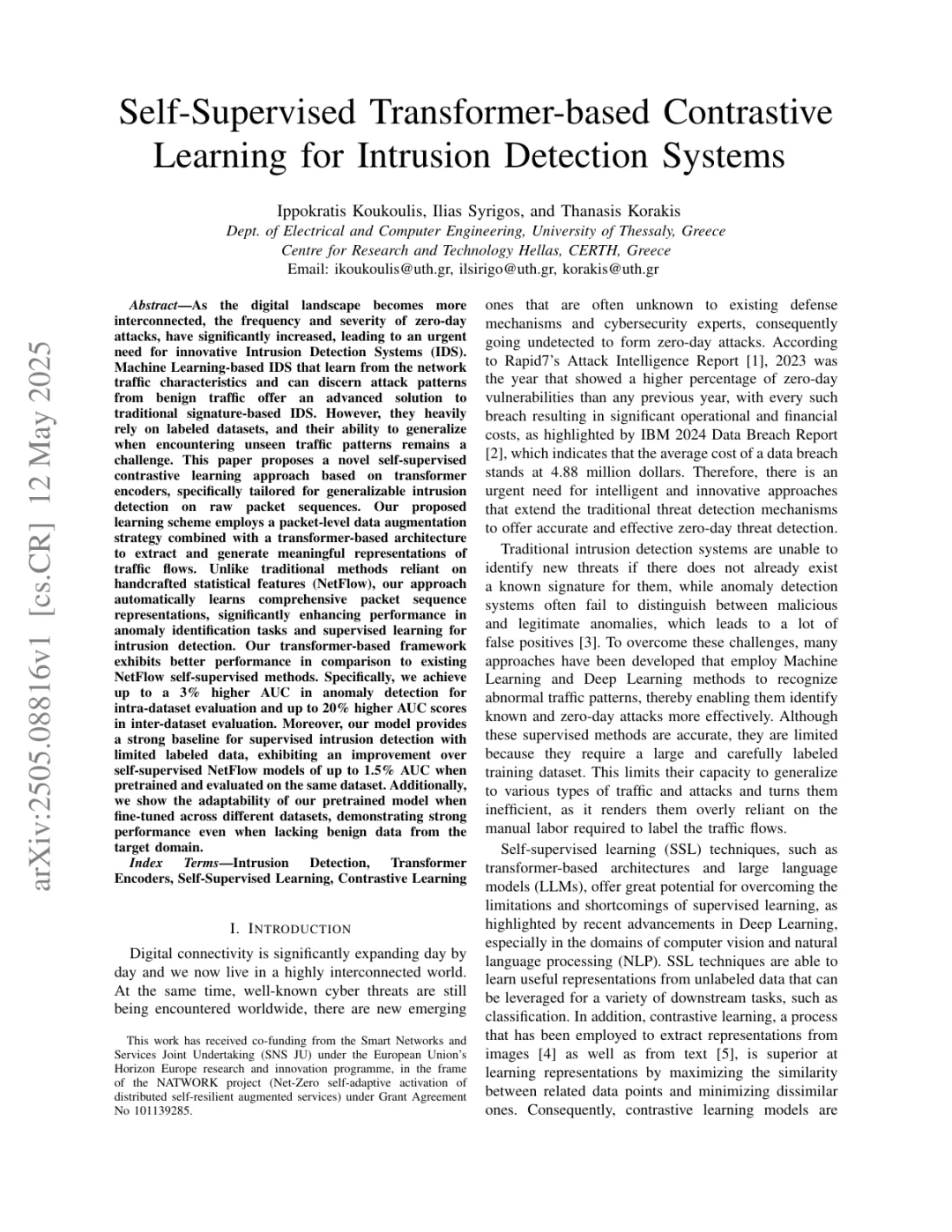

? 论文标题:Self-Supervised Transformer-based Contrastive Learning for Intrusion Detection Systems

? Arxiv ID:2505.08816v1

? 关键词:Intrusion Detection Systems, Machine Learning, Self-supervised Contrastive Learning, Transformer Encoders, Anomaly Detection

? 太长不看版:该论文提出一种基于transformer编码器的自监督对比学习新方法,有效提升原始数据包序列的可解释性,显著增强异常检测和入侵检测性能。

? 摘要翻译:随着数字世界的日益互联互通,零日攻击的频率和严重性显著增加,迫切需要创新性的入侵检测系统(IDS)。基于机器学习的IDS,通过学习网络流量特征并从良性流量中辨别攻击模式,为传统的基于签名的IDS提供了一种高级解决方案。然而,它们高度依赖于标记的数据集,而当遇到未见过的流量模式时,它们的泛化能力仍然是一个挑战。本文提出了一种基于transformer编码器的创新性自监督对比学习方法,专门针对原始数据包序列的泛化入侵检测。我们提出的学习方案采用数据包级别的数据增强策略,结合基于transformer的架构,以提取和生成流量流的有意义表示。与依赖于手工制作的统计特征(如NetFlow)的传统方法不同,我们的方法自动学习全面的包序列表示,显著提高了异常识别任务和入侵检测的监督学习性能。我们的基于transformer的框架在性能上优于现有的NetFlow自监督方法。具体来说,我们在数据集内部评估中实现了高达3%的AUC提升,在数据集间评估中实现了高达20%的AUC分数提升。此外,我们的模型为具有有限标记数据的监督入侵检测提供了一个强大的基线,当在相同的数据集上预训练和评估时,与自监督NetFlow模型相比,AUC提高了高达1.5%。此外,我们还展示了我们的预训练模型在不同数据集上进行微调时的适应性,即使在缺乏目标域良性数据的情况下,也表现出强大的性能。

? 本帖由AI整理生成,若有错误欢迎朱批!

?? 求一个关注,让我更有动力为大家整理更多的AI领域的新文章!

LLM NLP AI 大模型 人工智能 论文阅读

? 右滑查看士子奏报,关注微臣,每天批阅更多奏章!

? 论文标题:Self-Supervised Transformer-based Contrastive Learning for Intrusion Detection Systems

? Arxiv ID:2505.08816v1

? 关键词:Intrusion Detection Systems, Machine Learning, Self-supervised Contrastive Learning, Transformer Encoders, Anomaly Detection

? 太长不看版:该论文提出一种基于transformer编码器的自监督对比学习新方法,有效提升原始数据包序列的可解释性,显著增强异常检测和入侵检测性能。

? 摘要翻译:随着数字世界的日益互联互通,零日攻击的频率和严重性显著增加,迫切需要创新性的入侵检测系统(IDS)。基于机器学习的IDS,通过学习网络流量特征并从良性流量中辨别攻击模式,为传统的基于签名的IDS提供了一种高级解决方案。然而,它们高度依赖于标记的数据集,而当遇到未见过的流量模式时,它们的泛化能力仍然是一个挑战。本文提出了一种基于transformer编码器的创新性自监督对比学习方法,专门针对原始数据包序列的泛化入侵检测。我们提出的学习方案采用数据包级别的数据增强策略,结合基于transformer的架构,以提取和生成流量流的有意义表示。与依赖于手工制作的统计特征(如NetFlow)的传统方法不同,我们的方法自动学习全面的包序列表示,显著提高了异常识别任务和入侵检测的监督学习性能。我们的基于transformer的框架在性能上优于现有的NetFlow自监督方法。具体来说,我们在数据集内部评估中实现了高达3%的AUC提升,在数据集间评估中实现了高达20%的AUC分数提升。此外,我们的模型为具有有限标记数据的监督入侵检测提供了一个强大的基线,当在相同的数据集上预训练和评估时,与自监督NetFlow模型相比,AUC提高了高达1.5%。此外,我们还展示了我们的预训练模型在不同数据集上进行微调时的适应性,即使在缺乏目标域良性数据的情况下,也表现出强大的性能。

? 本帖由AI整理生成,若有错误欢迎朱批!

?? 求一个关注,让我更有动力为大家整理更多的AI领域的新文章!

LLM NLP AI 大模型 人工智能 论文阅读