刚看完Torchcomms论文,发现了个挺有意思的性能优化点。

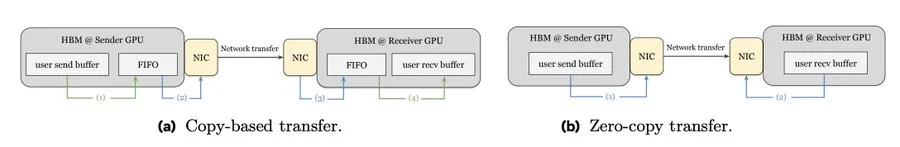

传统GPU通信用的是复制模式,数据要先经过SM或HBM内存,还得维护FIFO队列排队,这就像快递站转运一样,多了一道手续自然就慢了。而且这个队列还会和计算进程抢资源,容易产生性能瓶颈。

Torchcomms直接默认用零拷贝传输,相当于数据不用中转直接送达,省去了那层开销和资源争抢。对做分布式训练或大规模推理的同学来说,这个优化思路值得关注。

论文里给的对比图很清楚,左边是传统复制模式的多步骤流程,右边是零拷贝的简化路径。如果你的训练任务经常卡在通信上,可能就是这个原因。

#GPU优化 #深度学习 #分布式训练 #性能调优 #技术干货 #AI训练 #Torchcomms

传统GPU通信用的是复制模式,数据要先经过SM或HBM内存,还得维护FIFO队列排队,这就像快递站转运一样,多了一道手续自然就慢了。而且这个队列还会和计算进程抢资源,容易产生性能瓶颈。

Torchcomms直接默认用零拷贝传输,相当于数据不用中转直接送达,省去了那层开销和资源争抢。对做分布式训练或大规模推理的同学来说,这个优化思路值得关注。

论文里给的对比图很清楚,左边是传统复制模式的多步骤流程,右边是零拷贝的简化路径。如果你的训练任务经常卡在通信上,可能就是这个原因。

#GPU优化 #深度学习 #分布式训练 #性能调优 #技术干货 #AI训练 #Torchcomms