深度学习在网络入侵检测中屡创高分,但背后的“黑盒”机制却让人疑虑重重:模型判你有问题,却从不解释原因。而这篇论文,正是为此而来。它不仅提出了一个高性能的入侵检测系统,还引入了三种主流的可解释AI方法(XAI),让模型“说出为什么”,大幅提升信任度与实用性。

?结构简单但不简单,复现难度低,非常适合上手!

论文采用了 5层的前馈神经网络(DNN)结构,无复杂的Transformer或图网络,编程上用PyTorch即可完成,非常适合新手上手练习。更棒的是,它使用了两个广泛使用的公开数据集:NSL-KDD 与 UNSW-NB15,这两个数据集:

免费可下载,格式清晰;

有大量前人文献可作对比;

适合做二分类和多分类任务。

? 对于研究生来说,这种“数据+模型+代码方向都现成”的组合,是做实验、发论文的最佳起点之一。

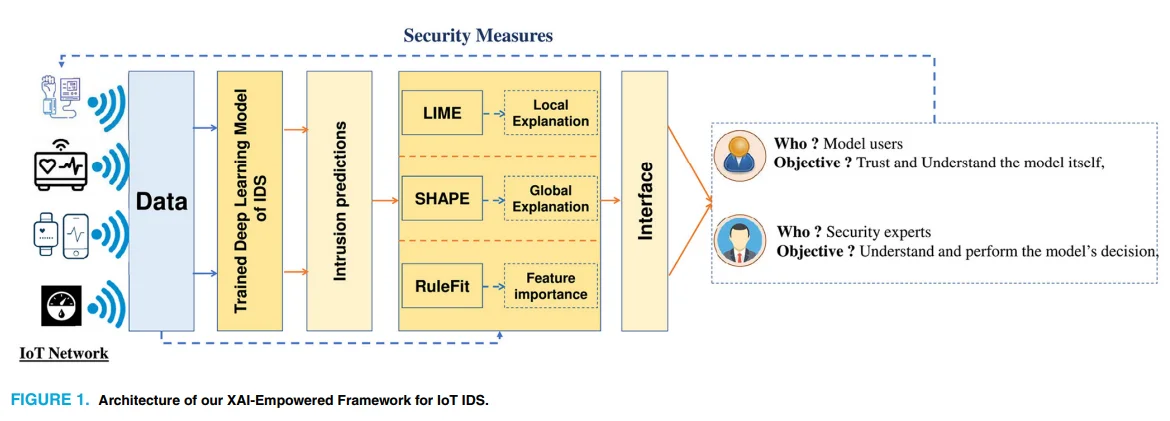

?解释三件套上线,让模型说得清又看得懂

这篇论文最大亮点是整合了三种可解释性机制,帮助分析模型为什么做出某个判断:

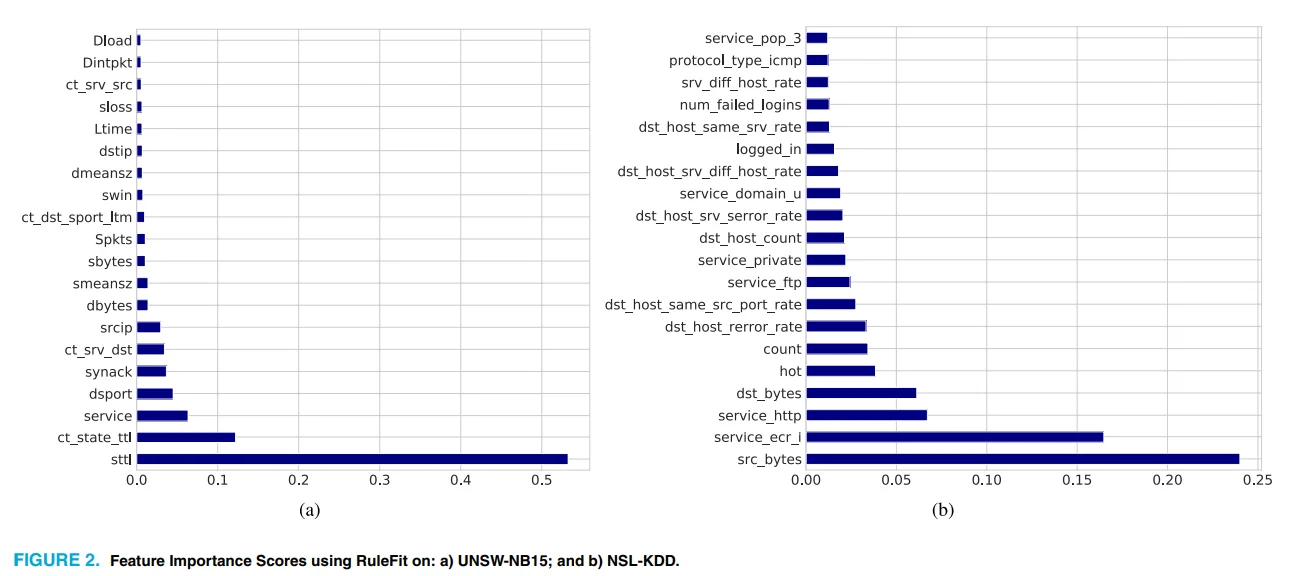

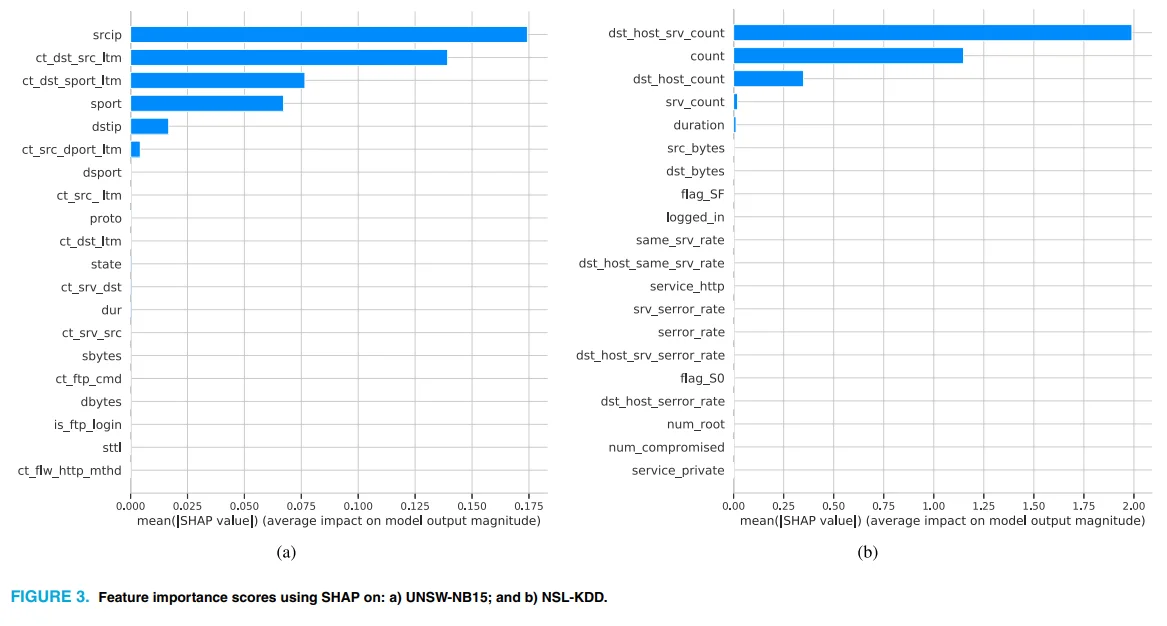

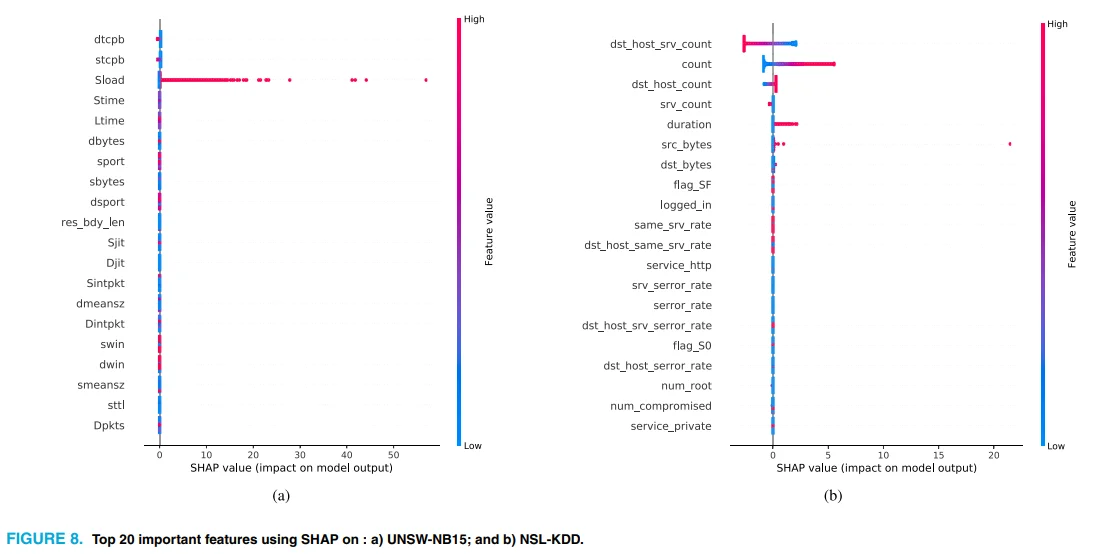

SHAP:衡量特征对模型预测的整体影响;

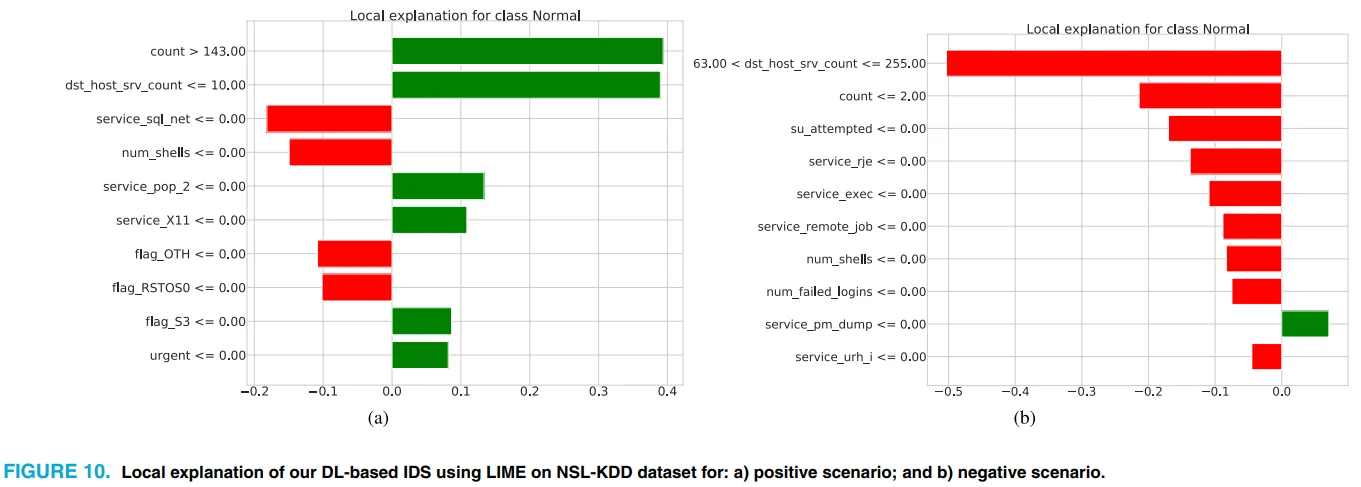

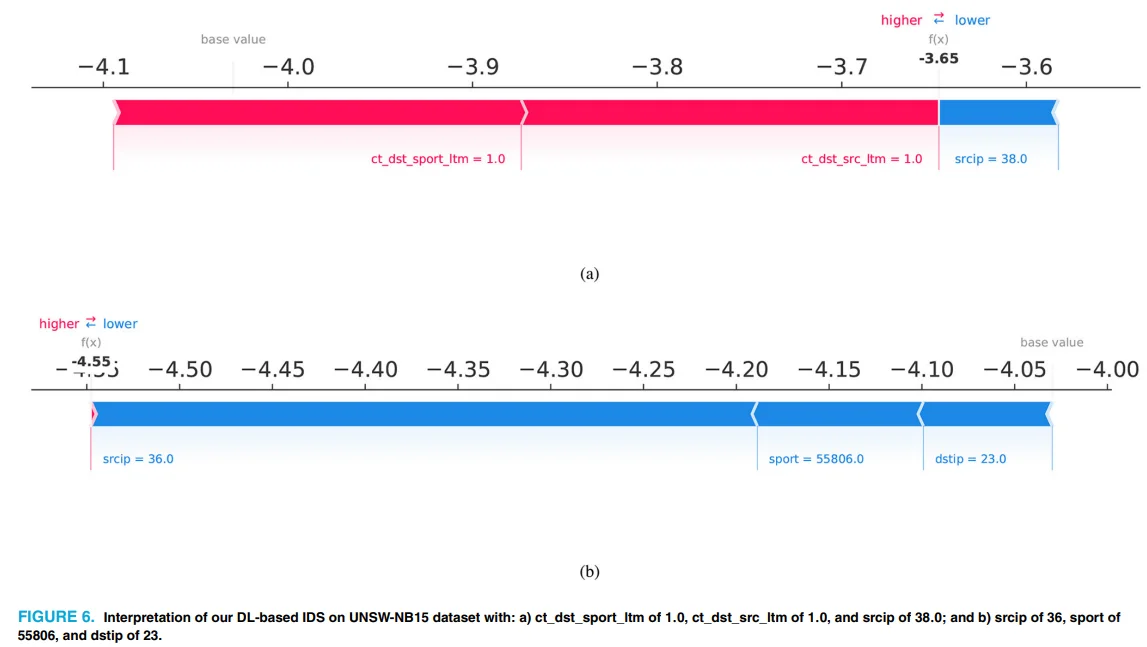

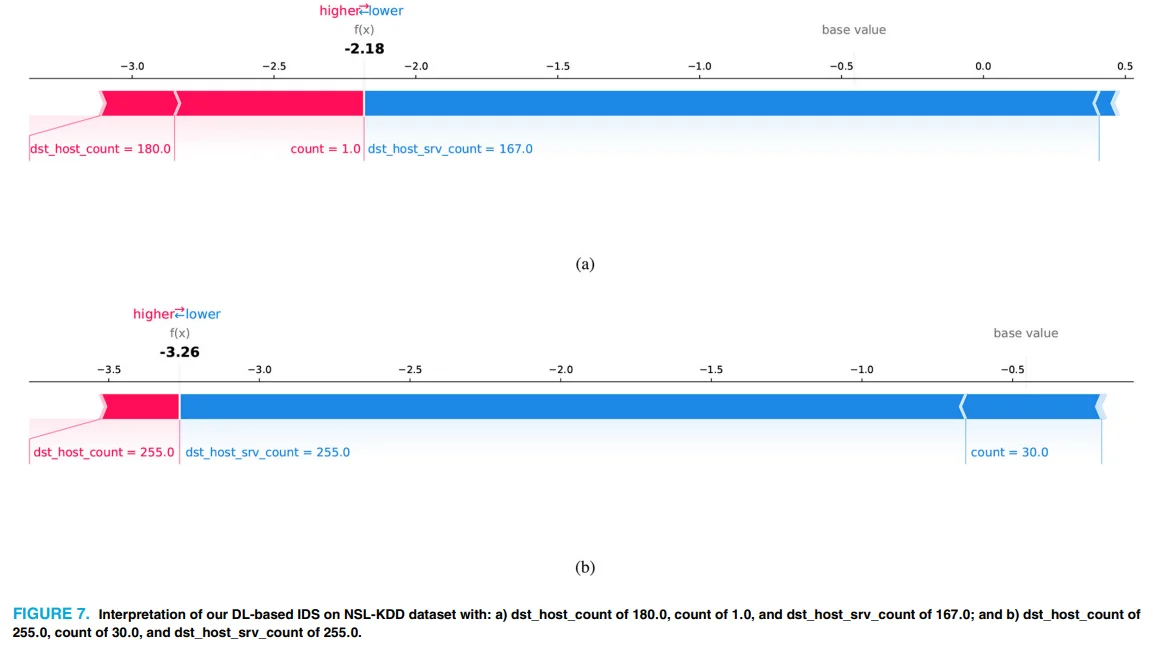

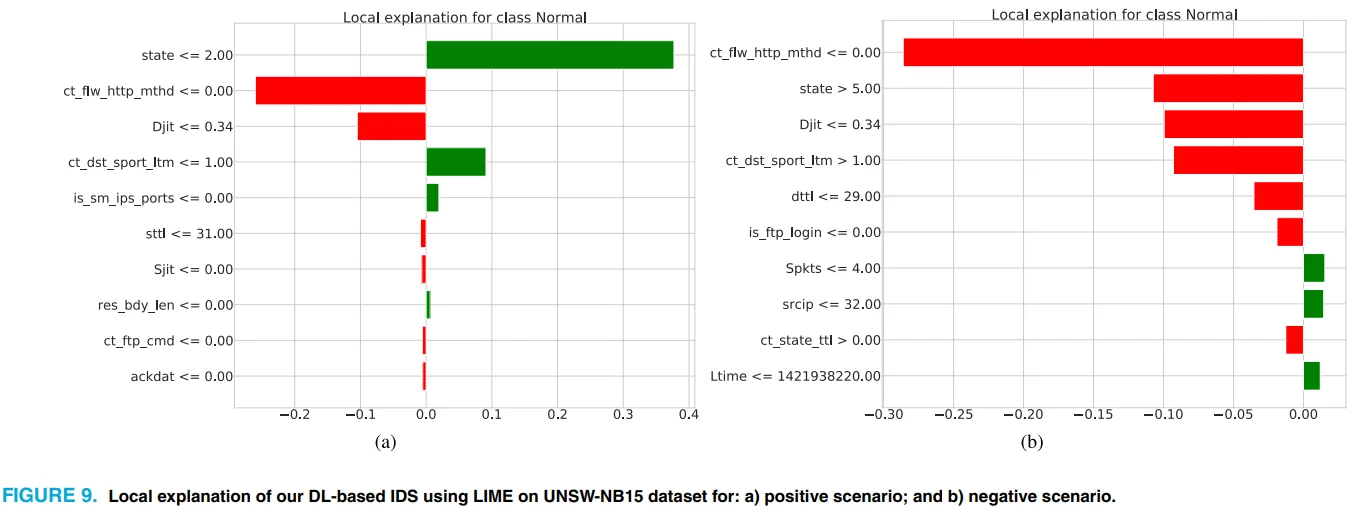

LIME:对某条具体数据样本给出局部解释;

RuleFit:通过规则提取找出预测依据;

这种“全局 + 局部 + 规则”的三重解释组合,使得研究者不仅知道结果,更能追踪“因果路径”。

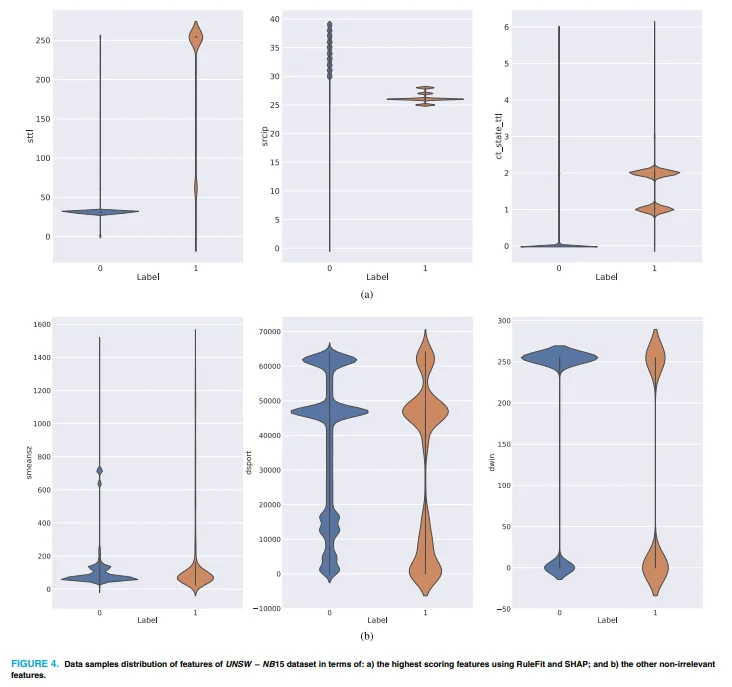

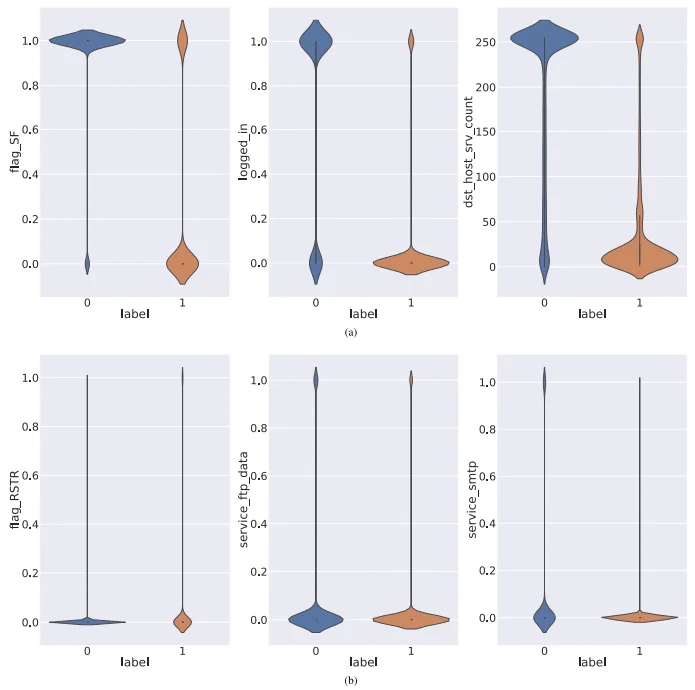

?可视化现成模板,用Python就能复刻出来

论文提供了大量可视化解释图,比如:

SHAP条形图(特征影响排序);

LIME解释图(单个预测的“理由”);

RuleFit得分图(高频规则提取);

这些图几乎都可以通过调用 SHAP/LIME 的 Python 库一键生成,不需要复杂自定义。对写论文或报告来说,这简直就是“图示素材包”,直接抄、轻松改、完美用。

?适合做改进实验,用它扩展你的创新空间

你不仅可以复现这篇论文的结构,还可以基于它扩展出自己的创新点:

加入 Attention 模块,增强模型解释性;

增加新的数据集(如 CICIDS2017)拓展实验维度;

提出自己的可解释性评价指标(如Fidelity、Robustness);

或者将其集成入边缘IoT设备,做小型部署测试。

?这篇论文不仅值得看,更值得“动手做”

相较于许多理论堆砌、实验晦涩的论文,这篇文章做到了“结构清、数据明、代码近”,是真正适合复现和拓展的好材料。它不仅展示了如何将深度模型“从黑变白”,更向你证明:你完全可以照着做出一个解释清晰、性能强劲的IDS系统。

#计算机 #代码复现

?结构简单但不简单,复现难度低,非常适合上手!

论文采用了 5层的前馈神经网络(DNN)结构,无复杂的Transformer或图网络,编程上用PyTorch即可完成,非常适合新手上手练习。更棒的是,它使用了两个广泛使用的公开数据集:NSL-KDD 与 UNSW-NB15,这两个数据集:

免费可下载,格式清晰;

有大量前人文献可作对比;

适合做二分类和多分类任务。

? 对于研究生来说,这种“数据+模型+代码方向都现成”的组合,是做实验、发论文的最佳起点之一。

?解释三件套上线,让模型说得清又看得懂

这篇论文最大亮点是整合了三种可解释性机制,帮助分析模型为什么做出某个判断:

SHAP:衡量特征对模型预测的整体影响;

LIME:对某条具体数据样本给出局部解释;

RuleFit:通过规则提取找出预测依据;

这种“全局 + 局部 + 规则”的三重解释组合,使得研究者不仅知道结果,更能追踪“因果路径”。

?可视化现成模板,用Python就能复刻出来

论文提供了大量可视化解释图,比如:

SHAP条形图(特征影响排序);

LIME解释图(单个预测的“理由”);

RuleFit得分图(高频规则提取);

这些图几乎都可以通过调用 SHAP/LIME 的 Python 库一键生成,不需要复杂自定义。对写论文或报告来说,这简直就是“图示素材包”,直接抄、轻松改、完美用。

?适合做改进实验,用它扩展你的创新空间

你不仅可以复现这篇论文的结构,还可以基于它扩展出自己的创新点:

加入 Attention 模块,增强模型解释性;

增加新的数据集(如 CICIDS2017)拓展实验维度;

提出自己的可解释性评价指标(如Fidelity、Robustness);

或者将其集成入边缘IoT设备,做小型部署测试。

?这篇论文不仅值得看,更值得“动手做”

相较于许多理论堆砌、实验晦涩的论文,这篇文章做到了“结构清、数据明、代码近”,是真正适合复现和拓展的好材料。它不仅展示了如何将深度模型“从黑变白”,更向你证明:你完全可以照着做出一个解释清晰、性能强劲的IDS系统。

#计算机 #代码复现