?【AI炼丹新思路】告别海量数据!WMDD用几何学“蒸馏”数据集,小样本训出强模型!

? 技术核爆点:

✅ WMDD:首创基于Wasserstein度量的数据集蒸馏,用“几何重心”精准保留原始数据分布的形状和结构。

✅ 少即是多:仅需极少量合成样本(如每类10-100张),即可训练出性能逼近使用全量数据的模型,实现极致“降本增效”。

✅ 效率与精度兼得:在高分辨率图像数据集(如ImageNet)上实现SOTA或强竞争力能,同时计算开销与主流高效方法相当。

? 革命性突破:

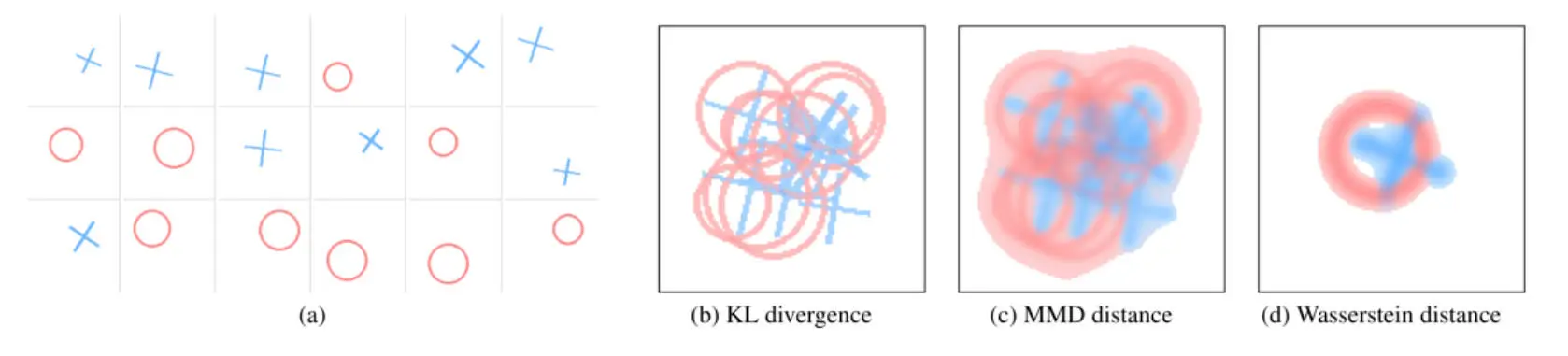

1️⃣ 几何保真蒸馏:首次将最优传输(OT)理论中的Wasserstein距离及其重心概念引入数据集蒸馏,从根本上解决了传统方法(如MMD均值匹配)难以保留数据分布几何结构(如形状、多样性)的痛点,让合成数据“形神兼备”。

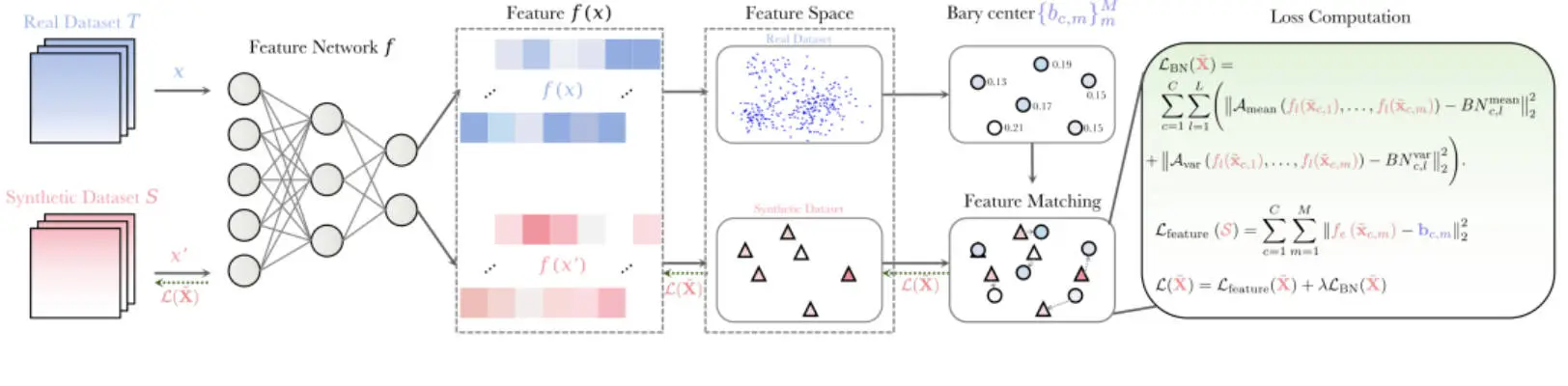

2️⃣ 特征空间精准对齐:巧妙地在预训练模型的深层特征空间进行分布对齐,而非原始像素空间,能更有效地捕捉数据的核心语义表征,并借助预训练模型的强大先验知识。

3️⃣ 创新PCBN正则化:提出“按类BatchNorm统计”(Per-Class BN)约束,在优化时独立对齐每个类别在网络中间层的统计量,有效避免了不同类别间的梯度干扰,更好地保持了类内结构和多样性。

? 实测数据炸裂:

性能逼近全量:在ImageNet-1K上,仅用100张/类(IPC=100)合成图像训练ResNet-18,Top-1准确率达60.7%,已非常接近使用128万张真实图像训练的63.1%。在Tiny-ImageNet等数据集上表现同样优异。

跨架构验证实力:用ResNet-18蒸馏的50 IPC数据,训练ResNet-50/101能持续带来性能增益;迁移到ViT-Tiny/Small架构上也有可观表现。

效率可观:受益于高效的最优传输求解算法,其训练时间和显存开销与当前最高效的分布匹配方法(如只匹配均值)处于同一数量级,但性能通常更优。

消融实验证实:Wasserstein重心匹配相比传统交叉熵损失、PCBN正则相比全局BN正则,均带来了稳定且显著的性能提升。

论文链接: https://arxiv.org/abs/2311.18531

代码链接: https://github.com/Liu-Hy/WMDD

?#数据集蒸馏 #人工智能 #机器学习 #ICCV #量子智心

本文由AI辅助生成

? 技术核爆点:

✅ WMDD:首创基于Wasserstein度量的数据集蒸馏,用“几何重心”精准保留原始数据分布的形状和结构。

✅ 少即是多:仅需极少量合成样本(如每类10-100张),即可训练出性能逼近使用全量数据的模型,实现极致“降本增效”。

✅ 效率与精度兼得:在高分辨率图像数据集(如ImageNet)上实现SOTA或强竞争力能,同时计算开销与主流高效方法相当。

? 革命性突破:

1️⃣ 几何保真蒸馏:首次将最优传输(OT)理论中的Wasserstein距离及其重心概念引入数据集蒸馏,从根本上解决了传统方法(如MMD均值匹配)难以保留数据分布几何结构(如形状、多样性)的痛点,让合成数据“形神兼备”。

2️⃣ 特征空间精准对齐:巧妙地在预训练模型的深层特征空间进行分布对齐,而非原始像素空间,能更有效地捕捉数据的核心语义表征,并借助预训练模型的强大先验知识。

3️⃣ 创新PCBN正则化:提出“按类BatchNorm统计”(Per-Class BN)约束,在优化时独立对齐每个类别在网络中间层的统计量,有效避免了不同类别间的梯度干扰,更好地保持了类内结构和多样性。

? 实测数据炸裂:

性能逼近全量:在ImageNet-1K上,仅用100张/类(IPC=100)合成图像训练ResNet-18,Top-1准确率达60.7%,已非常接近使用128万张真实图像训练的63.1%。在Tiny-ImageNet等数据集上表现同样优异。

跨架构验证实力:用ResNet-18蒸馏的50 IPC数据,训练ResNet-50/101能持续带来性能增益;迁移到ViT-Tiny/Small架构上也有可观表现。

效率可观:受益于高效的最优传输求解算法,其训练时间和显存开销与当前最高效的分布匹配方法(如只匹配均值)处于同一数量级,但性能通常更优。

消融实验证实:Wasserstein重心匹配相比传统交叉熵损失、PCBN正则相比全局BN正则,均带来了稳定且显著的性能提升。

论文链接: https://arxiv.org/abs/2311.18531

代码链接: https://github.com/Liu-Hy/WMDD

?#数据集蒸馏 #人工智能 #机器学习 #ICCV #量子智心

本文由AI辅助生成