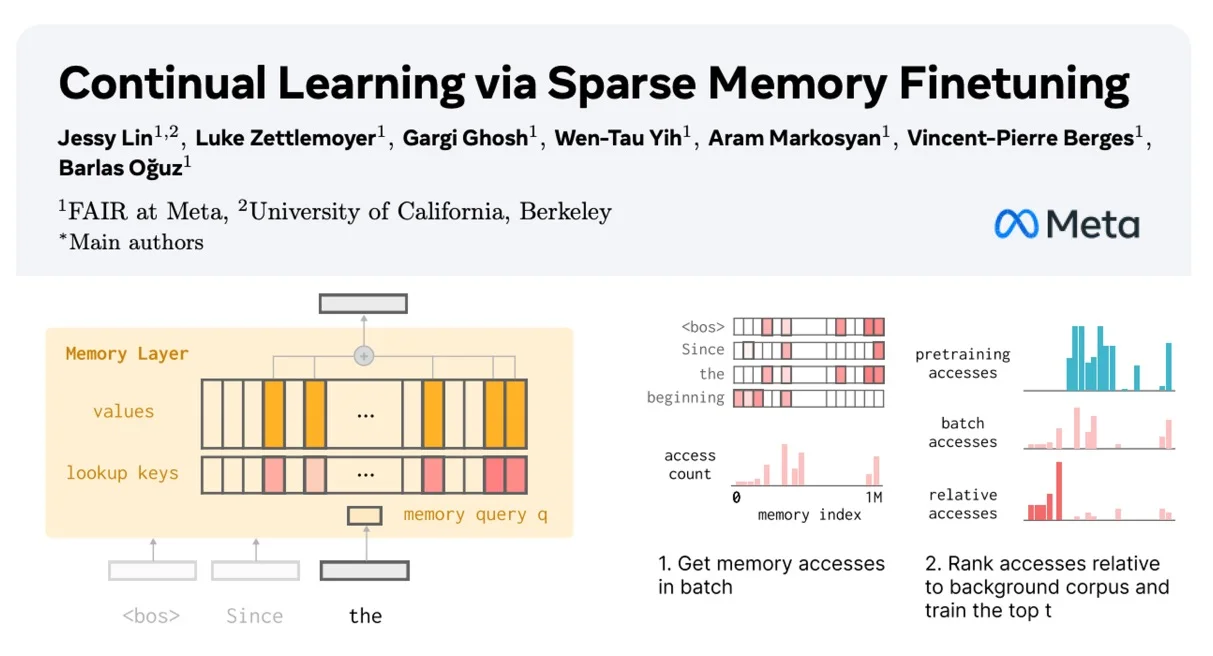

Meta在其新论文Continual Learning via Sparse Memory Finetuning中展示了如何对记忆层进行稀疏微调,从而能够针对不断学习进行有针对性的更新,同时对现有知识的影响极小。

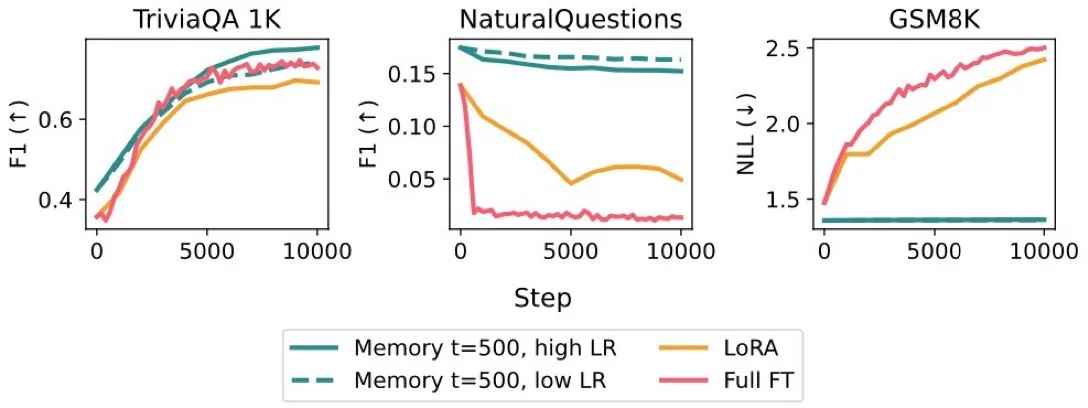

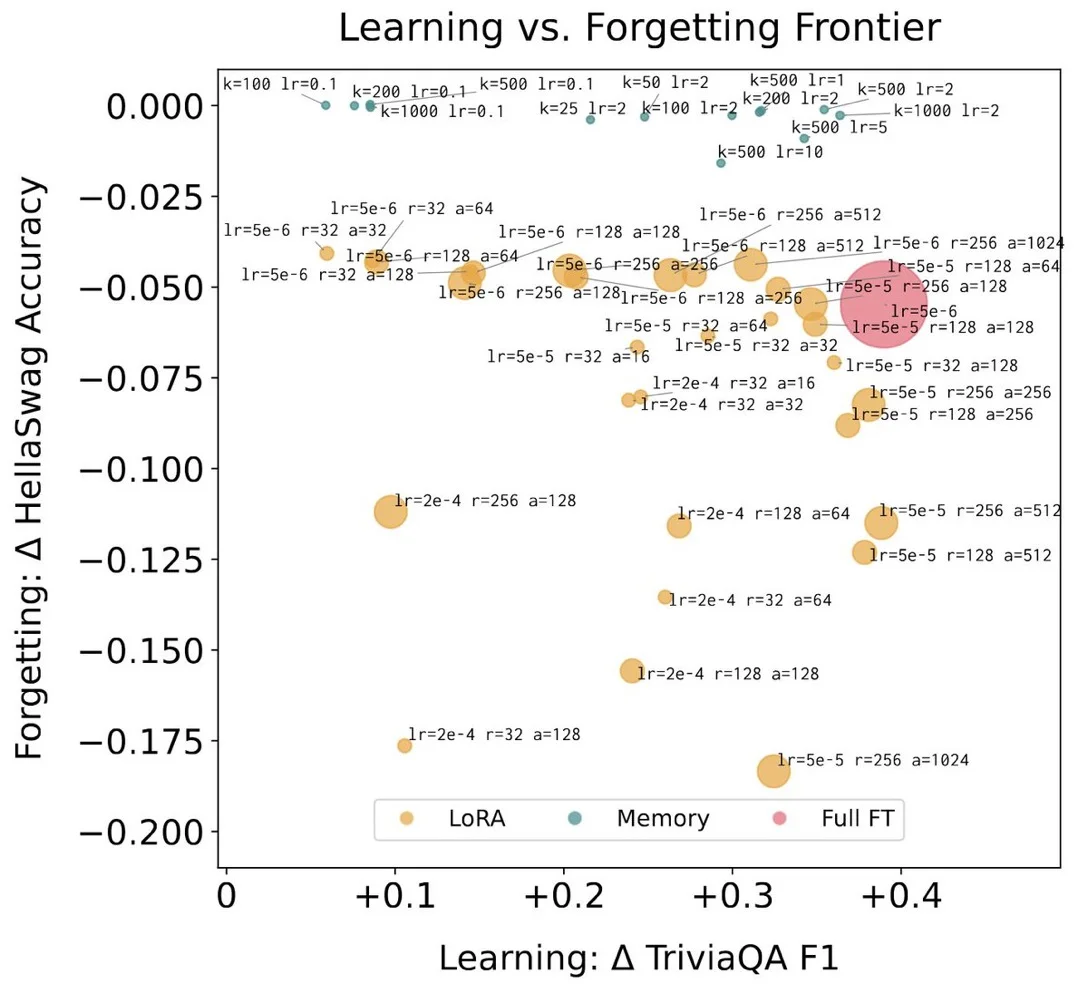

虽然全面微调和 LoRA 在测试任务中的表现大幅下降(事实学习任务方面:微调 -89%,LoRA -71%),但记忆层的学习效果却保持不变,且遗忘程度大幅降低(-11%)。

研究背景:要学习新知识,我们无需对大型模型的所有参数进行精细调整。这促使出现了参数效率高的持续学习/记忆方法,比如 LoRA 和 Cartridges,它们会在模型中添加一小部分参数。然而,LoRA 的容量天生就较小——一个小型的适配器无法适用于长期学习的需求。

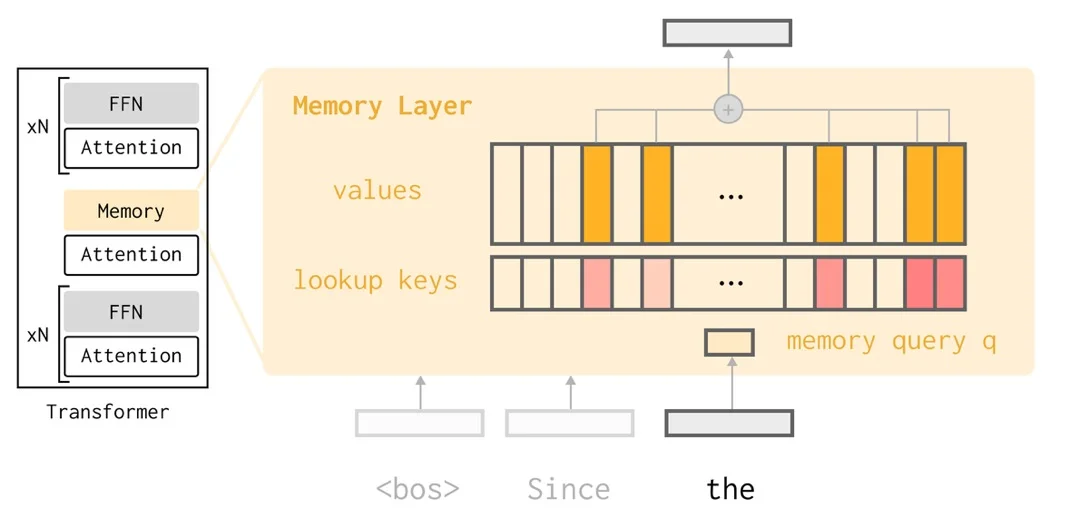

P2:在本文中,作者展示了近期提出的记忆层架构如何提供一种潜在的解决方案:用一个稀疏注意力查找机制来替代全连接神经网络(FFN),该查找机制会从一个庞大的已学习的记忆键值池中进行查找。这个架构能够对每个输入项所更新的参数进行精细控制。

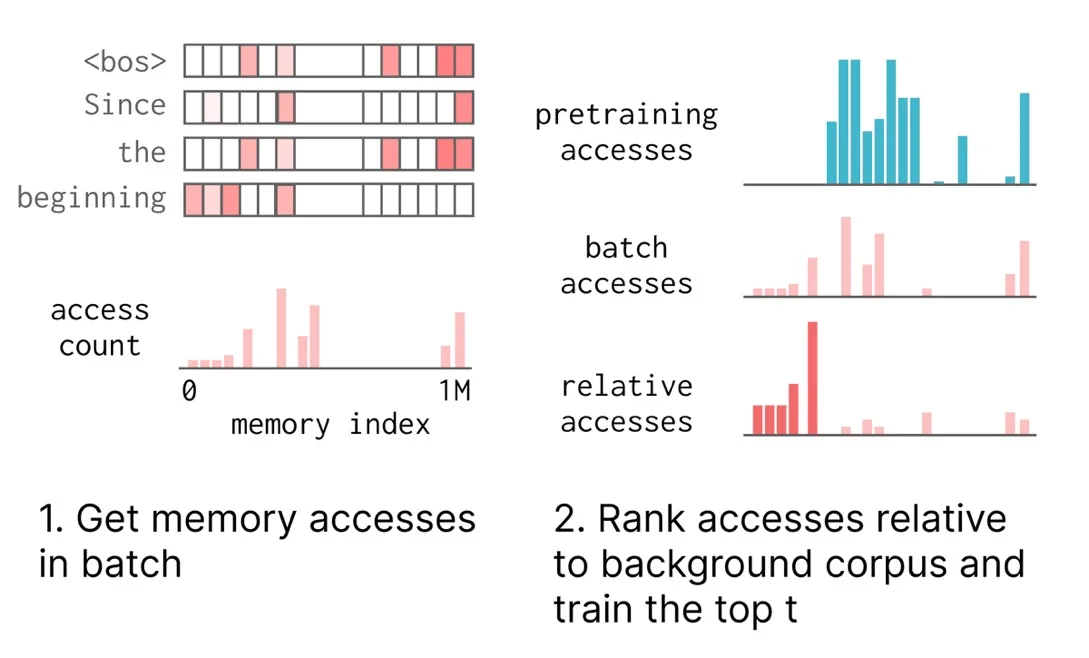

P3: 利用这种稀疏性,作者提议仅更新那些特定于某一特定输入的内存槽位——这些槽位在该输入上被频繁访问,但在其他数据(例如预训练数据)上访问频率较低,并且利用 TFIDF 对这些槽位进行排序。这实现了记忆的选择性。当了解到有关贝拉克·奥巴马的新信息时,我们只需要微调那些“存储”该信息的槽位,而无需触及那些负责例如了解如何编程等功能的参数。

P4:作者针对两个持续性的事实学习任务进行了评估:从一系列“TriviaQA”事实数据中进行学习,以及从“SimpleQA”中的一系列维基百科文档中进行学习。稀疏记忆微调的效果与完全微调和 LoRA 一样好,但在未测试任务中的表现却要好得多,而且还能实现有选择性的更新,从而减少了性能的下降。

?Paper: arxiv.org/abs/2510.15103

Blog:https://jessylin.com/2025/10/20/continual-learning/

#博士生 #大模型 #gpt #持续学习 #论文分享 #meta #lora #多模态人工智能 #ai

虽然全面微调和 LoRA 在测试任务中的表现大幅下降(事实学习任务方面:微调 -89%,LoRA -71%),但记忆层的学习效果却保持不变,且遗忘程度大幅降低(-11%)。

研究背景:要学习新知识,我们无需对大型模型的所有参数进行精细调整。这促使出现了参数效率高的持续学习/记忆方法,比如 LoRA 和 Cartridges,它们会在模型中添加一小部分参数。然而,LoRA 的容量天生就较小——一个小型的适配器无法适用于长期学习的需求。

P2:在本文中,作者展示了近期提出的记忆层架构如何提供一种潜在的解决方案:用一个稀疏注意力查找机制来替代全连接神经网络(FFN),该查找机制会从一个庞大的已学习的记忆键值池中进行查找。这个架构能够对每个输入项所更新的参数进行精细控制。

P3: 利用这种稀疏性,作者提议仅更新那些特定于某一特定输入的内存槽位——这些槽位在该输入上被频繁访问,但在其他数据(例如预训练数据)上访问频率较低,并且利用 TFIDF 对这些槽位进行排序。这实现了记忆的选择性。当了解到有关贝拉克·奥巴马的新信息时,我们只需要微调那些“存储”该信息的槽位,而无需触及那些负责例如了解如何编程等功能的参数。

P4:作者针对两个持续性的事实学习任务进行了评估:从一系列“TriviaQA”事实数据中进行学习,以及从“SimpleQA”中的一系列维基百科文档中进行学习。稀疏记忆微调的效果与完全微调和 LoRA 一样好,但在未测试任务中的表现却要好得多,而且还能实现有选择性的更新,从而减少了性能的下降。

?Paper: arxiv.org/abs/2510.15103

Blog:https://jessylin.com/2025/10/20/continual-learning/

#博士生 #大模型 #gpt #持续学习 #论文分享 #meta #lora #多模态人工智能 #ai