想从大模型框架的使用者进阶为专家,必须掌握vLLM和SGLang的核心实现原理。

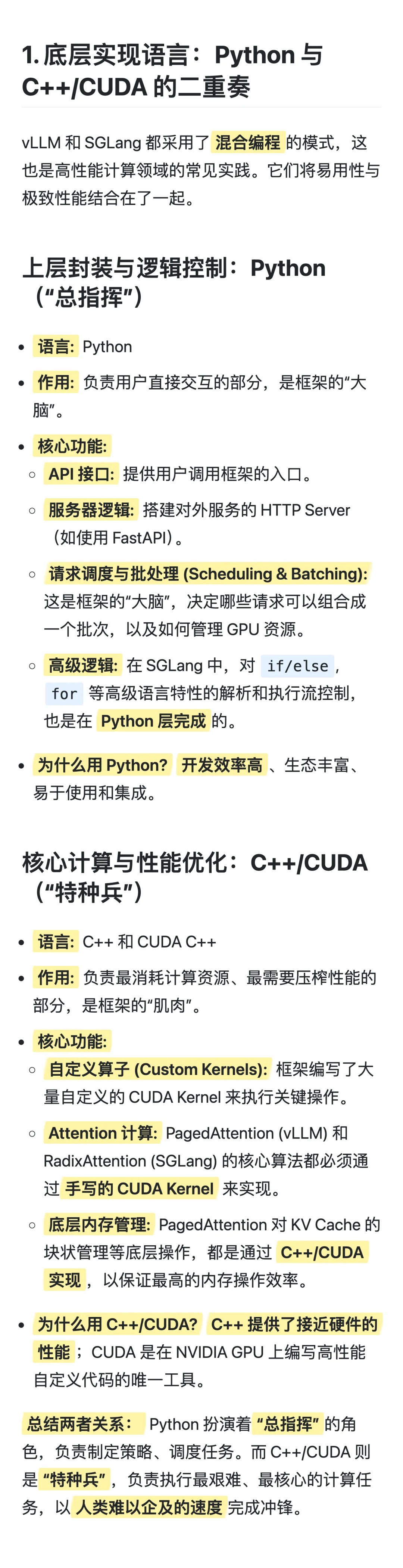

**底层语言揭秘:**

1. Python负责上层逻辑控制和API接口,是框架的“总指挥”。

2. C++/CUDA实现核心计算和自定义算子,是性能优化的“特种兵”。

3. 混合编程结合了开发效率和极致性能,是高性能计算的常见模式。

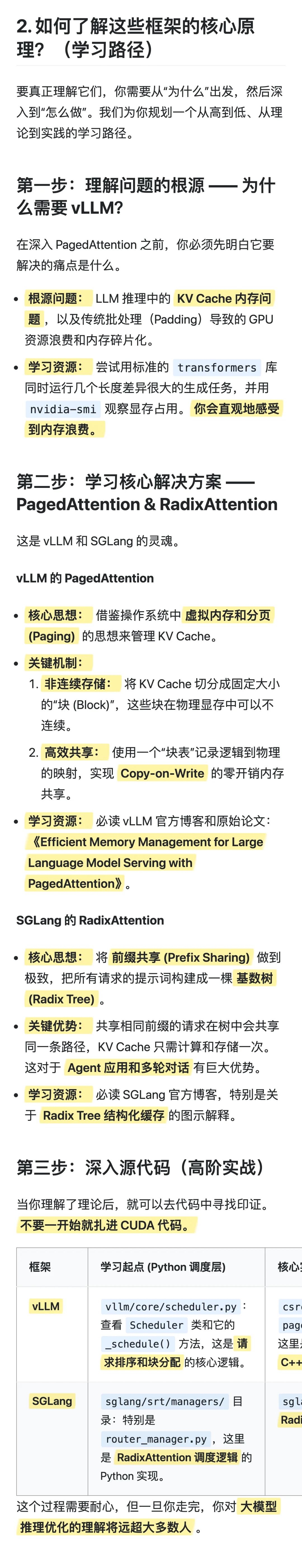

**学习路径:**

1. 理解LLM推理中KV Cache的内存痛点,这是优化的根源。

2. 深入学习PagedAttention(vLLM)和RadixAttention(SGLang)的核心思想。

3. 从Python调度器入手,逐步研究C++/CUDA的底层算子实现。

掌握这种软硬结合的架构,能让你对大模型推理优化有更深层次的理解。

#AI #大厂 #面试 #干货 #分享 #技术 #AI #大厂

**底层语言揭秘:**

1. Python负责上层逻辑控制和API接口,是框架的“总指挥”。

2. C++/CUDA实现核心计算和自定义算子,是性能优化的“特种兵”。

3. 混合编程结合了开发效率和极致性能,是高性能计算的常见模式。

**学习路径:**

1. 理解LLM推理中KV Cache的内存痛点,这是优化的根源。

2. 深入学习PagedAttention(vLLM)和RadixAttention(SGLang)的核心思想。

3. 从Python调度器入手,逐步研究C++/CUDA的底层算子实现。

掌握这种软硬结合的架构,能让你对大模型推理优化有更深层次的理解。

#AI #大厂 #面试 #干货 #分享 #技术 #AI #大厂