刷到一篇Meta团队的新工作,关于怎么给智能眼镜这类穿戴设备装上一个更聪明的大脑,还挺有意思的。

现在大家都用智能眼镜看世界,看到啥就想问问AI。比如“这栋楼有啥历史?” 或者 “这款零食含糖吗?”。这就需要用到多模态检索增强生成(MM-RAG)技术,让AI不仅能看懂图片,还能上网找资料来回答。但目前还没有一个全面的“考纲”来衡量AI到底做得好不好,尤其是在模拟真实视角(第一人称、图片质量差)的情况下。

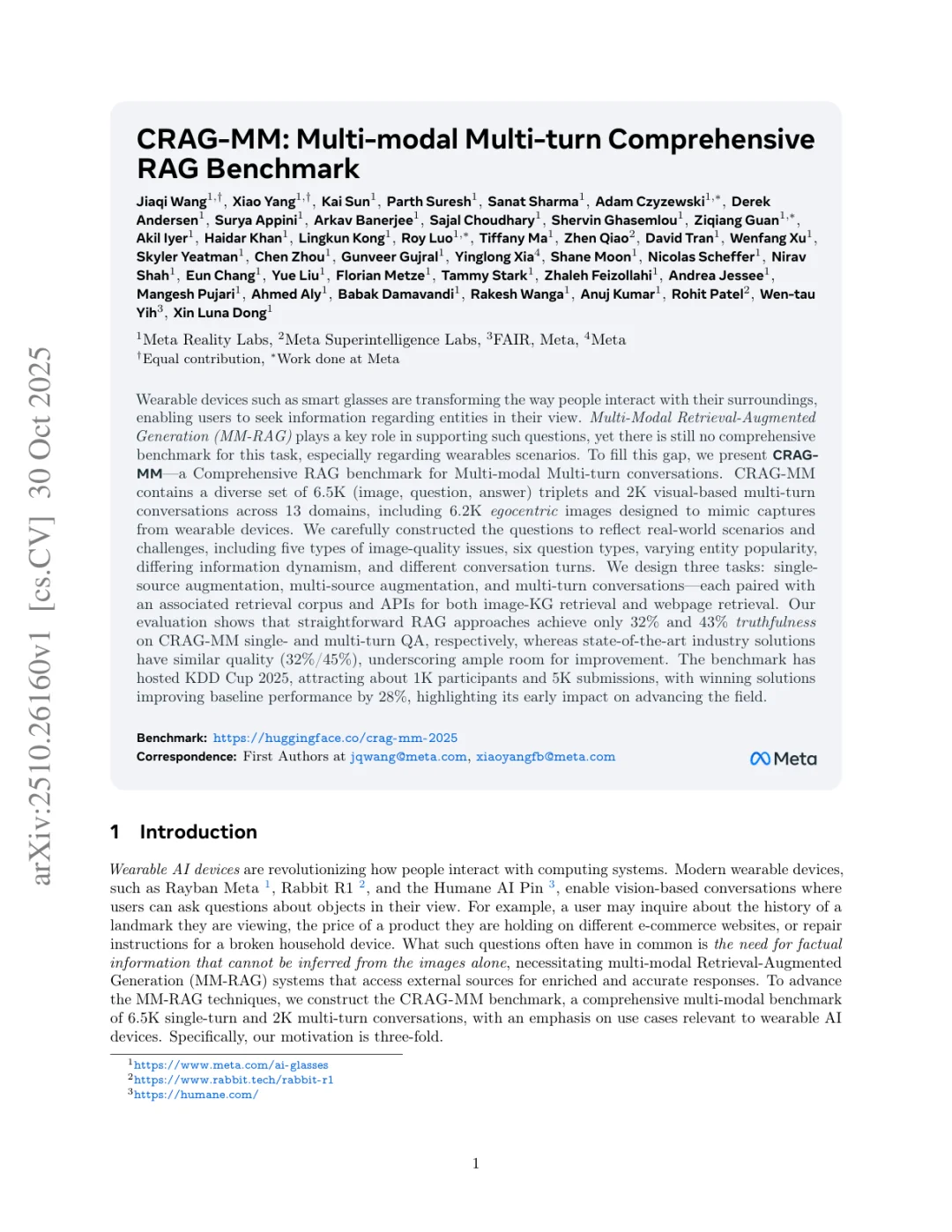

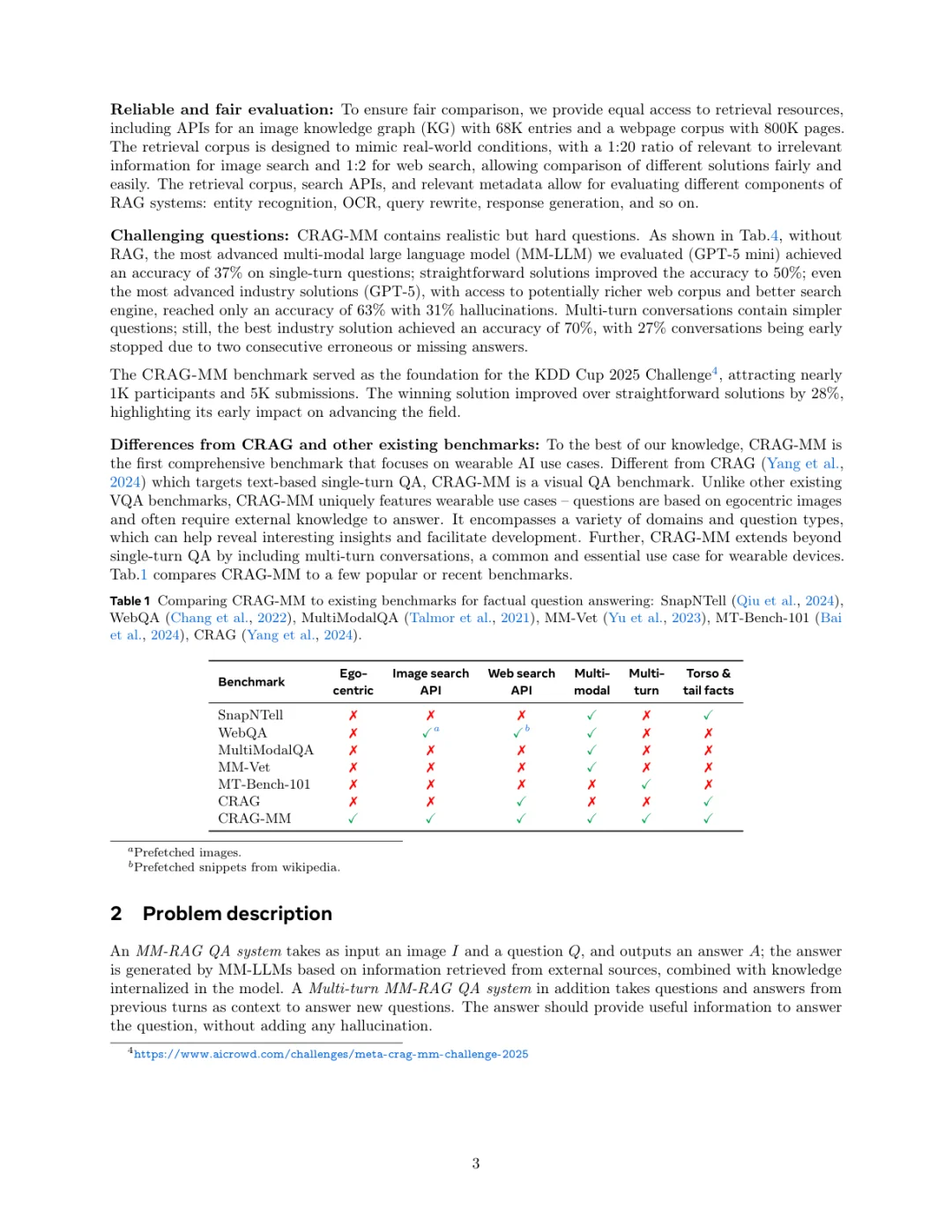

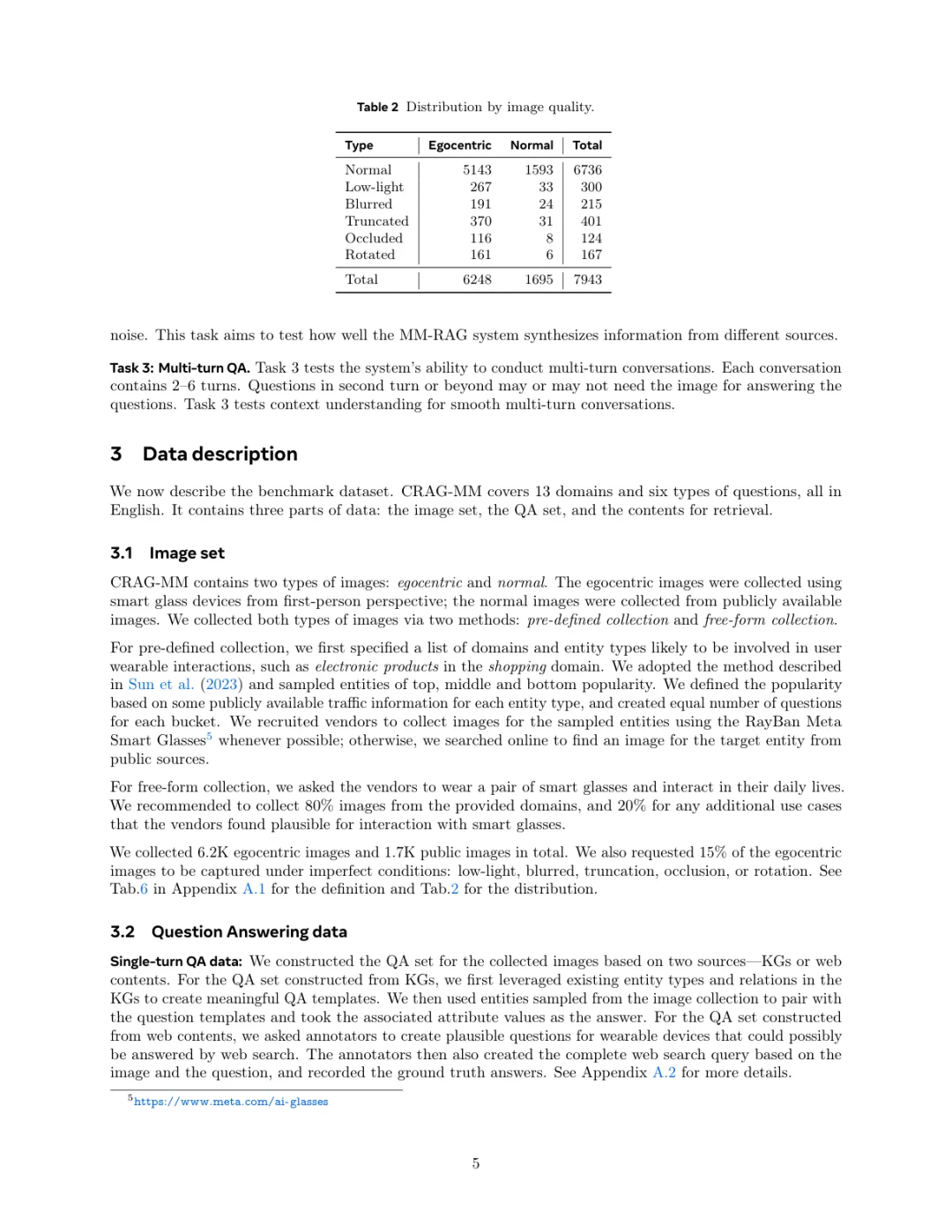

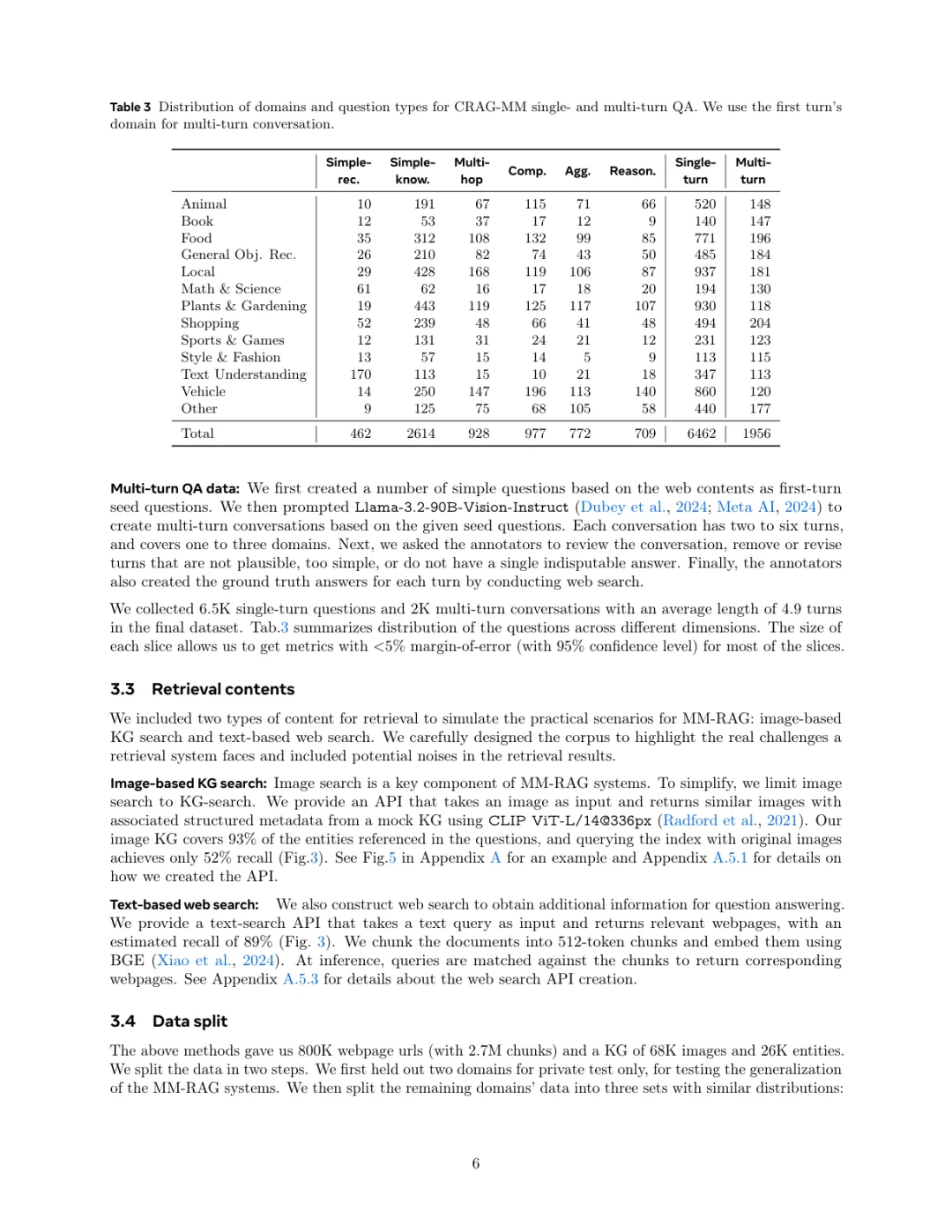

所以Meta团队推出了CRAG-MM,一个专为穿戴设备场景设计的多模态、多轮对话RAG基准。他们构建了一个大数据集,包含了6500组图文问答对和2000组多轮对话。这些数据很特别,大部分都是模拟智能眼镜拍出来的第一视角照片,还故意加入了模糊、遮挡这些真实世界里会遇到的图像问题。

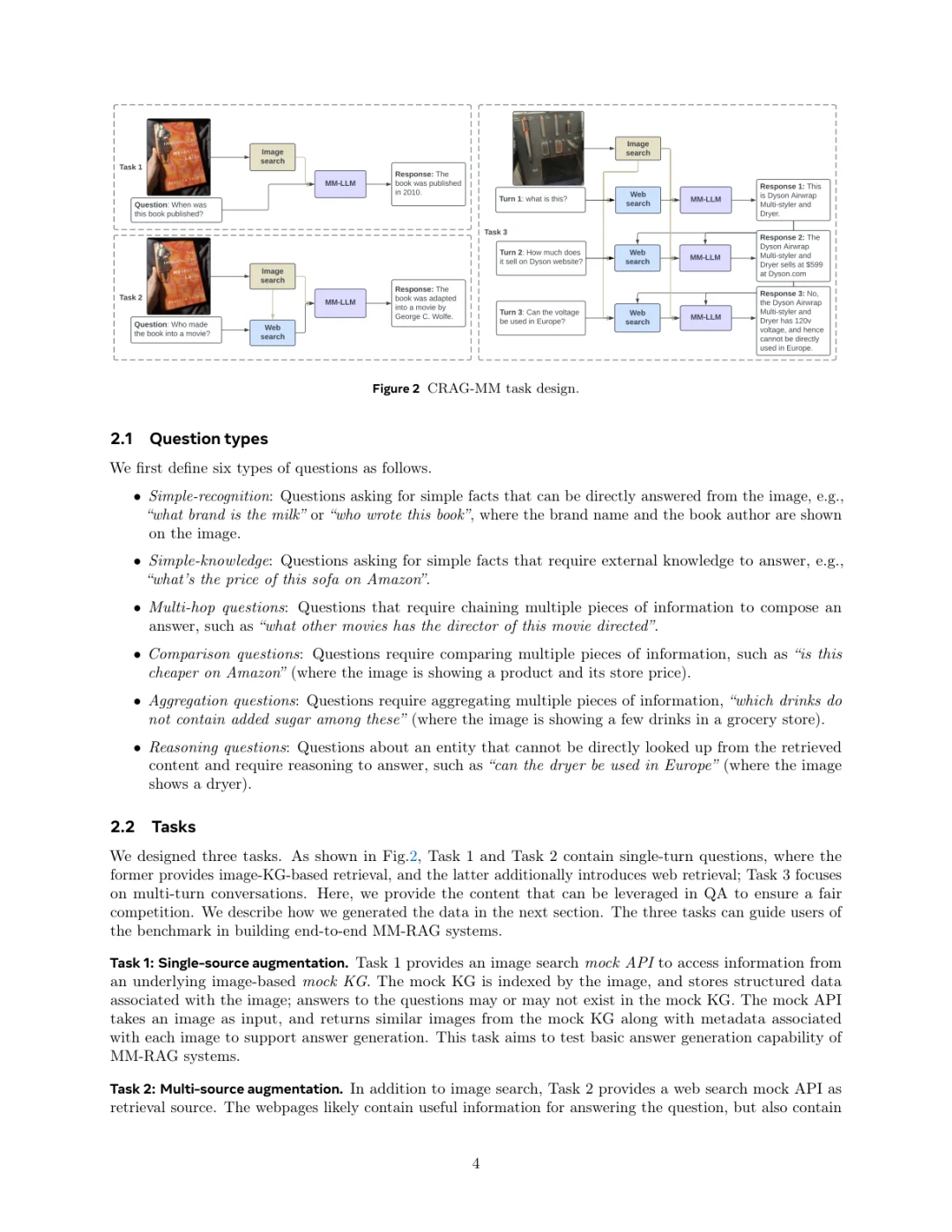

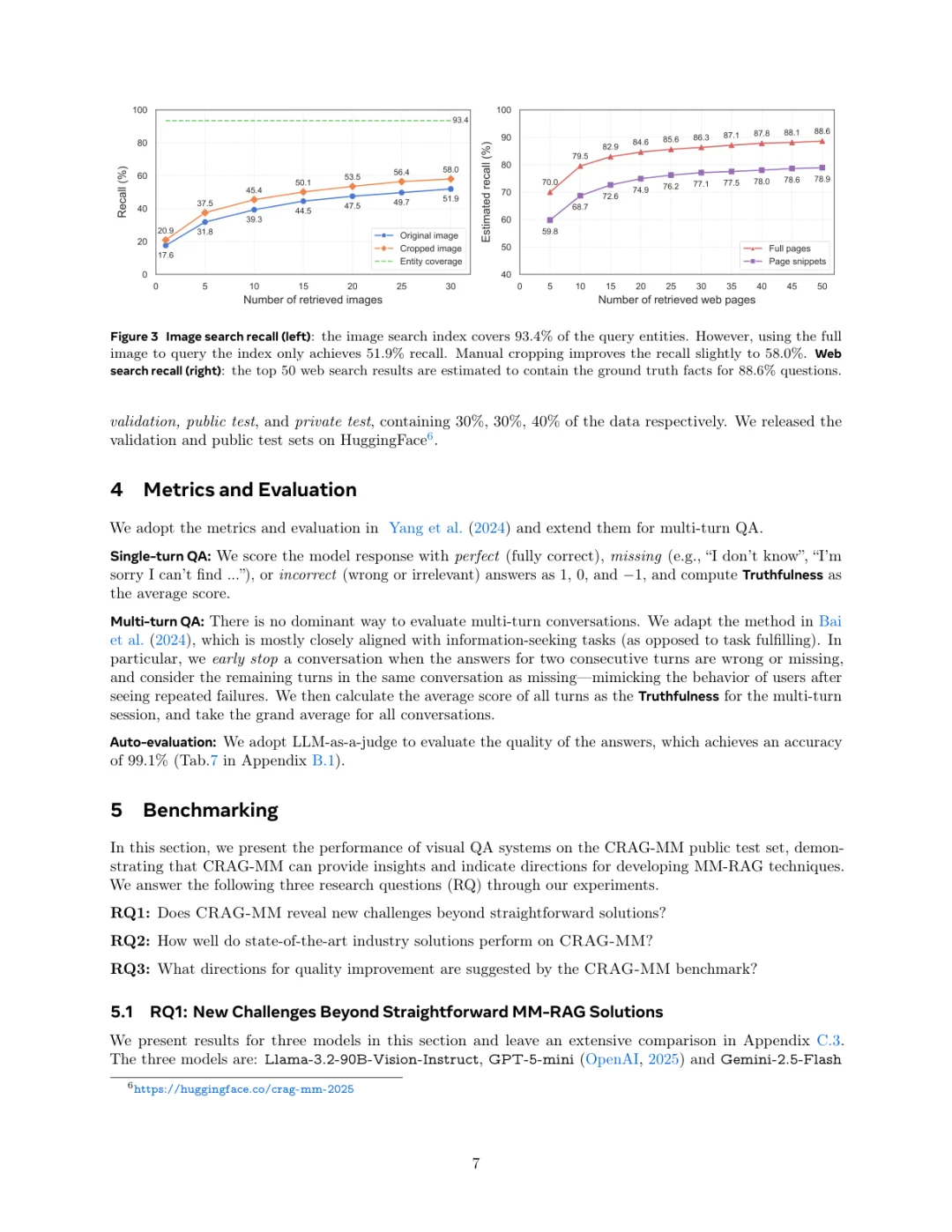

这个工作的创新点我觉得很实在。首先,它非常贴近真实场景,专门针对第一人称视角和各种低质量图像,这是以前的基准很少覆盖的。其次,它不只是一个数据集,还设计了三个具体的评测任务:单源检索、多源检索、多轮对话,并且提供了配套的知识库和网页检索API,相当于搭建了一整个考场。更厉害的是,它已经被用作KDD Cup 2025的赛题,吸引了上千人参与,说明这个基准的价值已经得到了业界的认可。

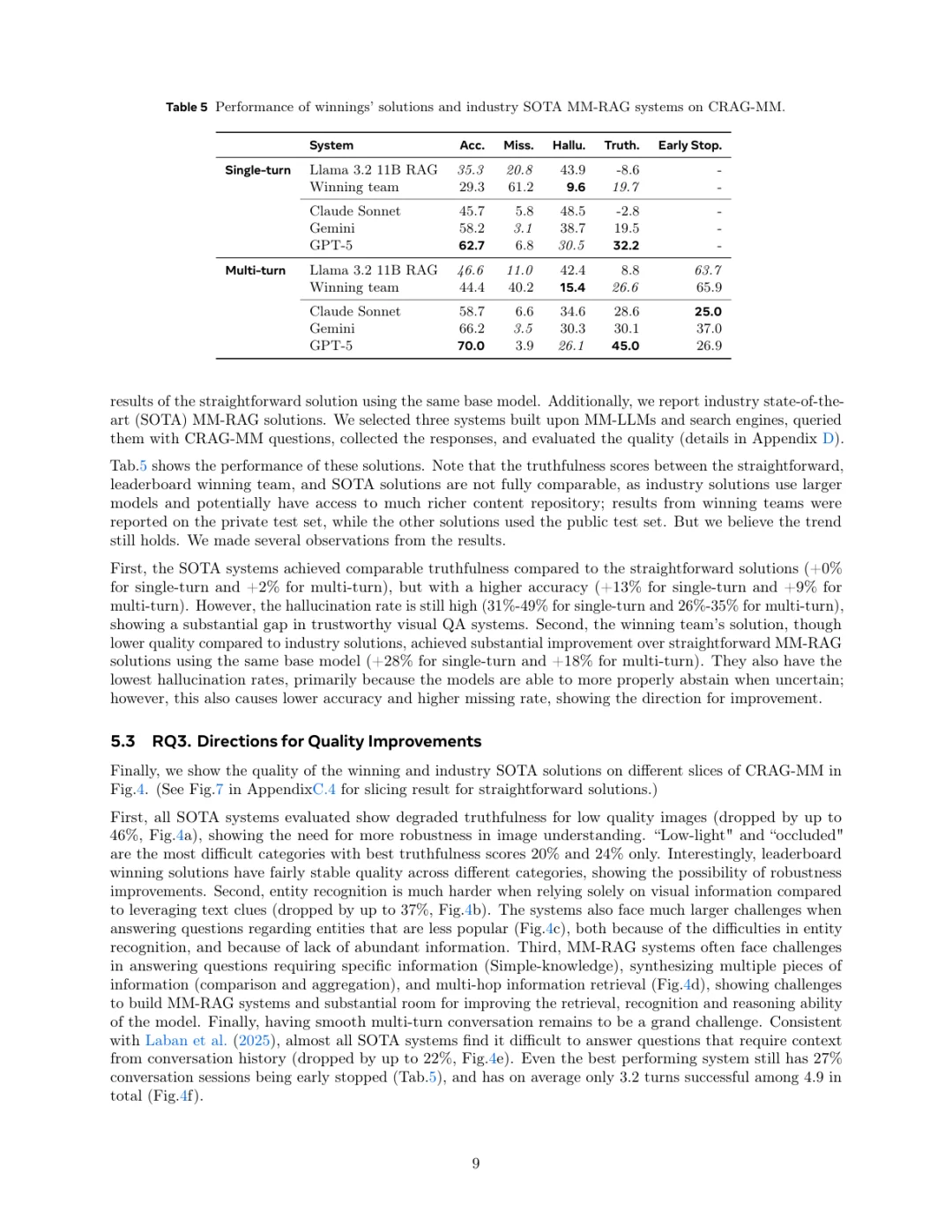

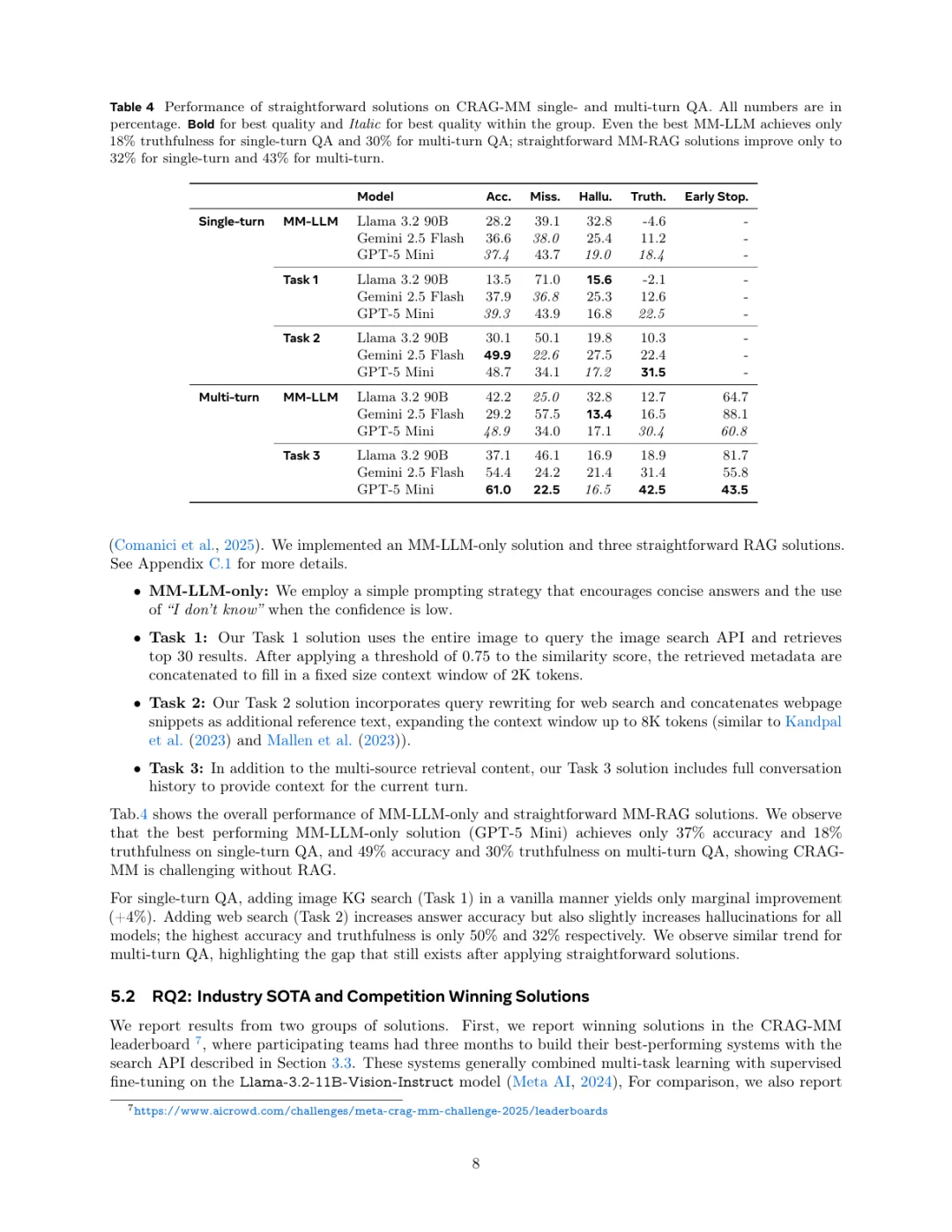

那现在的模型表现如何呢?结果有点扎心。他们测试发现,即便是当前最强的模型,在单轮和多轮问答上的回答真实性也只有32%和45%左右。这说明,让AI戴上眼镜看懂世界,并且准确回答问题,还有很长的路要走。不过好消息是,KDD Cup上的优胜方案已经把基线性能提升了28%,说明这个领域在快速进步。

CRAG-MM这个工作不仅指出了当前MM-RAG技术在实际应用中的短板,也为未来的研究指明了方向,提供了一个非常好的工具和平台。期待后续能看到更多基于这个基准的突破性进展。

【论文主题】Multi-modal RAG, Benchmark, Wearable AI

【论文arxiv链接】https://arxiv.org/abs/2510.26160

【论文发表年月】2025年10月

#AI #RAG #多模态 #Benchmark #Meta #人工智能 #论文解读 #前沿科技

现在大家都用智能眼镜看世界,看到啥就想问问AI。比如“这栋楼有啥历史?” 或者 “这款零食含糖吗?”。这就需要用到多模态检索增强生成(MM-RAG)技术,让AI不仅能看懂图片,还能上网找资料来回答。但目前还没有一个全面的“考纲”来衡量AI到底做得好不好,尤其是在模拟真实视角(第一人称、图片质量差)的情况下。

所以Meta团队推出了CRAG-MM,一个专为穿戴设备场景设计的多模态、多轮对话RAG基准。他们构建了一个大数据集,包含了6500组图文问答对和2000组多轮对话。这些数据很特别,大部分都是模拟智能眼镜拍出来的第一视角照片,还故意加入了模糊、遮挡这些真实世界里会遇到的图像问题。

这个工作的创新点我觉得很实在。首先,它非常贴近真实场景,专门针对第一人称视角和各种低质量图像,这是以前的基准很少覆盖的。其次,它不只是一个数据集,还设计了三个具体的评测任务:单源检索、多源检索、多轮对话,并且提供了配套的知识库和网页检索API,相当于搭建了一整个考场。更厉害的是,它已经被用作KDD Cup 2025的赛题,吸引了上千人参与,说明这个基准的价值已经得到了业界的认可。

那现在的模型表现如何呢?结果有点扎心。他们测试发现,即便是当前最强的模型,在单轮和多轮问答上的回答真实性也只有32%和45%左右。这说明,让AI戴上眼镜看懂世界,并且准确回答问题,还有很长的路要走。不过好消息是,KDD Cup上的优胜方案已经把基线性能提升了28%,说明这个领域在快速进步。

CRAG-MM这个工作不仅指出了当前MM-RAG技术在实际应用中的短板,也为未来的研究指明了方向,提供了一个非常好的工具和平台。期待后续能看到更多基于这个基准的突破性进展。

【论文主题】Multi-modal RAG, Benchmark, Wearable AI

【论文arxiv链接】https://arxiv.org/abs/2510.26160

【论文发表年月】2025年10月

#AI #RAG #多模态 #Benchmark #Meta #人工智能 #论文解读 #前沿科技