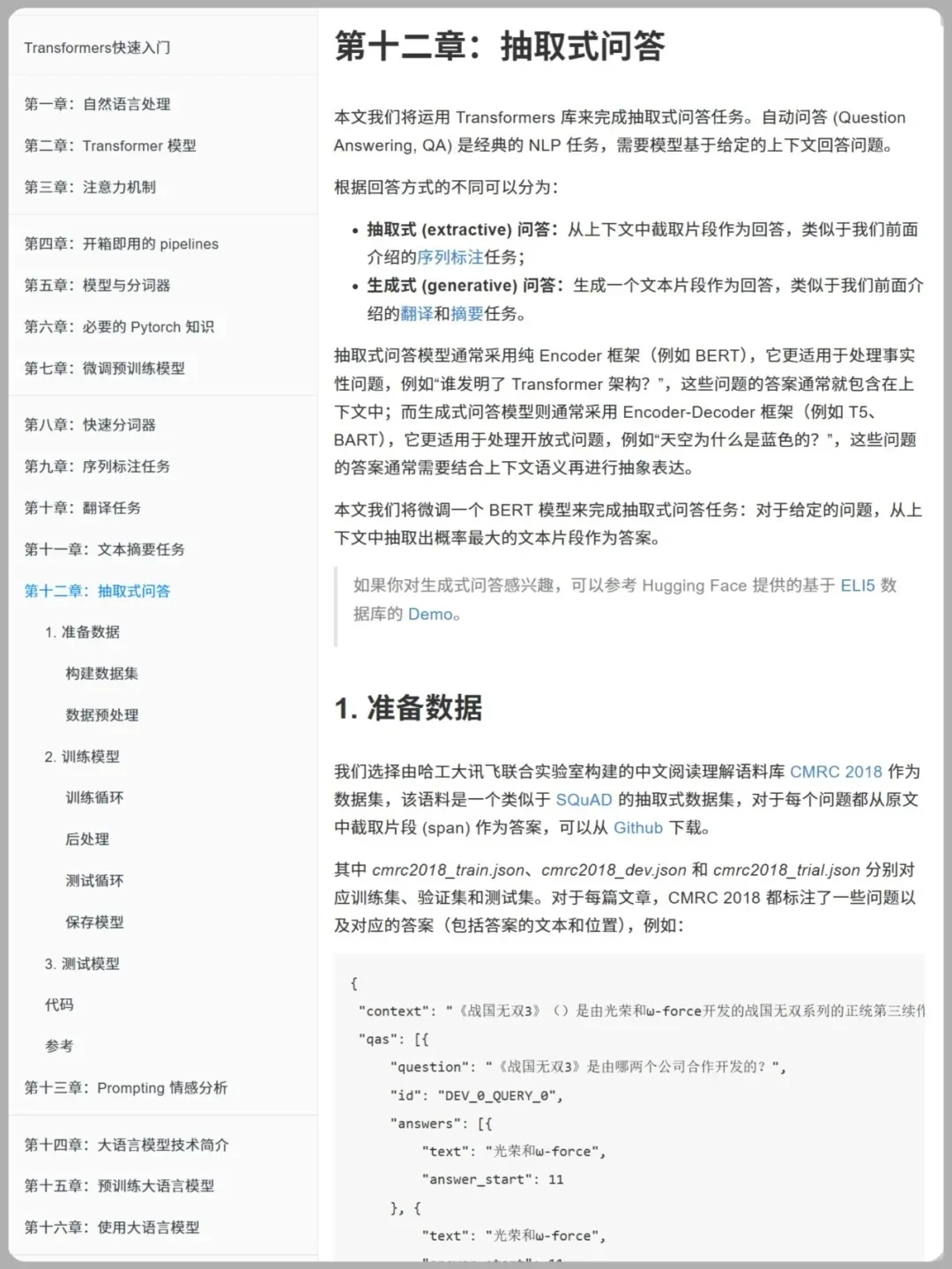

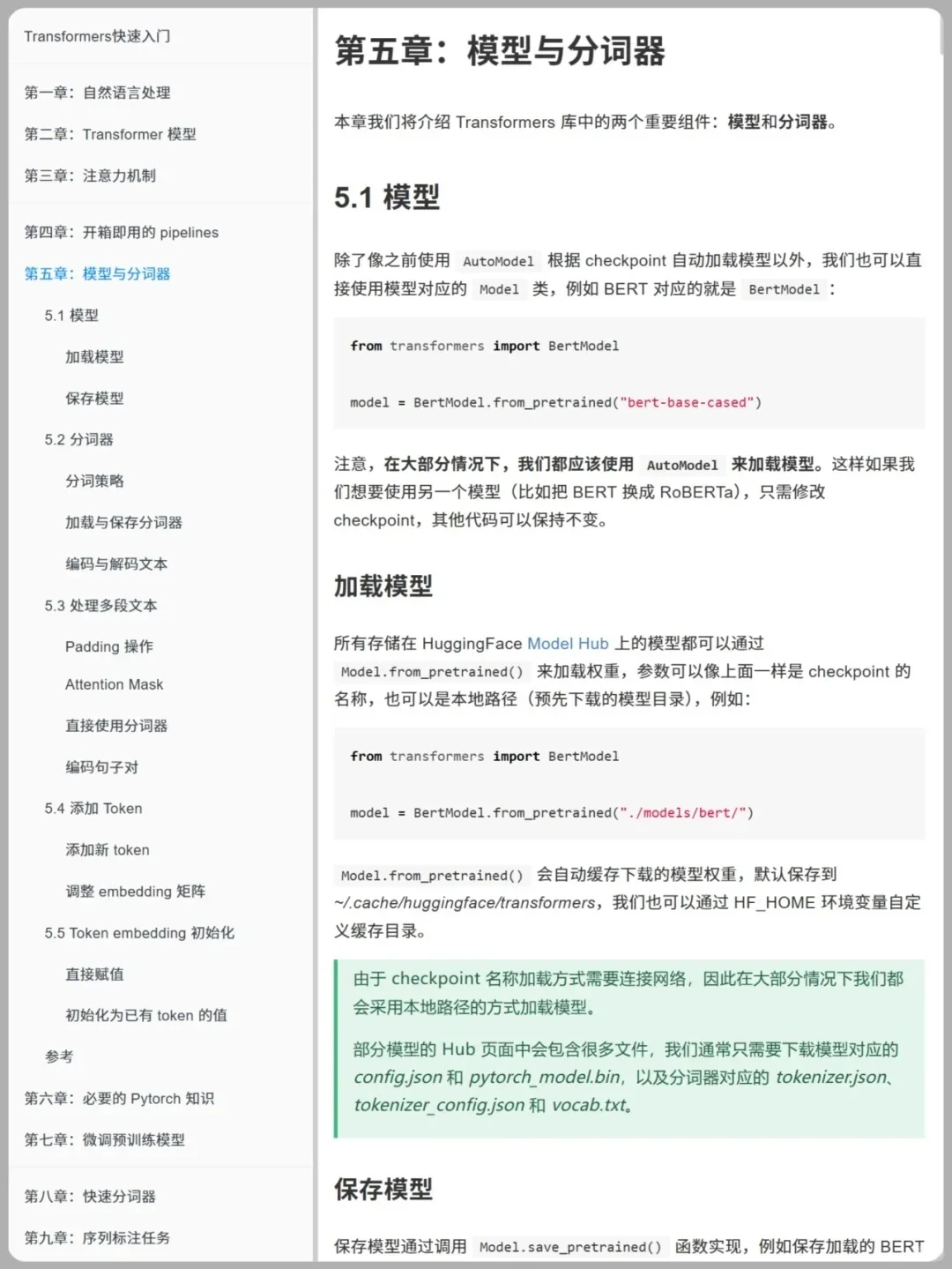

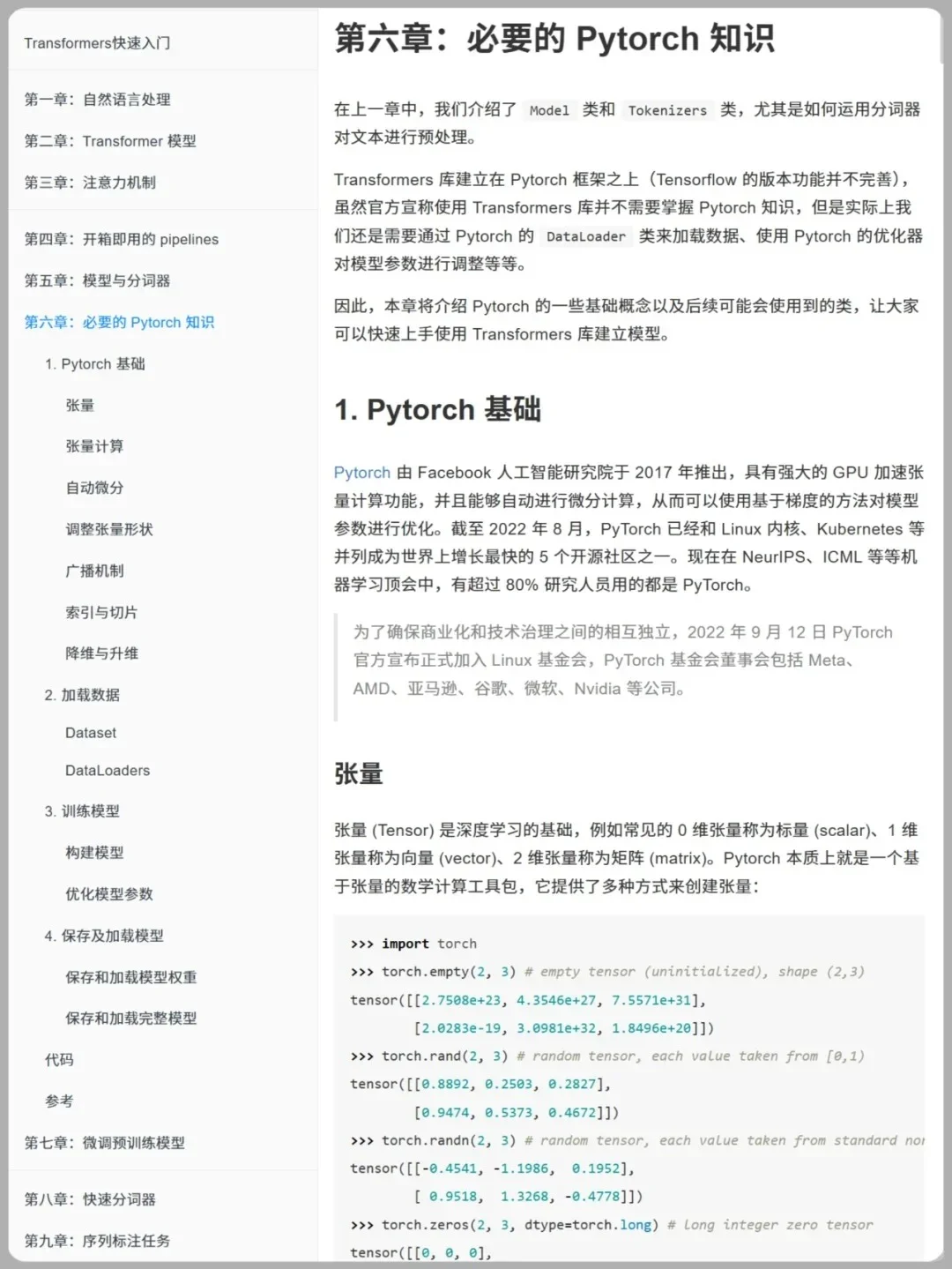

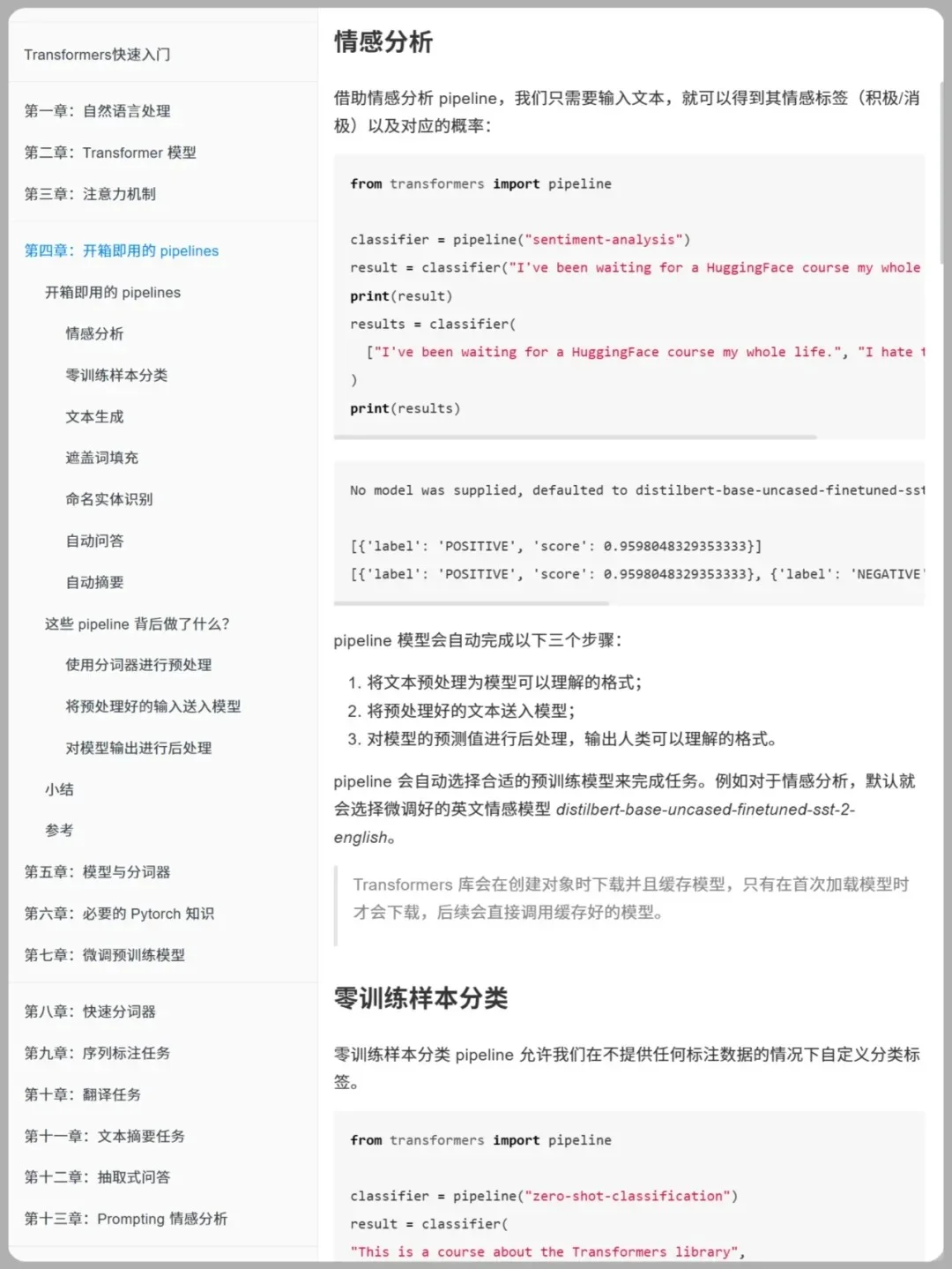

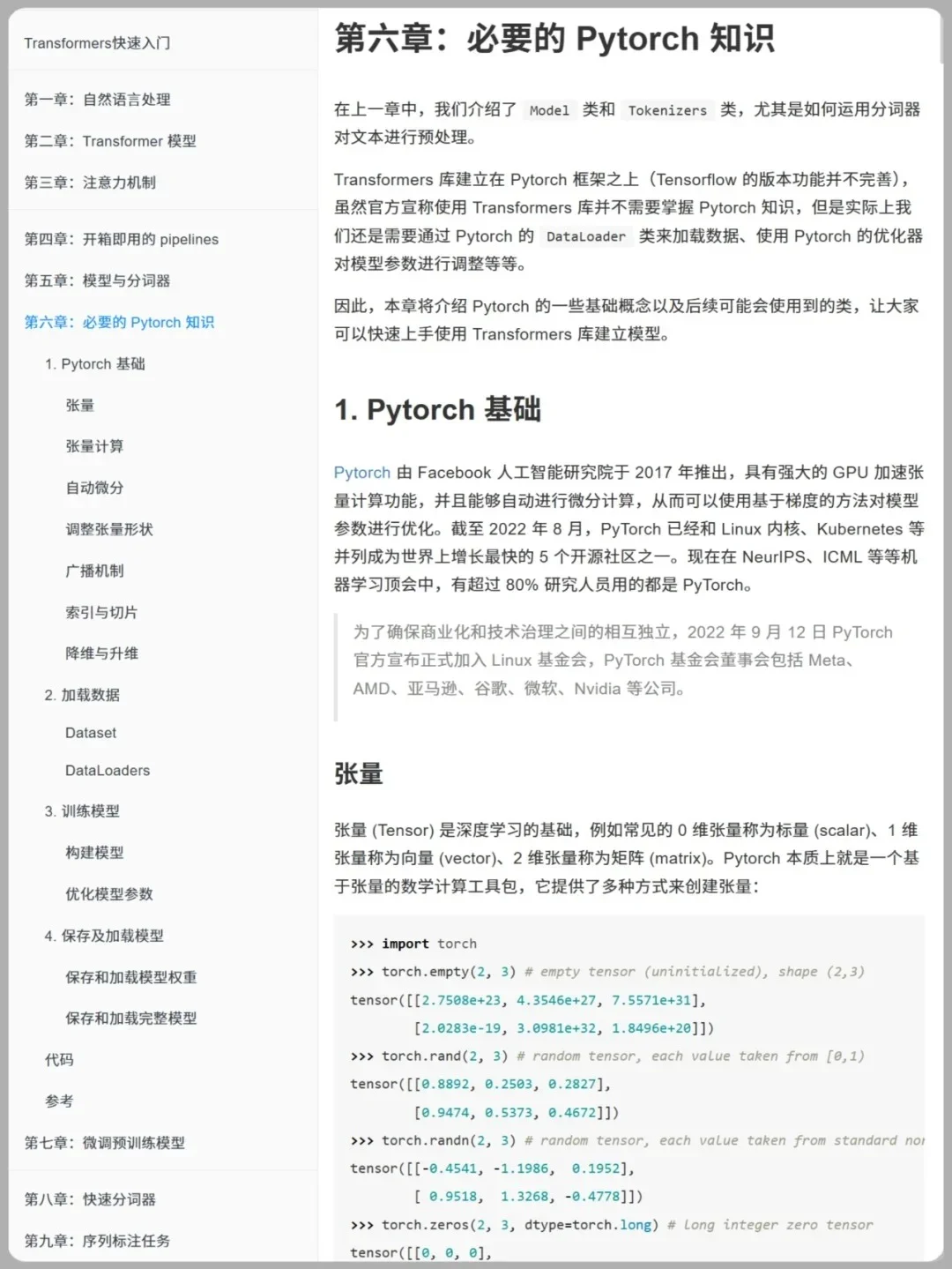

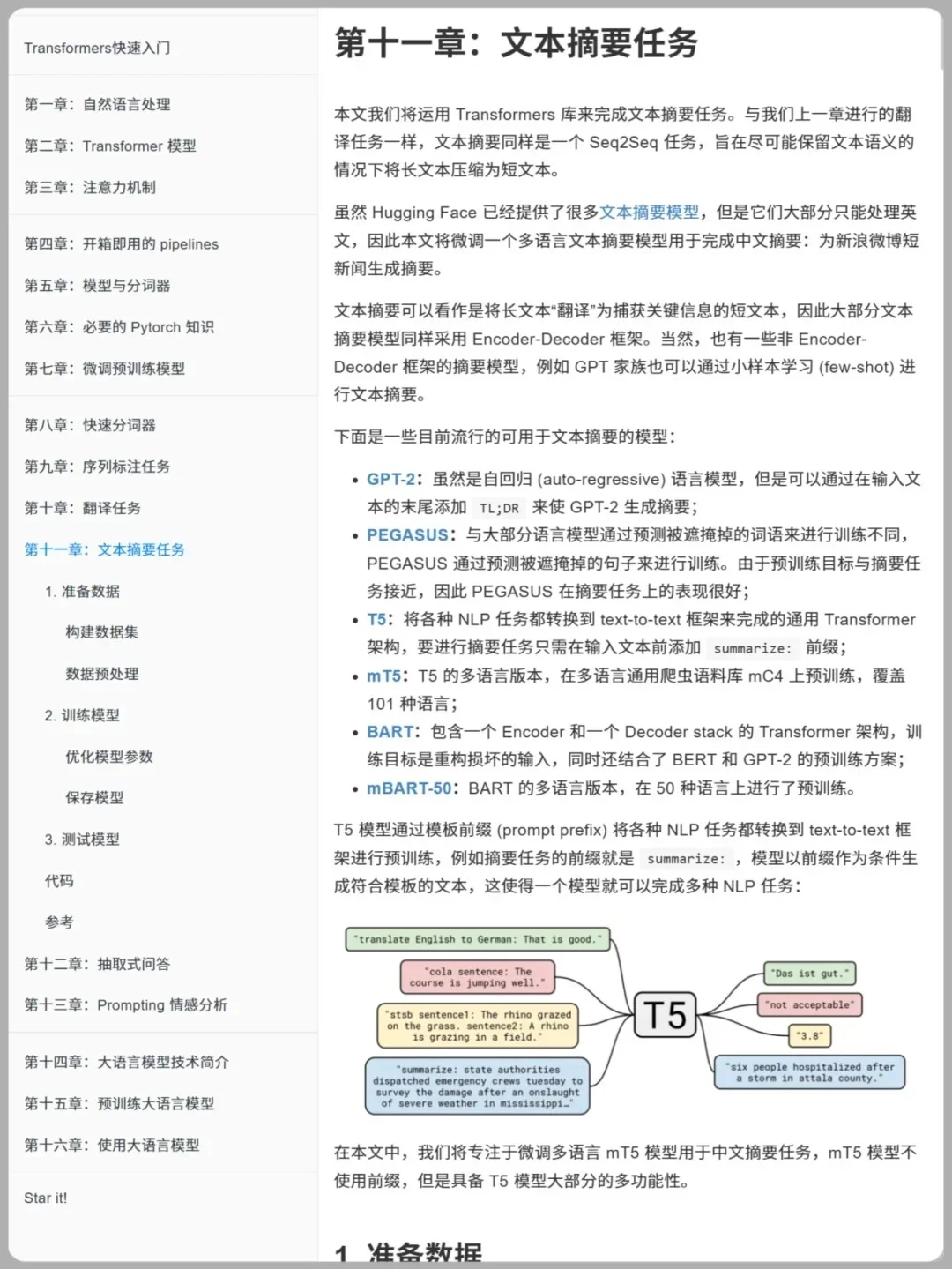

?гҖҠTransformer 7 еӨ§жөҒйҮҸеҜҶз ҒгҖӢ?

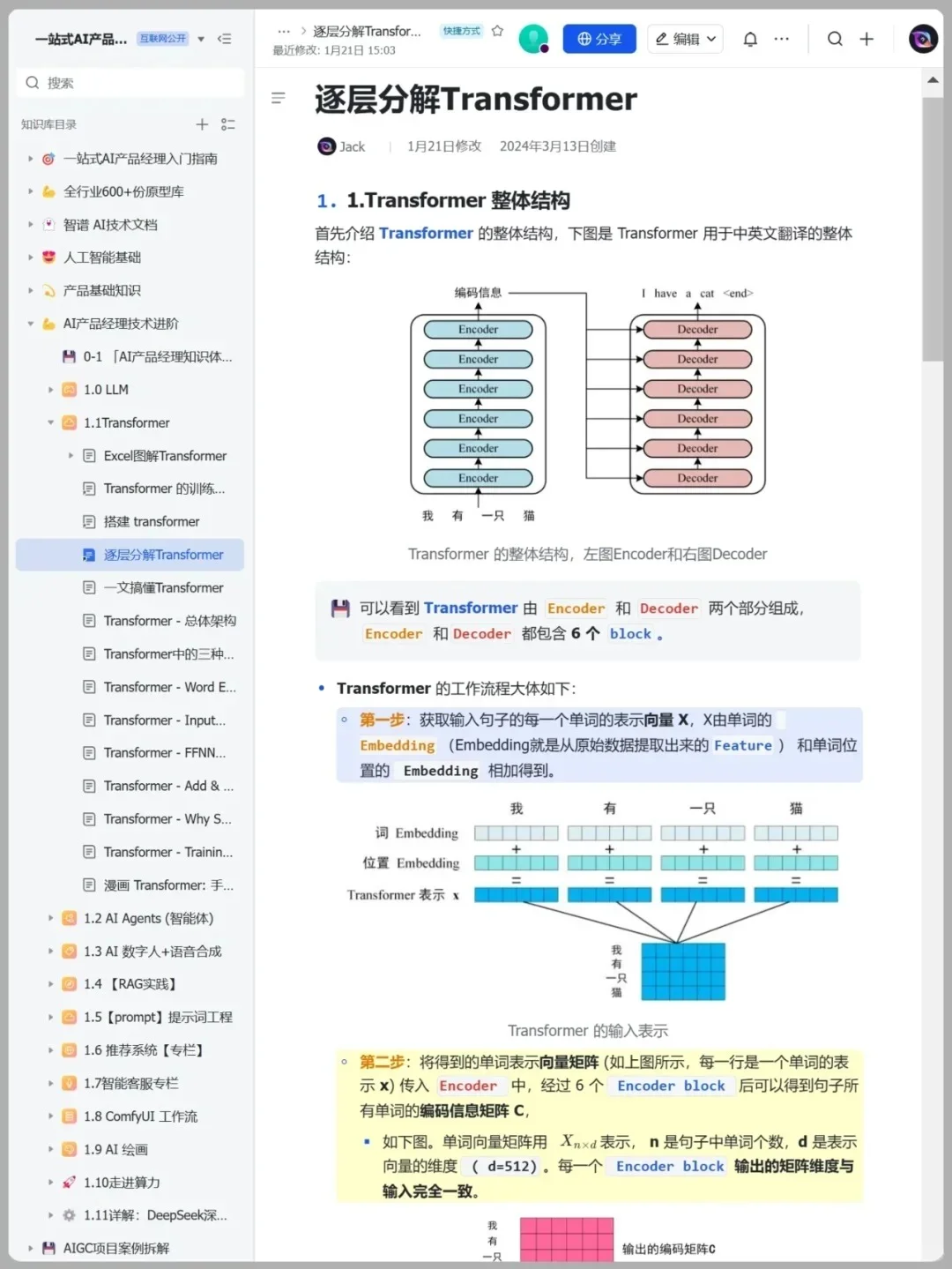

вҡЎ еҜҶз Ғ в‘ иҫ“е…Ҙ = иҜҚ + GPS иҜҚеҗ‘йҮҸе‘ҠиҜүдҪ гҖҢиҜҙд»Җд№ҲгҖҚпјҢдҪҚзҪ®зј–з Ғе‘ҠиҜүдҪ гҖҢеңЁе“ӘиҜҙгҖҚ? жІЎ GPSпјҹгҖҢзҢ«еҗғиҖҒйј гҖҚ=гҖҢиҖҒйј еҗғзҢ«гҖҚ?

вҡЎ еҜҶз Ғ в‘Ў Self-Attention = е…Ёе‘ҳејҖйәҰ? жҜҸеҶҷ 1 дёӘж–°иҜҚпјҢе…ЁеңәйҮҚж–°жү«дёҖйҒҚпјҡ Query й—®гҖҢжҲ‘иҰҒе•ҘгҖҚвҶ’ Key-Value дҫӣж–ҷвҶ’жү“еҲҶ softmaxвҶ’зһ¬й—ҙиҒҡз„ҰпјҢзҝ»иҜ‘ \"it\" з§’жҢҮд»Ј \"animal\" иҝҳжҳҜ \"street\"вң”пёҸ

вҡЎ еҜҶз Ғ в‘ў Multi-Head = еӨҡи·Ҝи®°иҖ…? жҠҠ QKV жӢҶжҲҗ N дёӘеӨҙпјҡиҜӯжі• / жғ…ж„ҹ / е®һдҪ“еҗҢж—¶йҮҮи®ҝпјҢеҶҚжӢј 4K е…ЁжҷҜпјҢдёҖеҸҘйЎ¶дёүеҸҘпјҒ

вҡЎ еҜҶз Ғ в‘Ј ж®Ӣе·® + LayerNorm и·іиҝҮиҝһжҺҘ = й«ҳйҖҹе…¬и·ҜйҖҒжўҜеәҰ?пёҸ LayerNorm = зЁіеҺӢеҷЁпјҢжҜҸеұӮжӢүеӣһжӯЈжҖҒпјҢе Ҷ 100 еұӮд№ҹдёҚжўҜеәҰж¶ҲеӨұпјҒ

вҡЎ еҜҶз Ғ в‘Ө Feed-Forward = иҜӯд№үеҠ е·Ҙе·ҘеқҠ? е…ҲеҚҮз»ҙеҶҚйҷҚз»ҙпјҢи®©еҗ‘йҮҸеңЁйқһзәҝжҖ§е®Үе®ҷгҖҢи„‘жҙһеӨ§ејҖгҖҚвңЁ

вҡЎ еҜҶз Ғ в‘Ҙ Masked Self-Attention и®ӯз»ғж—¶жңӘжқҘ token е…ЁйҒ®жҺүпјҢејәиҝ«жЁЎеһӢгҖҢеҸӘзңӢе·Ұиҫ№гҖҚ? вҶ’ GPT жүҚиғҪдёҖеӯ—дёҖеӯ—еҶҷе°ҸиҜҙгҖҒеҶҷд»Јз ҒгҖҒеҶҷжғ…д№Ұ?

вҡЎ еҜҶз Ғ в‘Ұ зј–и§Јз ҒеҲҶе·Ҙ BERTпјҡеҸӘз”Ёзј–з ҒеҷЁпјҢеҸҢеҗ‘зҗҶи§ЈзҺӢиҖ…? GPTпјҡеҸӘз”Ёи§Јз ҒеҷЁпјҢиҮӘеӣһеҪ’з”ҹжҲҗйЎ¶жөҒ? T5 / еҺҹзүҲпјҡзј–и§Јз ҒйҪҗйЈһпјҢзҝ»иҜ‘+ж‘ҳиҰҒе…ЁиғҪ?

#еӨ§жЁЎеһӢеӯҰд№ #еӨ§жЁЎеһӢ #еӨ§жЁЎеһӢеә”з”Ё #дәәе·ҘжҷәиғҪ #ai #transform #и®Ўз®—жңәжҠҖжңҜ #еӨ§жЁЎеһӢи®ӯз»ғ #еӨ§жЁЎеһӢеӯҰд№ #е№Іиҙ§еҲҶдә«

вҡЎ еҜҶз Ғ в‘ иҫ“е…Ҙ = иҜҚ + GPS иҜҚеҗ‘йҮҸе‘ҠиҜүдҪ гҖҢиҜҙд»Җд№ҲгҖҚпјҢдҪҚзҪ®зј–з Ғе‘ҠиҜүдҪ гҖҢеңЁе“ӘиҜҙгҖҚ? жІЎ GPSпјҹгҖҢзҢ«еҗғиҖҒйј гҖҚ=гҖҢиҖҒйј еҗғзҢ«гҖҚ?

вҡЎ еҜҶз Ғ в‘Ў Self-Attention = е…Ёе‘ҳејҖйәҰ? жҜҸеҶҷ 1 дёӘж–°иҜҚпјҢе…ЁеңәйҮҚж–°жү«дёҖйҒҚпјҡ Query й—®гҖҢжҲ‘иҰҒе•ҘгҖҚвҶ’ Key-Value дҫӣж–ҷвҶ’жү“еҲҶ softmaxвҶ’зһ¬й—ҙиҒҡз„ҰпјҢзҝ»иҜ‘ \"it\" з§’жҢҮд»Ј \"animal\" иҝҳжҳҜ \"street\"вң”пёҸ

вҡЎ еҜҶз Ғ в‘ў Multi-Head = еӨҡи·Ҝи®°иҖ…? жҠҠ QKV жӢҶжҲҗ N дёӘеӨҙпјҡиҜӯжі• / жғ…ж„ҹ / е®һдҪ“еҗҢж—¶йҮҮи®ҝпјҢеҶҚжӢј 4K е…ЁжҷҜпјҢдёҖеҸҘйЎ¶дёүеҸҘпјҒ

вҡЎ еҜҶз Ғ в‘Ј ж®Ӣе·® + LayerNorm и·іиҝҮиҝһжҺҘ = й«ҳйҖҹе…¬и·ҜйҖҒжўҜеәҰ?пёҸ LayerNorm = зЁіеҺӢеҷЁпјҢжҜҸеұӮжӢүеӣһжӯЈжҖҒпјҢе Ҷ 100 еұӮд№ҹдёҚжўҜеәҰж¶ҲеӨұпјҒ

вҡЎ еҜҶз Ғ в‘Ө Feed-Forward = иҜӯд№үеҠ е·Ҙе·ҘеқҠ? е…ҲеҚҮз»ҙеҶҚйҷҚз»ҙпјҢи®©еҗ‘йҮҸеңЁйқһзәҝжҖ§е®Үе®ҷгҖҢи„‘жҙһеӨ§ејҖгҖҚвңЁ

вҡЎ еҜҶз Ғ в‘Ҙ Masked Self-Attention и®ӯз»ғж—¶жңӘжқҘ token е…ЁйҒ®жҺүпјҢејәиҝ«жЁЎеһӢгҖҢеҸӘзңӢе·Ұиҫ№гҖҚ? вҶ’ GPT жүҚиғҪдёҖеӯ—дёҖеӯ—еҶҷе°ҸиҜҙгҖҒеҶҷд»Јз ҒгҖҒеҶҷжғ…д№Ұ?

вҡЎ еҜҶз Ғ в‘Ұ зј–и§Јз ҒеҲҶе·Ҙ BERTпјҡеҸӘз”Ёзј–з ҒеҷЁпјҢеҸҢеҗ‘зҗҶи§ЈзҺӢиҖ…? GPTпјҡеҸӘз”Ёи§Јз ҒеҷЁпјҢиҮӘеӣһеҪ’з”ҹжҲҗйЎ¶жөҒ? T5 / еҺҹзүҲпјҡзј–и§Јз ҒйҪҗйЈһпјҢзҝ»иҜ‘+ж‘ҳиҰҒе…ЁиғҪ?

#еӨ§жЁЎеһӢеӯҰд№ #еӨ§жЁЎеһӢ #еӨ§жЁЎеһӢеә”з”Ё #дәәе·ҘжҷәиғҪ #ai #transform #и®Ўз®—жңәжҠҖжңҜ #еӨ§жЁЎеһӢи®ӯз»ғ #еӨ§жЁЎеһӢеӯҰд№ #е№Іиҙ§еҲҶдә«