ChatGPT зӯүзі»еҲ—жЁЎеһӢжЁӘз©әеҮәдё–пјҢд»Ҙе…¶ејәеӨ§зҡ„жҖ§иғҪеј•иө·дәҶе…Ёзҗғзҡ„е…іжіЁпјҢжңүжңӣж”№еҸҳдәәдёҺи®Ўз®—жңәд№Ӣй—ҙзҡ„дәӨдә’ж–№ејҸпјҢеә”з”ЁеҲ°еҚғиЎҢзҷҫдёҡгҖӮ然иҖҢиҝҷдәӣеӨ§еһӢжЁЎеһӢзҡ„е®һйҷ…йңҖиҰҒжһҒй«ҳзҡ„еҶ…еӯҳе’Ңи®Ўз®—иө„жәҗпјҢйҷҗеҲ¶дәҶе®ғ们еңЁеҗ„з§ҚеңәжҷҜдёӯзҡ„еә”з”ЁгҖӮдҫӢеҰӮпјҢе…·жңү 175B еҸӮж•°зҡ„ GPT-3 еңЁдҪҝз”Ё FP32 ж•°жҚ®зұ»еһӢеӯҳеӮЁж—¶йңҖиҰҒеӨ§зәҰ 700GB еҶ…еӯҳгҖӮе°Ҫз®Ў 7B еҸӮж•°жЁЎеһӢзӣёеҜ№жӣҙй«ҳж•ҲпјҢдҪҶе…¶иө„жәҗйңҖжұӮд»Қ然йҡҫд»ҘзӣҙжҺҘйғЁзҪІеңЁжүӢжңәзӯүиҫ№зјҳи®ҫеӨҮдёҠгҖӮ

жӯӨеӨ–пјҢе°Ҫз®Ўи®ёеӨҡз ”з©¶е·Із»ҸжҲҗеҠҹең°жү“йҖ еҮәеӨҡдёӘж•ҲжһңеҫҲеҘҪзҡ„еӨ§иҜӯиЁҖжЁЎеһӢпјҢдҪҶ他们еҫҖеҫҖйҮҮз”Ёзӣёдјјзҡ„и®ӯз»ғзӯ–з•ҘгҖӮдёҖж–№йқўпјҢеӨ§йҮҸе·ҘдҪңйӣҶдёӯеңЁж”¶йӣҶе’Ңжё…зҗҶж•°жҚ®дёҠпјҢиҫғе°‘ејәи°ғз ”з©¶жңүж•Ҳзҡ„и®ӯз»ғзӯ–з•ҘгҖӮеҸҰдёҖж–№йқўпјҢеӨ§еһӢжЁЎеһӢзҡ„и®ӯз»ғйңҖиҰҒжһҒй«ҳзҡ„и®Ўз®—иө„жәҗжҠ•е…ҘпјҢдҪҝеҫ—жҺўзҙўеӨ§йҮҸзҡ„дјҳеҢ–зӯ–з•Ҙ并дёҚеҲҮе®һйҷ…гҖӮ

зӣҳеҸӨ ПҖ и®әж–Үй“ҫжҺҘпјҡhttps://arxiv.org/pdf/2312.17276.pdf

вҖңе°ҸвҖқ жЁЎеһӢи®ӯз»ғи®әж–Үй“ҫжҺҘпјҡhttps://arxiv.org/pdf/2402.02791.pdf

и®ӯз»ғе®һзҺ°й“ҫжҺҘпјҡhttps://github.com/YuchuanTian/RethinkTinyLM

еңЁиҝҷзҜҮе·ҘдҪңдёӯпјҢдҪңиҖ…д»ҘдёҖдёӘ 1B еӨ§е°Ҹзҡ„иҜӯиЁҖжЁЎеһӢдҪңдёәиҪҪдҪ“пјҢиҜҰз»Ҷи®Ёи®әдәҶе°Ҹзҡ„иҜӯиЁҖжЁЎеһӢеә”иҜҘеҰӮдҪ•зӮјдё№гҖӮдҪңиҖ…д»ҺжЁЎеһӢз»“жһ„гҖҒеҸӮж•°еҲқе§ӢеҢ–гҖҒжЁЎеһӢдјҳеҢ–ж–№жі•дёүдёӘи§’еәҰеұ•ејҖз ”з©¶пјҡжҖ»з»“еҮәеӣӣжқЎжҸҗеҚҮе°ҸиҜӯиЁҖжЁЎеһӢж•Ҳжһңзҡ„зӮјдё№жңҜпјҡ

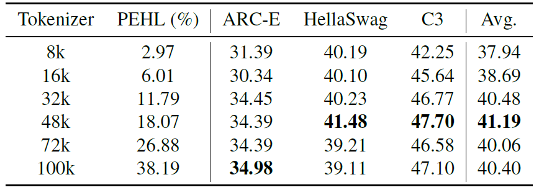

1гҖҒ еҲҶиҜҚеҷЁиЈҒеүӘпјҲTokenizerпјүпјҡеңЁе°Ҹзҡ„жЁЎеһӢзӣҙжҺҘ继жүҝеӨ§жЁЎеһӢзҡ„ Tokenizer дјҡеј•е…ҘеҶ—дҪҷеҸӮж•°пјҢеўһеҠ и®Ўз®—ејҖй”ҖеўһеҠ гҖӮеҲ йҷӨ Tokenizer дёӯзҡ„дҪҺйў‘иҜҚжұҮпјҢеҸҜд»ҘеҮҸе°‘ Tokenizer еҸӮж•°йҮҸпјҢдёәжЁЎеһӢдё»дҪ“з•ҷи¶із©әй—ҙгҖӮ

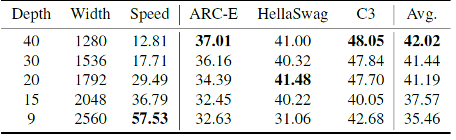

2гҖҒ жЁЎеһӢжһ¶жһ„и°ғдјҳпјҡжЁЎеһӢзҡ„ж·ұеәҰгҖҒе®ҪеәҰеҜ№е°ҸиҜӯиЁҖжЁЎеһӢж•ҲжһңжһҒеӨ§гҖӮеҗҢеҸӮж•°йҮҸдёӢпјҢиҫғж·ұзҡ„жЁЎеһӢеҫҖеҫҖж•ҲжһңжӣҙеҘҪпјҢдҪҶжҺЁзҗҶж•ҲзҺҮжӣҙдҪҺгҖӮ

3гҖҒ еҸӮ数继жүҝпјҡ继жүҝеӨ§жЁЎеһӢеҸӮж•°дҪңдёәеҲқе§ӢеҖјеҸҜд»ҘжҸҗеҚҮжЁЎеһӢж•Ҳжһң并еҠ йҖҹ收ж•ӣгҖӮеңЁжҢ‘йҖүеҸӮж•°ж—¶пјҢйҰ–е°ҫеұӮжҜ”дёӯй—ҙеұӮжӣҙйҮҚиҰҒпјҢжҜҸеұӮеҶ…зҡ„жңүж•ҲеҸӮж•°еҸҜд»ҘйҖҡиҝҮеҸҜеӯҰ mask еҫ—еҲ°гҖӮ

4гҖҒ еӨҡиҪ®и®ӯз»ғпјҡеӨҡиҪ®и®ӯз»ғиў«йӘҢиҜҒеҜ№и®ӯе°ҸжЁЎеһӢжңүж•ҲгҖӮдёҠдёҖиҪ®и®ӯз»ғи®°еҪ•зҡ„ loss еҖјзӯүдёӯй—ҙз»“жһңеҸҜд»ҘжҢҮеҜјж ·жң¬зҡ„жҢ‘йҖүпјҢйҷҚдҪҺеӨҡиҪ®и®ӯз»ғзҡ„д»Јд»·гҖӮ

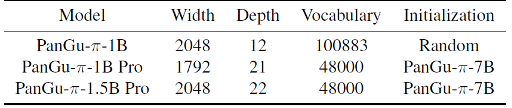

еҹәдәҺдёҠиҝ°зӯ–з•ҘпјҢдҪңиҖ…жһ„е»әдәҶдёӨдёӘ PanGu-ПҖ-1B Pro е’Ң PanGu-ПҖ-1.5B ProгҖӮдёҺзұ»дјји§„жЁЎзҡ„жЁЎеһӢзӣёжҜ”пјҢеҸ–еҫ—дәҶжӣҙдјҳзҡ„ж•ҲжһңгҖӮ

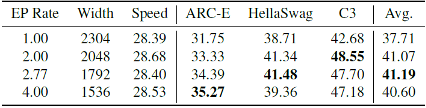

PanGu-ПҖ-1B е’Ң PanGu-ПҖ-1.5B зҡ„з»“жһ„и®ҫе®ҡ

В

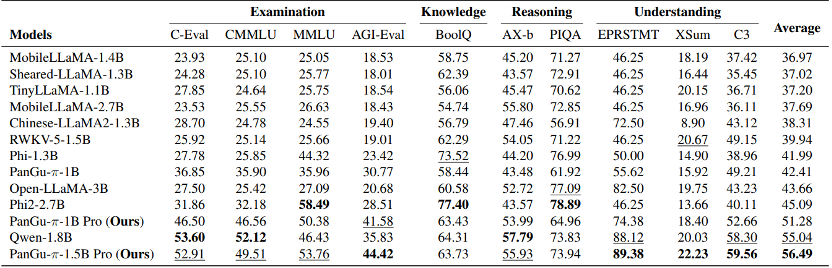

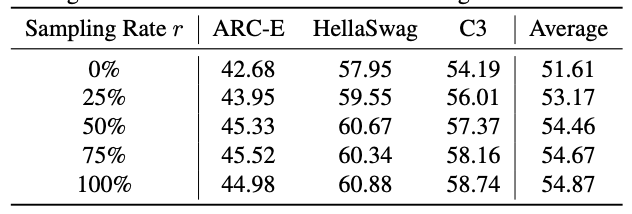

еңЁйҖҡз”ЁжөӢиҜ„йӣҶпјҲиҖғиҜ•гҖҒзҹҘиҜҶгҖҒжҺЁзҗҶгҖҒзҗҶи§ЈпјүдёҺзӣёиҝ‘规模模еһӢзҡ„жҜ”иҫғгҖӮ

В

д»ҘдёӢе°ҶеҜ№еӣӣжқЎзӮјдё№жңҜеҒҡиҜҰз»ҶеҲҶжһҗгҖӮдёәдәҶжҺ§еҲ¶жҲҗжң¬пјҢеӨ§еӨҡж•°е®һйӘҢжҳҜеҹәдәҺ 1B жЁЎеһӢеңЁ 50B жқЎдёӯиӢұж–ҮиҜӯж–ҷдёҠе®ҢжҲҗзҡ„гҖӮ

еҲҶиҜҚеҷЁиЈҒеүӘ

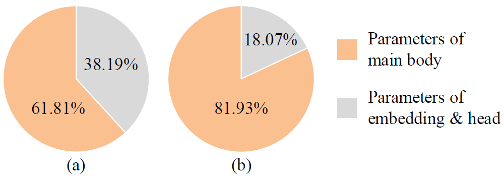

еӨҡиҜӯиЁҖеӨ§жЁЎеһӢеҫҖеҫҖйҮҮз”ЁдёҖдёӘеҫҲеӨ§зҡ„иҜҚиЎЁжқҘиҰҶзӣ–еҗ„з§ҚиҜӯж–ҷеә“пјҢдҪҶжҳҜеҜ№дәҺе°ҸжЁЎеһӢжқҘиҜҙпјҢдёҖдёӘеӨ§иҜҚиЎЁе°ұе·Із»ҸеҚ з”ЁеҫҲеӨҡеҸӮж•°дәҶгҖӮдҫӢеҰӮпјҢQwen-7BгҖҒBaichuan2-7B е’Ң PanGu-ПҖ-7B зҡ„иҜҚжұҮйҮҸеҲҶеҲ«дёә 151936гҖҒ125696гҖҒ100883гҖӮе®ғ们зҡ„еӨҙйғЁе’ҢеөҢе…ҘеұӮзҡ„еҸӮж•°еҲҶеҲ«еҚ жҖ»дҪ“еҸӮж•°зҡ„ 16.12\%гҖҒ13.72\%гҖҒ10.91\%гҖӮиҖҢеҜ№дәҺ 1B жЁЎеһӢжқҘиҜҙжЁЎеһӢпјҢдҪҝз”ЁзӣёеҗҢзҡ„еҲҶиҜҚеҷЁдјҡеҚ еҲ°жЁЎеһӢеӨ§е°Ҹзҡ„ 30% д»ҘдёҠгҖӮ

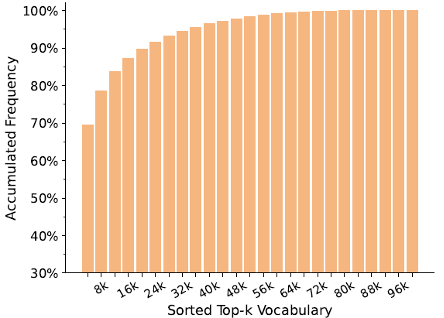

е®һйҷ…дёҠпјҢиҜҚиЎЁдёӯеӯҳеңЁеӨ§йҮҸеҶ—дҪҷгҖӮйҖҡиҝҮдҪҝз”Ёд»Һ PanGu-$\pi$ жЁЎеһӢ继жүҝзҡ„ 100k иҜҚжұҮиЎЁеҲқе§ӢеҢ–еҲҶиҜҚеҷЁпјҢжҲ‘们еҜ№еҢ…еҗ«еӨ§зәҰ 1.6T еҲҶиҜҚзҡ„еәһеӨ§иҜӯж–ҷеә“иҝӣиЎҢдәҶйў‘зҺҮеҲҶжһҗгҖӮеҰӮдёӢеӣҫжүҖзӨәпјҢиҜҚиЎЁиЎЁзҺ°еҮәй•ҝе°ҫж•Ҳеә”пјҢе…¶дёӯеүҚ 48k иҜҚжұҮе°ұеҚ жҚ®и®ӯз»ғиҜӯж–ҷеә“зҡ„ 97.86%пјҢд№ҹе°ұжҳҜиҜҙи¶…иҝҮ 50% зҡ„иҜҚжұҮеҸҜиғҪжҳҜеӨҡдҪҷзҡ„пјҢеӣ дёәе®ғ们еҸӘж»Ўи¶ідёҚеҲ° 3% зҡ„иҜӯж–ҷеә“гҖӮжҠҠдҪҺйў‘иҜҚиЎЁеҲ йҷӨпјҢе°ұеҸҜд»ҘеӨ§е№…йҷҚдҪҺиҜҚиЎЁеҸӮж•°йҮҸпјҢжҠҠз©әй—ҙз•ҷз»ҷжЁЎеһӢдё»дҪ“пјҢз”ЁдәҺжҸҗеҚҮжЁЎеһӢиЎЁиҫҫиғҪеҠӣгҖӮ

97.86% зҡ„ж•°жҚ®еҸҜд»Ҙиў« 48k зҡ„е°ҸиҜҚиЎЁиЎЁзӨә

еҸӮж•°йҮҸеҚ жҜ”пјҡпјҲaпјүдҪҝз”ЁзӣҙжҺҘ继жүҝзҡ„еӨ§иҜҚиЎЁ пјҲbпјүдҪҝз”ЁиЈҒеүӘеҗҺзҡ„иҜҚиЎЁ

жЁЎеһӢж•ҲжһңдёҺиҜҚиЎЁеӨ§е°Ҹзҡ„е…ізі»пјҲеӣәе®ҡеҸӮж•°йҮҸдёә 1Bпјү

В

жЁЎеһӢжһ¶жһ„и°ғдјҳ

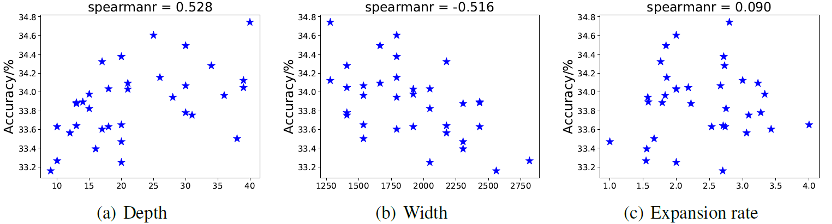

жЁЎеһӢжһ¶жһ„зҡ„й…ҚзҪ®пјҢдҫӢеҰӮе®ҪеәҰгҖҒж·ұеәҰе’Ңжү©еұ•зҺҮпјҢеҜ№е°ҸиҜӯиЁҖжЁЎеһӢзҡ„жңҖз»ҲжҖ§иғҪжңүзӣёеҪ“еӨ§зҡ„еҪұе“ҚгҖӮдҪңиҖ…еҒҡдәҶеӨ§йҮҸе®һйӘҢиҝӣиЎҢеҲҶжһҗпјҢеҸ‘зҺ°ж·ұеәҰеҪұе“Қе°ҸиҜӯиЁҖжЁЎеһӢж•ҲжһңжңҖйҮҚиҰҒзҡ„еӣ зҙ гҖӮдёҖдёӘжӣҙж·ұзҡ„жЁЎеһӢж•ҲжһңжӣҙеҘҪпјҢдҪҶеңЁ GPU зҡ„жҺЁзҗҶйҖҹеәҰд№ҹдјҡдҪҺдёҖдәӣпјҢд»ҘдёӢжҳҜеңЁ 50B ж•°жҚ®дёҠе…·дҪ“зҡ„е®һйӘҢз»“жһңгҖӮ

ж·ұеәҰгҖҒе®ҪеәҰеҜ№ 1B жЁЎеһӢж•Ҳжһңзҡ„еҪұе“ҚпјҲеӣәе®ҡжү©еј зҺҮпјү

В

FFN жү©еј зҺҮеҜ№ 1B жЁЎеһӢж•Ҳжһңзҡ„еҪұе“ҚпјҲеӣәе®ҡж·ұеәҰпјү

В

еӣәе®ҡжЁЎеһӢеҸӮж•°йҮҸдёә 1B е·ҰеҸіпјҢжЁЎеһӢж•ҲжһңдёҺж·ұеәҰгҖҒе®ҪеәҰгҖҒжү©еј зҺҮд№Ӣй—ҙзҡ„е…ізі»гҖӮ

еҸӮ数继жүҝ

еӨ§жЁЎеһӢиҖ—иҙ№еӨ§йҮҸз®—еҠӣеңЁеӨ§йҮҸж•°жҚ®дёҠиҝӣиЎҢи®ӯз»ғпјҢжӢҘжңүејәеӨ§зҡ„жіӣеҢ–иғҪеҠӣгҖӮдҪңиҖ…йӘҢиҜҒдәҶд»ҺеӨ§жЁЎеһӢдёӯ继жүҝеҸӮж•°еҸҜд»Ҙд»ҺдёҖдёӘиҫғй«ҳзҡ„иө·зӮ№ејҖе§Ӣи®ӯжЁЎеһӢпјҢиғҪеӨҹжңүж•ҲжҸҗеҚҮжЁЎеһӢж•ҲжһңгҖӮ

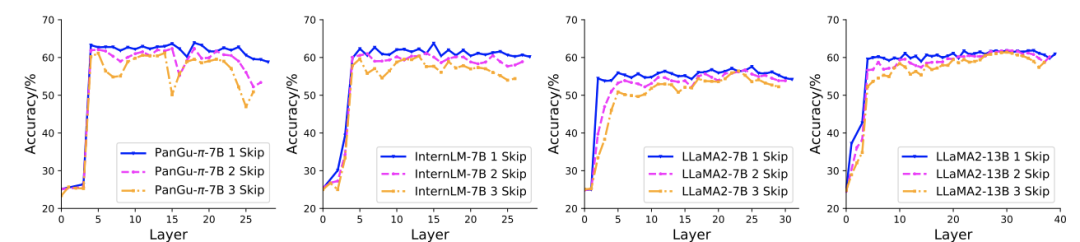

дҪңиҖ…йҰ–е…ҲйӘҢиҜҒдәҶжЁЎеһӢеҗ„дёӘеұӮзҡ„йҮҚиҰҒжҖ§гҖӮеҜ№дәҺ LLaMA2-7BгҖҒLLaMA2-13BгҖҒInternLM-7B е’Ң PanGu-ПҖ-7B зӯүеӨҡдёӘеӨ§жЁЎеһӢпјҢдҪңиҖ…и·іиҝҮдәҶдёҖдәӣеұӮпјҢжқҘи§ӮеҜҹи·іиҝҮеҗҺжЁЎеһӢж•Ҳжһңзҡ„еҸҳеҢ–гҖӮдёҚеҗҢжЁЎеһӢйғҪеұ•зҺ°еҮәзұ»дјјзҡ„规еҫӢпјҡи¶Ҡйқ иҝ‘жЁЎеһӢдёӨз«Ҝзҡ„еұӮеҜ№жЁЎеһӢж•Ҳжһңзҡ„еҪұе“ҚжңҖеӨ§пјҢеҲ йҷӨдёҖдәӣдёӯй—ҙеұӮеҜ№жЁЎеһӢж•ҲжһңеҪұе“Қиҫғе°ҸгҖӮеӣ жӯӨеҸӮ数继жүҝж—¶пјҢеҸҜд»ҘеҲ йҷӨеӨ§жЁЎеһӢйғЁеҲҶдёӯй—ҙеұӮпјҢжқҘеҜ№йҪҗеӨ§е°ҸжЁЎеһӢзҡ„ж·ұеәҰгҖӮ

В

еҲ йҷӨеӨ§жЁЎеһӢдёӯзҡ„еӨҡдёӘеұӮжқҘйӘҢиҜҒеұӮзҡ„йҮҚиҰҒжҖ§гҖӮдёҚеҗҢеӨ§жЁЎеһӢдёҠзҡ„е®һйӘҢз»“жһңиЎЁжҳҺпјҢйқ иҝ‘йҰ–е°ҫзҡ„еұӮдёӯй—ҙеұӮжӣҙйҮҚиҰҒгҖӮ

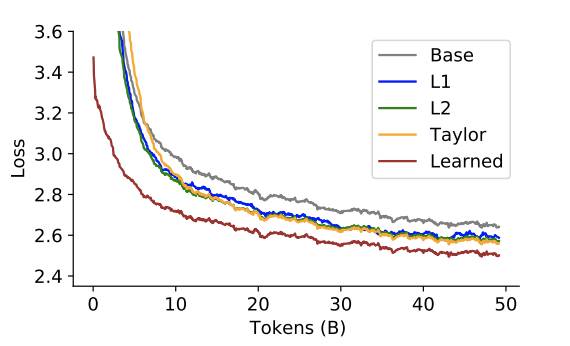

еңЁжҜҸдёӘеұӮеҶ…йғЁпјҢеҸҜд»Ҙз”Ёеҗ„з§ҚеәҰйҮҸеҮҪж•°жқҘиҜ„дј°еҸӮж•°зҡ„йҮҚиҰҒжҖ§пјҢеҢ…жӢ¬жқғйҮҚзҡ„иҢғж•°гҖҒжі°еӢ’еұ•ејҖејҸгҖҒж•°жҚ®й©ұеҠЁеҸҜеӯҰзҡ„еәҰйҮҸзӯүгҖӮдёӢеӣҫжҜ”иҫғдәҶдҪҝз”ЁдёҚеҗҢеәҰйҮҸйҖүжӢ©еҸӮж•°еҗҺжЁЎеһӢи®ӯз»ғж•Ҳжһңе’Ң收ж•ӣйҖҹеәҰгҖӮдҪҝз”Ёж•°жҚ®й©ұеҠЁеӯҰд№ зҡ„еәҰйҮҸжҳҜжңҖжңүж•Ҳзҡ„пјҢеҸҜд»Ҙд»ҺиҫғеҘҪзҡ„иө·зӮ№ејҖе§ӢпјҢд»Ҙжӣҙеҝ«зҡ„йҖҹеәҰ收ж•ӣеҲ°жӣҙдҪҺзҡ„ loss еҖјгҖӮ

В

дёҚеҗҢеҸӮж•°йҖүжӢ©ж–№жі•ж•Ҳжһңзҡ„жҜ”иҫғ

еӨҡиҪ®и®ӯз»ғ

зҺ°еңЁеӨ§еӨҡж•°еӨ§жЁЎеһӢйҖҡеёёеҸӘи®ӯз»ғдёҖиҪ®иҜӯиЁҖжЁЎеһӢпјҢеҚіжүҖжңүзҡ„ж•°жҚ®еҸӘз”ЁдёҖж¬ЎжқҘжӣҙж–°жЁЎеһӢпјҢжЁЎеһӢзҡ„еҸӮж•°е®һйҷ…дёҠ并жңӘе……еҲҶ收ж•ӣгҖӮеҗҢж—¶пјҢе°ҸиҜӯиЁҖжЁЎеһӢе®№йҮҸиҫғе°ҸпјҢд№ҹдҪҝеҫ—жЁЎеһӢзҡ„йҒ—еҝҳй—®йўҳжӣҙеҠ дёҘйҮҚгҖӮдҪңиҖ…жҸҗеҮәеә”еҪ“еҜ№жЁЎеһӢиҝӣиЎҢеӨҡиҪ®и®ӯз»ғпјҢжқҘеҮҸиҪ»йҒ—еҝҳй—®йўҳгҖӮ

дёәдәҶйҷҚдҪҺеӨҡиҪ®и®ӯз»ғзҡ„жҲҗжң¬пјҢеҸҜд»ҘдҪҝ用第дёҖиҪ®зҡ„и®ӯз»ғ loss жқҘеҒҡж•°жҚ®зӯӣйҖүе’ҢзІҫзӮјпјҢдјҳе…ҲйҖүжӢ© loss еӨ§зҡ„ж•°жҚ®йҖҒе…Ҙ第дәҢиҪ®гҖӮз”Ё r иЎЁзӨә第 2 иҪ®и®ӯз»ғж—¶ж ·жң¬зҡ„йҮҮж ·зҺҮпјҢеҸҜд»ҘеҸ‘зҺ°еҪ“йҮҮж ·зҺҮи¶…иҝҮ 50% ж—¶пјҢжЁЎеһӢж•Ҳжһңзҡ„жҸҗеҚҮжҜ”иҫғе°ҸгҖӮ

第дәҢиҪ®и®ӯз»ғж—¶ж•°жҚ®йҮҮж ·зҺҮзҡ„еҪұе“Қ

В

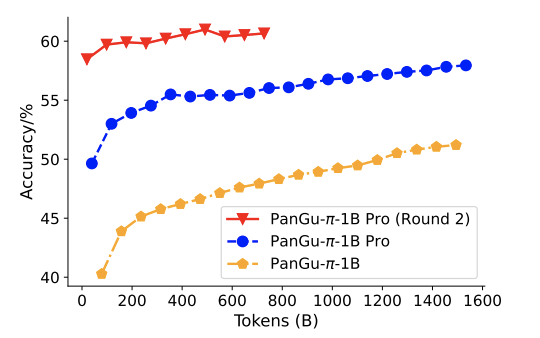

д»ҘдёӢжҳҜжЁЎеһӢеңЁе…ЁйҮҸж•°жҚ®пјҲ1.6T tokenпјүдёҠзҡ„и®ӯз»ғжӣІзәҝпјҢеҸҜд»ҘеҸ‘зҺ°з¬¬дәҢиҪ®и®ӯз»ғж—¶пјҢжЁЎеһӢж•Ҳжһңдҫқ然жңүйқһеёёжҳҺжҳҫзҡ„жҸҗеҚҮгҖӮ

В

и®ӯз»ғиҝҮзЁӢдёӯпјҢPanGu-ПҖ-1B е’Ң PanGu-ПҖ-1B Pro жЁЎеһӢеңЁ HellaSwag ж•°жҚ®йӣҶдёҠзҡ„ж•Ҳжһң

зү№еҲ«иҜҙжҳҺпјҡжң¬ж–Үд»…з”ЁдәҺеӯҰжңҜдәӨжөҒпјҢеҰӮжңүдҫөжқғиҜ·еҗҺеҸ°иҒ”зі»е°Ҹзј–еҲ йҷӨгҖӮ

- END -

иҪ¬иҪҪжқҘжәҗпјҡжңәеҷЁд№Ӣеҝғ

иҪ¬иҪҪзј–иҫ‘пјҡжңұж–ҮиҙӨ

е®Ўж ёпјҡжқҺдё№В иөөжҒ©е©·В В й»„иҺүдә‘В йҹ©жў…

иө„и®ҜжҺЁиҚҗ

в–¶ жҠҖжңҜдёҺе·Ҙе…·

е№іиЎҢиҜӯж–ҷеә“еңЁеҸЈиҜ‘е®һи·өдёӯзҡ„еә”з”Ё

еӣҪеҶ…еӨ–еёёи§ҒжңҜиҜӯз®ЎзҗҶе·Ҙе…·

зҝ»иҜ‘еҝ…еӨҮжңҜиҜӯеә“е’ҢиҜӯж–ҷеә“еҗҲйӣҶпјҲйҷ„зҪ‘еқҖпјү

зҝ»иҜ‘еҝ…еӨҮзҡ„и®Ўз®—жңәзҝ»иҜ‘иҫ…еҠ©иҪҜ件пјҲйҷ„зҪ‘еқҖпјү

AntConcпјҡе®һз”Ёзҡ„жң¬ең°иҜӯж–ҷеә“жЈҖзҙўе·Ҙе…·

TREXпјҡжңүжө·йҮҸдҫӢеҸҘгҖҒдё°еҜҢиҜӯж–ҷзҡ„еңЁзәҝиҜҚе…ё

NetspeakпјҡдёҖж¬ҫе…Қиҙ№зҡ„еҚ•иҜҚжҗӯй…ҚжЈҖзҙўе·Ҙе…·

WantWordsеҸҚеҗ‘иҜҚе…ёпјҢеҶ…еҗ«ејҖеҸ‘еӣўйҳҹе…¬ејҖж–ҮжЎЈ

Cymo BoothпјҡеҗҢеЈ°дј иҜ‘е‘ҳзҡ„дё“еұһиҷҡжӢҹеҗҢдј й—ҙ

MateCatпјҡдёҖж¬ҫе…Қиҙ№зҡ„еңЁзәҝCATе·Ҙе…·

VisuwordsпјҡеҸҜи§ҶеҢ–еңЁзәҝиҜҚе…ёпјҢеё®дҪ дёҖй”®жһ„йҖ и®°еҝҶе®«ж®ҝ

LinggleпјҡиҜӯж–ҷ+жҗӯй…ҚжЈҖзҙўе·Ҙе…·пјҲе®һж“Қжј”зӨәпјү

Ludwig: ең°йҒ“иӢұж–ҮеҶҷдҪңиҫ…еҠ©зҘһеҷЁпјҢе‘ҠеҲ«дёӯејҸиӢұиҜӯ

Reversoпјҡиҫ…еҠ©еҶҷдҪңдёҺзҝ»иҜ‘зҘһеҷЁ

в–¶ еӣҪйҷ…иҜӯиЁҖжңҚеҠЎеҠЁжҖҒ

| зҝ»иҜ‘е…¬еҸёзҜҮ | TransPerfectз®Җд»Ӣ

| зҝ»иҜ‘е…¬еҸёзҜҮ | е…Ёзҗғ第2еҗҚ RWSеҰӮж–ҮжҖқ

| зҝ»иҜ‘е…¬еҸёзҜҮ | вҖң收иҙӯзӢӮйӯ”вҖқKeywords Studios

| е’ЁиҜўжңәжһ„зҜҮ | Slator з®Җд»Ӣ

| е’ЁиҜўжңәжһ„зҜҮ | CSA Research з®Җд»Ӣ

| иЎҢдёҡжңәжһ„зҜҮ | еӣҪйҷ…зҝ»иҜ‘家иҒ”зӣҹFIT

| иЎҢдёҡжңәжһ„зҜҮ | зҫҺеӣҪзҝ»иҜ‘еҚҸдјҡATA

| иЎҢдёҡжңәжһ„зҜҮ | еҠ жӢҝеӨ§иҒ”йӮҰзҝ»иҜ‘еұҖ Canada's Translation Bureau

| зҝ»иҜ‘йҷўж ЎзҜҮ | жҳҺеҫ·еӨ§еӯҰи’ҷзү№йӣ·еӣҪйҷ…з ”з©¶еӯҰйҷўпјҲMIISпјү

| зҝ»иҜ‘йҷўж ЎзҜҮ | ж јжӢүж–Ҝе“ҘеӨ§еӯҰ

| зҝ»иҜ‘йҷўж ЎзҜҮ | еҹғеЎһе…Ӣж–ҜеӨ§еӯҰ

| зҝ»иҜ‘йҷўж ЎзҜҮ | еҲ©е…№еӨ§еӯҰ

| зғӯзӮ№иҝҪиёӘ | ChatGPTзҡ„дјҰзҗҶй—®йўҳпјҲдёҠпјү

|В зғӯзӮ№иҝҪиёӘ | ChatGPTзҡ„дјҰзҗҶй—®йўҳпјҲдёӢпјү

| зғӯзӮ№иҝҪиёӘ | GPT-4йқўдё–вҖ”вҖ”AIеј•йўҶиҜӯиЁҖиЎҢдёҡйқ©ж–°

в–¶ дё“и®ҝ

жқҺй•ҝж “пјҡChatGPTеңЁзҝ»иҜ‘дёӯзҡ„еҙӯж–°и§’иүІ

иўҒз…ңпјҡжҢ‘жҲҳиҮӘжҲ‘пјҢиҝҲеҮәиҲ’йҖӮеҢә

зҺӢеқҮжқҫпјҡдәәе·ҘжҷәиғҪж—¶д»Јзҡ„зҝ»иҜ‘пјҡжҠҖжңҜй©ұеҠЁзҡ„еҸҳйқ©дёҺжңӘжқҘеұ•жңӣ

зҺӢж ‘ж§җпјҡGPTдёҺе°ҸиҜҙзҝ»иҜ‘жү№иҜ„пјҡGPTдёҺж–ҮеӯҰзҝ»иҜ‘д№ӢдәҢ

зҺӢж ‘ж§җпјҡGPTдёҺиҜ—жӯҢзҝ»иҜ‘жү№иҜ„пјҡGPTдёҺж–ҮеӯҰзҝ»иҜ‘д№ӢдёҖ

иӢҸз§ӢеҶӣпјҡAIGCиғҢжҷҜдёӢзҡ„MTIеӯҰ科е»әи®ҫ

зҺӢеҚҺж ‘пјҡиҜ‘иҖ…ж•°еӯ—зҙ е…»з ”з©¶дәҹйңҖеҠ ејәпјҢжү“йҖ зҝ»иҜ‘дәәжүҚж–°дјҳеҠҝ

жІҲжҫҚпјҡAIGCжҳҜж•ҢжҳҜеҸӢпјҹзҝ»иҜ‘йўҶеҹҹзҡ„жңәйҒҮдёҺжҢ‘жҲҳ

е®Ғйқҷпјҡй•ҝзјЁеңЁжүӢпјҢж•ўзјҡиӢҚйҫҷ

еҙ”еҗҜдә®пјҡжңәеҷЁзҝ»иҜ‘еҜ№иҜӯиЁҖжңҚеҠЎдјҒдёҡжңүеӨҡеӨ§дҪңз”Ёпјҹ

йҹ©жһ—ж¶ӣпјҡж–Ү科з”ҹеҰӮдҪ•еӯҰд№ жңәеҷЁзҝ»иҜ‘пјҹ

йӯҸеӢҮй№ҸпјҡжңәеҷЁзҝ»иҜ‘иҙЁйҮҸиҜ„дј°дёәд»Җд№ҲйҮҚиҰҒпјҹ

еҫҗеҪ¬пјҡзҶҹз»ғжҺҢжҸЎзҝ»иҜ‘жҠҖжңҜпјҢе°ұиғҪеҒҡеҮәжјӮдә®зҡ„жҙ»е„ҝ

жӣ№йҰ–е…үпјҡеҰӮдҪ•жү“йҖ дёҖж¬ҫеҸ—ж¬ўиҝҺзҡ„жңәеҷЁзҝ»иҜ‘дә§е“ҒпјҹВ

жқҺжў…пјҡжңәеҷЁзҝ»иҜ‘еҜ№жңӘжқҘзҝ»иҜ‘ж•ҷиӮІжңүдҪ•еҪұе“Қпјҹ

е‘Ёе…ҙеҚҺпјҡй«ҳж Ўзҝ»иҜ‘ж•ҷеёҲеҰӮдҪ•еӯҰд№ зҝ»иҜ‘жҠҖжңҜпјҹ

дёҒдёҪпјҡиҜ‘еҗҺзј–иҫ‘дәәе‘ҳдёҺиҜ‘иҖ…иә«д»ҪжҳҜеҗҰеҜ№зӯүпјҹ

еҚўе®¶иҫүгҖҒйҷҲжҷЁпјҡеҸЈиҜ‘е‘ҳеңЁиҝңзЁӢеҸЈиҜ‘дёӯйқўдёҙзҡ„дё»иҰҒй—®йўҳ

в–¶ иЎҢдёҡжҙһеҜҹ

2021е№ҙиҜӯиЁҖжңҚеҠЎиЎҢдёҡеӣһйЎҫдёҺеұ•жңӣ

2022е№ҙе…ЁзҗғзҷҫејәиҜӯиЁҖжңҚеҠЎе•ҶжҰңеҚ•

2022е№ҙзҝ»иҜ‘иЎҢдёҡе°ҶиҝҺжқҘе“Әдәӣж–°еҸҳеҢ–

еҗҺз–«жғ…ж—¶д»ЈпјҢиҜӯиЁҖжңҚеҠЎиЎҢдёҡеҰӮдҪ•еҸ‘еұ•иҪ¬еһӢпјҹ

дҪ•й’ҰпјҡдёӯеӣҪз”өеҪұеҜ№еӨ–иҜ‘д»Ӣзҡ„зҺ°зҠ¶дёҺжҖқиҖғ

еҶҜеҝ—дјҹпјҡе…ідәҺжңәеҷЁзҝ»иҜ‘иЎҢдёҡеҸ‘еұ•зҡ„дёүзӮ№е»әи®®

еј йң„еҶӣпјҡдјҰзҗҶи§Ҷи§’дёӢпјҢжңәеҷЁзҝ»иҜ‘зҡ„иғҪдёҺдёҚиғҪ

й»„еҸӢд№үпјҡеҰӮдҪ•зӘҒз ҙдёӯеӨ–ж–ҮеҢ–е·®ејӮпјҢи®©дё–з•ҢжӣҙдәҶи§ЈдёӯеӣҪпјҹ

в–¶ ж•ҷиӮІеҲӣж–°

жқҺй•ҝж “пјҡMTIи®әж–ҮеҚғзҜҮдёҖеҫӢпјҢеҰӮдҪ•з ҙеұҖпјҹ

зҺӢеҚҺж ‘ еҲҳдё–з•Ңпјҡж•°еӯ—дәәж–Үи§ҶеҹҹдёӢиҜ‘иҖ…ж•°еӯ—зҙ е…»з ”з©¶пјҡеҶ…ж¶өгҖҒй—®йўҳдёҺе»әи®®

зҺӢеҚҺж ‘ еҲҳдё–з•Ңпјҡдәәе·ҘжҷәиғҪж—¶д»Јзҝ»иҜ‘жҠҖжңҜиҪ¬еҗ‘з ”з©¶

зҺӢеҚҺж ‘ еҲҳдё–з•Ңпјҡжҷәж…§зҝ»иҜ‘ж•ҷиӮІз ”究: зҗҶеҝөгҖҒи·Ҝеҫ„дёҺи¶ӢеҠҝ

жӣ№иҫҫй’ҰВ жҲҙй’°ж¶өпјҡдәәе·ҘжҷәиғҪж—¶д»Јй«ҳж Ўзҝ»иҜ‘жҠҖжңҜе®һи·өзҺҜеўғе»әи®ҫз ”з©¶

жқҺжў…пјҡеҰӮдҪ•з»ҷвҖңжҠҖжңҜе°ҸзҷҪвҖқ ејҖи®ҫи®Ўз®—жңәиҫ…еҠ©зҝ»иҜ‘иҜҫзЁӢпјҹ

е®һи·өеҜјеҗ‘зҡ„MTIдәәжүҚеҹ№е…»жЁЎејҸвҖ”вҖ”д»ҘеҜ№еӨ–з»ҸжөҺиҙёжҳ“еӨ§еӯҰдёәдҫӢ

ж•°еӯ—еҢ–еҸЈиҜ‘ж•ҷеӯҰиө„жәҗе»әи®ҫпјҡ欧жҙІз»ҸйӘҢдёҺеҗҜзӨә

еҰӮдҪ•е°Ҷзҝ»иҜ‘йЎ№зӣ®з®ЎзҗҶжЁЎејҸеә”з”ЁеҲ°CATж•ҷеӯҰиҜҫе Ӯдёӯпјҹ